**论文题目:**Agent Planning with World Knowledge Model **本文作者:**乔硕斐(浙江大学)、方润楠(浙江大学)、张宁豫(浙江大学)、朱雨琦(浙江大学)、陈想(浙江大学)、邓淑敏(新加坡国立大学)、蒋勇(阿里巴巴)、谢朋峻(阿里巴巴)、黄非(阿里巴巴)、陈华钧(浙江大学) **发表会议:**NeurIPS 2024 **论文链接:**https://arxiv.org/abs/2405.14205 ****代码链接:https://github.com/zjunlp/WKM 欢迎转载,转载请注明出处

一、引言

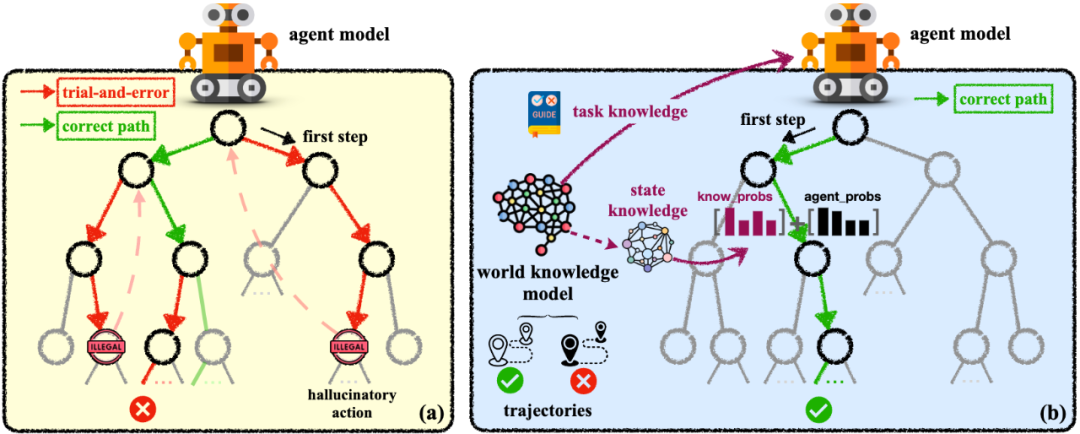

现阶段,大模型智能体的规划能力已取得了较大发展,近日上线的Claude新模型在一定程度上甚至可以像人类一样使用计算机。然而,由于大模型缺乏对真实物理世界的理解,大模型智能体仍然存在盲目试错和幻觉生成问题。人类在处理规划任务时往往会借鉴历史经验(知识模型),在任务开始前会根据先验知识在脑中预演整个流程,在任务过程中会根据环境的动态变化判断环境的具体状态 。 类比人类认知世界的过程,我们提出参数化的世界知识模型(World Knowledge Model,WKM),在全局规划上为智能体提供先验任务知识,在局部规划上为智能体提供动态状态知识。

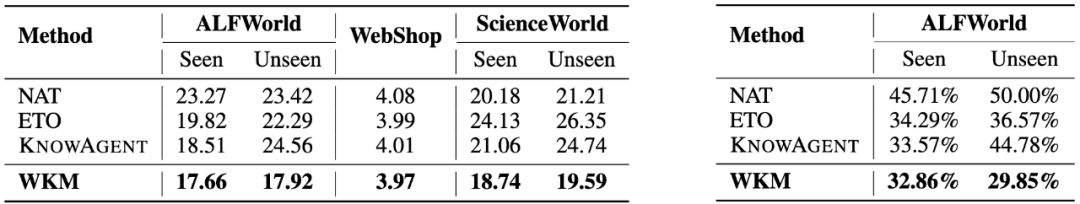

在三个复杂的真实世界模拟数据集(ALFWorld、WebShop、ScienceWorld)和三种SOTA开源模型(Mistral-7B、Gemma-7B和Llama-3-8B)上的实验结果表明,世界知识模型增强的智能体可以实现更好的性能。此外,我们分析了知识模型能够有效缓解智能体盲目试错和幻觉行为问题。其他有趣的发现包括:1)我们的实例级任务知识能够更好地泛化到未见过的任务;2)小的世界知识模型可以有效地指导更强大的智能体进行规划;3)统一的世界知识模型训练具有进一步发展的潜力。

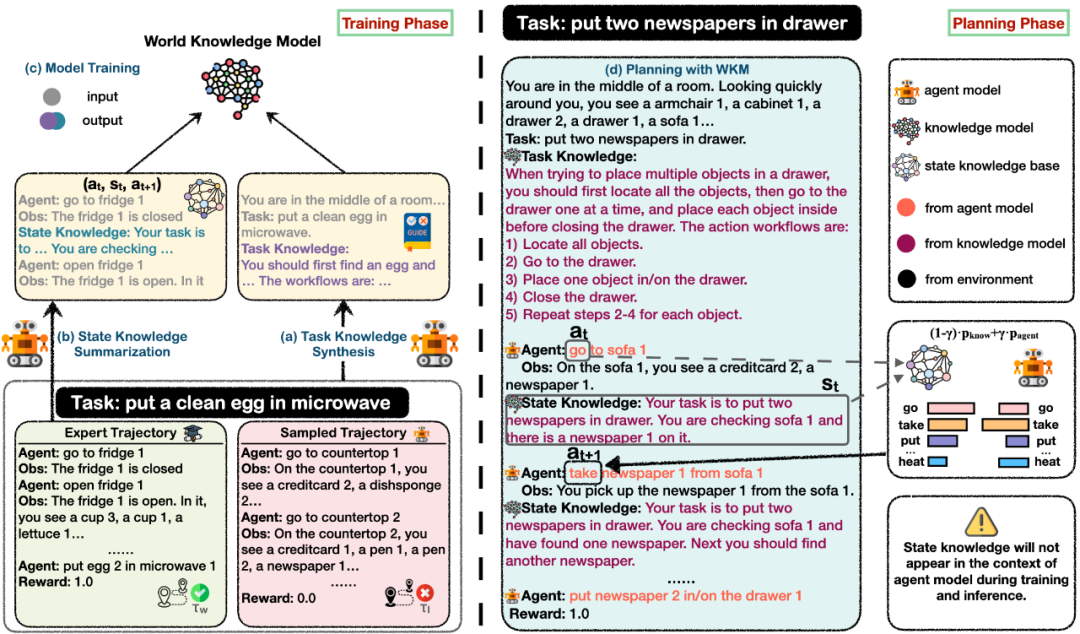

二、方法

人类通常通过向专家学习和具体实践来获取知识,我们基于专家经验和探索轨迹来构建WKM:1)首先引导智能体从专家和采样轨迹之间的比较中总结任务知识(task knowledge)。 2)我们提示它从专家轨迹中总结每个规划步骤的状态知识(state knowledge),并将前一个和下一个动作结合起来构建状态知识库。 3) 最后,我们将生成的知识整合到专家轨迹中,并训练一个知识模型来生成这些知识。同时智能体需要重新训练以适应任务知识。注意我们的代理和知识模型都是使用LoRA共享相同的主干进行训练的。 在规划阶段,我们使用WKM为智能体提供全局先验任务知识,并维护局部动态状态知识。任务知识将以自然语言形式与特定任务相结合,以指导智能体的试错过程。在每个规划步骤中,为了防止幻觉行为的发生,我们利用生成的状态知识作为query,从预先构建的状态知识库中进行检索。然后我们使用前一个动作的约束、检索到的下一个动作的概率以及代理模型的概率来对下一个动作进行加权预测。

三、主要实验

WKM在不同模型和数据集上相对于各种baseline都有相对更好的表现,特别是在ALFWorld和WebShop上能够超过GPT-4。

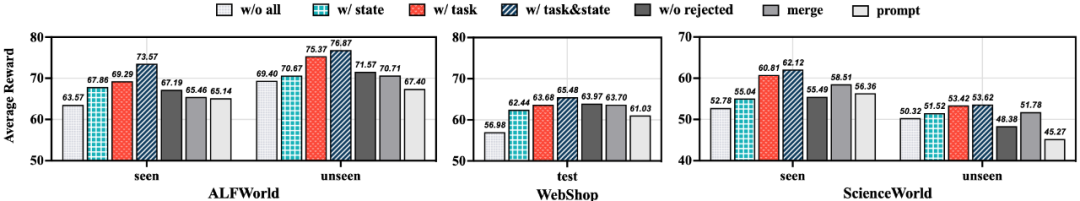

在消融研究中,我们分别分析了任务知识和状态知识的有效性。我们发现,通过任务知识带来的改进比通过状态知识更为显著。此外,状态知识对seen任务的影响比对unseen任务更为重要,而任务知识的影响则在seen任务和unseen任务中都是影响一致的。此外,我们对仅通过专家轨迹总结任务知识(w/o rejected)、将智能体和知识模型训练为同一个模型(merge)和通过prompt提供知识(prompt)三种特殊场景进行了评估。

四、分析

我们在平均规划步骤数和幻觉动作率上进一步将WKM与多种基线进行了比较。WKM能够减轻盲目试错并减少幻觉动作。并且它能够在unseen任务上保持稳定性,甚至降低比例。

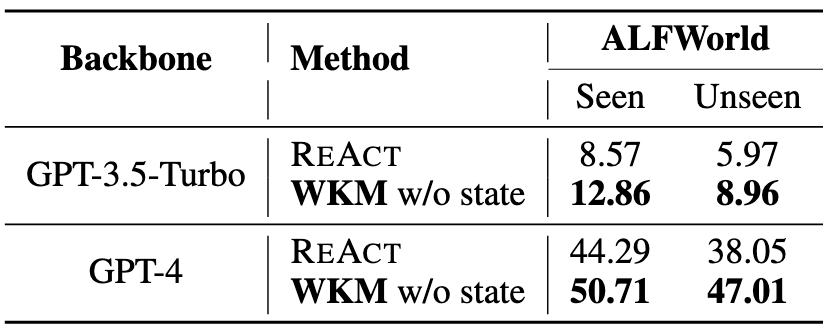

我们还进行了一些其他有趣的实验,包括使用Mistral-7B知识模型来生成任务知识,并指导像gpt-3.5-turbo和gpt-4这样的强大模型。我们发现,由较弱的Mistral-7B生成的知识可以有效地指导强大的GPT-3.5/4的规划。此外,我们将三个数据集整合在一起,训练了一个统一的WKM。通过多任务联合训练的统一参数化知识模型比单任务训练表现得更好。

五、总结

在这篇论文中,我们致力于开发一个参数化的世界知识模型(WKM)来增强语言代理模型的规划能力。我们的WKM能够生成先验任务知识来指导全局规划,以及动态状态知识来调节局部规划。实验结果表明,我们的知识可以在GPT-4和最先进的开源模型上工作,并与各种强大的基线相比实现更优越的性能。分析实验验证了我们的WKM可以:1) 减少无脑试错和幻觉动作,2) 更好地泛化到未见任务,3) 实现弱模型指导强模型,4) 有效地扩展到统一的世界知识训练。潜在的未来方向包括:1) 构建统一的世界知识模型,2) 学习像世界模型一样预测世界,3) 应用于多模态智能体规划等。