人工智能在军事中可用于多项任务,例如目标识别、大数据处理、作战系统、网络安全、后勤运输、战争医疗、威胁和安全监测以及战斗模拟和训练。

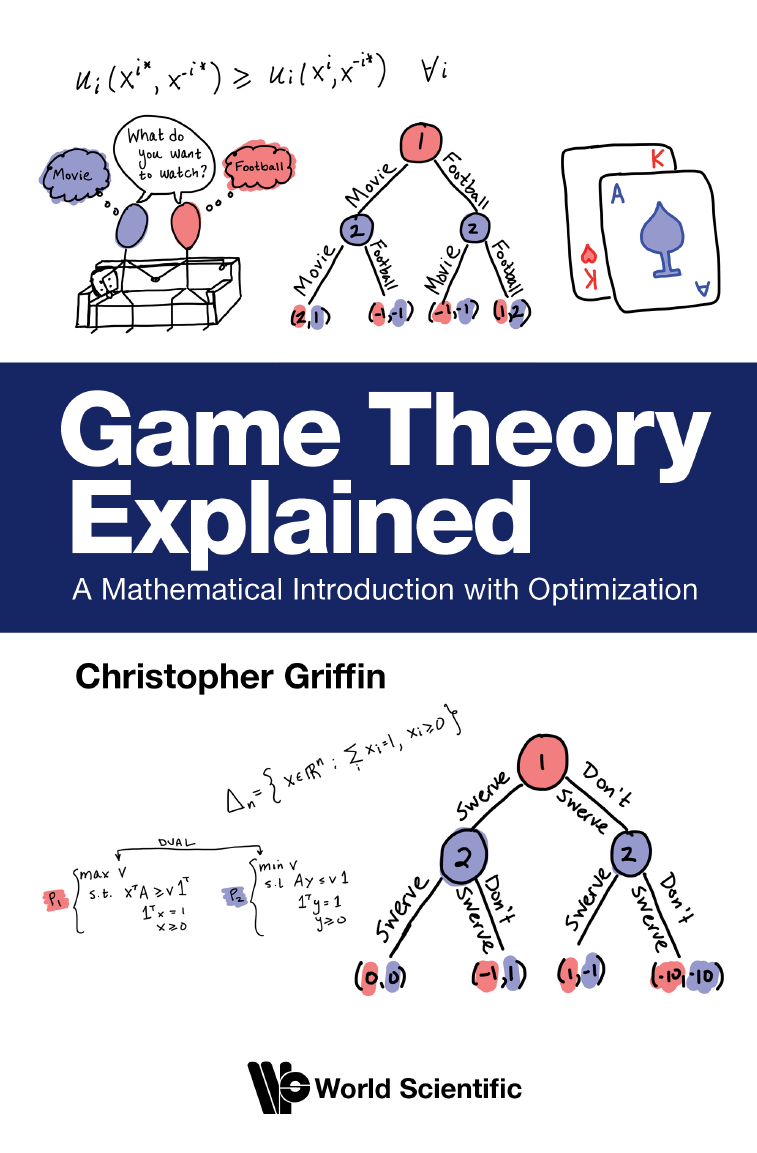

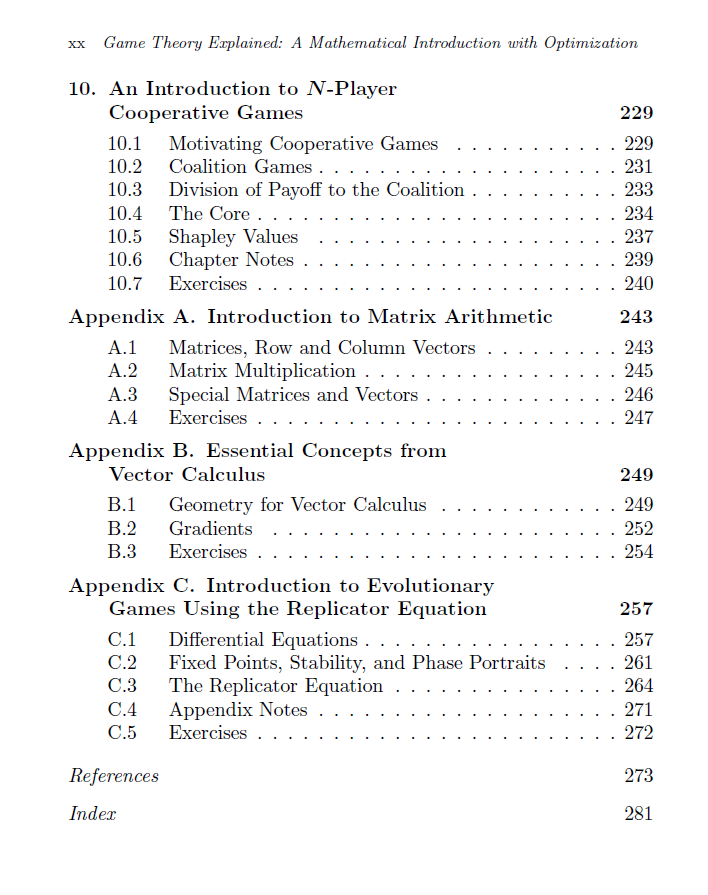

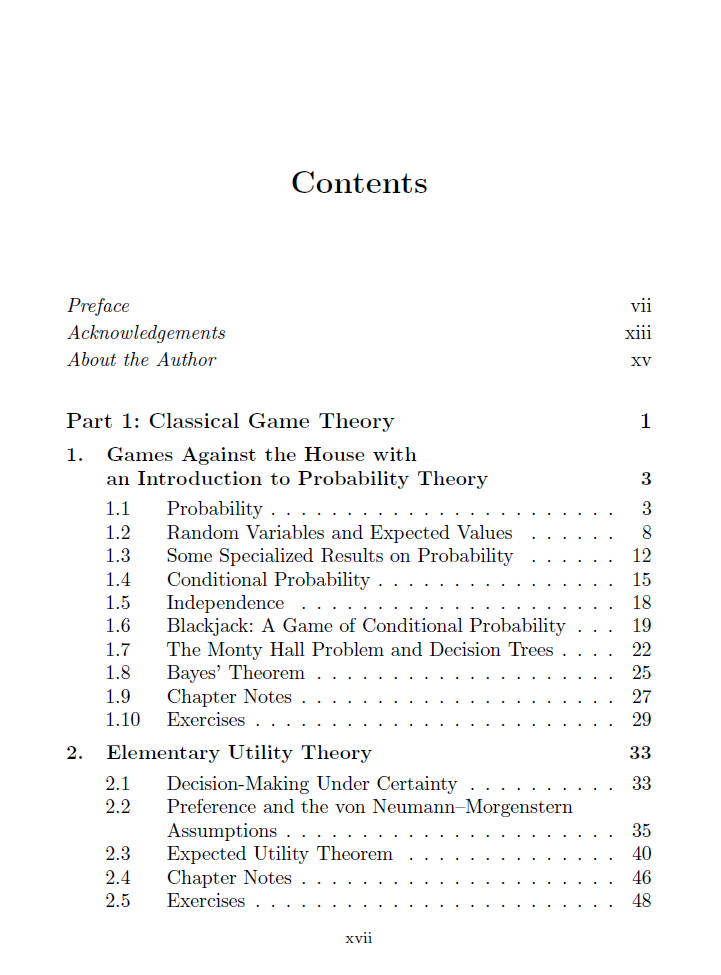

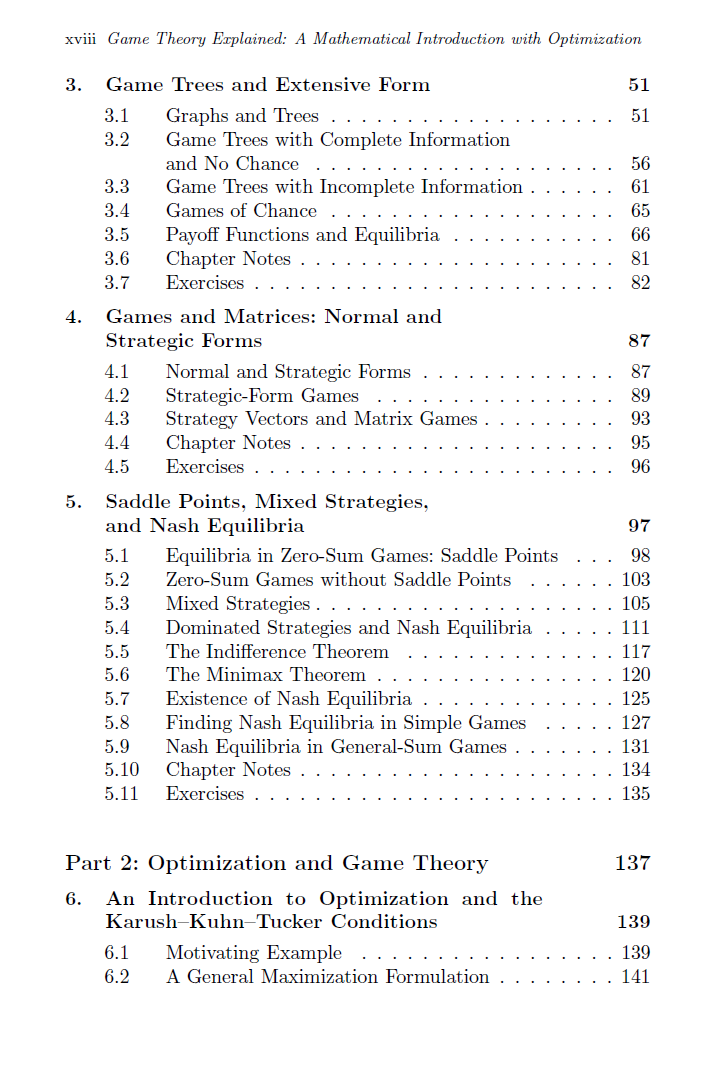

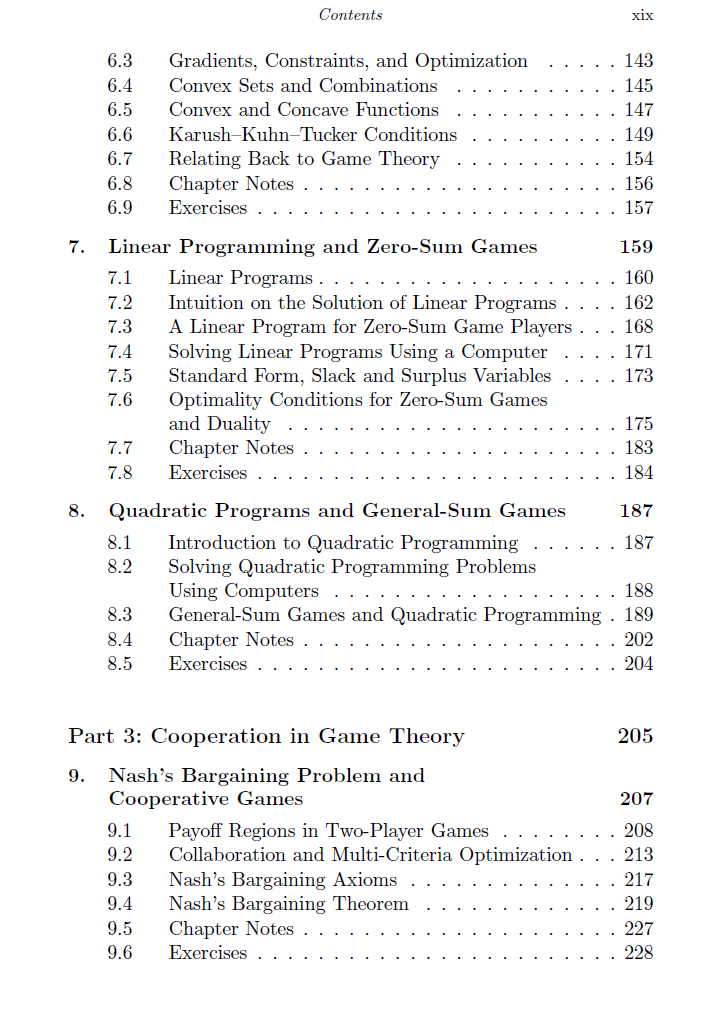

本书采用经典方法与优化理论相结合的方式,系统介绍博弈论的数学理论体系。全书采用"定理-证明-示例"的教学范式,不仅聚焦博弈论核心结论,更注重论证方法的传授。 第一部分重点阐述经典博弈理论:从赌场游戏视角的概率论基础入门,到纳什一般和博弈混合策略均衡存在性证明终章,其间完整覆盖效用理论、博弈树与极小化极大定理等核心内容,辅以丰富案例解析。第二部分引入优化理论与KKT条件,系统演示如何将博弈问题重构为优化问题以实现纳什均衡计算。第三部分专论合作博弈:创新性地将纳什议价模型重塑为多目标优化问题,并运用线性规划与对偶理论重新证明经典的Bondareva-Shapley定理。 本书提供两个数学基础附录,并特别增设进化博弈专题附录(涵盖复制动力学等现代内容),便于教师灵活替换传统教学内容。作者Christopher Griffin博士作为宾州州立大学应用研究实验室教授,在应用动力系统、博弈论与优化领域具有深厚造诣,其研究成果获美国国家科学基金会等十余家机构资助,发表学术论文逾百篇。

成为VIP会员查看完整内容