【泡泡一分钟】用于RGBD语义分割的三维图神经网络(ICCV2017-546)

每天一分钟,带你读遍机器人顶级会议文章

标题:3D Graph Neural Networks for RGBD Semantic Segmentation

作者:Xiaojuan Qi, Renjie Liao, Jiaya Jia, Sanja Fidler,Raquel Urtasun

来源:International Conference on Computer Vision (ICCV 2017)

编译:倪志鹏

审核:颜青松 陈世浪

欢迎个人转发朋友圈;其他机构或自媒体如需转载,后台留言申请授权

摘要

RGBD的语义分割需要结合2D外观和3D几何信息。在本文中,我们提出了一个3D图神经网络(3DGNN),它会在3D点云的基础上构建k-最近邻图。图中的每个节点对应一组点,而且图中每个节点和隐藏表示的向量相关联,这些向量通过一元CNN从2D图像提取的外观特征来实现初始化。依赖循环函数,每个节点根据当前状态和来自其近邻的传入消息动态来更新其隐藏表示。该传播模型在一定的时间步长中展开,并且最终每个节点的表示可用于预测每个像素的语义类。我们使用反向传播算法来训练模型。

在NYUD2和SUN-RGBD数据集的基础上,我们通过多次实验证明了以上方法是行之有效的。

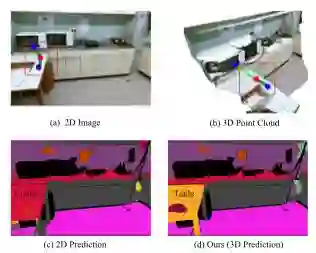

图1 实线表示3D中的近邻,而虚线表示2D中的近邻但不是3D中的近邻。(a)输入图像(b)2D图像投影到3D点云(c)通过具有HHA编码的双流CNN进行预测;(d)我们的3DGNN预测图

Abstract

RGBD semantic segmentation requires joint reasoning about 2D appearance and 3D geometric information.

In this paper we propose a 3D graph neural network (3DGNN)that builds a k-nearest neighbor graph on top of 3D point cloud.Each node in the graph corresponds to a set of points and is associated with a hidden representation vector initialized with an appearance feature extracted by a unary CNN from 2D images.

Relying on recurrent functions, every node dynamically updates its hidden representation based on the current status and incoming messages from its neighbors. This propagation model is unrolled for a certain number of time steps and the final per-node representation is used for predicting the semantic class of each pixel.We use back-propagation through time to train the model. Extensive experiments on NYUD2 and SUN-RGBD datasets demonstrate the effectiveness of our approach.

如果你对本文感兴趣,想要下载完整文章进行阅读,可以关注【泡泡机器人SLAM】公众号(paopaorobot_slam)。

欢迎来到泡泡论坛,这里有大牛为你解答关于SLAM的任何疑惑。

有想问的问题,或者想刷帖回答问题,泡泡论坛欢迎你!

泡泡网站:www.paopaorobot.org

泡泡论坛:http://paopaorobot.org/forums/

泡泡机器人SLAM的原创内容均由泡泡机器人的成员花费大量心血制作而成,希望大家珍惜我们的劳动成果,转载请务必注明出自【泡泡机器人SLAM】微信公众号,否则侵权必究!同时,我们也欢迎各位转载到自己的朋友圈,让更多的人能进入到SLAM这个领域中,让我们共同为推进中国的SLAM事业而努力!

商业合作及转载请联系liufuqiang_robot@hotmail.com