【泡泡点云时空】基于移动平台的激光雷达点云投影到相机图像上的不确定性估计

泡泡点云时空,带你精读点云领域顶级会议文章

标题:Uncertainty Estimation for Projecting Lidar Points onto Camera Images for Moving Platforms

作者:Charika De Alvis, Mao Shan, Stewart Worrall, and Eduardo Nebot

来源:ICRA2019

编译:陈贝章

审核:Lionheart

欢迎个人转发朋友圈;其他机构或自媒体如需转载,后台留言申请授权

摘要

结合多传感设备以实现高级的感知能力是自动驾驶汽车导航的关键要求。传感器融合用于获取有关周围环境的丰富信息。摄像头和激光雷达传感器的融合可获取精确的范围信息,该信息可以投影到可视图像数据上。这样可以对场景有一个高层次的认识,可以用来启用基于上下文的算法,例如避免碰撞更好的导航。组合这些传感器时的主要挑战是将数据对齐到一个公共域中。由于照相机的内部校准中的误差,照相机与激光雷达之间的外部校准以及平台运动导致的误差,因此这可能很困难。在本文中,我们研究了为激光雷达传感器提供运动校正所需的算法。由于不可能完全消除由于激光雷达的测量值投影到同一里程计框架中而导致的误差,因此,在融合两个不同的传感器时,必须考虑该投影的不确定性。这项工作提出了一个新的框架,用于预测投影到移动平台图像帧(2D)中的激光雷达测量值(3D)的不确定性。所提出的方法将运动校正的不确定性与外部和内部校准中的误差所导致的不确定性相融合。通过合并投影误差的主要成分,可以更好地表示估计过程的不确定性。我们的运动校正算法和提出的扩展不确定性模型的实验结果通过在电动汽车上收集的真实数据进行了演示,该电动汽车配备了可覆盖180度视野的广角摄像头和16线扫描激光雷达。

主要贡献

(1)提出一种为激光雷达到摄像机投影问题生成准确一致的不确定性估计的方法。

(2)提出了运动校正错误的公式,包括平台在给定时间范围内的平移和旋转方差。

(3)在基于校准参数的不确定性来估计激光雷达对图像投影的不确定性的基础上,结合运动校正引入的不确定性以及其他典型的校准误差,以提供可靠的不确定性估计。

实验平台与实验介绍

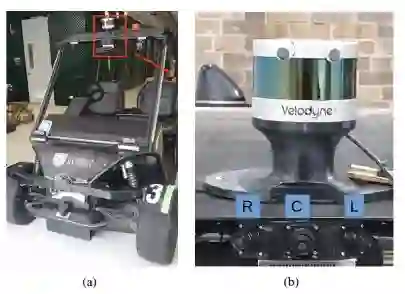

图1.移动实验平台。(a)展示了车辆的前部,(b)展示了VLP-16激光雷达和前向三个GMSL摄像机的安装位置。标签R,C和L分别代表右,中和左摄像机

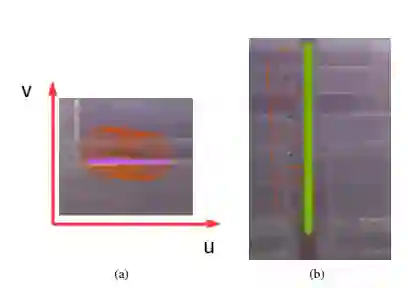

图2.(a)和(b)分别为激光点在图像像素坐标系的u和v方向上中的移动

表I.激光对相机投影的估计误差和真实误差

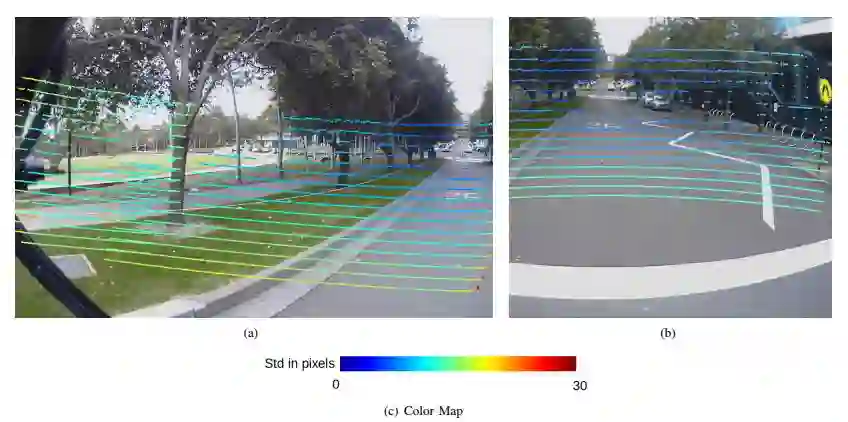

图3.激光雷达对静态平台的相机投影不确定性。(a)和(b)分别代表沿u和v轴的像素坐标的不确定性,(c)为不确定度颜色图

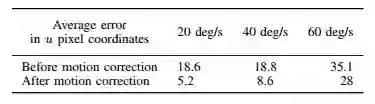

表2.循环运动中的运动校正精度

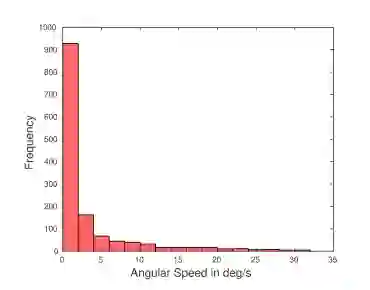

图4.在校园内正常行驶期间转弯速率的直方图

实验结果与结论

图5.以30 km / h的速度行驶时,激光点投射到图像上。根据点在像素坐标系中沿u和v轴所产生的方差,对点进行着色。左图是从左相机拍摄的,右图是中央相机的图像的一部分

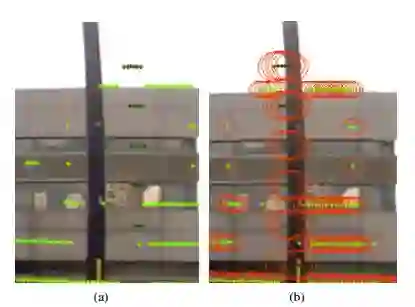

图6.(a)中的运动校正前和(b)中的运动校正后的图像比较。以每个投影点为中心的红色椭圆表示真实点所在的区域,可能性为95%

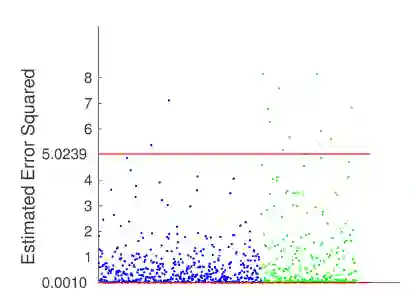

图7. 直线运动(蓝色)和旋转运动(绿色)的投影激光雷达坐标的误差平方估计(EES)值分布。红线代表95%X2(卡方分布)满足置信区间,图中样本个数为865。

在本文中,我们提出了一种准确的将3D激光雷达点投影到2D摄像机图像帧的不确定性估计方法。该方法考虑了由平移和旋转运动校正引起的不确定性。所提出的框架使得能够合并运动校正中的误差,以及其他不确定性源,例如由外部和固有校准引入的那些不确定性。运动校正过程中的不确定性使用车辆两次里程测量值之间的线性位移和角度位移的方差来表示。然后,使用雅可比方法将考虑所有误差源的不确定性投影到图像像素帧中。一整套综合的实验结果证明了不确定度估计的准确性。实验是在配备有激光雷达,摄像头,GPS和IMU传感器并在大学校园环境中四处行驶的电动汽车上进行的。投影不确定性的一致估计对于组合激光雷达和相机数据的数据融合算法至关重要。

Abstract

Combining multiple sensors for advanced perception is a crucial requirement for autonomous vehicle navigation. Heterogeneous sensors are used to obtain rich information about the surrounding environment. The combination of the camera and lidar sensors enables precise range information that can be projected onto the visual image data. This gives a high level understanding of the scene which can be used to enable context based algorithms such as collision avoidance and navigation. The main challenge when combining these sensors is aligning the data into a common domain. This can be difficult due to the errors in the intrinsic calibration of the camera, extrinsic calibration between the camera and the lidar and errors resulting from the motion of the platform. In this paper, we examine the algorithms required to provide motion correction for scanning lidar sensors. The error resulting from the projection of the lidar measurements into a consistent odometry frame is not possible to remove entirely, and as such it is essential to incorporate the uncertainty of this projection when combining the two different sensor frames. This work proposes a novel framework for the prediction of the uncertainty of lidar measurements (in 3D) projected in to the image frame (in 2D) for moving platforms. The proposed approach fuses the uncertainty of the motion correction with uncertainty resulting from errors in the extrinsic and intrinsic calibration. By incorporating the main components of the projection error, the uncertainty of the estimation process is better represented. Experimental results for our motion correction algorithm and the proposed extended uncertainty model are demonstrated using real-world data collected on an electric vehicle equipped with wide-angle cameras covering a 180-degree field of view and a 16-beam scanning lidar.

如果你对本文感兴趣,想要下载完整文章进行阅读,可以关注【泡泡机器人SLAM】公众号。

欢迎来到泡泡论坛,这里有大牛为你解答关于SLAM的任何疑惑。

有想问的问题,或者想刷帖回答问题,泡泡论坛欢迎你!

泡泡网站:www.paopaorobot.org

泡泡论坛:http://paopaorobot.org/bbs/

泡泡机器人SLAM的原创内容均由泡泡机器人的成员花费大量心血制作而成,希望大家珍惜我们的劳动成果,转载请务必注明出自【泡泡机器人SLAM】微信公众号,否则侵权必究!同时,我们也欢迎各位转载到自己的朋友圈,让更多的人能进入到SLAM这个领域中,让我们共同为推进中国的SLAM事业而努力!

商业合作及转载请联系liufuqiang_robot@hotmail.com