【泡泡图灵智库】基于帧间深度传播的自适应基线单目稠密建图(IROS)

泡泡图灵智库,带你精读机器人顶级会议文章

标题:Adaptive Baseline Monocular Dense Mapping with Inter-frame Depth Propagation

作者:Kaixuan Wang and Shaojie Shen

来源:IROS 2018

编译:万应才

审核:李雨昊

欢迎个人转发朋友圈;其他机构或自媒体如需转载,后台留言申请授权

摘要

大家好,今天为大家带来的文章是——基于帧间深度传播的自适应基线单目稠密建图,该文章发表于IROS 2018。

目前最先进的单目密集建图方法通常将图像序列划分为几个单独的多视图立体问题,因此在多基线观测和序列深度估计中对信息的利用有限。本文提出了利用信息来提高建图性能的两个核心算法。第一种是自适应基线匹配成本计算,它使用顺序输入图像为每个像素提供宽基线观测。第二种是帧到帧传播深度滤波器,它以一种鲁棒的概率方式集成了同一物理点的序列深度估计。两个算法被集成到一个单目密集建图系统中,该系统为针孔和鱼眼相机实时生成深度建图。作者的系统完全并行化,可以在Nvidia Jetson TX2上以超过25 fps的速度运行。

作者将其工作与公共数据集上最先进的方法进行了比较。机载无人机绘图和手持实验也用来证明作者的方法的性能。作者将系统代码开源:https://github.com/HKUST-Aerial-Robotics/Pinhole-Fisheye-Mapping

主要贡献

1.提出了一种自适应基线匹配成本计算,它利用顺序输入图像中的信息。在保证图像重叠的同时,利用以前输入图像中可用的宽基线观测值计算每个像素的匹配成本。该方法解决了大基线测量帧与图像重叠的共同难题。

2.提出了一种帧间传播深度滤波器,融合了序列深度估计。深度图融合在一个强大的概率方法,其中的估计是精炼和离群值检测。

3.开源了一个单目密集建图系统,通过所提出的自适应基线成本计算和传播深度滤波器,利用输入图像的序列信息生成深度图。

算法流程

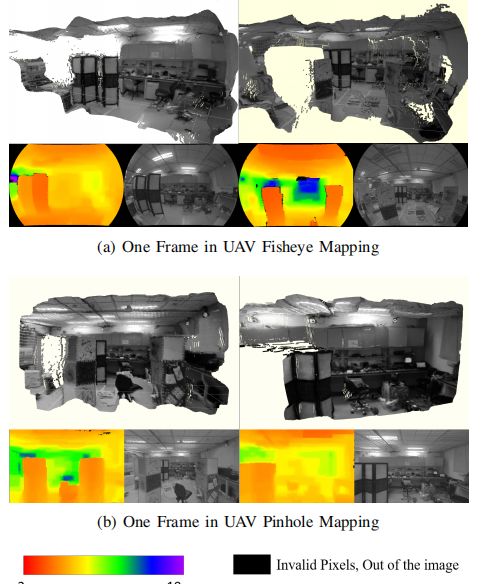

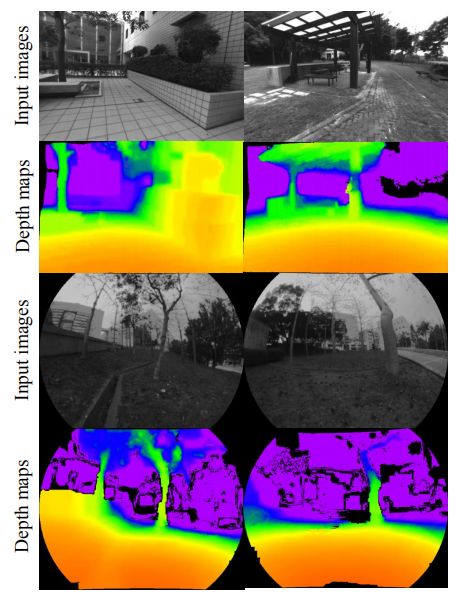

图1 无人机鱼眼和针孔建图

本文在VINS深度估计的基础上,认为已经得到运动矩阵。输入图像地图年龄不断更新

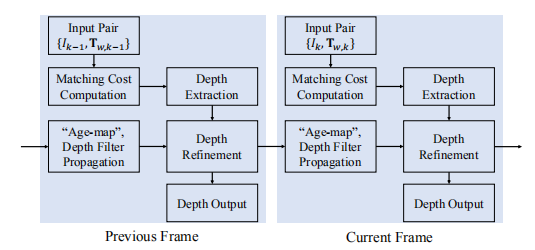

图 2 系统整体框架图

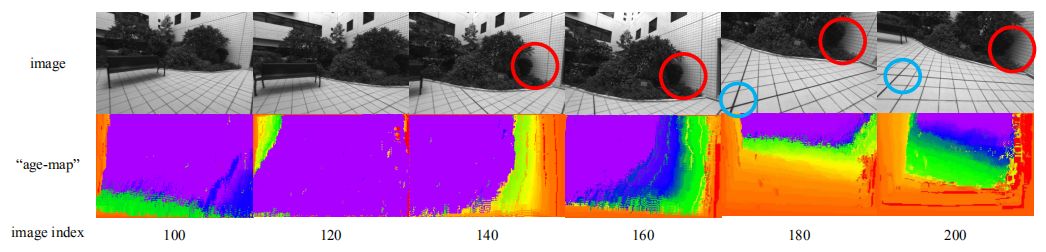

1.在系统中维护一个“年龄图”,以记录每个像素观察到的先前帧的数量。在匹配成本计算过程中,根据像素“年龄”,为每个像素专门选择测量帧。利用像素的宽基线观测,确保重叠。

2.将一个概率深度滤波器从一帧传播到另一帧,将当前的深度估计与以前的估计融合在一起。在融合过程中对深度估计进行了改进,并检测出异常值。将所提出的匹配成本计算方法和深度滤波器集成到一个能产生高质量密度的单目密集建图系统中。

图3 “年龄”图在建图过程中传播示例

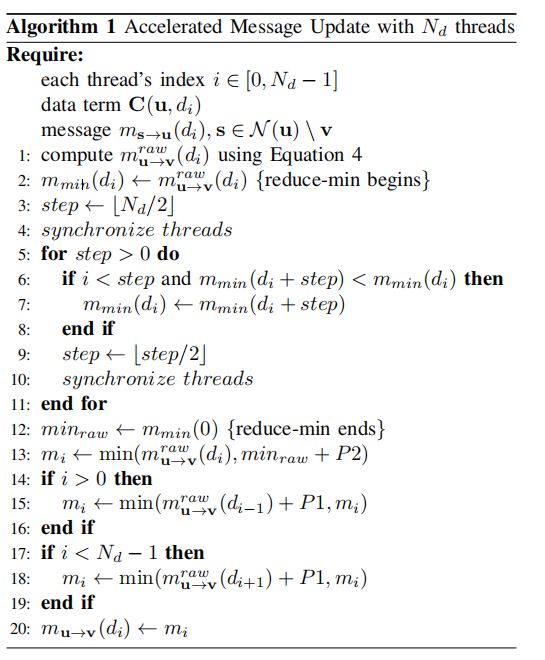

3. 加速信息更新算法

图4 信息更新加速算法

主要结果

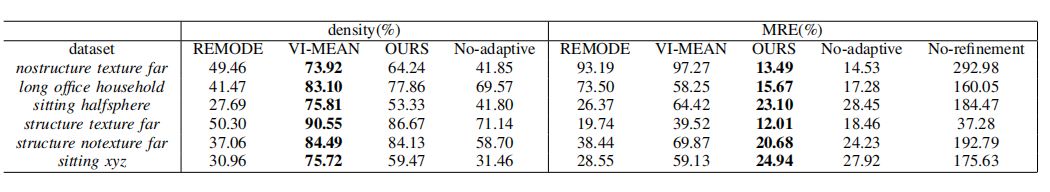

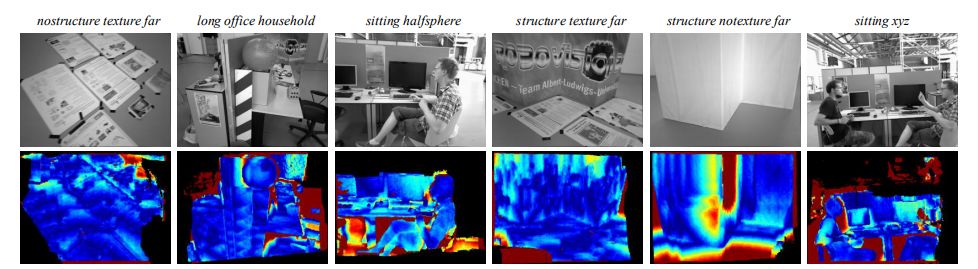

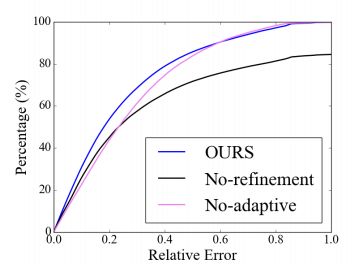

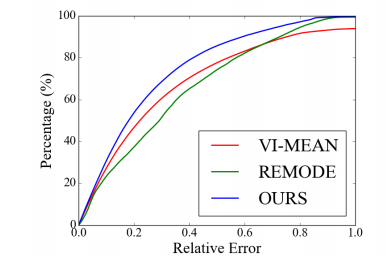

1、tum数据集测试本文提出的方法在六种情况下的相对误差图

图 5 六种环境下的相对误差

第一行是对应序列的快照。下一行是深度图像的误差图。误差图是用颜色编码在喷流颜色图中的:冷颜色表示小误差,暖颜色表示大误差。黑色表示被深度过滤器掩盖的异常像素。请注意,我们的方法生成平滑的深度图,而不存在“条纹”瑕疵,并且可以很好地处理无纹理区域(例如,在结构notexture far中)。概率滤波器可以检测异常值(例如,移动物体引起的异常值,如序列位于xyz),并保持内部深度估计

图 6 相对误差

2、机体上实际测试

作者在无人机的实验室环境中使用针孔和鱼眼相机测试系统。使用针孔和鱼眼摄像机在室外环境中测试该方法。深度图的颜色编码与图1相同。实验结果表明,该方法能较好地捕捉到杆、树等精细结构。生成的深度图平滑致密。

图7 无人机实际测试结果

Abstract

State-of-the-art monocular dense mapping methods usually divide the image sequence into several separate multi-view stereo problems thus have limited utilization of the information in multi-baseline observations and sequential depth estimations. In this paper, two core contributions are proposed to improve the mapping performance by exploiting the information. The first is an adaptive baseline matching cost computation that uses the sequential input images to provide each pixel with wide-baseline observations. The second is a frame-to-frame propagated depth filter which integrates the sequential depth estimation of the same physical point in a robust probabilistic manner. Two contributions are integrated into a monocular dense mapping system that generates the depth maps in real-time for both pinhole and fisheye cameras. Our system is fully parallelized and can run at more than 25 fps on a Nvidia Jetson TX2. We compare our work with state-of-the-art methods on the public dataset. Onboard UAV mapping and handhold experiments are also used to demonstrate the performance of our method. For the benefit of the community, we make the implementation open source.

如果你对本文感兴趣,想要下载完整文章进行阅读,可以关注【泡泡机器人SLAM】公众号。

点击阅读原文,即可获取本文下载链接。

欢迎来到泡泡论坛,这里有大牛为你解答关于SLAM的任何疑惑。

有想问的问题,或者想刷帖回答问题,泡泡论坛欢迎你!

泡泡网站:www.paopaorobot.org

泡泡论坛:http://paopaorobot.org/bbs/

泡泡机器人SLAM的原创内容均由泡泡机器人的成员花费大量心血制作而成,希望大家珍惜我们的劳动成果,转载请务必注明出自【泡泡机器人SLAM】微信公众号,否则侵权必究!同时,我们也欢迎各位转载到自己的朋友圈,让更多的人能进入到SLAM这个领域中,让我们共同为推进中国的SLAM事业而努力!

商业合作及转载请联系liufuqiang_robot@hotmail.com