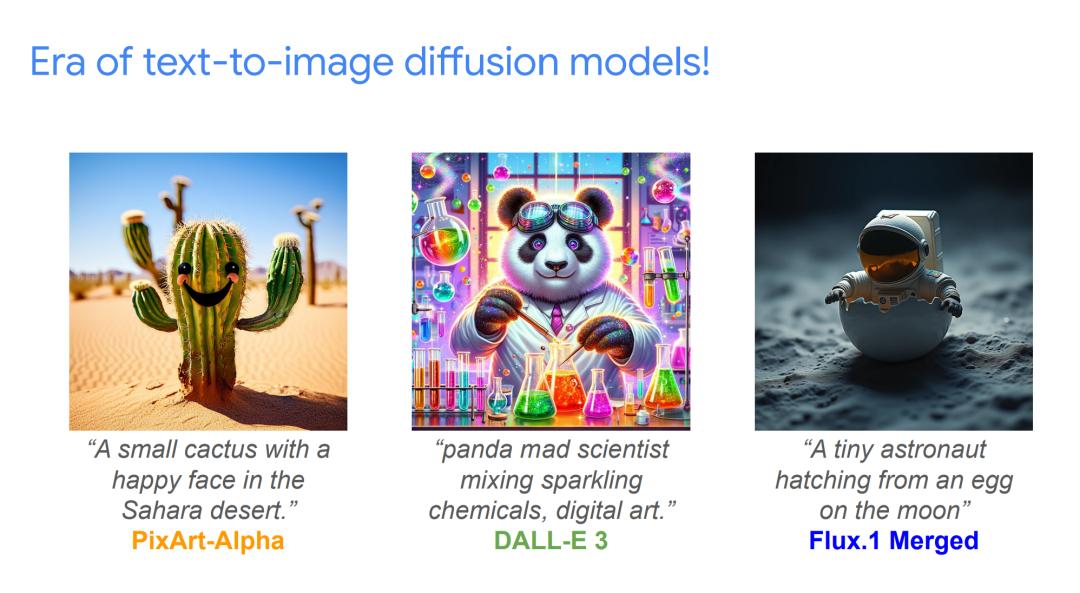

扩散模型近年来在生成逼真但合成的连续媒体内容方面引起了广泛关注。本次演讲将介绍 Transformer 在图像生成的扩散模型中的应用,并进一步探讨其更广泛的前景。 我们首先简要介绍扩散模型的基础知识以及它们的训练方式,从而建立基本背景。接着,我们讲解曾是扩散模型事实标准的基于 UNet 的网络架构,这将帮助我们理解引入 Transformer 架构并推动其发展的动因。 随后,我们将深入探讨构成基础架构的核心模块,以及在不同条件设定下可以做架构消融实验的自由度。接着,我们将重点介绍当前社区在多个 SoTA 开源模型中用于各种应用场景的多种注意力机制变体及相关组件。

最后,我们将讨论一些围绕效率方面的前沿研究方向,为未来的发展提供启发。 **演讲者简介:**Sayak 目前在 Hugging Face 从事扩散模型相关工作。他的日常工作包括为 diffusers 库贡献代码、训练和调试扩散模型,以及探索应用层面的新想法。他的兴趣方向包括基于主体的生成、偏好对齐和扩散模型的评估。工作之余,他喜欢弹吉他、刷 ICML 教程以及追剧《金装律师》(Suits)。

成为VIP会员查看完整内容

相关内容

专知会员服务

10+阅读 · 2022年3月8日

专知会员服务

62+阅读 · 2020年4月19日

Arxiv

40+阅读 · 2023年4月19日

Arxiv

81+阅读 · 2023年4月4日

Arxiv

145+阅读 · 2023年3月29日