【泡泡一分钟】利用速度估计方法减小单目视觉定位和建图中的尺度偏移(3dv-63)

每天一分钟,带你读遍机器人顶级会议文章

标题:Using learning of speed to stabilize scale in monocular localization and mapping

作者:Duncan P Frost,David W Murray,Victor A Prisacariu

来源:3dv 2017 ( International Conference on 3D Vision)

播音员:zhuying

编译:王健(90)

欢迎个人转发朋友圈;其他机构或自媒体如需转载,后台留言申请授权

摘要

大家好,今天给大家介绍一项单目视觉SLAM中尺度矫正的新方法——Using learning of speed to stabilize scale in monocular localization and mapping,该文章发表于3dv-2017。

单目视觉进行定位和建图算法估计环境尺度,但是会造成尺度漂移,难以实现闭环检测,最终导致失败。本文描述了一种针对尺度漂移校正的图像驱动方法,该方法使用了卷积神经网络,并根据连续的单目视频帧推断相机的速度。作者得到了连续的漂移校正,避免需要明确的高级地图表示来解决此类尺度问题。作者还提出了一种新方法,在BA中把速度估计写成一正则化矩阵,避免了尺度信息激增导致的信息冗余缺陷。作者使用长距离视频流来验证该方法,其中地面实况可得,结果显示基本没有尺度漂移。作者使用单目数据与多种其他尺度漂移矫正方法进行性能比较,最后结果表明本文方法能够得到更加精确的结果。

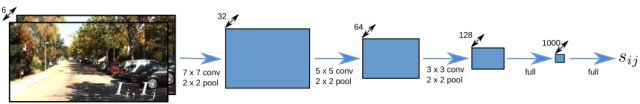

同时贴上文章中作者的卷积神经网络构架图:

图1 显示从图像对中进行速度回归的网络架构

本文结果显示如下:

图2 (a)为使用KITTI数据集中00序列,由没有任何尺度稳定性的单目系统产生的地图。(b)为作者使用了文中提出的方法在相同系统下产生的地图。在两个图中显示出了00序列的地面实况轨迹。

Abstract

Monocular visual localization and mapping algorithms are able to estimate the environment only up to scale, a degree of freedom which leads to scale drift, difficulty closing loops, and eventual failure. This paper describes an image-driven approach for scale-drift correction which uses a convolutional neural network to infer the speed of the camera from successive monocular video frames. We obtain continuous drift correction, avoiding the need for explicit higher-level representations of the map to resolve scale. We also propose a novel method of including speed estimates as a regularizer in bundle adjustment which avoids the pitfalls of sudden imposition of scale knowledge. We demonstrate our approach using long-distance sequences for which ground truth is available, and find output that is essentially free of scale drift. We compare the performance with number of other methods for scale-drift correction from monocular data, and show that our solution achieves more accurate results.

如果你对本文感兴趣,想要下载完整文章进行阅读,可以关注【泡泡机器人SLAM】公众号(paopaorobot_slam)。

链接: https://pan.baidu.com/s/1V0kBY14JdrHy-wOBWYoQlg 密码: x4h5

泡泡机器人SLAM的原创内容均由泡泡机器人的成员花费大量心血制作而成,希望大家珍惜我们的劳动成果,转载请务必注明出自【泡泡机器人SLAM】微信公众号,否则侵权必究!同时,我们也欢迎各位转载到自己的朋友圈,让更多的人能进入到SLAM这个领域中,让我们共同为推进中国的SLAM事业而努力!

商业合作及转载请联系liufuqiang_robot@hotmail.com