【泡泡一分钟】单目视觉惯性SLAM的重定位,全局优化和地图融合

每天一分钟,带你读遍机器人顶级会议文章

标题:Relocalization, Global Optimization and Map Merging for Monocular Visual-Inertial SLAM

作者:Tong Qin, Peiliang Li, and Shaojie Shen

来源:2018 IEEE International Conference on Robotics and Automation (ICRA) May 21-25, 2018, Brisbane, Australia

编译:李建禹

审核:颜青松,陈世浪

欢迎个人转发朋友圈;其他机构或自媒体如需转载,后台留言申请授权

摘要

单目视觉惯性系统(HKUST-VINS)由一个摄像头和一个低成本惯性测量单元(IMU)组成,是实现精确6自由度状态估计的流行方法。然而,这种局部精确的视觉惯性里程计容易受漂移影响,且不能提供绝对姿态估计,利用历史信息重新定位和纠正漂移已成为一个研究热点。

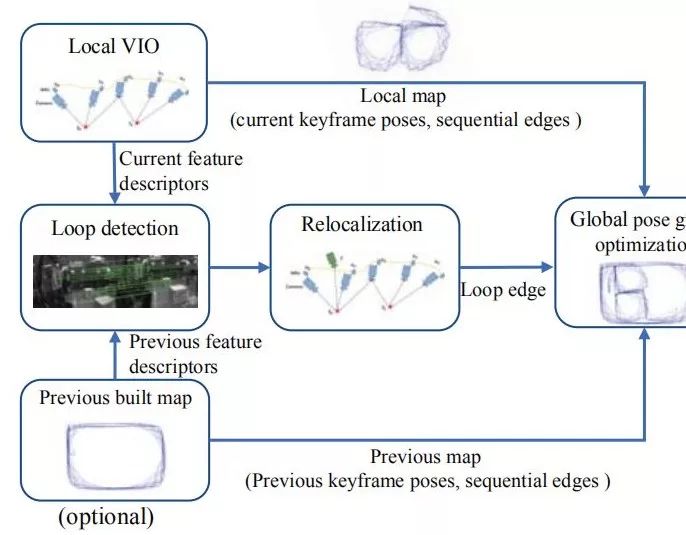

在本文中,作者提出了一种单目视觉惯性SLAM系统,它可以对相机重定位并在事先构建的地图中获得绝对位姿,然后执行4自由度位姿图优化以校正漂移并实现全局一致性。4自由度包含x,y,z三个方向平移和偏航角,它们是视觉惯性系统中的实际漂移方向。此外,所提出的系统可以通过以有效的方式保存和加载地图来重用地图。当前地图和先前地图可以通过全局位姿图优化合并在一起。作者在公共数据集上验证系统的准确性,并与其他最先进的算法进行比较。作者还评估了此系统在大型户外环境中的地图合并能力。地图复用的源代码已集成到的公共代码VINS-Mono中。

Abstract

The monocular visual-inertial system (VINS),which consists one camera and one low-cost inertial measurement unit (IMU), is a popular approach to achieve accurate 6-DOF state estimation. However, such locally accurate visual-inertial odometry is prone to drift and cannot provide absolute pose estimation. Leveraging history information to relocalize and correct drift has become a hot topic. In this paper, we propose a monocular visual-inertial SLAM system, which can relocalize camera and get the absolute pose in a previous-built map. Then 4-DOF pose graph optimization is performed to correct drifts and achieve global consistent. The 4-DOF contains x, y, z, and yaw angle, which is the actual drifted direction in the visual-inertial system. Furthermore, the proposed system can reuse a map by saving and loading it in an efficient way. Current map and previous map can be merged together by the global pose graph optimization. We validate the accuracy of our system on public datasets and compare against other state-of-the-art algorithms. We also evaluate the map merging ability of our system in the large-scale outdoor environment. The source code of map reuse is integrated into our public code, VINS-Mono.

如果你对本文感兴趣,请点击点击阅读原文下载完整文章,如想查看更多文章请关注【泡泡机器人SLAM】公众号(paopaorobot_slam)。

百度网盘提取码:e16n

欢迎来到泡泡论坛,这里有大牛为你解答关于SLAM的任何疑惑。

有想问的问题,或者想刷帖回答问题,泡泡论坛欢迎你!

泡泡网站:www.paopaorobot.org

泡泡论坛:http://paopaorobot.org/bbs/

泡泡机器人SLAM的原创内容均由泡泡机器人的成员花费大量心血制作而成,希望大家珍惜我们的劳动成果,转载请务必注明出自【泡泡机器人SLAM】微信公众号,否则侵权必究!同时,我们也欢迎各位转载到自己的朋友圈,让更多的人能进入到SLAM这个领域中,让我们共同为推进中国的SLAM事业而努力!

商业合作及转载请联系liufuqiang_robot@hotmail.com