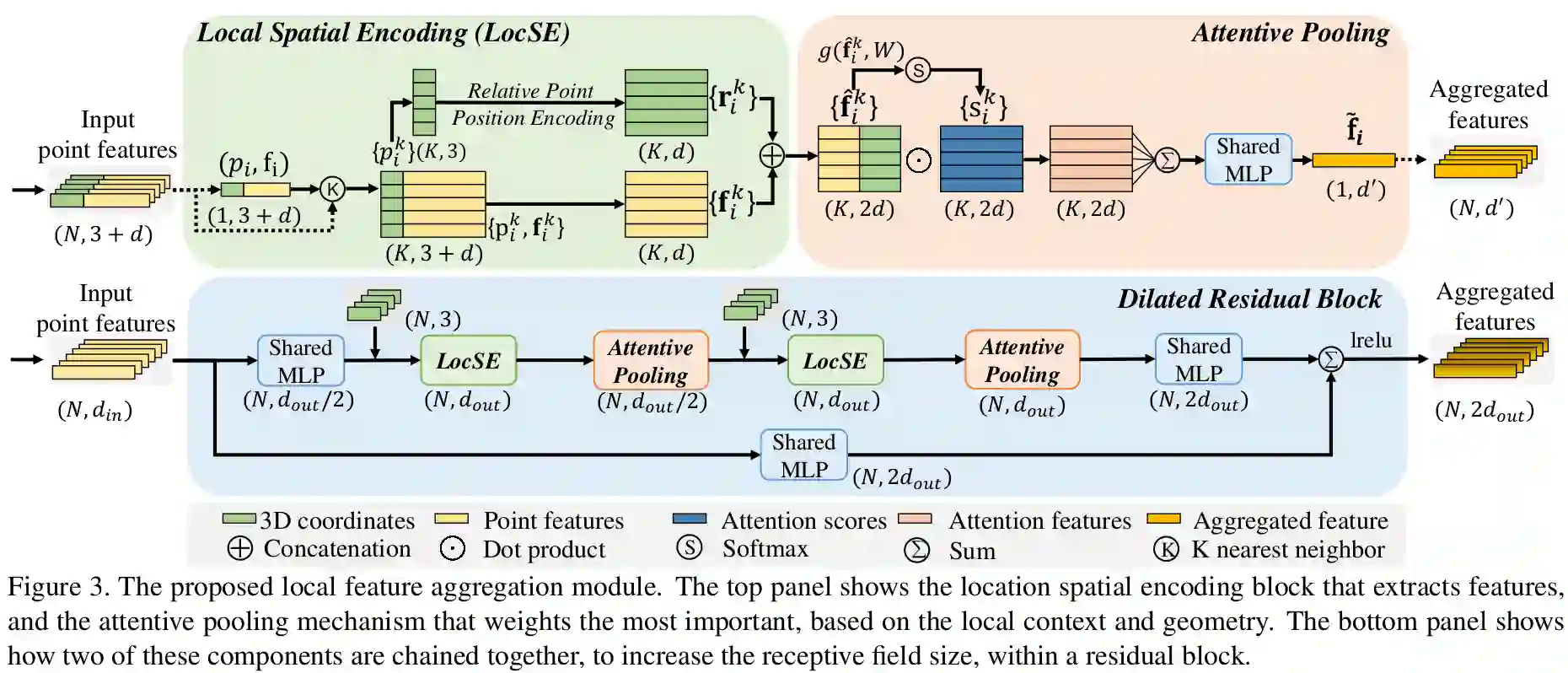

研究了大规模三维点云的有效语义分割问题。通过依赖昂贵的采样技术或繁重的计算预处理/后处理步骤,大多数现有的方法只能在小规模点云上进行训练和操作。在这篇文章中,我们介绍了一种高效的轻量级神经结构——RandLA-Net,它可以直接推断大规模点云的每点语义。我们的方法的关键是使用随机点抽样而不是更复杂的点选择方法。虽然随机抽样具有很高的计算效率和内存效率,但它也会随机地丢弃一些关键特性。为了克服这个问题,我们引入了一个新的局部特征聚合模块,逐步增加每个3D点的接受域,从而有效地保留几何细节。大量实验表明,我们的RandLA-Net单次可以处理100万个点,速度比现有方法快200倍。此外,我们的RandLA-Net在语义分割的两个大规模基准上明显超过了最先进的方法Semantic3D和SemanticKITTI。

成为VIP会员查看完整内容