【泡泡一分钟】点云到网格的回归算法实现

每天一分钟,带你读遍机器人顶级会议文章

标题:From Point Clouds to Mesh using Regression

作者:L’ubor Ladický, Olivier Saurer, SoHyeon Jeong

来源:International Conference on Computer Vision (ICCV 2017)

编译:刘梦雅

审核:颜青松 陈世浪

欢迎个人转发朋友圈;其他机构或自媒体如需转载,后台留言申请授权

摘要

基于点云的表面重建一直是在三维场景重建中的一个标准子问题,即利用RGB图和深度图实现的三维重建工作。仅在各个点附近执行局部操作的方法速度非常快,但重建的模型通常含有许多空洞。另一方面,正则化的体元方法构成一个全局优化问题来解决,在实时交互的性能上又太慢。

因此,我们提出使用以回归森林为基础的方法,根据网格点邻域中点密度的空间结构分布,预测网格点到表面的投影。我们设计了一个合适的特征向量以及一个高效的oct树用于在GPU上进行快速评估,能够预测高分辨率的3D模型,准确率在几毫米以内。我们的方法可以学习并预测基于标准点云更稀疏的观测点云的表面重建,因此可以有效的充当正则器。

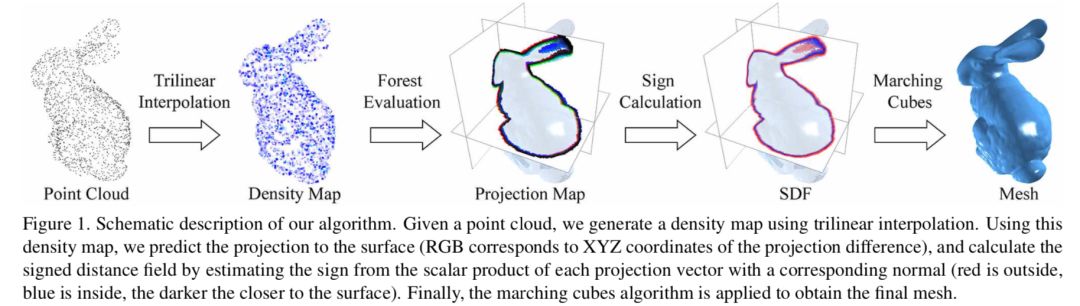

该方法的整体流程见下图。已知一个点云,我们首先使用三边插值生成一个稠密点云,并将其进行预测投影到表面上(RGB对应于投影差异的XYZ坐标),通过估计每个投影向量的标量积与相应法线的符号来计算有符号距离场 (红色表示外沿接近表面部分,蓝色表示内部,颜色越深表示越接近表面)。最后,应用立方体算法来获得最终网格。

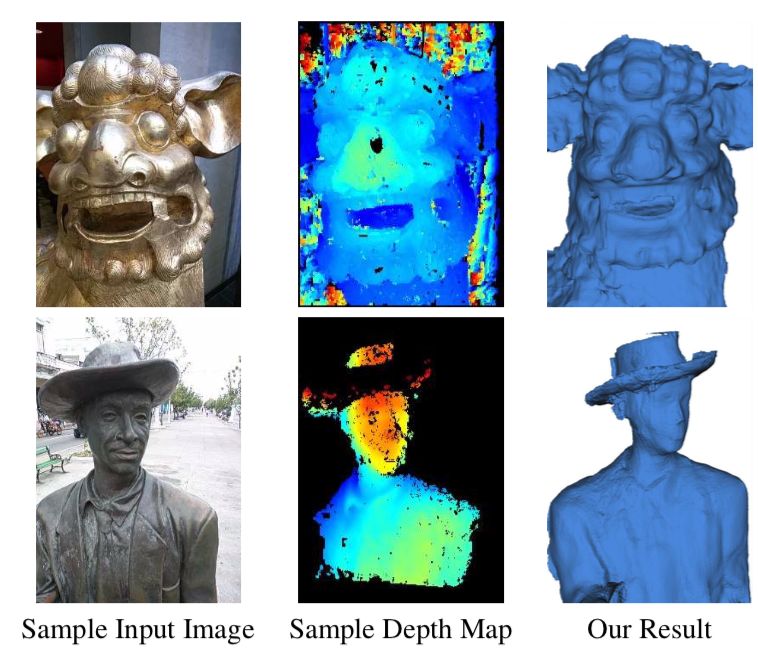

下图是该实验结果的一个示意图,原图是由手机拍摄的图片,包括非朗博光谱表面,尽管反射区域(雕像的帽子)的噪音水平高,点密度低,但我们的方法能够获得合理的结果。

Abstract

Surface reconstruction from a point cloud is a standard subproblem in many algorithms for dense 3D reconstruc- tion from RGB images or depth maps. Methods, performing only local operations in the vicinity of individual points, are very fast, but reconstructed models typically contain lots of holes. On the other hand, regularized volumetric ap- proaches, formulated as a global optimization, are typically too slow for real-time interactive applications.

We propose to use a regression forest based method, which predicts the projection of a grid point to the surface, depending on the spatial configuration of point density in the grid point neighborhood. We designed a suitable feature vector and efficient oct-tree based GPU evaluation, capable of predicting surface of high resolution 3D models in mil- liseconds. Our method learns and predicts surfaces from an observed point cloud sparser than the evaluation grid, and therefore effectively acts as a regularizer.

如果你对本文感兴趣,想要下载完整文章进行阅读,可以关注【泡泡机器人SLAM】公众号(paopaorobot_slam)。

欢迎来到泡泡论坛,这里有大牛为你解答关于SLAM的任何疑惑。

有想问的问题,或者想刷帖回答问题,泡泡论坛欢迎你!

泡泡网站:www.paopaorobot.org

泡泡论坛:http://paopaorobot.org/forums/

泡泡机器人SLAM的原创内容均由泡泡机器人的成员花费大量心血制作而成,希望大家珍惜我们的劳动成果,转载请务必注明出自【泡泡机器人SLAM】微信公众号,否则侵权必究!同时,我们也欢迎各位转载到自己的朋友圈,让更多的人能进入到SLAM这个领域中,让我们共同为推进中国的SLAM事业而努力!

商业合作及转载请联系liufuqiang_robot@hotmail.com