主题: TOPOLOGY OF DEEP NEURAL NETWORKS

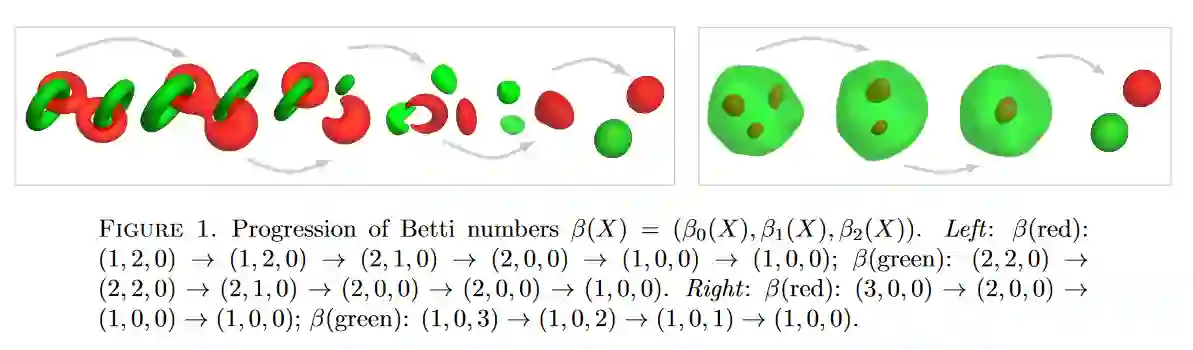

摘要: 我们研究数据集M=Ma∪Mb⊆Rd的拓扑结构如何表示二进制分类问题中的两个类别a和b,如何通过经过良好训练的神经网络的层而发生变化,即在训练集和接近零的泛化误差(≈0.01%)。目的是揭示深层神经网络的两个奥秘:(i)像ReLU这样的非平滑激活函数要优于像双曲正切这样的平滑函数; (ii)成功的神经网络架构依赖于多层结构,即使浅层网络可以很好地近似任意函数。我们对大量点云数据集的持久同源性进行了广泛的实验,无论是真实的还是模拟的。结果一致地证明了以下几点:(1)神经网络通过更改拓扑结构来运行,将拓扑复杂的数据集在穿过各层时转换为拓扑简单的数据集。无论M的拓扑多么复杂,当通过训练有素的神经网络f:Rd→Rp时,Ma和Mb的贝蒂数都会大大减少;实际上,它们几乎总是减小到可能的最低值:对于k≥1和β0(f(Mi))= 1,i = a,b,βk(f(Mi))= 0。此外,(2)ReLU激活的Betti数减少比双曲线切线激活快得多,因为前者定义了改变拓扑的非同胚映射,而后者定义了保留拓扑的同胚映射。最后,(3)浅层和深层网络以不同的方式转换数据集-浅层网络主要通过更改几何结构并仅在其最终层中更改拓扑来运行,而深层网络则将拓扑变化更均匀地分布在所有层中。

成为VIP会员查看完整内容

相关内容

专知会员服务

26+阅读 · 2020年3月26日

专知会员服务

54+阅读 · 2020年3月5日