题目: Graph Random Neural Networks

摘要:

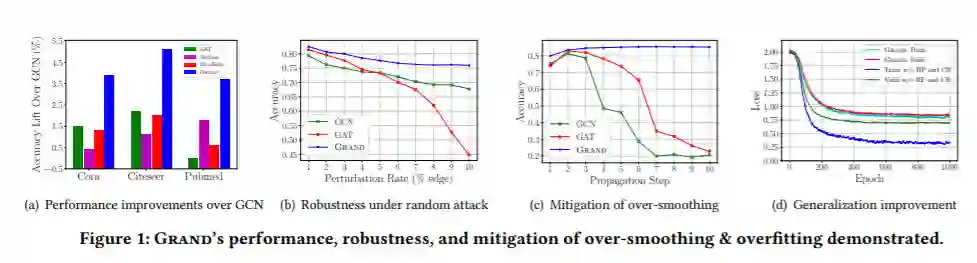

图神经网络(GNNs)将深度学习方法推广到图结构数据中,在图形挖掘任务中表现良好。然而,现有的GNN常常遇到具有标记节点的复杂图结构,并受到非鲁棒性、过度平滑和过拟合的限制。为了解决这些问题,本文提出了一个简单而有效的GNN框架——图随机神经网络(Grand)。与现有GNNs中的确定性传播不同,Grand采用随机传播策略来增强模型的鲁棒性。这种策略也很自然地使Grand能够将传播从特征转换中分离出来,减少了过度平滑和过度拟合的风险。此外,随机传播是图数据扩充的一种有效方法。在此基础上,利用无标记节点在多个扩展中的分布一致性,提高模型的泛化能力,提出了Grand的一致性正则化方法。在图形基准数据集上的大量实验表明,Grand在半监督的图形学习任务上显著优于最先进的GNN基线。最后,证明了它可以显著减轻过度平滑和过度拟合的问题,并且它的性能与鲁棒性相结合。

成为VIP会员查看完整内容

相关内容

专知会员服务

99+阅读 · 2020年7月3日

专知会员服务

108+阅读 · 2020年3月29日