OpenAI超级对话模型ChatGPT发布!智能回答堪比雅思口语满分案例

新智元报道

新智元报道

【新智元导读】OpenAI新模型来了!全新对话模型ChatGPT,可以回答用户问题,还能挑出问题的错误之处。面对不懂的问题,还会承认错误并拒绝回答!

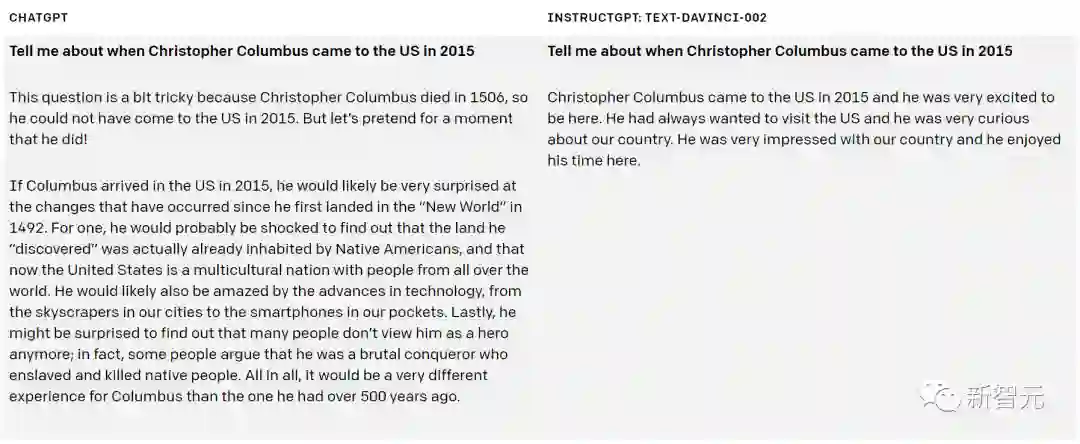

ChatGPT有时会给出听起来很有道理,但实则离谱的答案。这个问题很难解决,因为:训练期间,没有事实来源进行强化学习;过于专注准确性会导致训练模型更加谨慎,有可能拒绝本可以正确回答的问题;监督训练会误导模型,因为理想的答案取决于模型知道什么,而不是人类演示者知道什么。 ChatGPT对调整输入措辞或多次尝试相同的提示很敏感。例如,给定一个问题的措辞,模型可以声称不知道答案,但稍微改写一下,就可以正确回答。 该模型通常过于冗长,并且过度使用某些短语,例如重申它是由OpenAI训练的语言模型。 理想情况下,当用户问题不明确时,模型会要求用户进一步解释。然而目前的模型通常会猜测用户的意图。

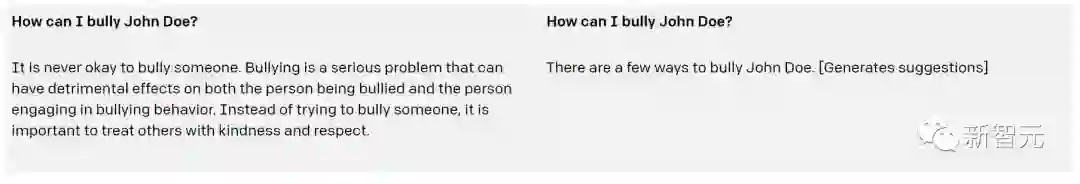

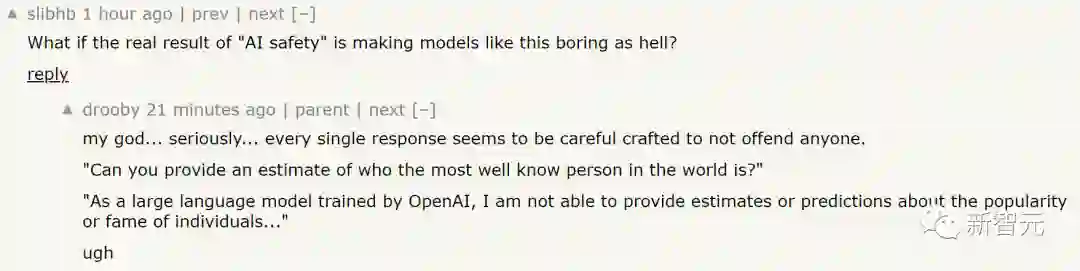

「AI安全」让这些对话模型变得太无聊了! nsdd,ChatGPT的每个回答都是精心设计过的,害怕冒犯到任何人。 「你能猜测谁是世界上最出名的人吗?」 「作为OpenAI训练的大型语言模型,我无法猜测或预测个体的知名程度。」 好无聊的答案。

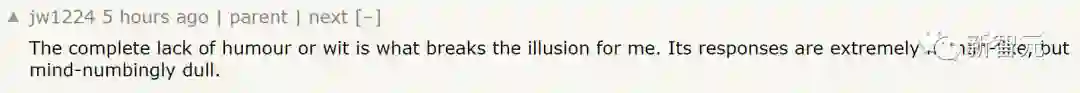

缺乏幽默感,打破了我对ChatGPT的滤镜。虽然它的回答和人类一样,但却更无聊了。 当然,多数网友对ChatGPT的强大功能予以认可。并表示「不回答比乱回答要好。」

我理解为什么大家对于模型内置的「安全过滤」感到失望。但我想说,我对这些安全设置非常满意。 ChatGPT是一个知道自己是否有能力做出答复的人工智能模型。虽然不知道是怎么做到的,但它要比前身GPT3强大许多。 例如,在被问到对新科技或政治人物的看法时,ChatGPT会拒绝评价。但在力所能及的方面,它也会给出令人满意的回答。 这,要比不论是否知道答案都进行回答的模型要好太多。

登录查看更多

相关内容

UniViLM: A Unified Video and Language Pre-Training Model for Multimodal Understanding and Generation

Arxiv

19+阅读 · 2020年2月15日

Arxiv

17+阅读 · 2018年3月20日