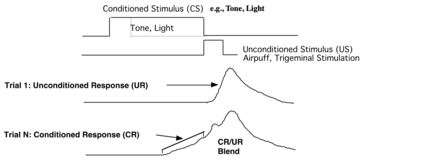

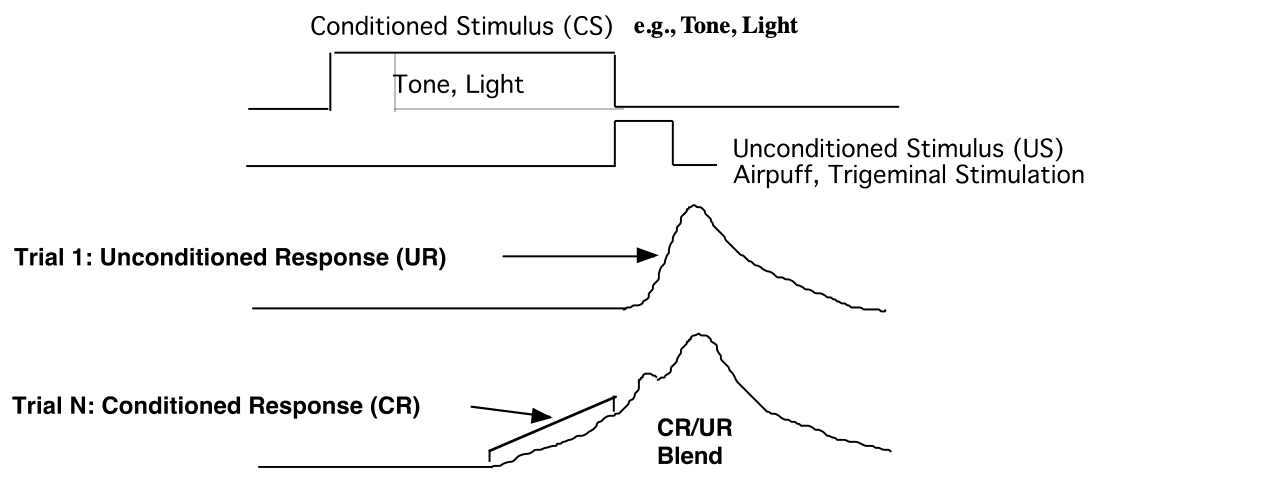

Experiments in classical conditioning show that animals such as rabbits, pigeons, and dogs can make long temporal associations that enable multi-step prediction. To replicate this remarkable ability, an agent must construct an internal state representation that summarizes its interaction history. Recurrent neural networks can automatically construct state and learn temporal associations. But the current training methods are prohibitively expensive for online prediction -- continual learning on every time step -- which is the focus of this paper. To facilitate research in online prediction, we present three new diagnostic prediction problems inspired by classical-conditioning experiments. The proposed problems test the learning capabilities that animals readily exhibit and highlight the current recurrent learning methods' limitations. While the proposed problems are nontrivial, they are still amenable to extensive testing and analysis in the small-compute regime, thereby enabling researchers to study issues in isolation carefully, ultimately accelerating progress towards scalable online representation learning methods.

翻译:古典机能实验显示,兔子、鸽子和狗等动物可以形成长期的关联,从而能够进行多步预测。为了复制这一非凡的能力,代理商必须构建一个能总结其互动历史的内部国家代表结构。经常性神经网络可以自动构建状态并学习时间联系。但当前的培训方法对于在线预测来说费用太高,无法承受,因为每个时间步骤都是本文的重点。为了便利在线预测的研究,我们提出了三个由古典机能实验启发的新的诊断预测问题。拟议的问题测试了动物随时展示的学习能力,突出了当前经常学习方法的局限性。拟议中的问题虽然不易处理,但仍然容易在小型构思的系统中进行广泛的测试和分析,从而使研究人员能够仔细研究孤立的问题,最终加快在可扩展的在线代言式学习方法方面的进展。