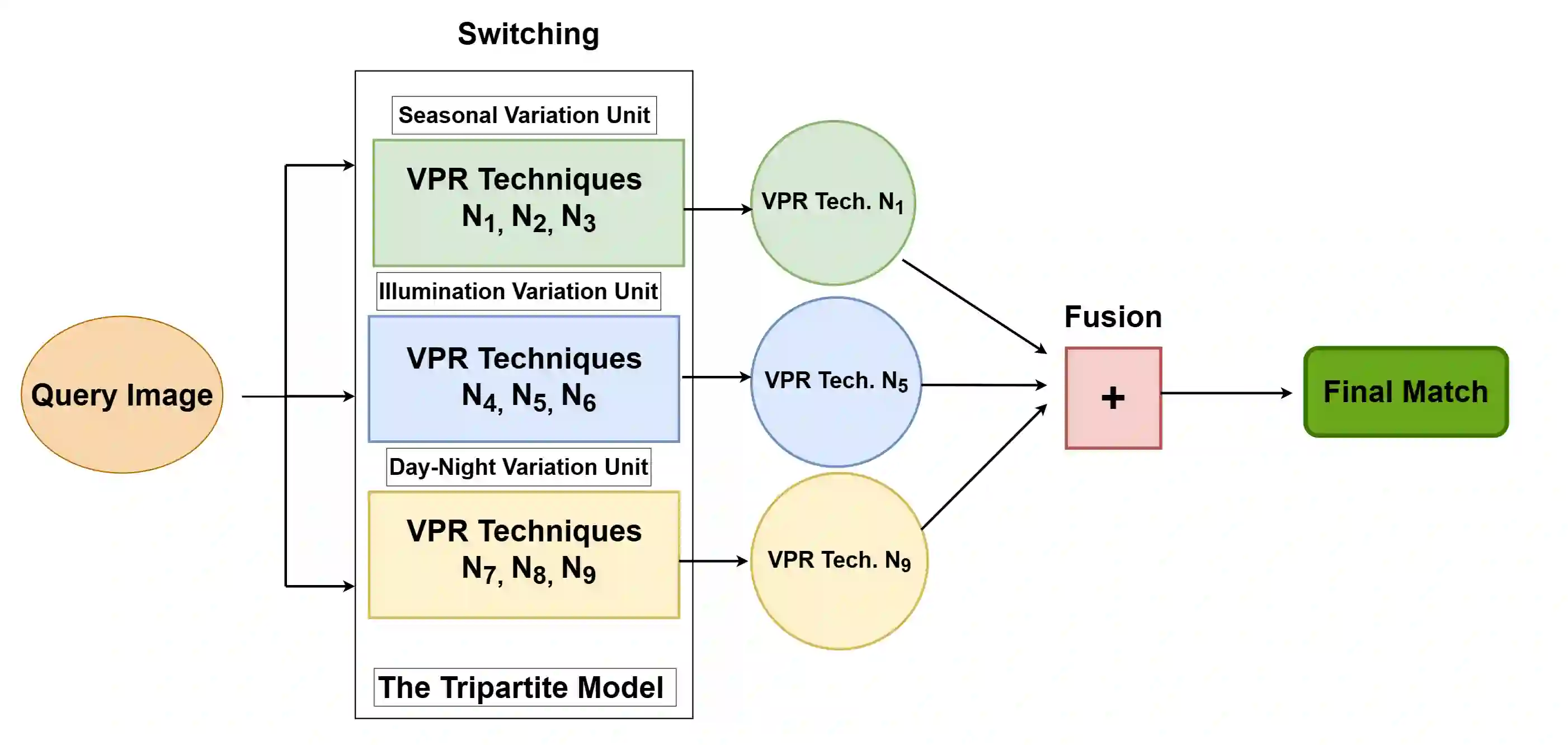

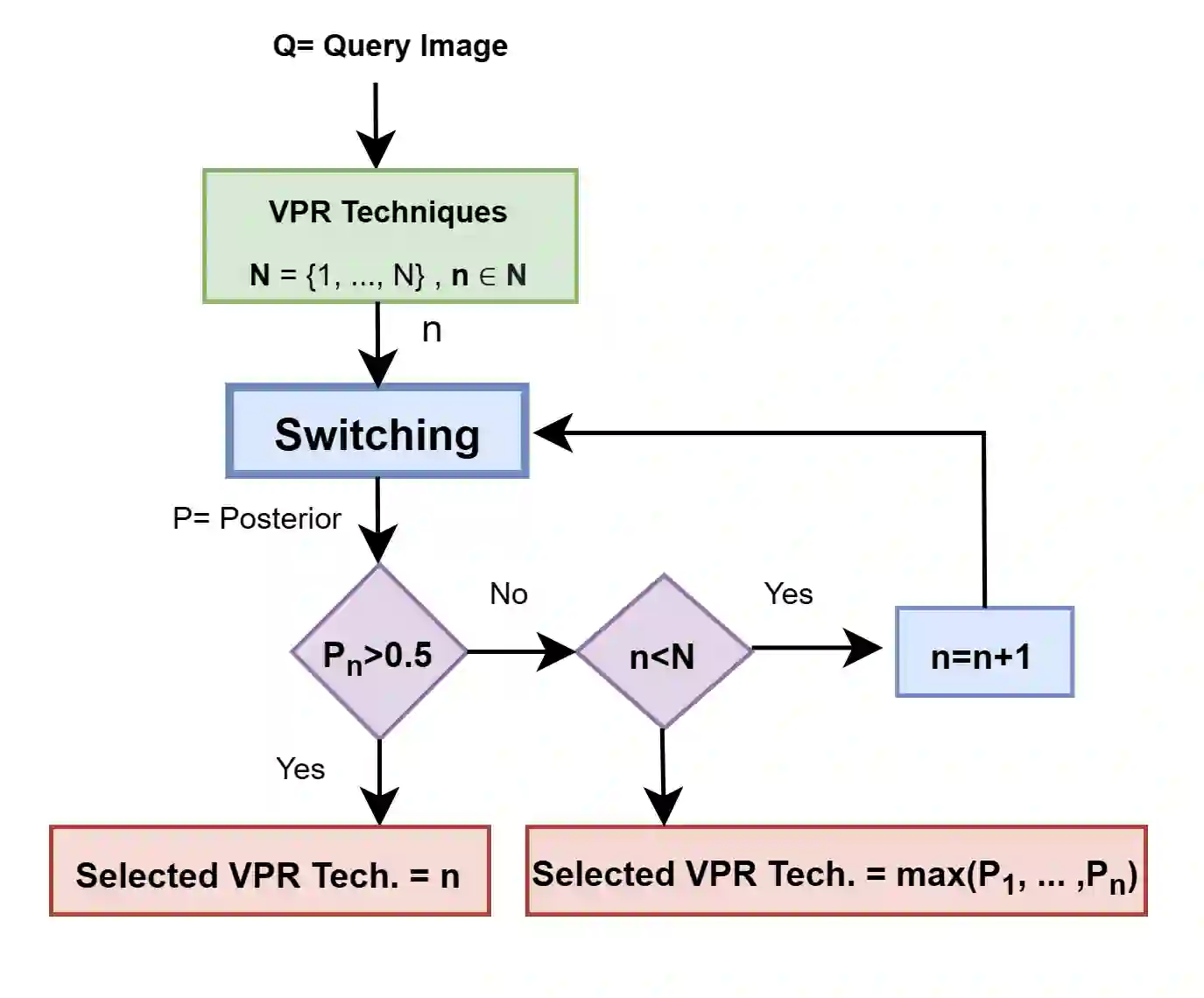

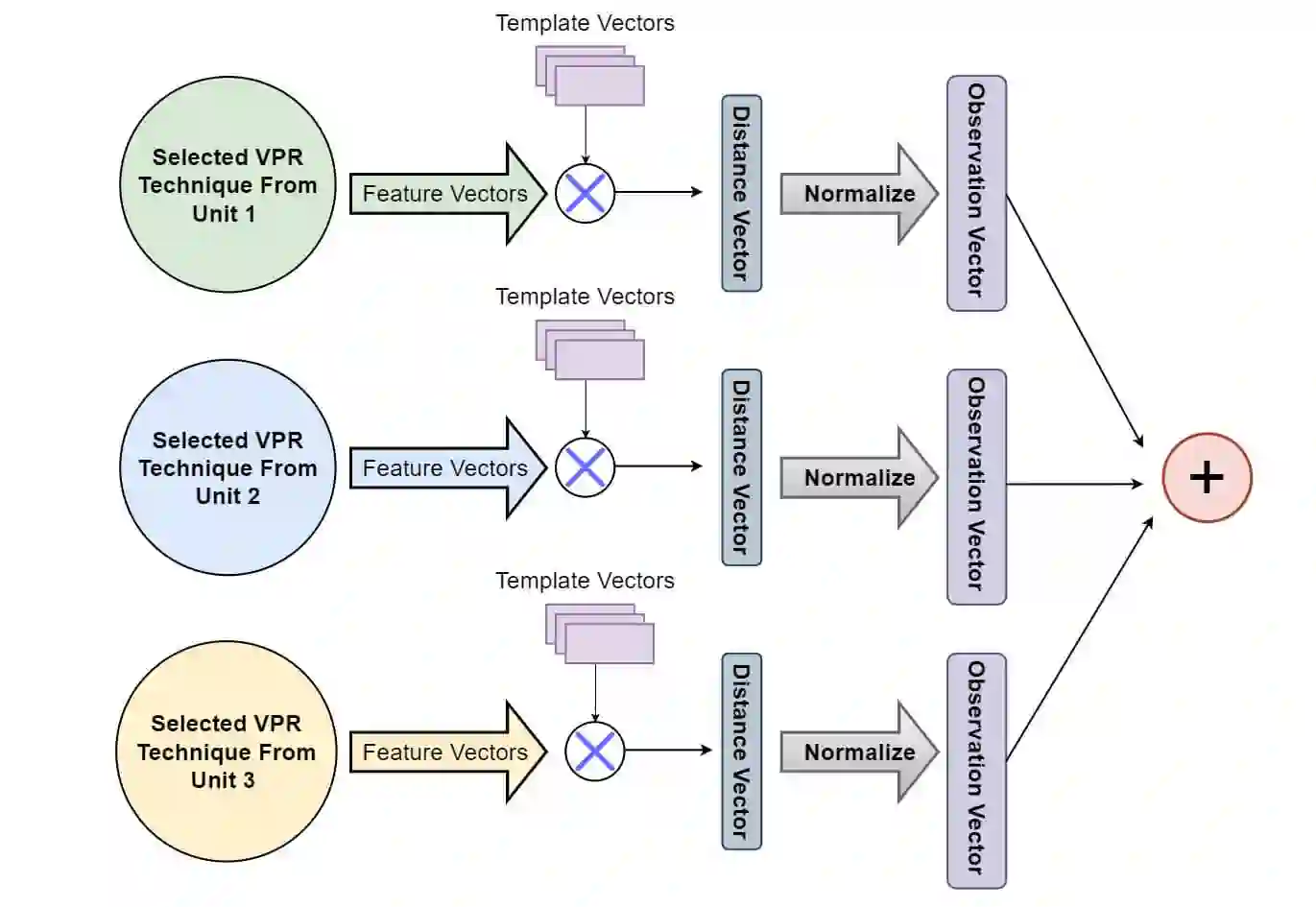

Recently several fusion and switching based approaches have been presented to solve the problem of Visual Place Recognition. In spite of these systems demonstrating significant boost in VPR performance they each have their own set of limitations. The multi-process fusion systems usually involve employing brute force and running all available VPR techniques simultaneously while the switching method attempts to negate this practise by only selecting the best suited VPR technique for given query image. But switching does fail at times when no available suitable technique can be identified. An innovative solution would be an amalgamation of the two otherwise discrete approaches to combine their competitive advantages while negating their shortcomings. The proposed, Switch-Fuse system, is an interesting way to combine both the robustness of switching VPR techniques based on complementarity and the force of fusing the carefully selected techniques to significantly improve performance. Our system holds a structure superior to the basic fusion methods as instead of simply fusing all or any random techniques, it is structured to first select the best possible VPR techniques for fusion, according to the query image. The system combines two significant processes, switching and fusing VPR techniques, which together as a hybrid model substantially improve performance on all major VPR data sets illustrated using PR curves.

翻译:最近,为解决视觉定位识别问题,提出了若干基于融合和切换的方法。尽管这些系统显示了VPR性能的显著提升,但它们都有各自的限制。多过程组合系统通常涉及同时使用粗力和运行所有可用的VPR技术,而转换方法试图通过只选择最适合的VPR技术来否定这种做法,只为给定的查询图像选择最适合的VPR技术。但在无法找到合适的技术时,转换确实失败了。创新的解决方案是合并两种其他的分散方法,以合并其竞争优势,同时消除其缺陷。提议的Switch-Fuse系统是一个有趣的方法,可以结合基于互补性的VPR技术转换的稳健性和同时使用精心选择的技术来大幅改进性能的力量。我们的系统有一个结构优于基本融合方法,而不是简单地使用所有或任何随机技术,而是根据查询图像,首先选择可能最佳的VPR技术进行融合。这个系统结合了两个重要的程序,转换和调用VPR技术,作为一个混合模型,大大地改进了所有主要VPR曲线的运行情况。</s>