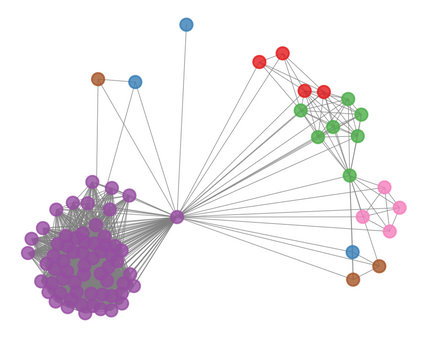

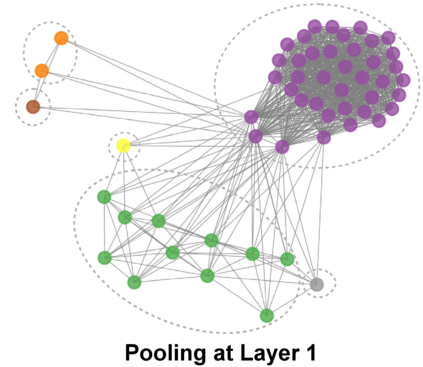

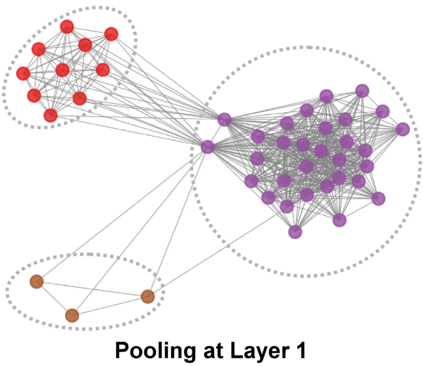

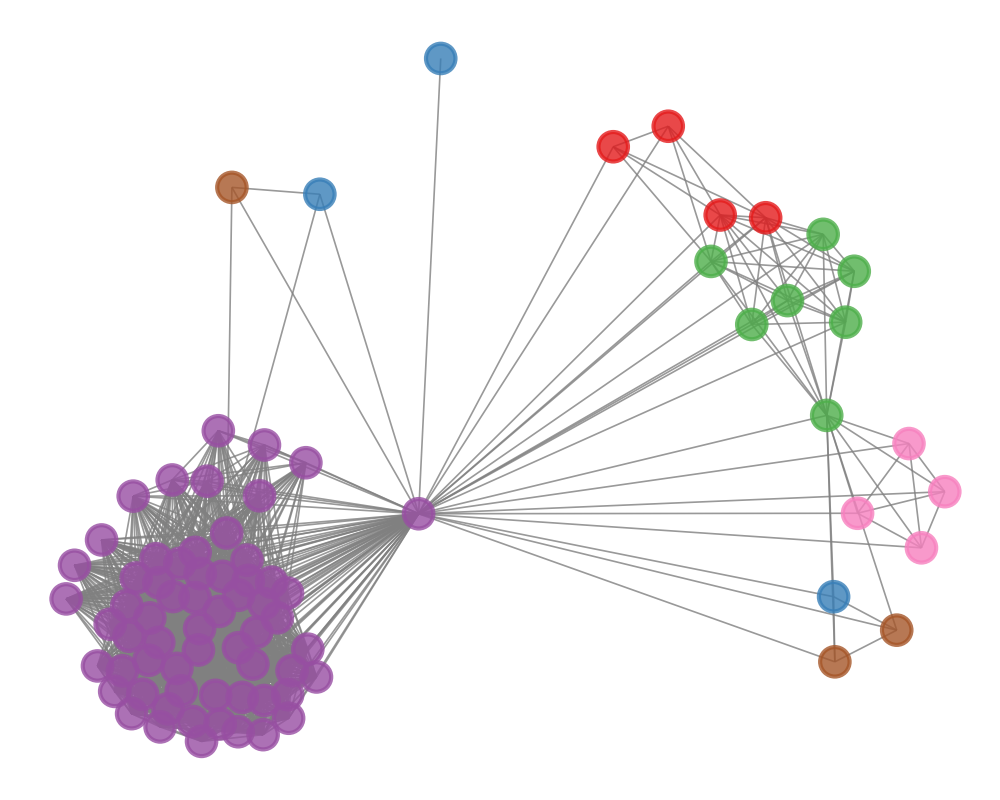

Recently, graph neural networks (GNNs) have revolutionized the field of graph representation learning through effectively learned node embeddings, and achieved state-of-the-art results in tasks such as node classification and link prediction. However, current GNN methods are inherently flat and do not learn hierarchical representations of graphs---a limitation that is especially problematic for the task of graph classification, where the goal is to predict the label associated with an entire graph. Here we propose DiffPool, a differentiable graph pooling module that can generate hierarchical representations of graphs and can be combined with various graph neural network architectures in an end-to-end fashion. DiffPool learns a differentiable soft cluster assignment for nodes at each layer of a deep GNN, mapping nodes to a set of clusters, which then form the coarsened input for the next GNN layer. Our experimental results show that combining existing GNN methods with DiffPool yields an average improvement of 5-10% accuracy on graph classification benchmarks, compared to all existing pooling approaches, achieving a new state-of-the-art on four out of five benchmark data sets.

翻译:最近,图形神经网络(GNNs)通过有效学习节点嵌入器,使图表显示学习领域发生了革命性的变化,并在节点分类和链接预测等任务中取得了最新成果。然而,目前的GNN方法本质上是平坦的,不学习图形-限制的等级表示方式,这对于图形分类任务尤其有问题,因为图表分类的目的是预测与整个图有关的标签。在这里,我们提出了DiffPool,这是一个可不同图形集合模块,可以生成图表的等级表示器,并且可以与各种图表神经网络结构以端到端的方式相结合。Diffpool学习了深度GNN的每个层的可不同可变软集群分配方式,为一组组合绘制节点图,然后为下一个GNNN层形成粗化的投入。我们的实验结果表明,将现有的GNN方法与DiffPool相结合,与现有的所有组合方法相比,在图表分类基准上平均提高了5-10%的精确度,从而在五个基准数据集的四层实现新的状态。