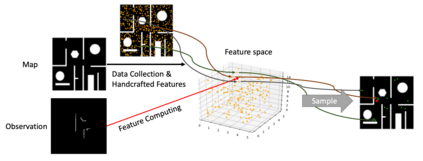

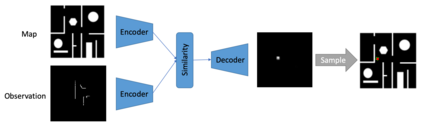

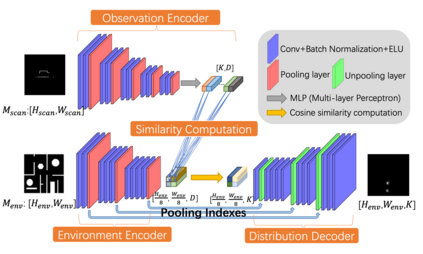

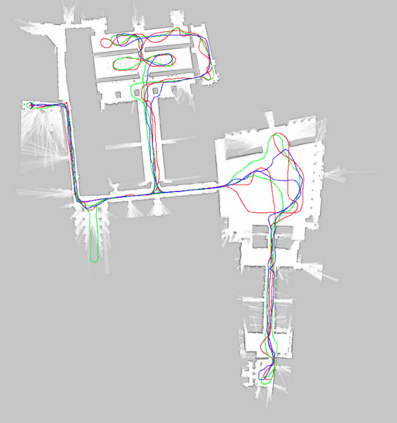

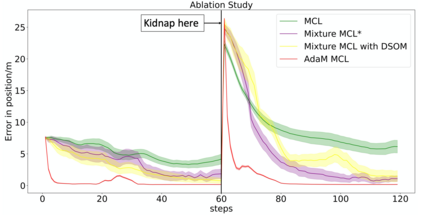

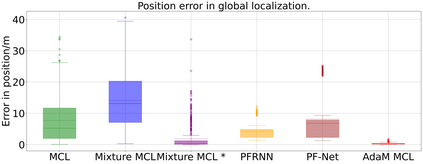

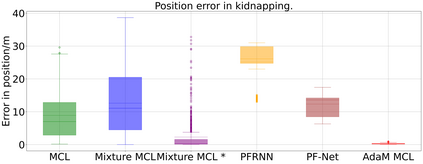

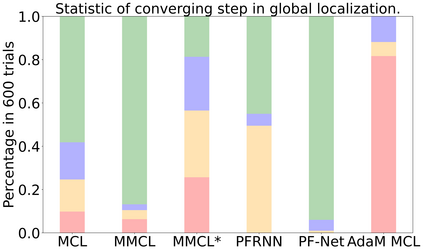

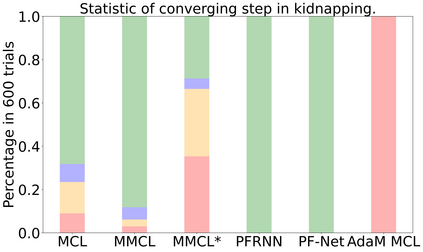

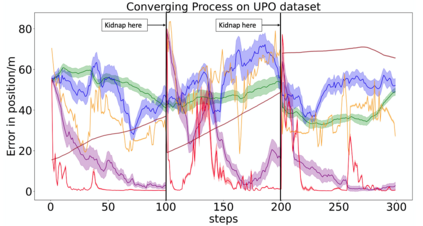

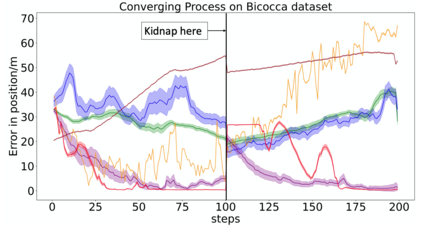

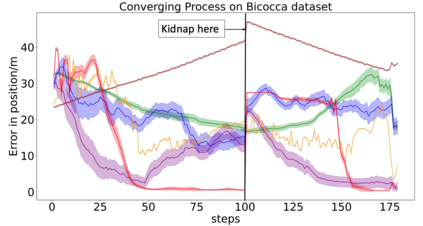

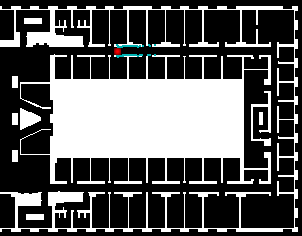

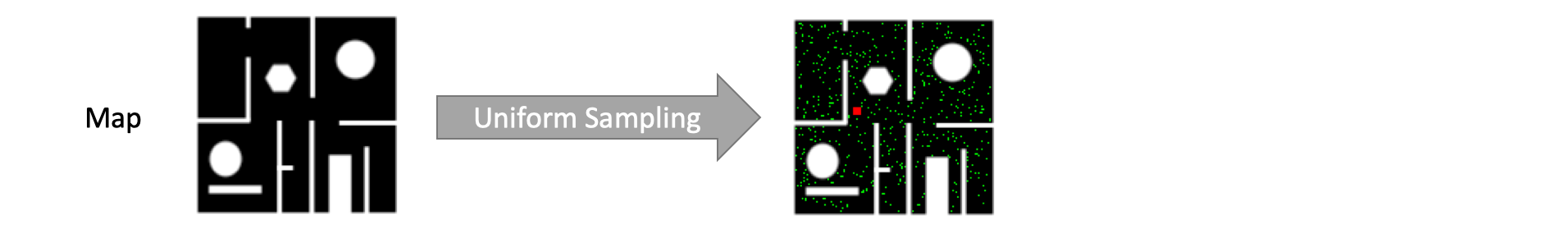

Global localization and kidnapping are two challenging problems in robot localization. The popular method, Monte Carlo Localization (MCL) addresses the problem by iteratively updating a set of particles with a "sampling-weighting" loop. Sampling is decisive to the performance of MCL [1]. However, traditional MCL can only sample from a uniform distribution over the state space. Although variants of MCL propose different sampling models, they fail to provide an accurate distribution or generalize across scenes. To better deal with these problems, we present a distribution proposal model, named Deep Samplable Observation Model (DSOM). DSOM takes a map and a 2D laser scan as inputs and outputs a conditional multimodal probability distribution of the pose, making the samples more focusing on the regions with higher likelihood. With such samples, the convergence is expected to be more effective and efficient. Considering that the learning-based sampling model may fail to capture the true pose sometimes, we furthermore propose the Adaptive Mixture MCL (AdaM MCL), which deploys a trusty mechanism to adaptively select updating mode for each particle to tolerate this situation. Equipped with DSOM, AdaM MCL can achieve more accurate estimation, faster convergence and better scalability compared to previous methods in both synthetic and real scenes. Even in real environments with long-term changing, AdaM MCL is able to localize the robot using DSOM trained only by simulation observations from a SLAM map or a blueprint map.

翻译:全球本地化和绑架是机器人本地化的两个具有挑战性的问题。流行的方法,蒙特卡洛本地化(MMCL)通过反复更新一组带有“抽样加权”环状的粒子来解决这一问题。抽样对MCL[1]的性能具有决定性作用。然而,传统的MCL只能从州空间的统一分布中进行抽样。虽然MCL的变量建议不同的采样模型,但是它们无法提供准确的分布或概括各种场景。为了更好地处理这些问题,我们提出了一个分发建议模型,名为深抽样观察模型(DSOM)。DSOM用地图和2D激光扫描作为图和2D激光的输入和输出,作为一种有条件的模件的多式联运概率分布,使样品更侧重于高的可能性区域[1]。然而,传统的MCLCL只能从州空间的统一分布上进行抽样分析,但考虑到基于学习的采样模型可能有时无法捕捉到真实的图像,我们进一步提议采用适应性混合式MCLL(AdaM MCL),它只能为每个粒子的适应性选择更新模式以容忍这一局面。DSMM(DS)和MLM(M)在现实环境上进行更精确化的观察、ADM)进行更快速化、更精确化、更精确化、更精确化、更精确化、更精确化、更精确化的MDMMM),在比对地、更精确化、更精确化MMADMADM、更精确化、更精确化、更精确化、更精确化、更精确化、更精确化、更精确化、更精确化、更精确化、更精确化、更精确化、更精确化、更精确化、更精确化、更精确的MMMM、更精确化、更精确化、更精确化、更精确化、更精确化、更精确化、更精确化、更精确化、更精确化、更精确化和MMM、更精确化、更精确化、更精确化、更精确化、更精确化、更精确化、更精确化、更精确化、更精确化、更精确化、更精确化MMMMMMMADLMMMMMA、更精确化、更精确化、更精确化、更精确化、更精确