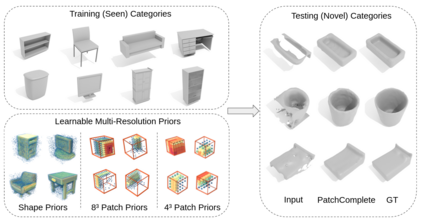

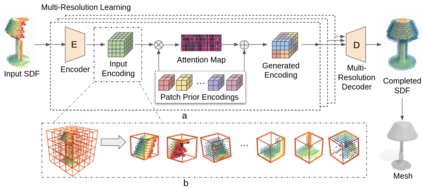

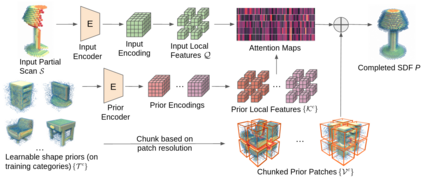

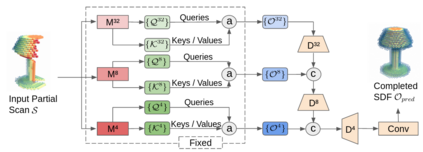

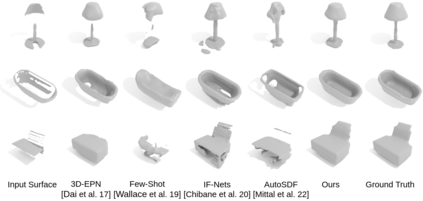

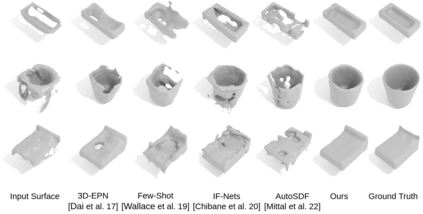

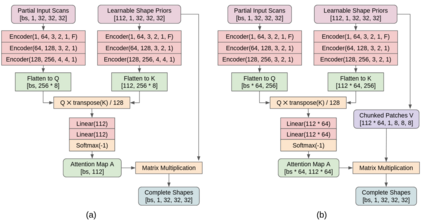

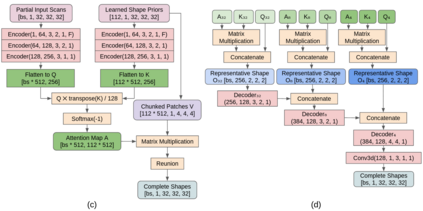

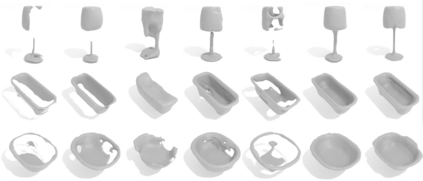

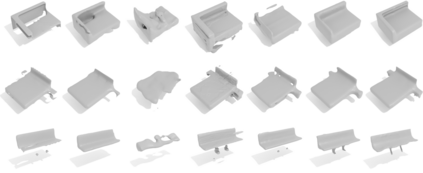

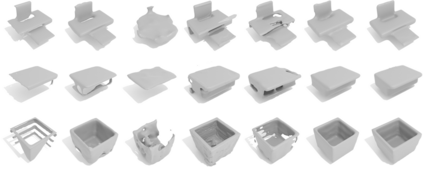

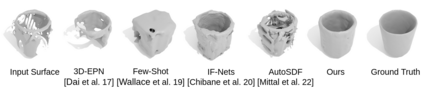

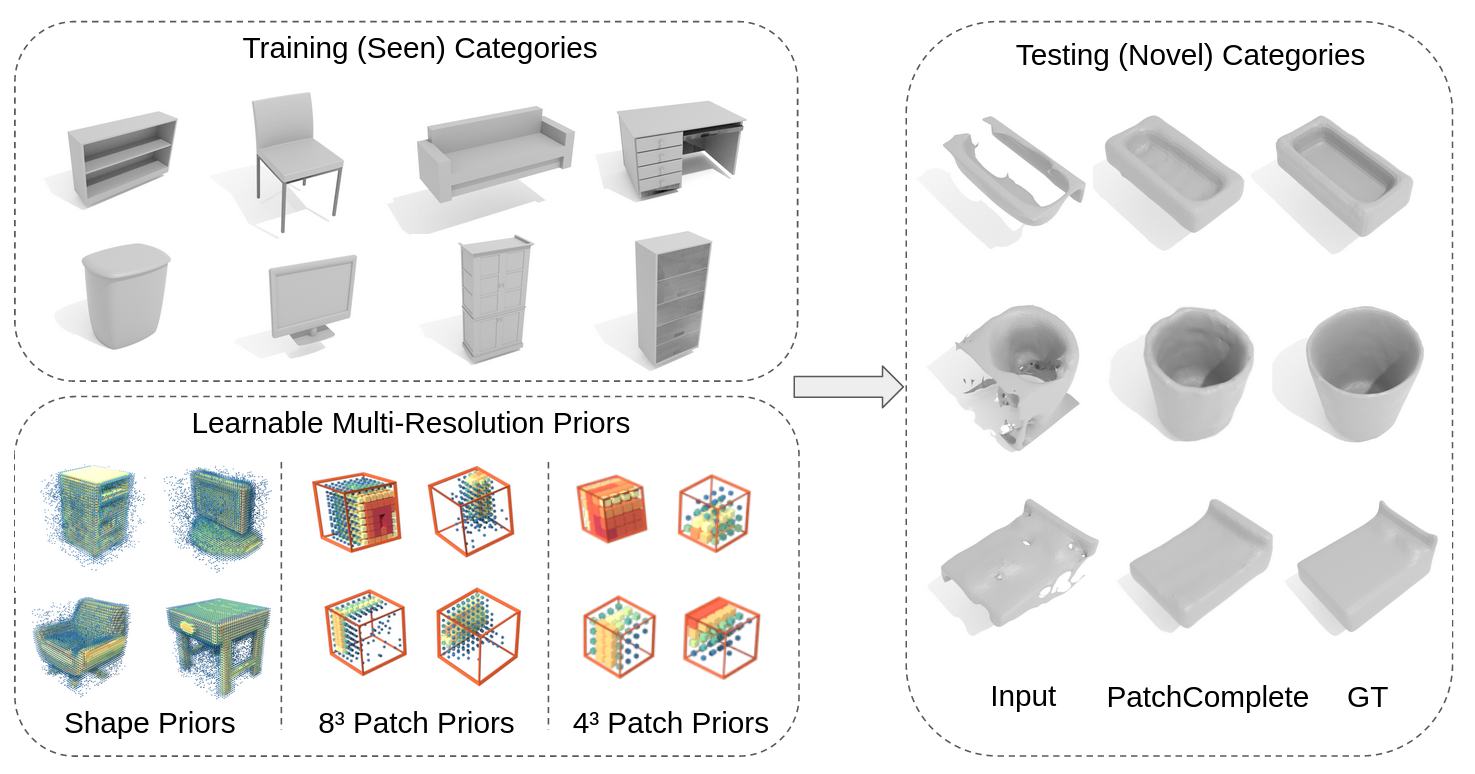

While 3D shape representations enable powerful reasoning in many visual and perception applications, learning 3D shape priors tends to be constrained to the specific categories trained on, leading to an inefficient learning process, particularly for general applications with unseen categories. Thus, we propose PatchComplete, which learns effective shape priors based on multi-resolution local patches, which are often more general than full shapes (e.g., chairs and tables often both share legs) and thus enable geometric reasoning about unseen class categories. To learn these shared substructures, we learn multi-resolution patch priors across all train categories, which are then associated to input partial shape observations by attention across the patch priors, and finally decoded into a complete shape reconstruction. Such patch-based priors avoid overfitting to specific train categories and enable reconstruction on entirely unseen categories at test time. We demonstrate the effectiveness of our approach on synthetic ShapeNet data as well as challenging real-scanned objects from ScanNet, which include noise and clutter, improving over state of the art in novel-category shape completion by 19.3% in chamfer distance on ShapeNet, and 9.0% for ScanNet.

翻译:虽然 3D 形状表示法能够在许多视觉和感知应用中进行强有力的推理, 学习 3D 形状前置物往往会限制在特定的培训类别中, 导致学习过程效率低下, 特别是对于普通的隐形类别。 因此, 我们建议 Patch Cuplete, 学习基于多分辨率本地补丁的有效形状前置物, 这些补丁通常比全形状( 例如, 椅子和桌子通常都双腿) 更加普通, 从而可以对不可见类进行几何推理。 为了了解这些共享的子结构, 我们学习了所有列车类别的多分辨率补丁前置物, 这些前置物随后与将部分形状观察输入到补丁之前的补丁, 并最终解码成完整的形状重建。 这些基于补丁的前置物避免了对特定列物分类的过度适应, 并且能够在测试时重建完全看不见的类别。 我们展示了我们在合成的 ShapeNet 数据上的方法的有效性, 以及 ScarmeNet 中挑战的真扫描对象,, 包括噪音和结, 、 改进艺术在新型类形状上的状态, 在 Shapeer Net 的距离上的19. 3% 和 9.0 扫描 。