梯度下降(Gradient Descent)的收敛性分析

©作者 | 黄秋实

单位 | 香港中文大学(深圳)

研究方向 | 智能电网

-

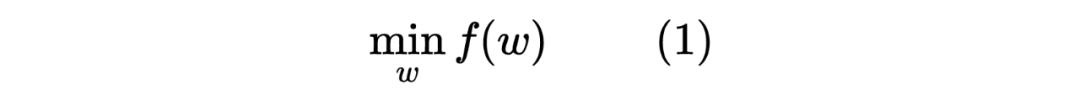

随机初始化优化变量 -

重复如下步骤直至收敛: ,其中 为优化步长

Lipschitz 连续性

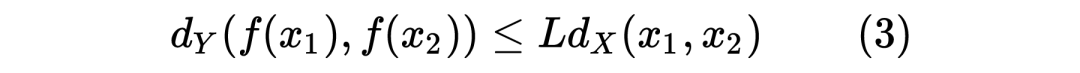

给定两个度量空间 和 , 是集合 X 上的测度, 是集合 Y 上的测度。一个从集合 X 到集合 Y 函数 满足 Lipschitz 连续,则存在一个常数 对于集合 X 中任意两点 和 有:

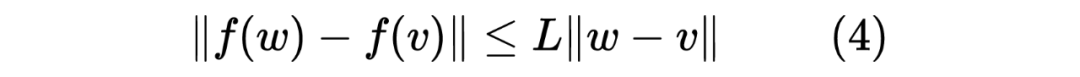

因此对于函数 ,若其满足 Lipschitz 连续,则对于任意两点 w 和 v,都满足:

一个函数 f(x) 满足 Lipschitz 连续,可以理解为该函数的变化速率受到了限制。这个变化速率的上界就被称为 Lipschitz 常数。函数梯度的 Lipschitz 连续性在实际情况中相对容易得到满足,因为真实世界中的数据的变化幅度并不大。这也是很多其他数据处理方法物理释义,例如应用数据低秩性与稀疏性的 Robust PCA 等用压缩感知方法。对于常用的机器学习模型,例如逻辑回归,SVM等方法,大多可以证明其损失函数的梯度在一定条件下满足 Lipschitz 连续性。但是对于深度学习模型,我们无法证明。

下降引理 (Descent Lemma)

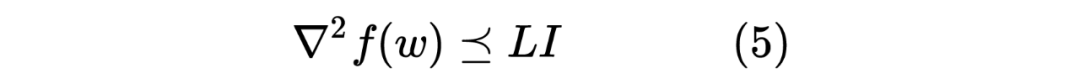

对于一个二阶可导的函数 ,它的导数 满足 Lipschitz 连续,则它的 Hessian 矩阵满足:

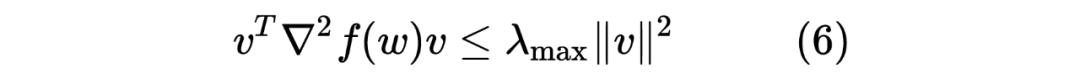

我们可以从这个角度来理解式(5):首先,我们知道导数 变化最快的方向就是它的 Hessian 矩阵 绝对值最大特征值所对应的特征向量。由于 Hessian 矩阵 是对称矩阵(symmetric matrix),于是根据 Rayleigh quotient,我们就可以得到,对于任意 v 都满足:

因此,对于导数 满足 Lipschitz 连续的函数 ,它任意点 w 的 Hessian 矩阵 都满足 ,即式(5)。

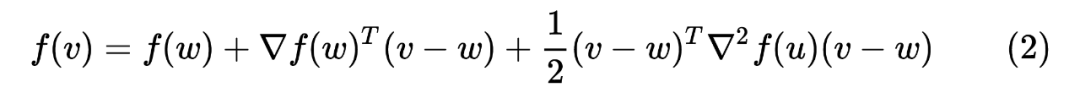

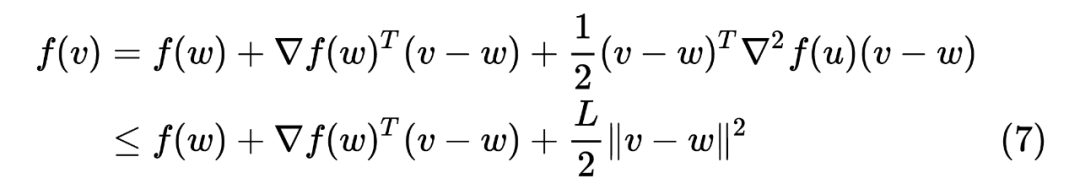

当我们对这样满足二阶可导,且导数 满足 Lipschitz 连续的函数 进行泰勒展开时,我们可以得到

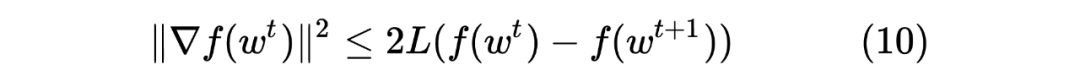

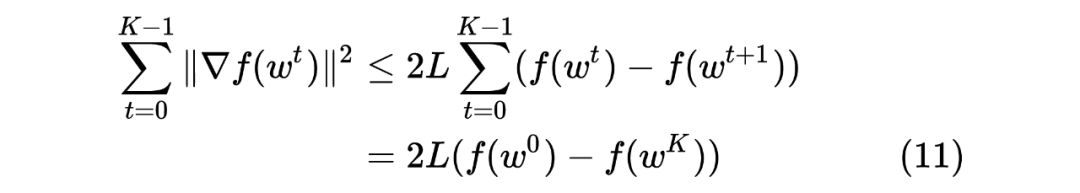

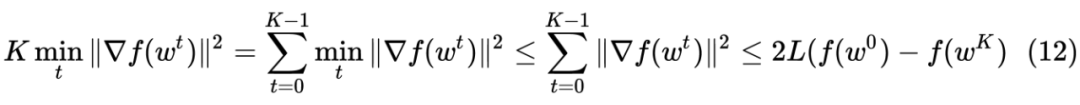

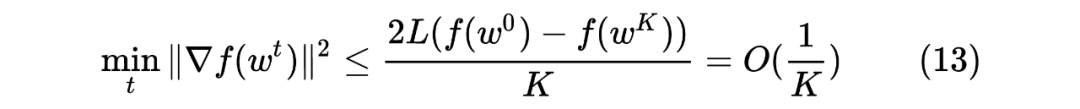

梯度下降的收敛性与收敛速度

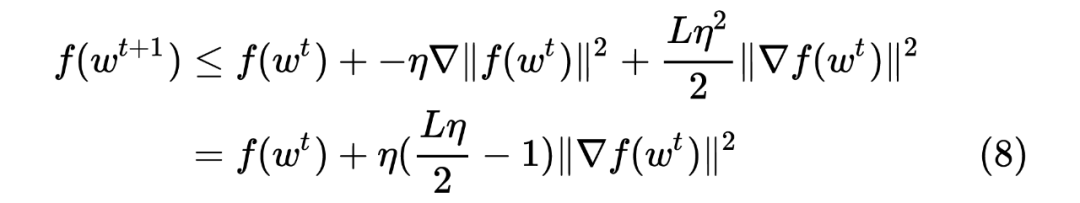

在上面的论述中,我们已经回答了梯度下降算法为什么可以优化目标函数,让每一步优化得到的结果的目标函数的函数值更小。同时我们也给出了如何选择优化步长的指标。现在我们就来回答,为什么梯度下降的优化算法可以收敛?它的收敛速度又是多少?

梯度下降算法收敛性的证明依赖于如下三个条件:

-

目标函数的梯度 满足 Lipschitz 连续 -

目标函数 ,即目标函数有一个下界 -

优化步长

我们注意到我们平时常用的损失函数,例如交叉熵,均方误差等,在一定的范围内(部分损失函数会依赖于一个好的初始值的选择)都可以满足以上三个条件。

参考文献

更多阅读

#投 稿 通 道#

让你的文字被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧