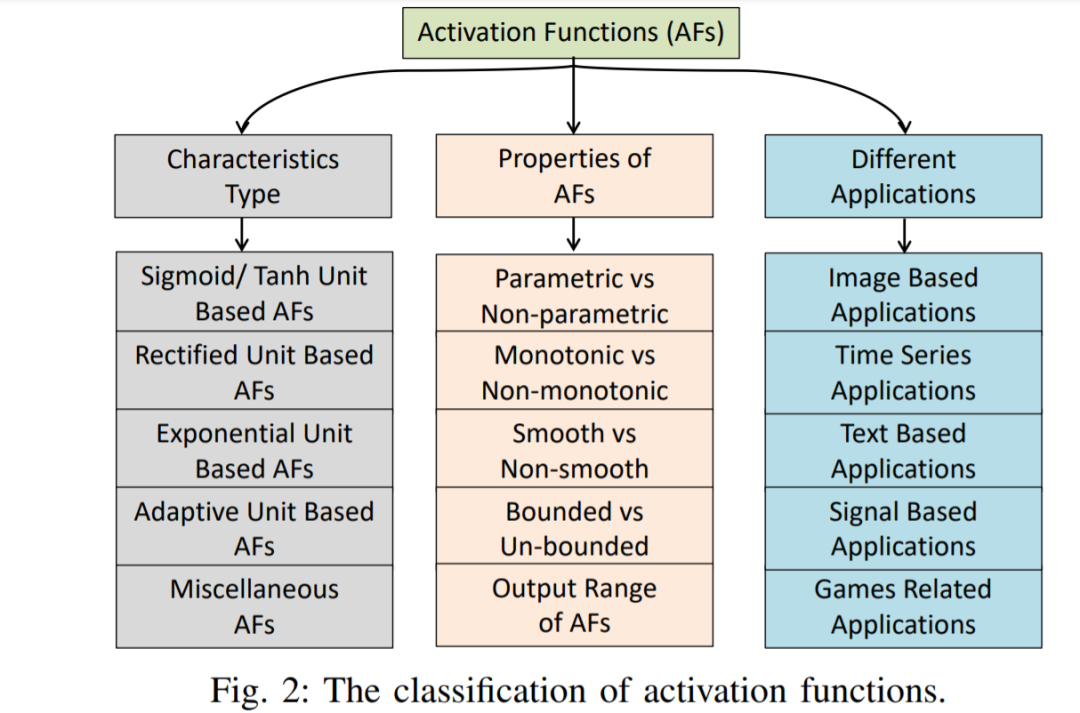

近年来,神经网络在解决许多问题方面有了巨大的发展。不同类型的神经网络被引入来处理不同类型的问题。然而,任何神经网络的主要目标是将非线性可分的输入数据转换为更线性可分的抽象特征,使用层次结构。这些层是线性和非线性函数的组合。最流行和常见的非线性层是激活函数(AFs),如Logistic Sigmoid、Tanh、ReLU、ELU、Swish和Mish。本文对深度学习神经网络中的激活函数AFs进行了全面的综述和研究。不同类别的AFs,如Logistic Sigmoid和基于Tanh,基于ReLU,基于ELU,和基于Learning。指出了AFs的输出范围、单调性和平滑性等特点。并对18种最先进的AFs在不同网络上的性能进行了比较。本文提出了AFs的见解,以帮助研究者进行进一步的研究,并帮助实践者在不同的选择中进行选择。用于实验比较的代码。

近年来,深度学习在解决人脸分析[2][113]、预测评级[74]、情感分析[143]、[152]、高光谱图像分析[144]、图像合成和语义处理[1]、数字图像增强[72]、图像检索[33]等具有挑战性的问题方面取得了巨大的增长。深度学习中已经发展了各种类型的神经网络来从数据中学习抽象特征,如多层感知器(Multilayer Perceptron, MLP)[30],卷积神经网络(CNN)[82],[73],循环神经网络(RNN)[54],生成对抗网络(Generative Adversarial networks, GAN)[12]。神经网络的重要方面包括权值初始化[104]、损失函数[130]、正则化[102]、过拟合控制[18]、激活函数[136]和优化[35]。

激活函数在神经网络[36]中起着非常重要的作用,它通过非线性变换学习抽象的特征。AFs的一些共同性质如下: A)在优化中增加非线性曲率以提高网络的训练收敛性; B)它不应该广泛地增加模型的计算复杂性; C)不妨碍训练过程中的梯度流动;d)它应该保留数据的分布,以便更好地训练网络。近年来,为了实现上述特性,人们已经探索了几种用于深度学习的AFs。本综述致力于神经网络中AFs领域的发展。不同AFs的见解和推理被提出,以使深度学习社区受益。这项综述的主要贡献概述如下:

-

本综述为广泛的AFs提供了详细的分类。它还非常全面地包括了AFs,包括Logistic Sigmoid/Tanh, Rectified Unit, Exponential Unit, 和Adaptive AFs。

-

本综述从不同角度对AFs进行分析,为读者提供最新的AFs。它特别涵盖了用于深度学习的AFs的进展。

-

本综述还通过简要的重点和重要的讨论总结了AFs,以描述其对不同类型数据的适用性(参见表VI)。

-

将本次综述与现有综述/分析进行比较,显示其重要性(见表七)。

-

本文还介绍了使用18种最先进的AFs和不同类型网络在4个不同模式的基准数据集上的性能比较(参见表VIII, IX和XI)。