【泡泡一分钟】机器人顶级会议精华提炼(20190506-20190512)

每天一分钟,带你读遍机器人顶级会议文章

来源:计算机视觉和机器人顶级会议

播音员:水蘸墨,赵嘉珩

汇总:张宁

编译:泡泡一分钟全体组员

欢迎个人转发朋友圈;其他机构或自媒体如需转载,后台留言申请授权

摘要

2019年5月6日至2019年5月12日,泡泡一分钟共推送了10篇文章,其内容涉及到运动规划(2篇)、姿态估计(3篇)、地图构建(1篇)、物体交互(2篇)、深度估计(1篇)和自动驾驶(1篇)等。

运动规划

运动规划本周共推送2篇文章。

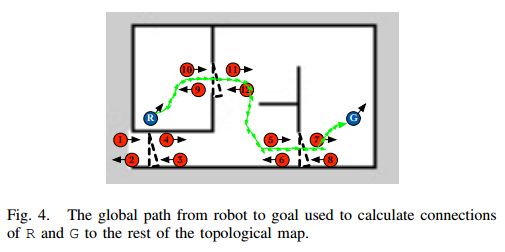

第一篇文章提出了一种基于人工智能(AI)规划的拓扑导航系统。 从环境的符号表示开始,导航任务分为若干阶段,其中每个阶段需要不同的动作。该方法对于在室内环境中规划机器人的操作非常有效。

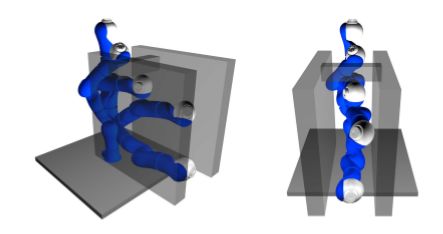

第二篇文章提出了一种桌面式的场景,其中七个自由度的KUKA LWR机器人手臂必须在环境中存在多个物体的情况下从初始姿势移动到目标姿势。我们表明,BKPIECE(AUC-Bandit)和RRT-Connect(随机森林)的最佳方法分别平均提高了4.5x和1.26x的性能。

姿态估计

姿态估计方面本周共推送3篇文章。

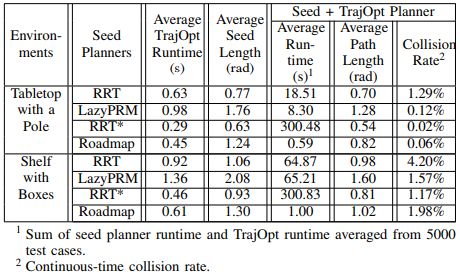

第一篇文章对几个有代表性的基于采样和基于优化的运动规划器进行了评估,然后我们引入了一个集成的运动规划系统,该系统将轨迹优化的最新进展纳入稀疏路线图框架。

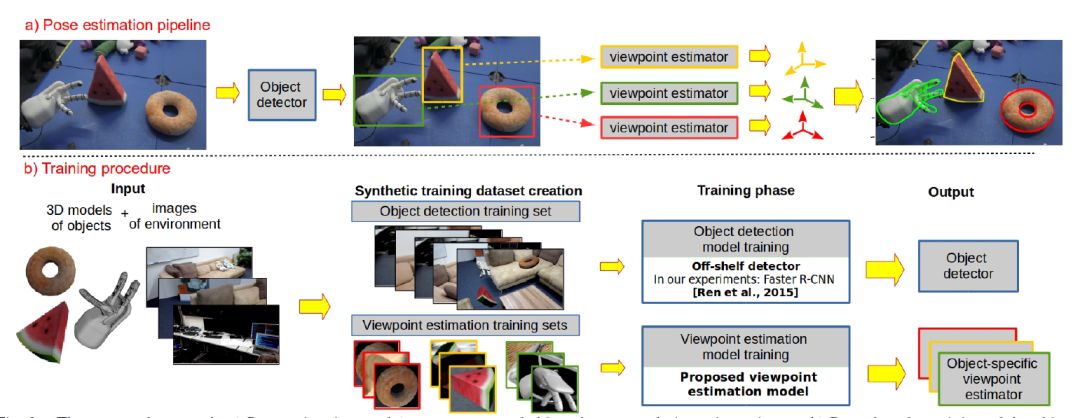

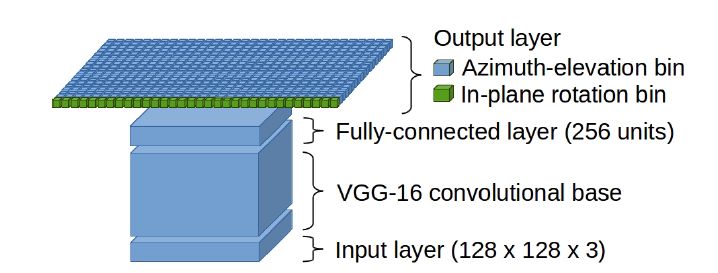

第二篇,提出了一种新型的结合CNN的鲁棒性和基于精细分辨率的3D位姿估计方法,该模型在由物体的3D模型自动生成的全标记的合成训练数据上进行训练。

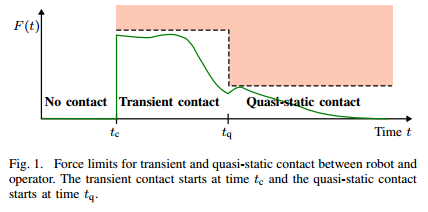

第三篇本文提出了一种数值计算方法,能够使协同机器人在满足ISO/TS 15066安全要求的前提下,以最高速度在规划路径上运动。

地图构建

地图构建本周介绍了1篇文章。

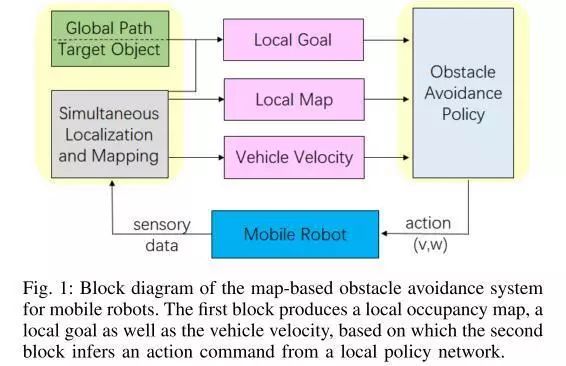

第一篇文章提出一种深度模仿学习算法,该算法基于以自我为中心的局部占用图来开发一种计算上有效的避障策略。

物体交互

物体交互本周介绍了2篇文章。

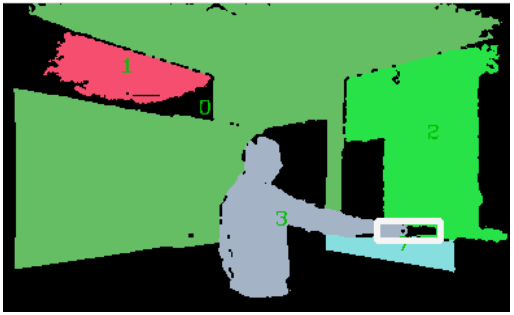

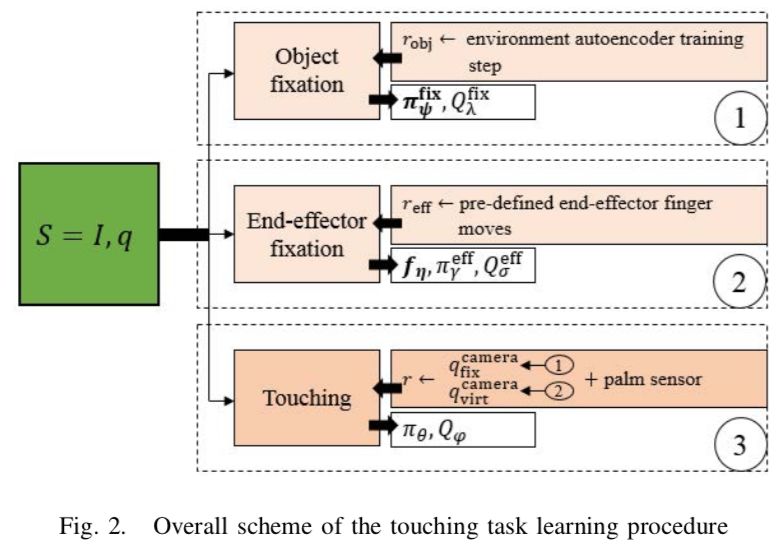

第一篇文章作者提出了一种方法通过弱监督和分级学习简化任务来学习手掌触碰物体的任务。

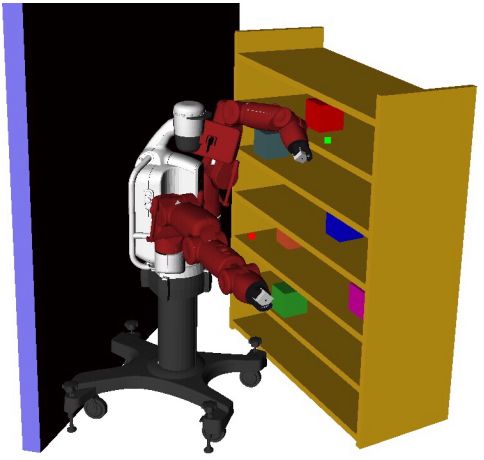

第二篇文章为了避免雇佣人工来手动标注更多的数据来支持机器人感知识别新的物体,作者提出了一种不需要手动标注的交互训练过程。

不使用ImageNet的物体识别交互训练

深度估计

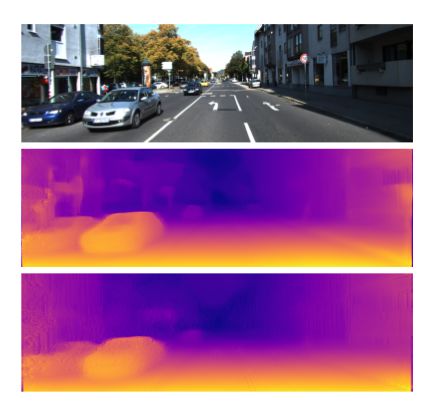

在本文中,提出了一种新颖的架构,能够使用从单个输入图像中提取的特征金字塔,在CPU甚至是嵌入式系统上快速推断出精确的深度图。

自动驾驶

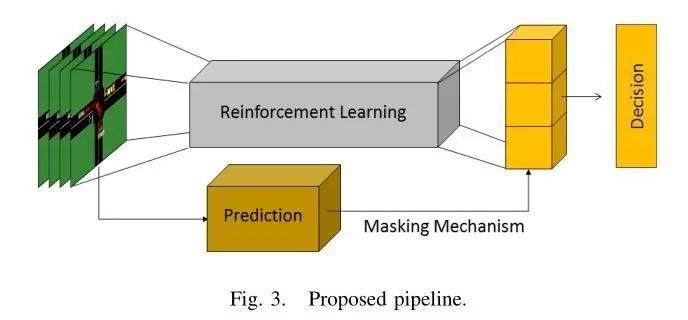

本文工作,提出了一个安全强化学习的框架,使用预测来掩盖不安全的行为。将此方法应用于自动驾驶域,以学习改善无符号交叉口处理性能的策略。

如果你对本文感兴趣,想要下载完整文章进行阅读,可以关注【泡泡机器人SLAM】公众号(paopaorobot_slam)。

欢迎来到泡泡论坛,这里有大牛为你解答关于SLAM的任何疑惑。

有想问的问题,或者想刷帖回答问题,泡泡论坛欢迎你!

泡泡网站:www.paopaorobot.org

泡泡论坛:http://paopaorobot.org/bbs/

泡泡机器人SLAM的原创内容均由泡泡机器人的成员花费大量心血制作而成,希望大家珍惜我们的劳动成果,转载请务必注明出自【泡泡机器人SLAM】微信公众号,否则侵权必究!同时,我们也欢迎各位转载到自己的朋友圈,让更多的人能进入到SLAM这个领域中,让我们共同为推进中国的SLAM事业而努力!

商业合作及转载请联系liufuqiang_robot@hotmail.com