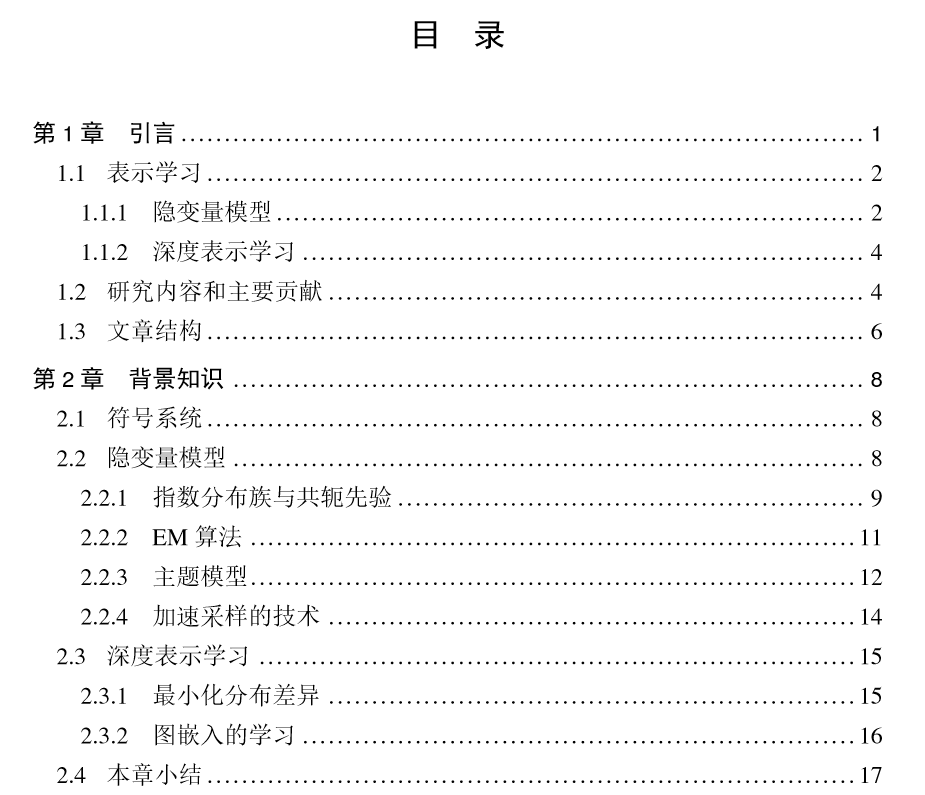

论文摘要:本文基于方差缩减、拒绝采样、访存优化等技术,研究了隐变量模型和深度表示学习两类模型的高效算法,并研究了这些算法在文本分析、生成式模型、图节 点分类等多个任务中的应用。具体地,本文创新点有:

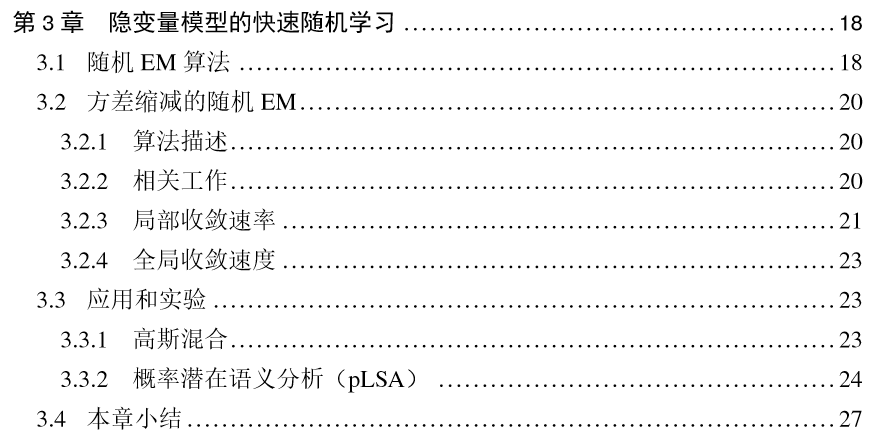

- 提出隐变量模型的方差缩减 EM 算法,并给出了其局部收敛速度和全局收敛性的理论结果。

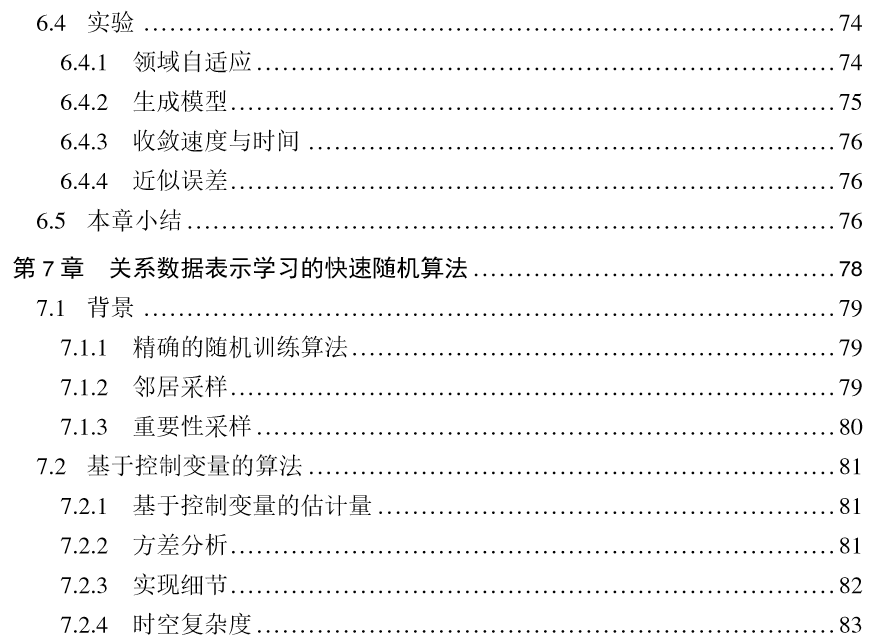

- 提出了缓存高效的 O(1) 时间复杂度主题模型采样算法,该算法较之前算法提速了 5-15 倍,且能扩展到数亿文档、数百万主题、上万 CPU 核的场景。

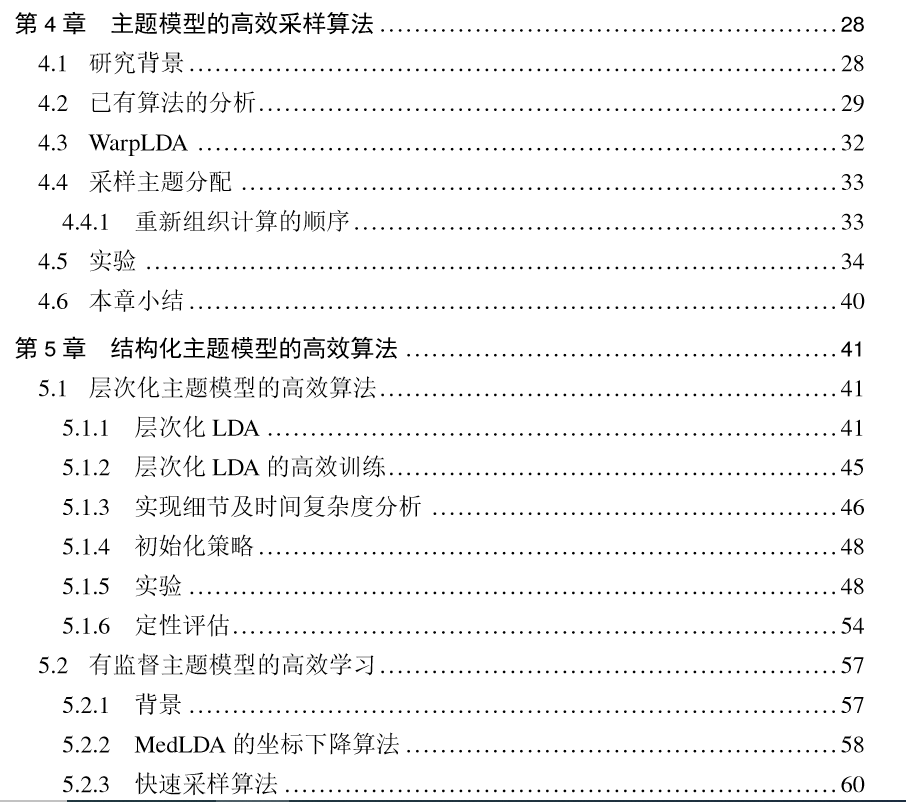

- 提出了结构化主题模型的高效算法,具体包括层次化主题模型的部分坍缩吉 布斯采样算法,将该模型扩展到了比之前大5个数量级的数据集上;以及有监督主题模型的坐标下降、拒绝采样算法,较之前算法加速4倍。

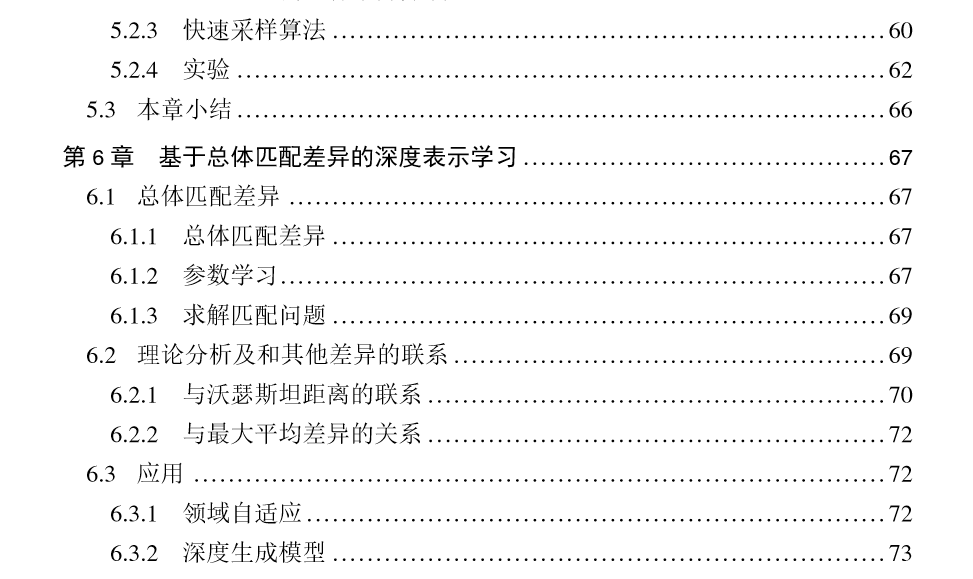

- 提出了总体匹配差异,一个两分布之间距离基于样本的估计;证明了总体匹配差异的一致性,并讨论了其在领域自适应、深度生成模型上的应用。

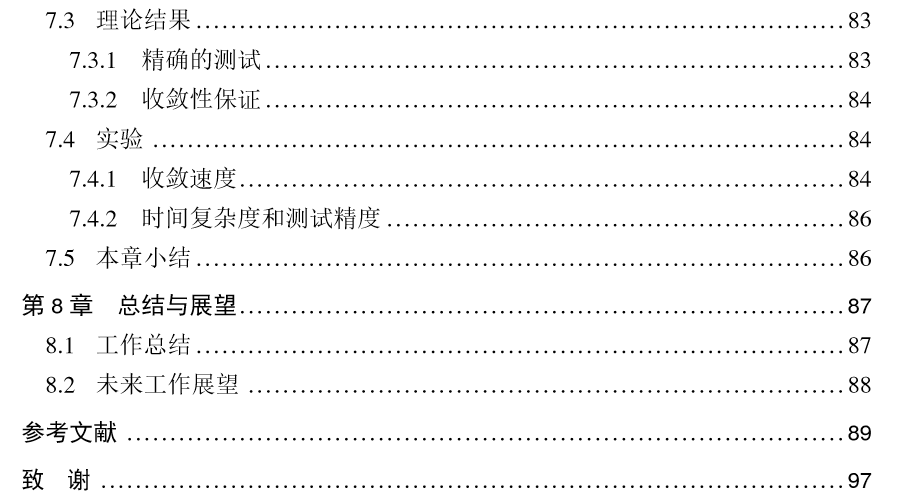

- 提出了一个基于控制变量的图卷积网络高效随机训练算法,并给出了其收敛性证明和实验结果,较之前算法收敛速度快了7倍。

关键词:表示学习;隐变量模型;主题模型;采样算法;图卷积网络

作者介绍:陈健飞,他目前是清华大学计算机科学与技术系的博士研究生,他的博士生导师是朱军。他研究兴趣是大规模机器学习,尤其是可扩展的深层生成模型和深层主题模型。之前,他专注于扩展各种主题模型,包括LDA、CTM、DTM等。

成为VIP会员查看完整内容