【泡泡一分钟】机器人顶级会议精华提炼(20190114-20190120)

每天一分钟,带你读遍机器人顶级会议文章

来源:计算机视觉和机器人顶级会议

播音员:糯米

汇总:陈世浪,颜青松

编译:泡泡一分钟全体组员

欢迎个人转发朋友圈;其他机构或自媒体如需转载,后台留言申请授权

摘要

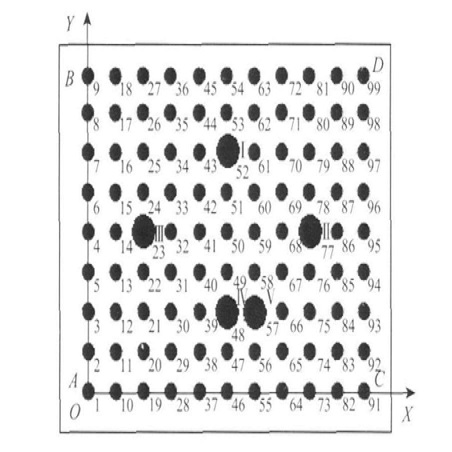

2019年1月14日至2019年1月19日,泡泡一分钟共推送了11篇文章,其内容涉及到位姿估计(2篇)、场景定位(2篇)、地图构建(2篇)、VO(1篇)、导航系统(1篇)、相机标定(1篇)、场景描述(1篇)和SLAM框架(1篇)等。

位姿估计

位姿估计共推送2篇文章。

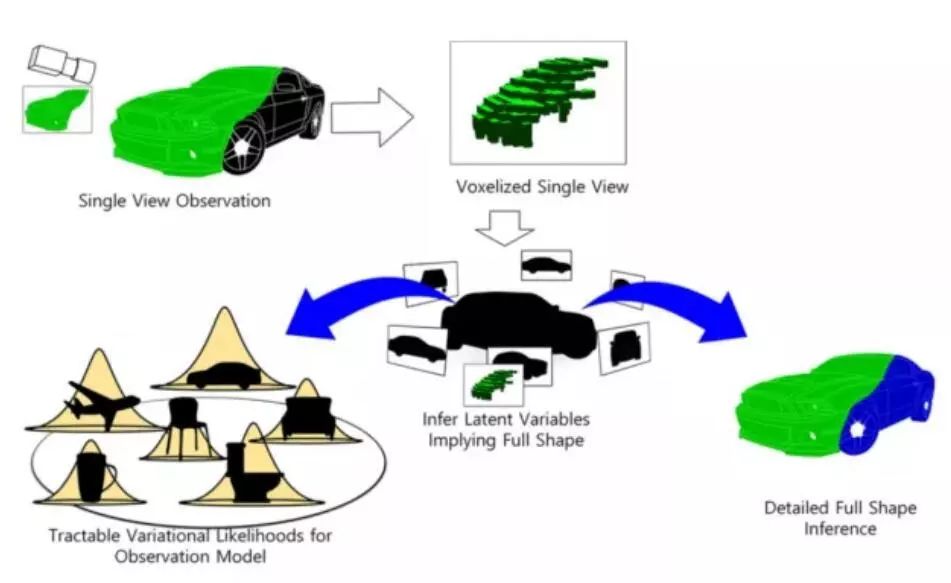

针对常见的推论方法都使用高维度下人工设计的图像特征问题,Dmitry 等提出了一种通过由一个CNN分类器输出的特征获得的视觉观测来推测系统的隐藏状态的方法,作者还分析了该方法在不同光照条件下的鲁棒性。

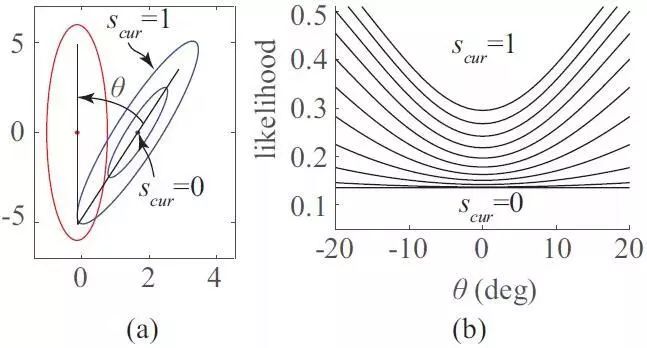

Hyunki等研究发现分布到分布的正态分布变换(NDT-D2D)基于分布间L2距离的目标函数与旋转对准呈负相关,提出了一种利用协方差的动态尺度因子来提高NDT-D2D的精度的方法。

场景定位

场景定位本周共推送2篇文章。

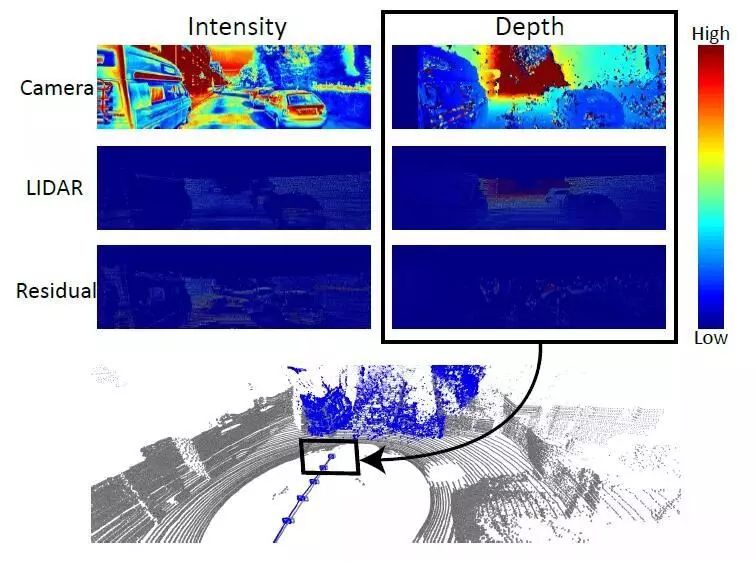

Youngj等基于已有的3D激光雷达地图提出了一个轻量型视觉定位的算法,该算法可以应用研究者自己的数据集上,并可以在SLAM框架中作为一个独立模块。

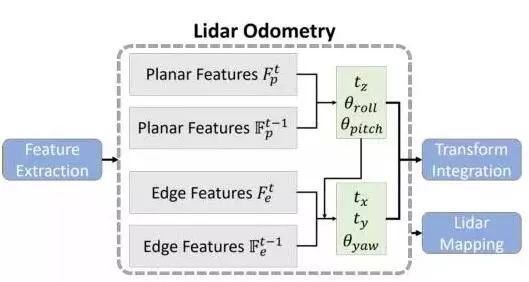

Tixiao等提出了一种用于地面车辆实时六自由度姿态估计的轻量级和地面优化激光雷达测距和测绘方法(LeGO-LOAM)。

地图构建

场景定位本周介绍了2篇文章。

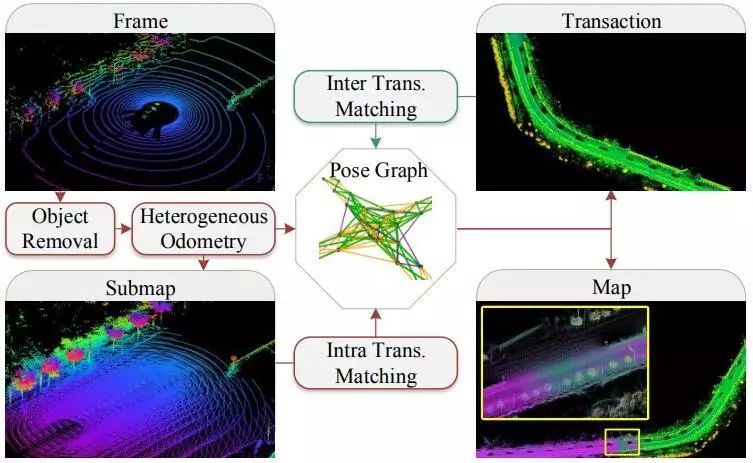

Sheng等提出了用于在城市范围内重建全局一致性3D高清地图的方法。

M. G.等实现了一个使用两对大广角立体相机的飞行系统,其能够快速完成感兴趣区域的地图。

VO

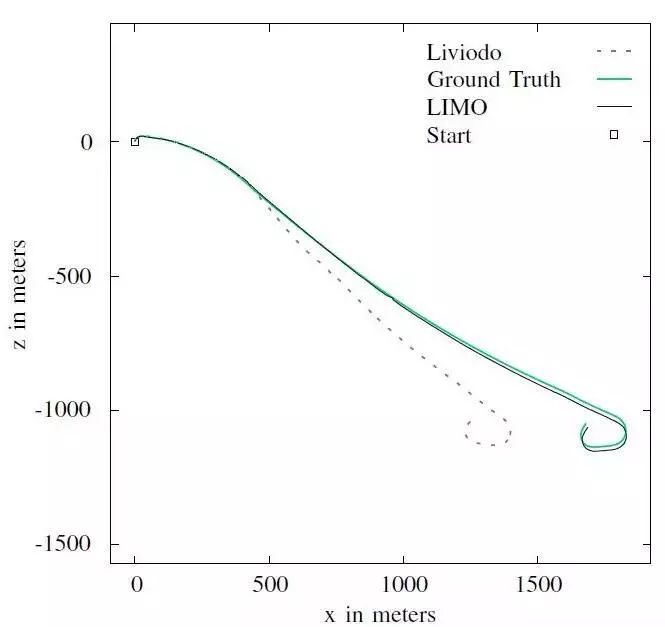

Johannes等提出了一种针对摄像机特征轨迹的激光雷达深度提取算法,并利用基于鲁棒关键帧的BA算法来估计运动。

导航系统

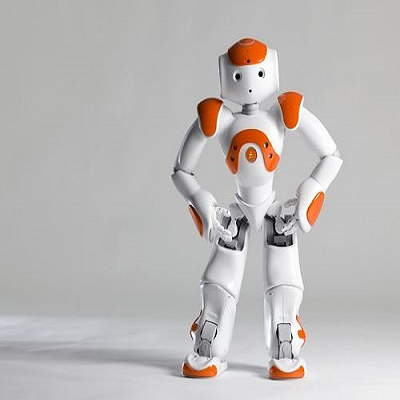

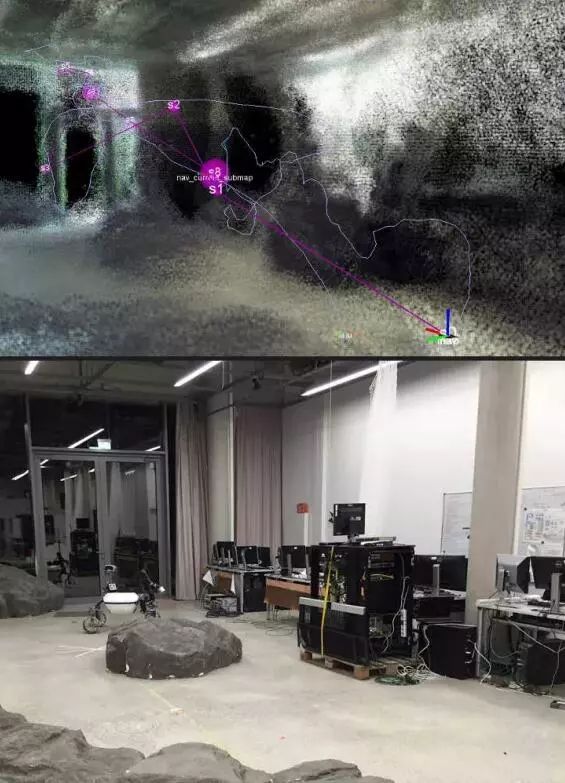

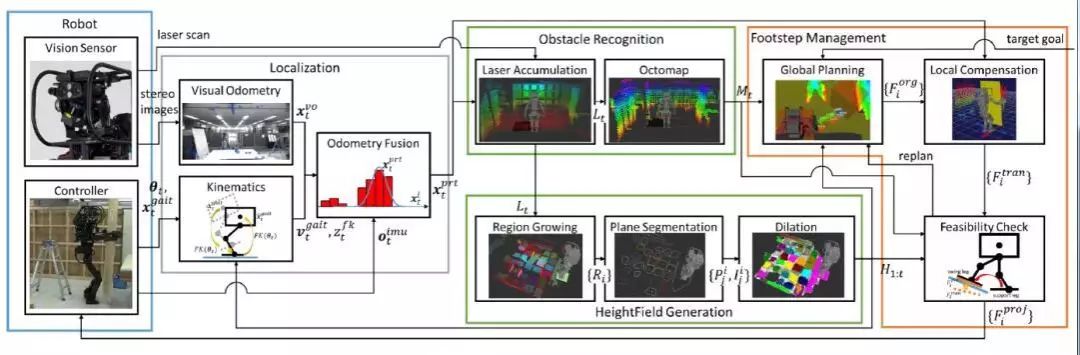

自适应运动系统可保证使仿人机器人在执行有遮挡或有姿势约束的任务时,准确地到达目标位置。自适应运动系统包含定位、建立环境地图、全局运动规划和局部错误校正功能。Iori 等提出了一种构建基于感知的仿人机器人运动系统的方法。

相机标定

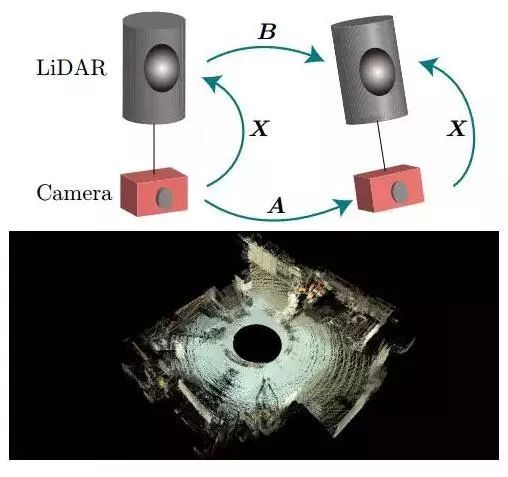

Ryoichi本文提出了一种无目标自动相机-LiDAR校准方法。 其方法将手眼校准框架扩展到2D-3D校准。使用传感器融合测距方法精确地计算具有尺度的相机运动,仅需要三维点云和相机图像。在室内和室外场景中使用多种传感器配置的实验证明了该方法的有效性。

场景描述

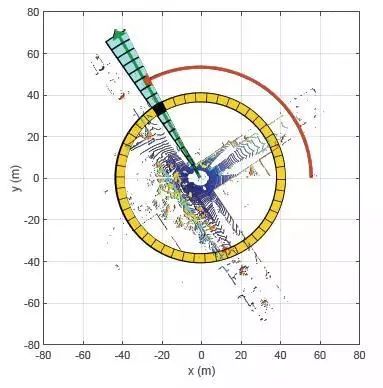

Giseop 等针对基于结构信息的全局定位,我们提出了扫描上下文,一种来自3D光检测和测距(LiDAR)扫描的基于非直方图的全局描述符。

SLAM框架

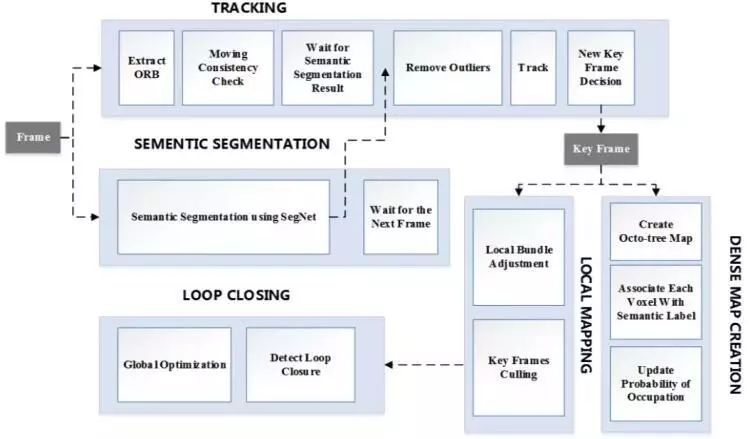

Chao 等提出了一个鲁棒的针对动态环境的语义视觉SLAM系统(DS-SLAM)。该系统中共有5个并行的线程:跟踪、语义分割、局部建图、闭环检测以及语义地图的稠密重建。

如果你对本文感兴趣,想要下载完整文章进行阅读,可以关注【泡泡机器人SLAM】公众号(paopaorobot_slam)。

欢迎来到泡泡论坛,这里有大牛为你解答关于SLAM的任何疑惑。

有想问的问题,或者想刷帖回答问题,泡泡论坛欢迎你!

泡泡网站:www.paopaorobot.org

泡泡论坛:http://paopaorobot.org/forums/

泡泡机器人SLAM的原创内容均由泡泡机器人的成员花费大量心血制作而成,希望大家珍惜我们的劳动成果,转载请务必注明出自【泡泡机器人SLAM】微信公众号,否则侵权必究!同时,我们也欢迎各位转载到自己的朋友圈,让更多的人能进入到SLAM这个领域中,让我们共同为推进中国的SLAM事业而努力!

商业合作及转载请联系liufuqiang_robot@hotmail.com