【泡泡一分钟】机器人顶级会议精华提炼(20190408-20190414)

每天一分钟,带你读遍机器人顶级会议文章

来源:计算机视觉和机器人顶级会议

播音员:水蘸墨,赵嘉珩

汇总:孙钦,陈世浪,颜青松

编译:泡泡一分钟全体组员

欢迎个人转发朋友圈;其他机构或自媒体如需转载,后台留言申请授权

摘要

2019年4月8日至2019年4月14日,泡泡一分钟共推送了11篇文章,其内容涉及到位姿估计(4篇)、地图构建(3篇)、后端优化(2篇)、传感器标定(1篇)、场景定位(1篇)等。

位姿估计

位姿估计方面本周共介绍了4篇文章。

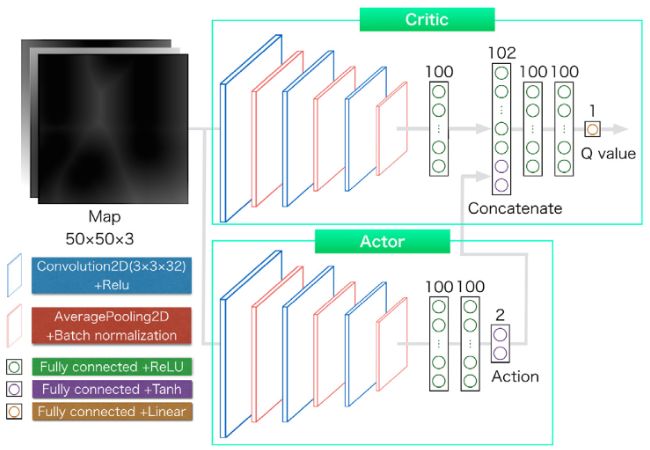

第一篇文章提出了一种根据用户状态生成其参与行为的方法。该方法根据用户的相对位置和方向等信息对用户的状态进行分类,并对每个分类的状态执行由深度确定性策略梯度(DDGP)网络训练得到的行为生成策略。

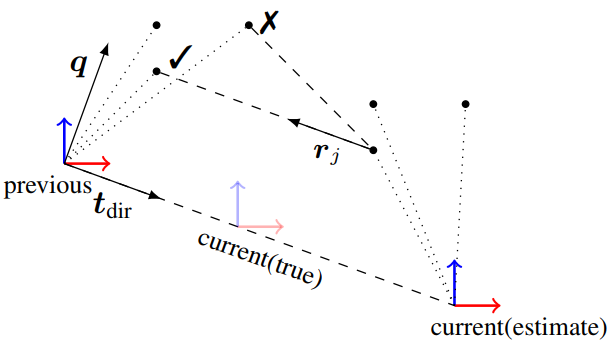

第二篇文章提出了一种结合单目相机和激光测距仪对增量自我运动进行估计的新方法。该方法利用相机确定方向,利用激光测距仪获取周围环境的3D点云信息,实现了比单一传感器更佳的性能。

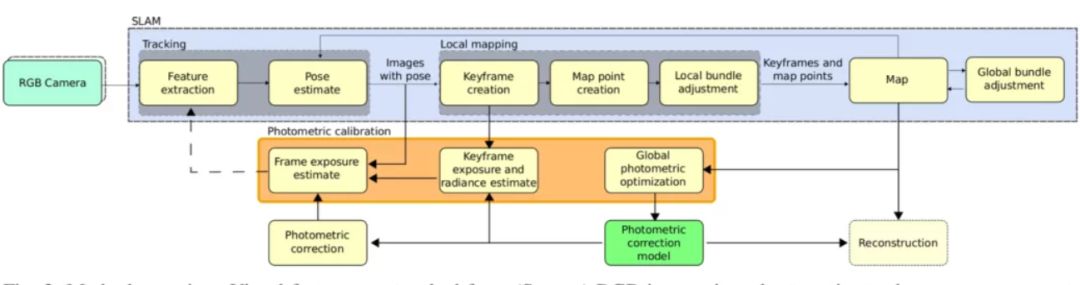

第三篇文章基于相机在移动,照明是静态的,反射属于朗伯反射的假设条件下,提出了一种在不需要均匀照明表面、已知纹理以及特定几何形状等信息的前提下,实现实时在线的光晕和响应校准。

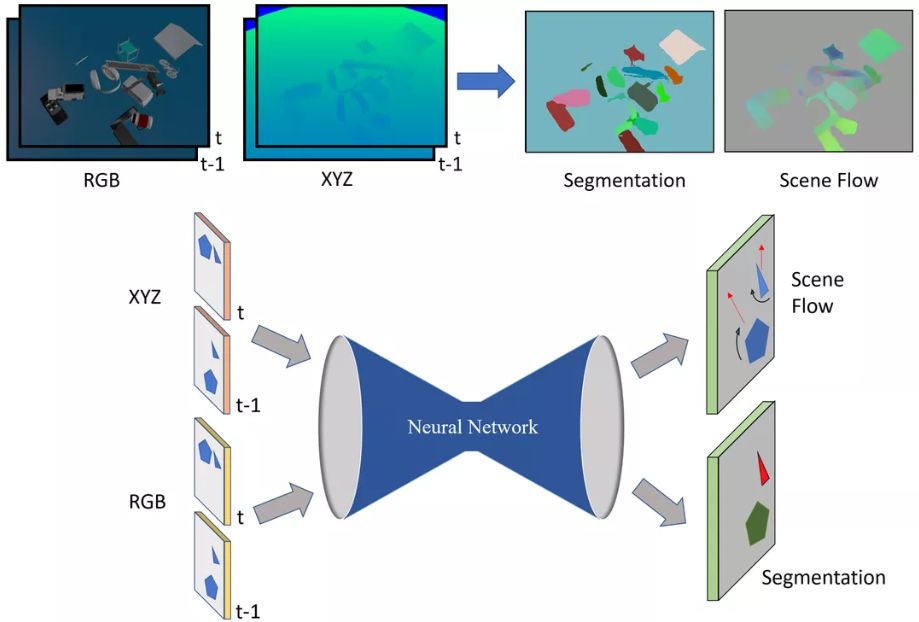

第四篇文章针对两幅连续的RGB-D图像,提出了一种估计密集三维运动场的模型。该模型使用了沙漏式深层神经网络结构。同时,本文还生成了包含有大量3D移动目标的具有挑战性的大规模合成数据集,并通过在该数据集上的实验,证明了本文方法优于最先进的场景流和运动分割方法。

地图构建

地图构建方面本周共推送3篇文章。

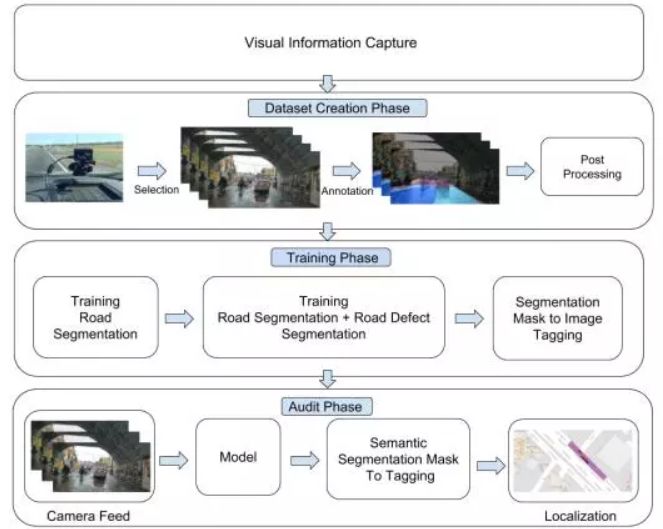

第一篇文章利用深度学习和语义分割的一些最新进展,提出了一个城市规模的自动道路审计系统,用于收集城市道路网络的缺陷信息。同时,作者还提出了一种多步深度学习模型,该模型对道路进行分割并将道路的缺陷进一步细分,为每个缺陷标记框架,最后将缺陷定位在使用GPS收集的地图上。

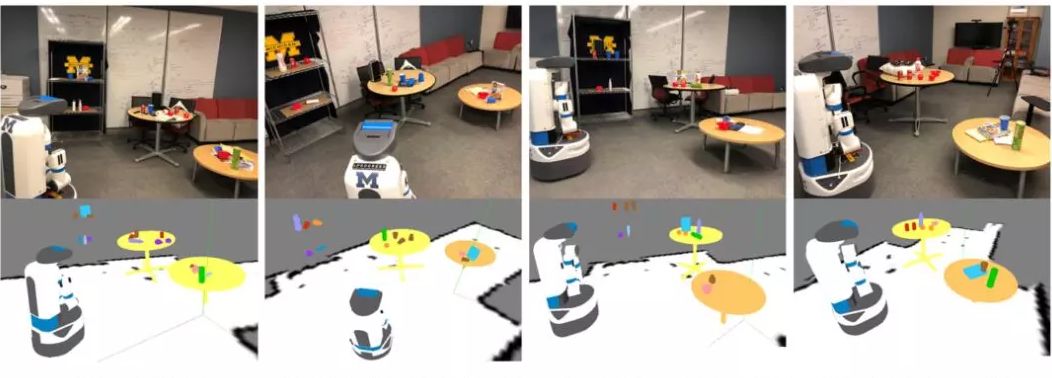

第二篇文章提出一种名为上下文时间一致性建图(CT-Map)的语义地图构建方法,该方法使用了粒子滤波算法,它在检测物体的同时还可以实现六个自由度的定位。作者在配备了RGB-D传感器的密西根进度提取机器人(Michigan Progress Fetch robot)上验证了CT-Map方法的有效性。

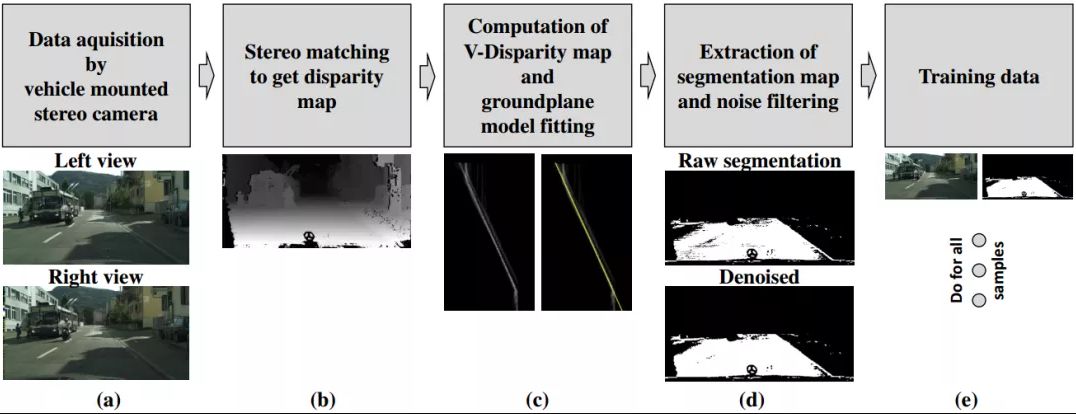

第三篇文章提出了一种基于深度神经网络(DNN),针对可驾驶区域分割任务的训练数据生成方法。作者提出了一种自动的标注流程,利用确定性立体的地面检测方法,创建了适合神经网络训练的大型数据集,为道路分割任务作出了贡献。

后端优化

后端优化方面本周共推送2篇文章。

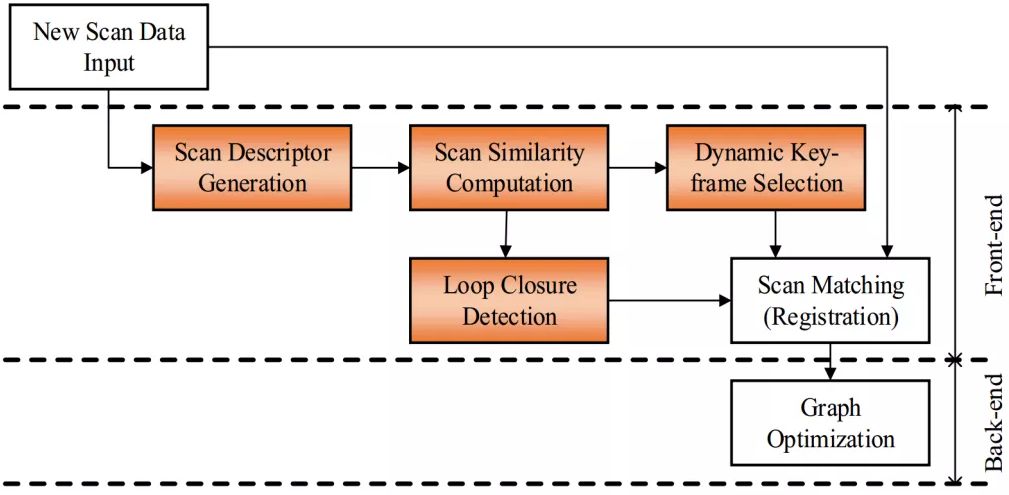

第一篇文章提出了一种用于Graph SLAM的基于扫描相似度的位姿图构建方法。作者利用先前提出的2D激光扫描描述子来进行闭环检测,并通过在公开数据集以及真实世界数据集上的实验,展示了算法的客观性能。

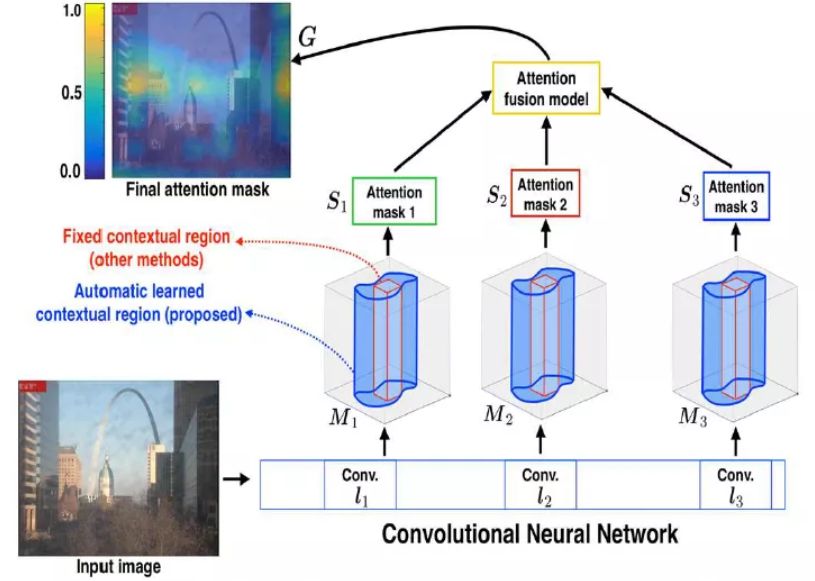

第二篇文章提出了一种新型的注重图像语境的灵活注意机制。作者引入了一个多尺度,语境灵活的网络,用来估计特征地图中每个空间区域的重要性。该网络使用端到端的训练模型进行位置识别,能够检测任意形状的感兴趣区域。

传感器标定

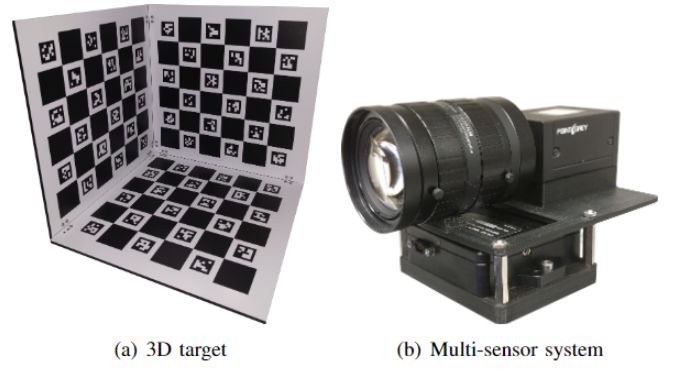

为了找到IMU与相机传感器的相对时间戳偏移量及其不确定性,这篇文章提出了一种确定IMU和摄像机的方位估计的方法,该方法在找到包围真实偏移区间的同时,还对不其确定性进行了建模。

场景定位

鉴于视觉里程计等传统视觉定位方法在远程导航中会产生误差累积,本文提出了一种灵活的多位置联合粒子滤波(MPJPF)框架来校正位置误差。而且实验表明,本文的方法可以在没有GPS或其他类型的绝对位置传感器的帮助下,且无论轨迹多长或弯曲,都能进行长时间的车辆定位。

如果你对本文感兴趣,想要下载完整文章进行阅读,可以关注【泡泡机器人SLAM】公众号(paopaorobot_slam)。

欢迎来到泡泡论坛,这里有大牛为你解答关于SLAM的任何疑惑。

有想问的问题,或者想刷帖回答问题,泡泡论坛欢迎你!

泡泡网站:www.paopaorobot.org

泡泡论坛:http://paopaorobot.org/bbs/

泡泡机器人SLAM的原创内容均由泡泡机器人的成员花费大量心血制作而成,希望大家珍惜我们的劳动成果,转载请务必注明出自【泡泡机器人SLAM】微信公众号,否则侵权必究!同时,我们也欢迎各位转载到自己的朋友圈,让更多的人能进入到SLAM这个领域中,让我们共同为推进中国的SLAM事业而努力!

商业合作及转载请联系liufuqiang_robot@hotmail.com