题目: Dual Averaging Method for Regularized Stochastic Learning and Online Optimization

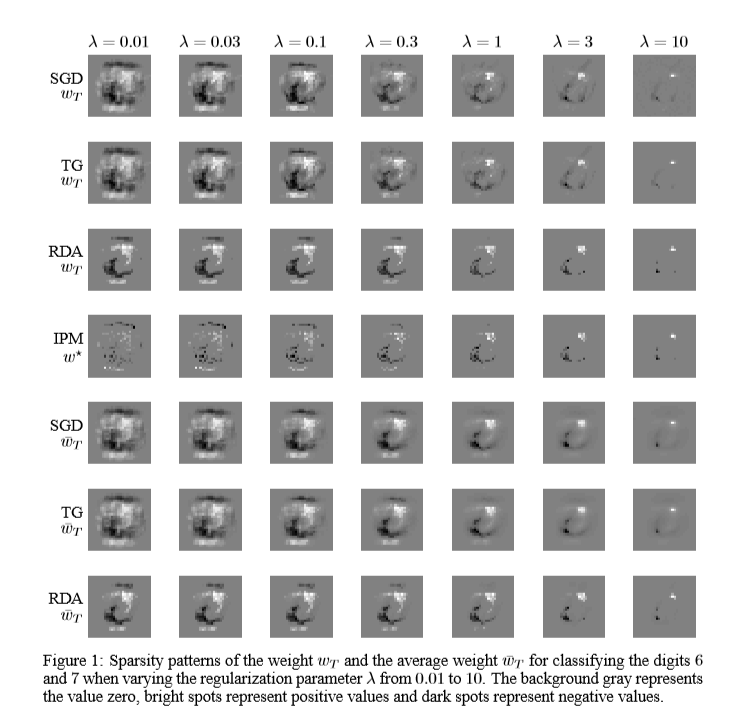

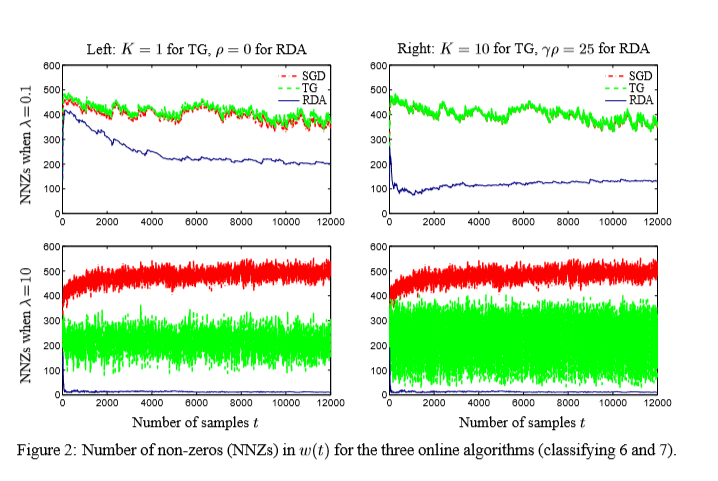

简介: 我们考虑正则化随机学习和在线优化问题,其中目标函数是两个凸项的和:一个是学习任务的损失函数,另一个是简单的正则化项,例如ℓ1-范数,以促进稀疏性。 我们开发了一种新的在线算法,即正规化双重平均(RDA)方法,该算法可以在在线环境中显式利用正规化结构。 特别是,在每次迭代中,通过解决一个简单的优化问题来调整学习变量,该问题涉及损失函数的所有子梯度的运行平均值以及整个正则化项,而不仅仅是其子梯度。这篇文章研究了正则化的随机学习和在线优化问题,提出了一种新的算法——正规化双重平均法。与标准随机梯度法类似,该方法可达到最佳收敛速度,并且每次迭代通常具有较低的复杂度。

成为VIP会员查看完整内容

相关内容

专知会员服务

69+阅读 · 2020年6月19日

专知会员服务

25+阅读 · 2020年2月28日

专知会员服务

20+阅读 · 2020年1月7日