题目: Online Deep Clustering for Unsupervised Representation Learning

摘要:

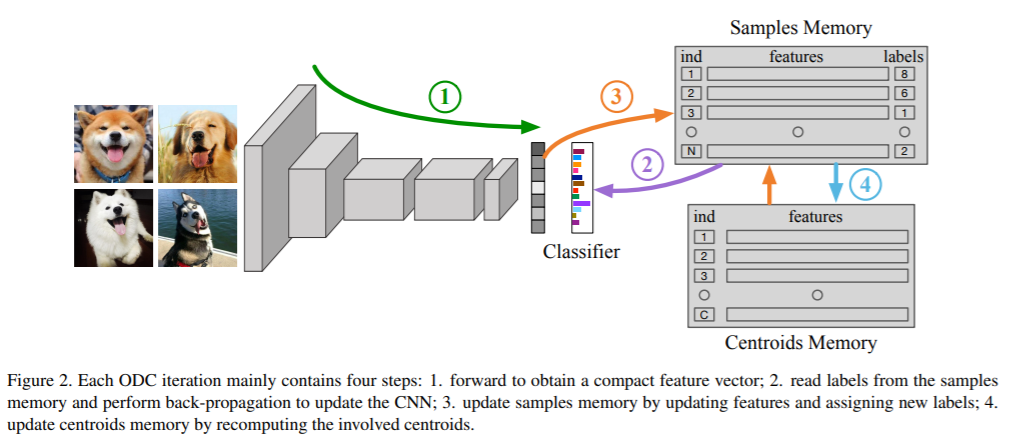

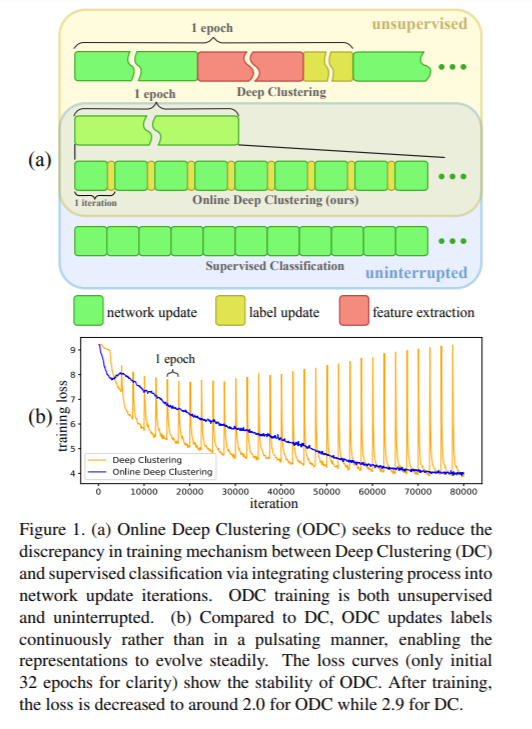

联合聚类和特征学习方法在无监督表示学习中表现出了显著的效果。但是,特征聚类和网络参数更新训练计划的交替导致视觉表征学习的不稳定。为了克服这个挑战,我们提出在线深度集群(ODC),它可以同时执行集群和网络更新,而不是交替进行。关键见解是,聚类中心应该稳步发展,以保持分类器的稳定更新。具体来说,设计和维护了两个动态内存模块,即样本记忆用于存储样本标签和特征,中心记忆用于中心进化。我们将全局聚类分解为稳定的内存更新和成批的标签重新分配。该过程被集成到网络更新迭代中。通过这种方式,标签和网络齐头并进,而不是交替发展。大量的实验表明,ODC能够稳定训练过程,有效地提高训练性能。

成为VIP会员查看完整内容

相关内容

表示学习是通过利用训练数据来学习得到向量表示,这可以克服人工方法的局限性。 表示学习通常可分为两大类,无监督和有监督表示学习。大多数无监督表示学习方法利用自动编码器(如去噪自动编码器和稀疏自动编码器等)中的隐变量作为表示。 目前出现的变分自动编码器能够更好的容忍噪声和异常值。 然而,推断给定数据的潜在结构几乎是不可能的。 目前有一些近似推断的策略。 此外,一些无监督表示学习方法旨在近似某种特定的相似性度量。提出了一种无监督的相似性保持表示学习框架,该框架使用矩阵分解来保持成对的DTW相似性。 通过学习保持DTW的shaplets,即在转换后的空间中的欧式距离近似原始数据的真实DTW距离。有监督表示学习方法可以利用数据的标签信息,更好地捕获数据的语义结构。 孪生网络和三元组网络是目前两种比较流行的模型,它们的目标是最大化类别之间的距离并最小化了类别内部的距离。

专知会员服务

46+阅读 · 2020年7月29日

专知会员服务

26+阅读 · 2020年2月16日

Arxiv

5+阅读 · 2018年7月21日