题目: Stochastic Graph Neural Networks

简介:

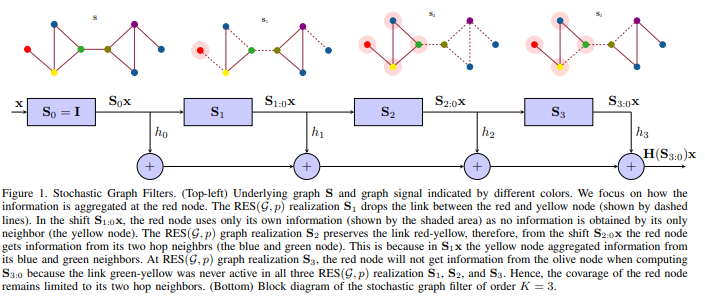

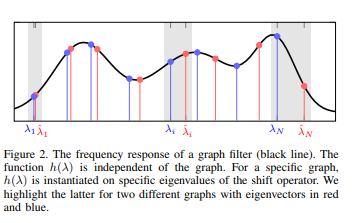

图神经网络(GNN)对图数据中的非线性表示进行建模,并在分布式智能体协调,控制和规划等方面进行了应用。当前的GNN架构假设理想情况,并且忽略由于环境,人为因素或外部攻击而发生的波动。在这些情况下,如果未考虑拓扑随机性,则GNN无法解决其分布式任务。为了克服这个问题,我们提出了随机图神经网络(SGNN)模型:一种GNN,其中分布式图卷积模块解决了随机网络的变化。由于随机性引入了新的学习范式,因此我们对SGNN输出方差进行统计分析,以识别学习滤波器为实现向扰动场景的鲁棒转移而应满足的条件,最终揭示随机链路损耗的显式影响。我们进一步为SGNN开发了基于随机梯度下降(SGD)的学习过程,并推导了学习速率收敛的条件,在该条件下该学习过程收敛于平稳点。数值结果证实了我们的理论研究,并将SGNN鲁棒与传统GNN的优势进行了比较,后者在学习过程中忽略了图形扰动。

成为VIP会员查看完整内容

相关内容

专知会员服务

76+阅读 · 2020年1月16日

Arxiv

13+阅读 · 2019年5月22日