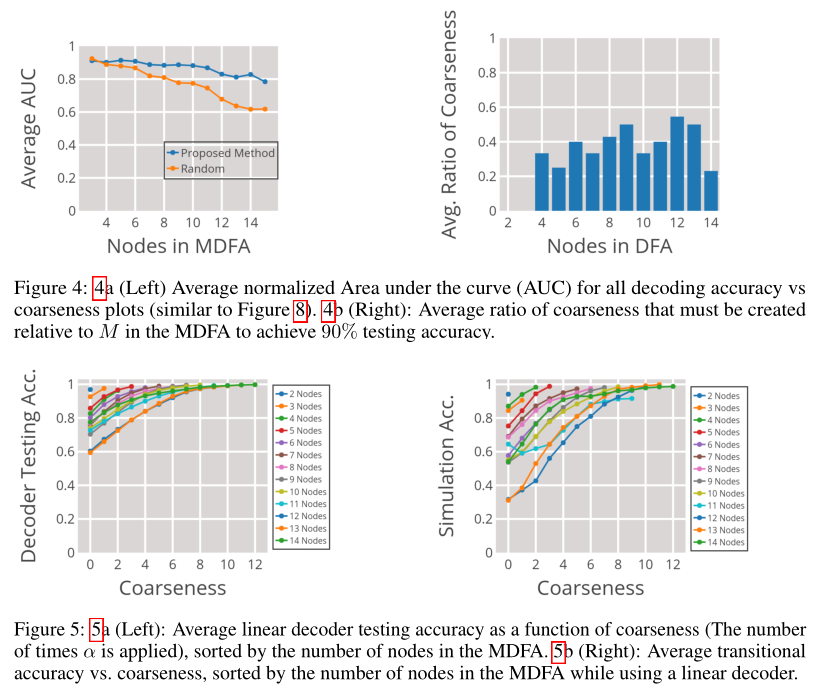

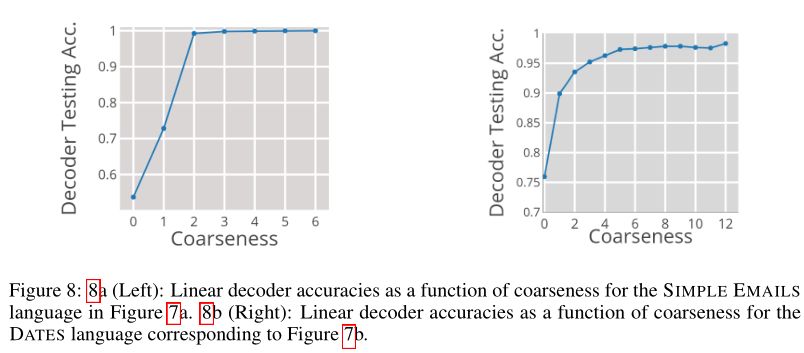

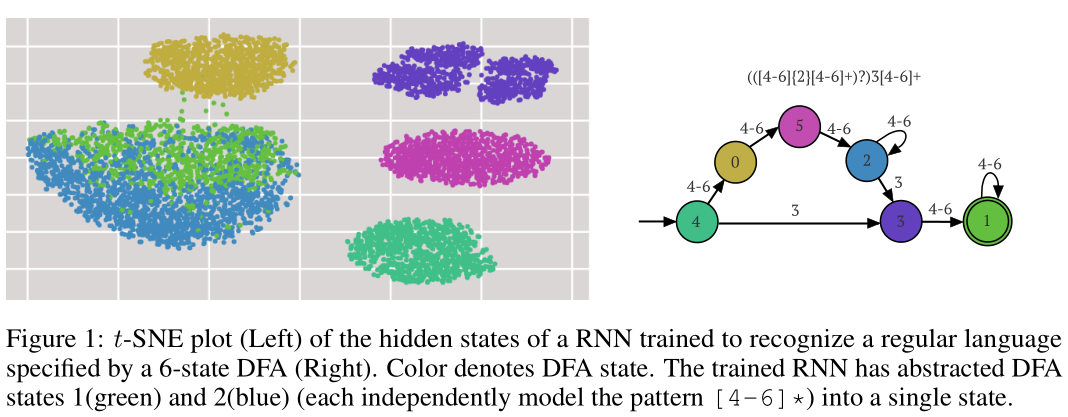

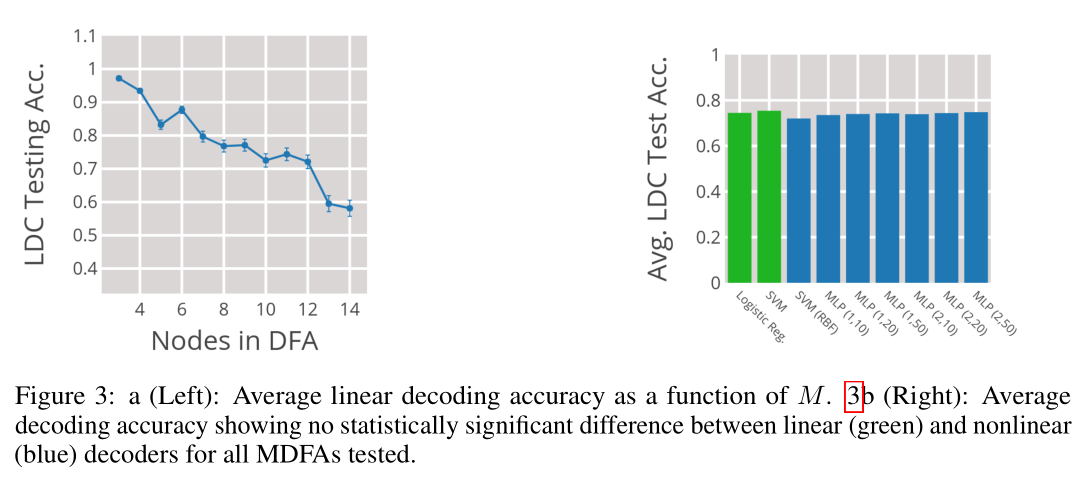

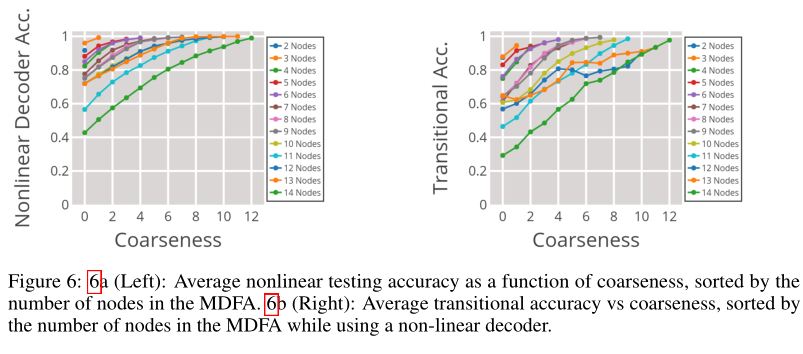

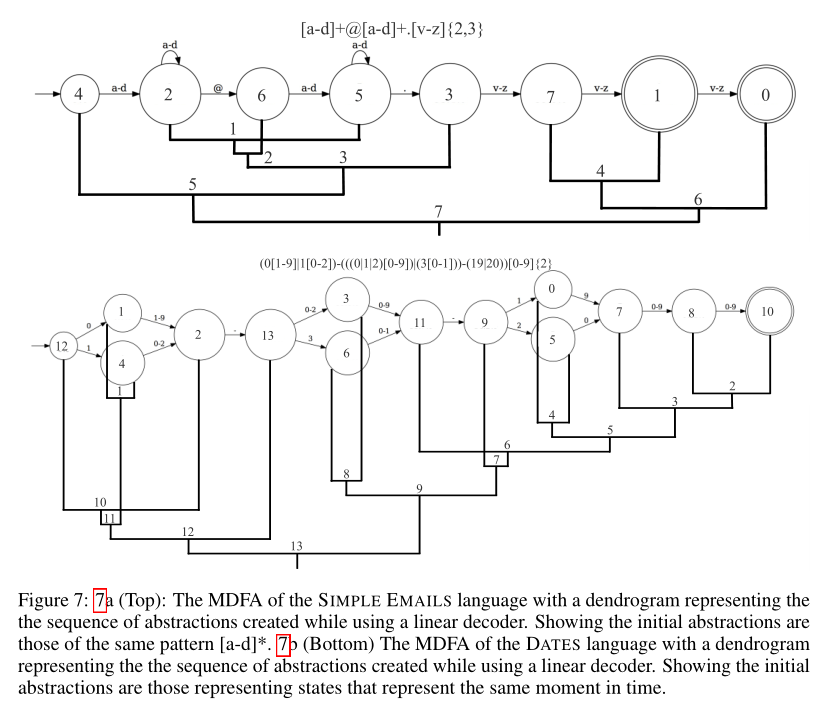

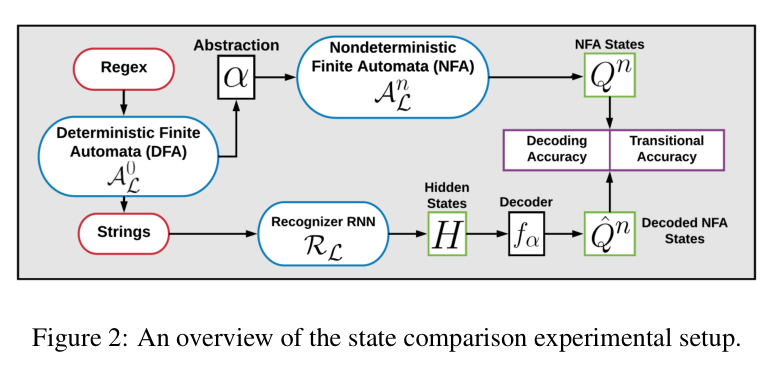

摘要: 我们研究了循环神经网络在学习规则形式语言时的内部表示。具体来说,我们训练一个RNN从一种普通语言的正反例子,并查寻是否有一个简单的解码函数,将这个RNN的状态映射到该语言的最小确定性有限自动机(MDFA)的状态。我们的实验表明,这种译码函数确实存在,并且它不是将RNN的状态映射到MDFA状态,而是将小组MDFA状态聚类成超状态得到的抽象状态。定性分析表明,抽象通常有一个简单的解释。总的来说,研究结果表明,RNNs使用的内部表征与有限自动机之间存在很强的结构关系,并解释了众所周知的RNNs识别形式语法结构的能力。

成为VIP会员查看完整内容

相关内容

ICLR,全称为「International Conference on Learning Representations」(国际学习表征会议),2013 年才刚刚成立了第一届。这个一年一度的会议虽然今年才办到第五届,但已经被学术研究者们广泛认可,被认为「深度学习的顶级会议」。

ICLR由位列深度学习三大巨头之二的 Yoshua Bengio 和 Yann LeCun 牵头创办。

ICLR 希望能为深度学习提供一个专业化的交流平台。但实际上 ICLR 不同于其它国际会议,得到好评的真正原因,并不只是他们二位所自带的名人光环,而在于它推行的 Open Review 评审制度。

Arxiv

4+阅读 · 2018年11月21日

Arxiv

4+阅读 · 2018年4月26日