简介:

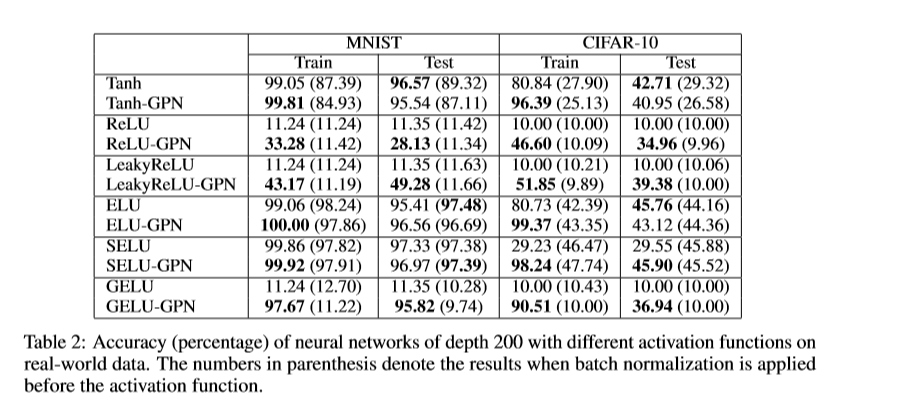

梯度爆炸和消失的问题一直是阻碍神经网络有效训练的长期障碍。尽管在实践中采用了各种技巧和技术来缓解该问题,但仍然缺少令人满意的理论或可证明的解决方案。在本文中,我们从高维概率论的角度解决了这个问题。我们提供了严格的结果,表明在一定条件下,如果神经网络具有足够的宽度,则爆炸/消失梯度问题将很可能消失。我们的主要思想是通过一类新的激活函数(即高斯-庞加莱归一化函数和正交权重矩阵)来限制非线性神经网络中的正向和反向信号传播。在数据实验都可以验证理论,并在实际应用中将其有效性确认在非常深的神经网络上。

成为VIP会员查看完整内容

相关内容

专知会员服务

79+阅读 · 2019年12月29日

Arxiv

16+阅读 · 2019年5月24日

Arxiv

4+阅读 · 2018年6月12日

Arxiv

7+阅读 · 2018年5月25日

Arxiv

3+阅读 · 2018年4月18日