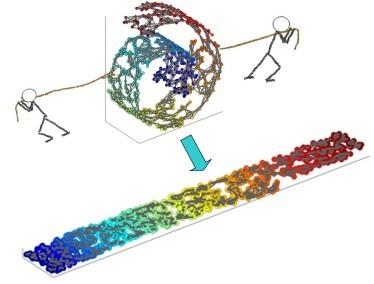

Locally Linear Embedding (LLE) is a nonlinear spectral dimensionality reduction and manifold learning method. It has two main steps which are linear reconstruction and linear embedding of points in the input space and embedding space, respectively. In this work, we propose two novel generative versions of LLE, named Generative LLE (GLLE), whose linear reconstruction steps are stochastic rather than deterministic. GLLE assumes that every data point is caused by its linear reconstruction weights as latent factors. The proposed GLLE algorithms can generate various LLE embeddings stochastically while all the generated embeddings relate to the original LLE embedding. We propose two versions for stochastic linear reconstruction, one using expectation maximization and another with direct sampling from a derived distribution by optimization. The proposed GLLE methods are closely related to and inspired by variational inference, factor analysis, and probabilistic principal component analysis. Our simulations show that the proposed GLLE methods work effectively in unfolding and generating submanifolds of data.

翻译:局部线性嵌入( LLE) 是一种非线性光谱维度递减和多重学习方法。 它有两个主要步骤, 分别是线性重建以及输入空间和嵌入空间中点的线性嵌入。 在这项工作中, 我们建议了两种新型的LLE 基因化版本, 叫做“ 引力化 LLE ” ( GLLE ), 其线性重建步骤是随机的, 而不是确定性的。 GLLE 假设每个数据点都是由线性重建重量作为潜在因素造成的。 提议的GLLE 算法可以产生各种LLE 嵌入式, 而所有生成的嵌入式都与原LLE 嵌入有关。 我们建议了两种版本的线性线性重建, 一种是利用预期最大化, 另一种是利用通过优化的分布直接抽样。 拟议的GLLE 方法与变化的推断、 要素分析以及概率性主要组成部分分析密切相关并受到启发。 我们的模拟表明, 拟议的GLE 方法在数据演化和生成子上有效发挥作用。