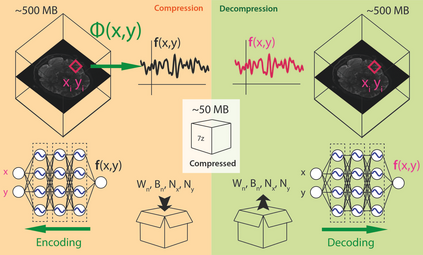

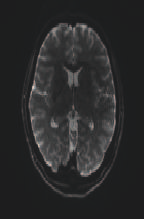

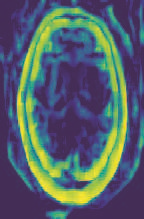

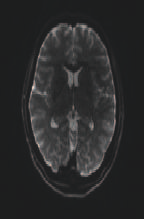

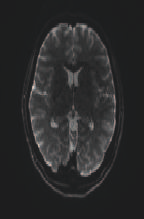

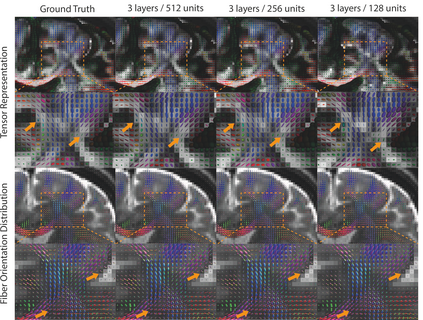

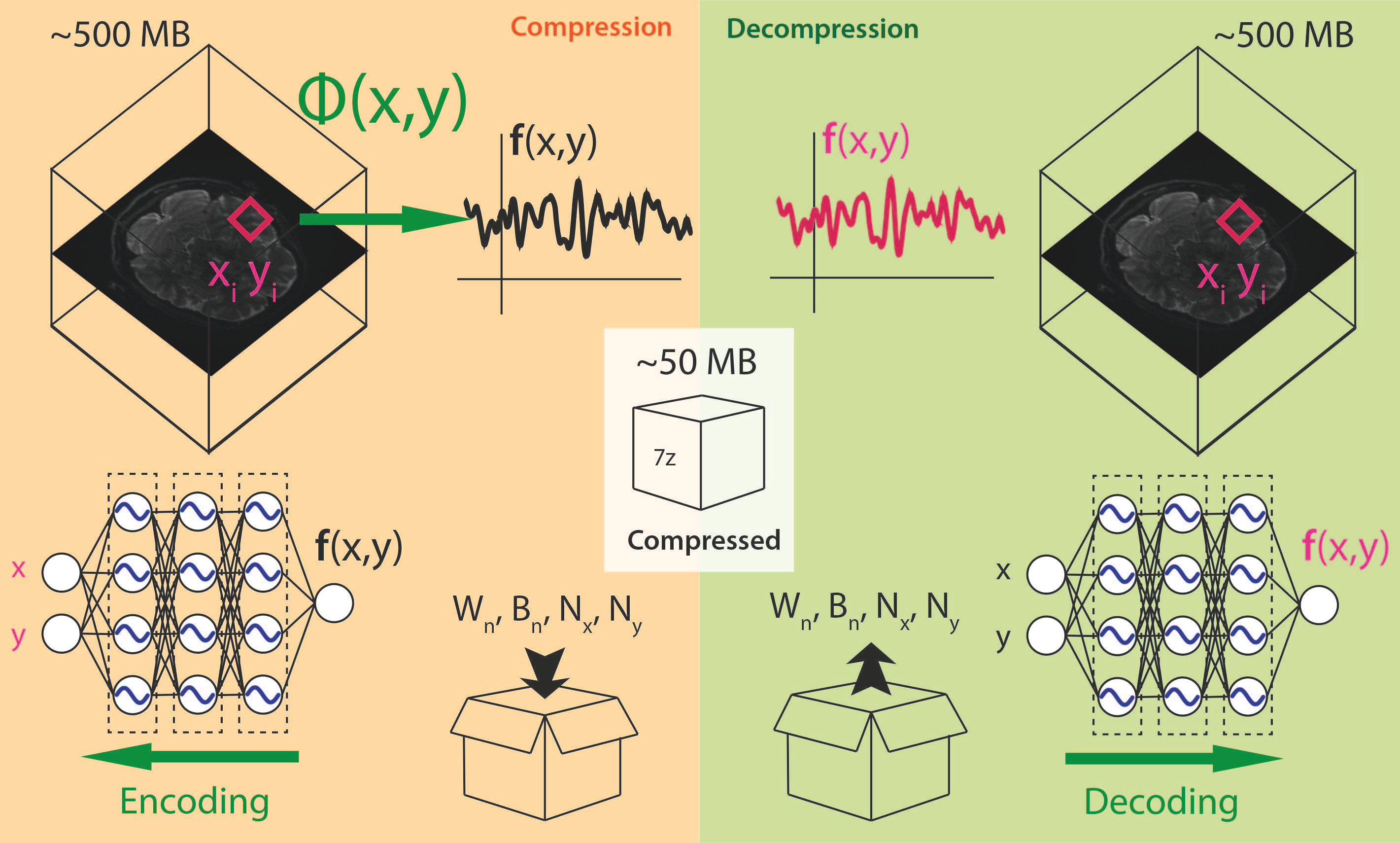

In this work, we evaluate how neural networks with periodic activation functions can be leveraged to reliably compress large multidimensional medical image datasets, with proof-of-concept application to 4D diffusion-weighted MRI (dMRI). In the medical imaging landscape, multidimensional MRI is a key area of research for developing biomarkers that are both sensitive and specific to the underlying tissue microstructure. However, the high-dimensional nature of these data poses a challenge in terms of both storage and sharing capabilities and associated costs, requiring appropriate algorithms able to represent the information in a low-dimensional space. Recent theoretical developments in deep learning have shown how periodic activation functions are a powerful tool for implicit neural representation of images and can be used for compression of 2D images. Here we extend this approach to 4D images and show how any given 4D dMRI dataset can be accurately represented through the parameters of a sinusoidal activation network, achieving a data compression rate about 10 times higher than the standard DEFLATE algorithm. Our results show that the proposed approach outperforms benchmark ReLU and Tanh activation perceptron architectures in terms of mean squared error, peak signal-to-noise ratio and structural similarity index. Subsequent analyses using the tensor and spherical harmonics representations demonstrate that the proposed lossy compression reproduces accurately the characteristics of the original data, leading to relative errors about 5 to 10 times lower than the benchmark JPEG2000 lossy compression and similar to standard pre-processing steps such as MP-PCA denosing, suggesting a loss of information within the currently accepted levels for clinical application.

翻译:在这项工作中,我们评估如何利用具有定期激活功能的神经网络来可靠压缩大型多维医疗图像数据集,对4D扩散加权MRI(dMRI)进行测试应用。在医学成像景观中,多维MRI是开发对基本组织微观结构敏感和特有的生物标志的关键研究领域。然而,这些数据的高维性质在储存和共享能力及相关成本方面构成了挑战,需要适当的算法能够在低维空间中代表信息。最近深层学习的理论发展表明,定期启动功能是如何为图像隐含神经表示力的强大工具,并可用于压缩2D图像。在这里,我们将这一方法扩大到4D图像,并表明,任何给定的4DDMRI数据集都可以通过感应原组织微观激活网络的参数准确表达,使数据压缩率比标准的DEFLATE算法高出大约10倍。我们的结果显示,拟议的方法比ReLU和Tancepron启动的精确度结构结构显示,以目前相似的缩略度缩缩缩缩缩图的缩图显示,用目前的缩缩缩图表显示,比的缩略图的缩缩缩缩缩缩缩缩缩缩缩图的缩略图的缩图显示了10的缩图的缩略图的缩图的缩略图的缩图的缩图的缩略图的缩图的缩图的缩图。