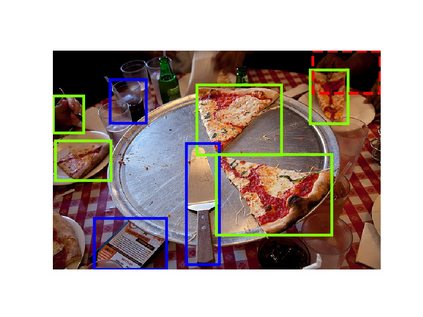

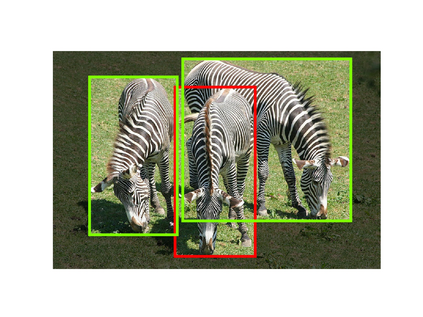

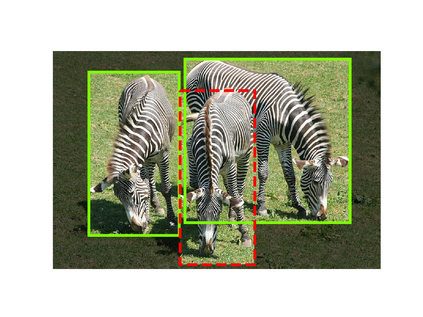

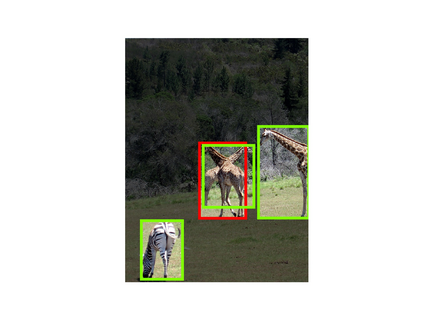

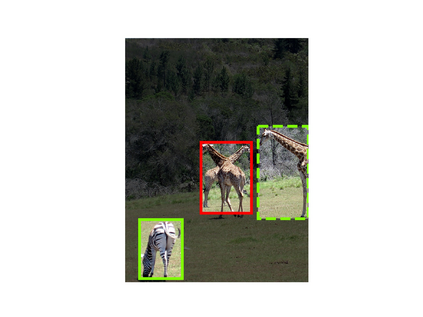

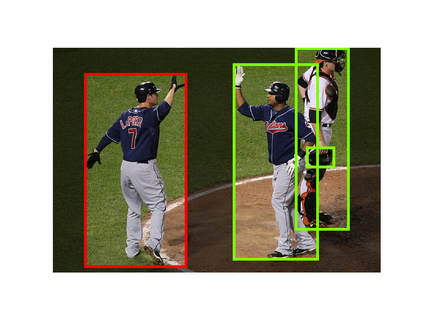

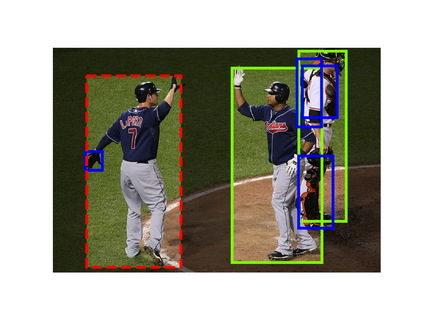

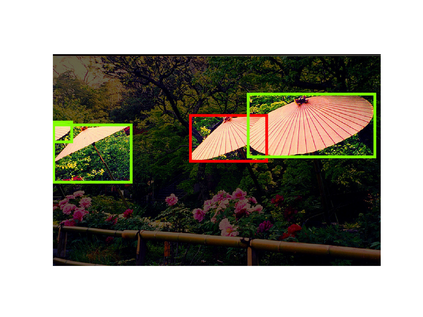

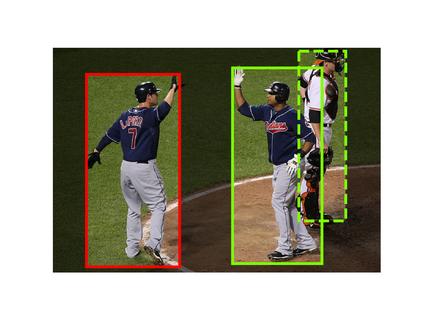

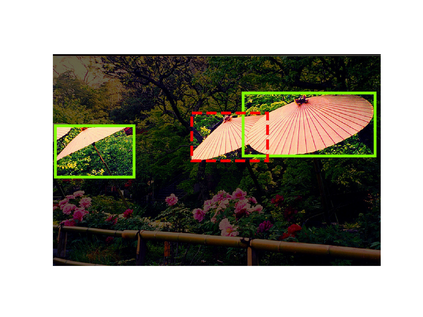

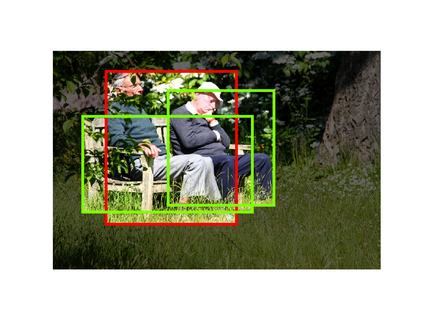

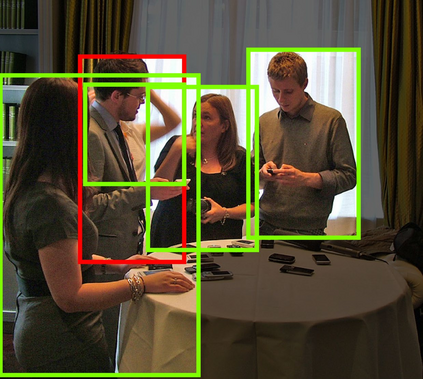

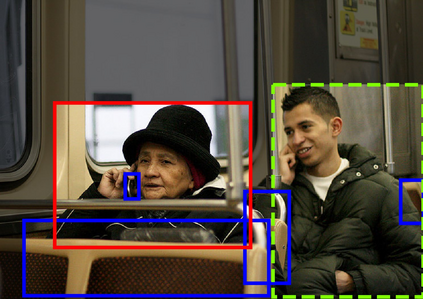

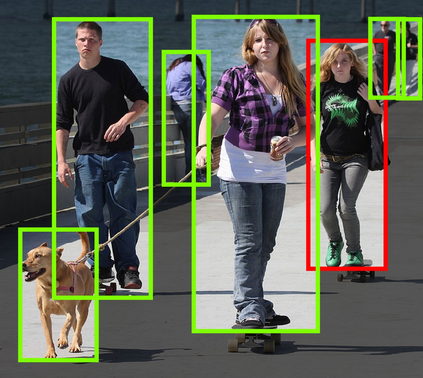

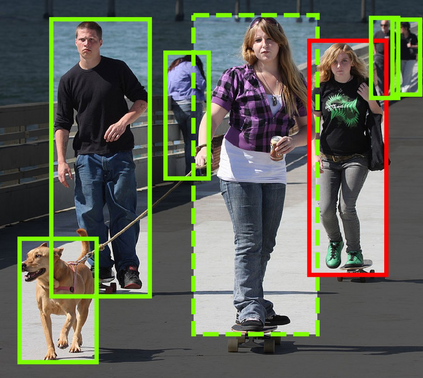

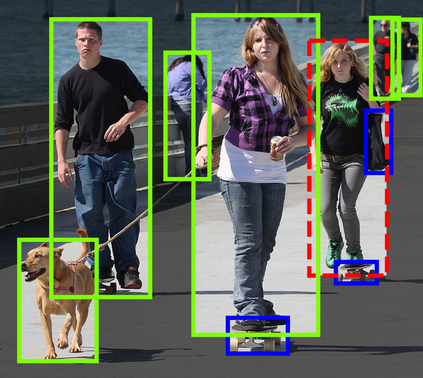

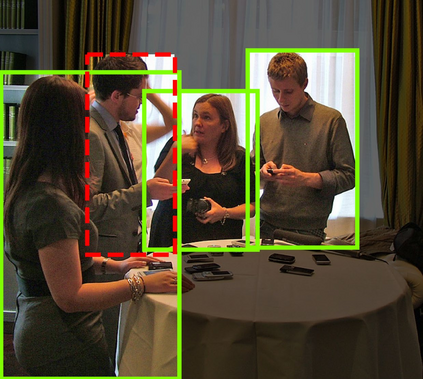

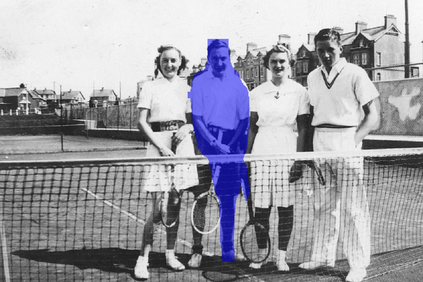

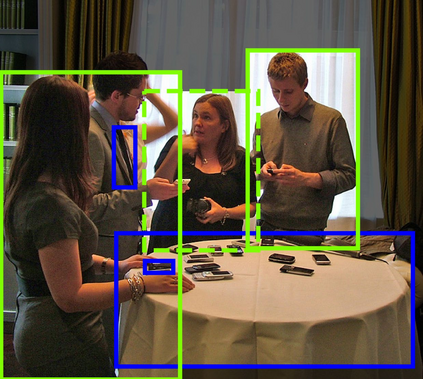

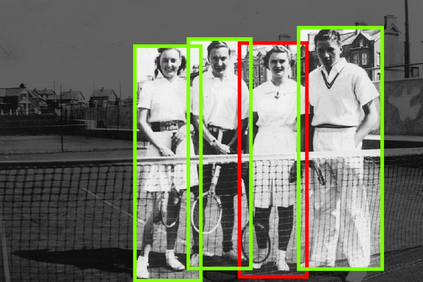

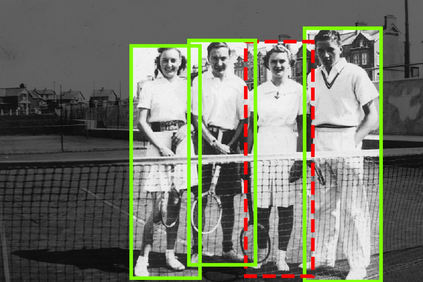

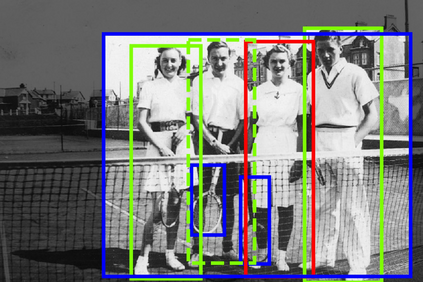

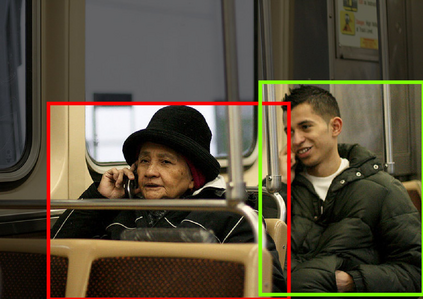

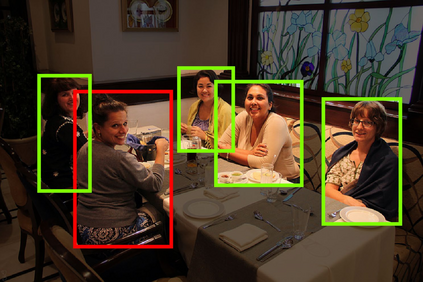

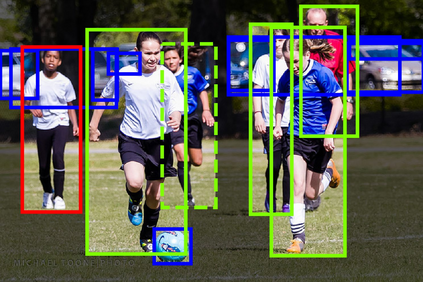

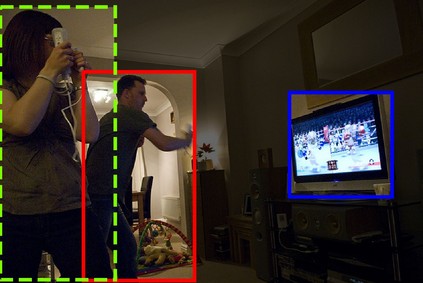

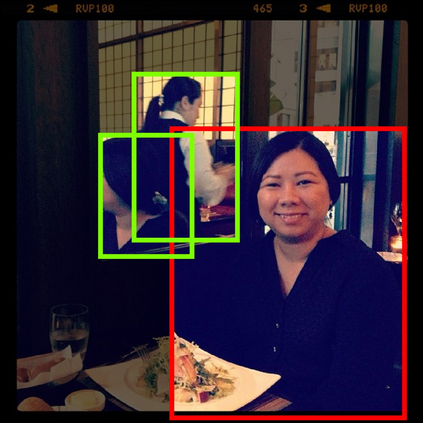

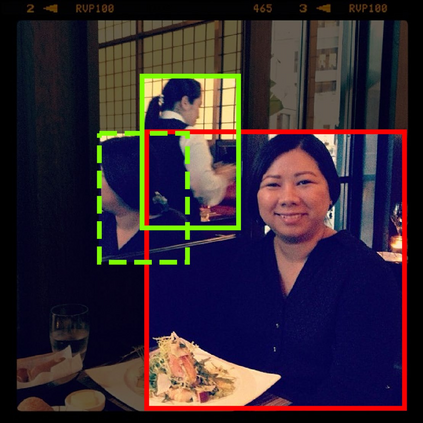

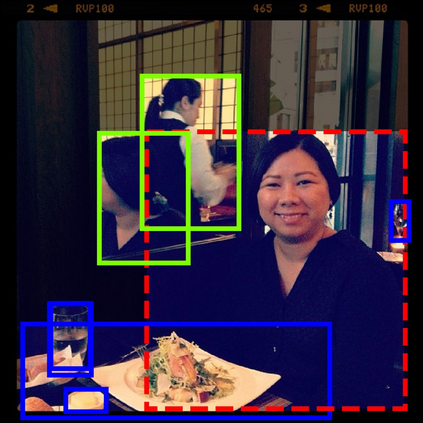

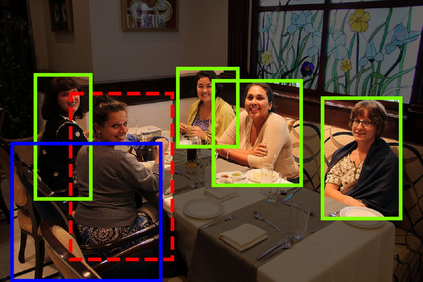

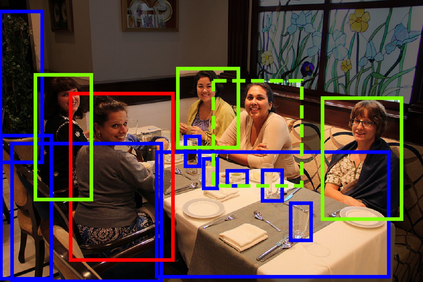

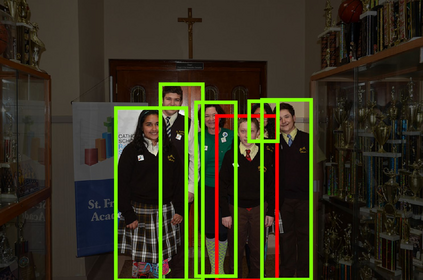

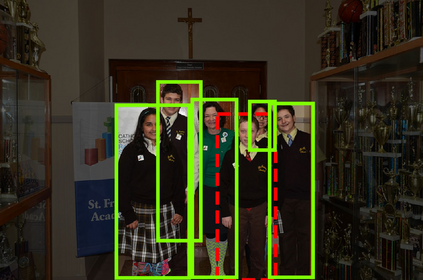

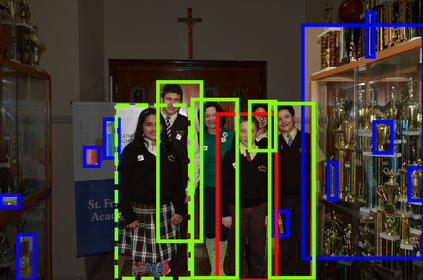

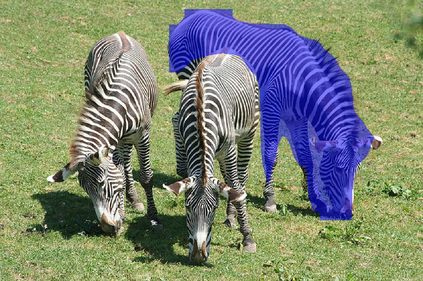

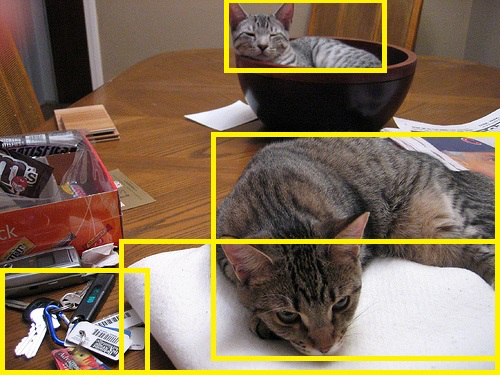

The prevailing framework for solving referring expression grounding is based on a two-stage process: 1) detecting proposals with an object detector and 2) grounding the referent to one of the proposals. Existing two-stage solutions mostly focus on the grounding step, which aims to align the expressions with the proposals. In this paper, we argue that these methods overlook an obvious mismatch between the roles of proposals in the two stages: they generate proposals solely based on the detection confidence (i.e., expression-agnostic), hoping that the proposals contain all right instances in the expression (i.e., expression-aware). Due to this mismatch, current two-stage methods suffer from a severe performance drop between detected and ground-truth proposals. To this end, we propose Ref-NMS, which is the first method to yield expression-aware proposals at the first stage. Ref-NMS regards all nouns in the expression as critical objects, and introduces a lightweight module to predict a score for aligning each box with a critical object. These scores can guide the NMS operation to filter out the boxes irrelevant to the expression, increasing the recall of critical objects, resulting in a significantly improved grounding performance. Since Ref- NMS is agnostic to the grounding step, it can be easily integrated into any state-of-the-art two-stage method. Extensive ablation studies on several backbones, benchmarks, and tasks consistently demonstrate the superiority of Ref-NMS. Codes are available at: https://github.com/ChopinSharp/ref-nms.

翻译:现有两阶段解决方案主要侧重于基础步骤,目的是使表达与建议保持一致。在本文件中,我们争辩说,这些方法忽略了两个阶段提案作用之间的明显不匹配:它们产生的提案完全基于检测信任(即表达-不可知性),希望这些提案包含表达式中的所有正确实例(即表达-觉悟),由于这种不匹配,当前两阶段方法因检测到的和地面真相建议之间的严重性能下降而受到影响。为此,我们提议了Ref-NMS,这是在第一阶段产生表达-认知建议的第一个方法。Ref-NMS将表达中的所有名词都视为关键对象,并引入一个轻度模块,以预测每个框与关键对象(即表达-觉悟)。这些分数可以指导NMS操作过滤与表达中无关的框,增加关键对象的回顾度。