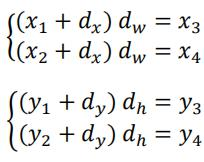

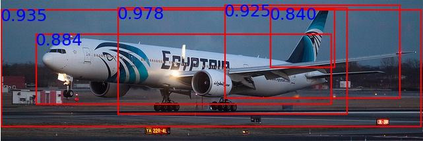

Aiming at recognizing and localizing the object of novel categories by a few reference samples, few-shot object detection (FSOD) is a quite challenging task. Previous works often depend on the fine-tuning process to transfer their model to the novel category and rarely consider the defect of fine-tuning, resulting in many application drawbacks. For example, these methods are far from satisfying in the episode-changeable scenarios due to excessive fine-tuning times, and their performance on low-quality (e.g., low-shot and class-incomplete) support sets degrades severely. To this end, this paper proposes an instant response few-shot object detector (IR-FSOD) that can accurately and directly detect the objects of novel categories without the fine-tuning process. To accomplish the objective, we carefully analyze the defects of individual modules in the Faster R-CNN framework under the FSOD setting and then extend it to IR-FSOD by improving these defects. Specifically, we first propose two simple but effective meta-strategies for the box classifier and RPN module to enable the object detection of novel categories with instant response. Then, we introduce two explicit inferences into the localization module to alleviate its over-fitting to the base categories, including explicit localization score and semi-explicit box regression. Extensive experiments show that the IR-FSOD framework not only achieves few-shot object detection with the instant response but also reaches state-of-the-art performance in precision and recall under various FSOD settings.

翻译:微小物体探测(FSOD)是相当具有挑战性的任务。以前的工作往往取决于微调过程,以便将其模型转移到新的类别,而很少考虑微调的缺陷,从而造成许多应用缺陷。例如,由于调整时间过细,这些方法在可变情况中远远不能令人满意,在可变情况中还远远不能令人满意,因为调整时间过长,而且这些方法在低质量(例如低发和级不完整)支持组的性能严重退化。为此,本文件提议了一种即时反应的微快、几发精确的物体探测器(IR-FSOD),它可以准确和直接探测新类别的对象,而无需微调过程。为了实现目标,我们仔细分析FSOD设置下更快R-CN框架中单个模块的缺陷,然后通过改进这些缺陷,将其扩大到IR-FSOD。具体地,我们首先为箱分类和RPN模块提出两种简单有效的元战略策略,以便能够立即对新对象类别进行检测。然后,我们引入两种明确的地面测试模型,包括直径分析模型,以直径分析模型,将地方化为基准。