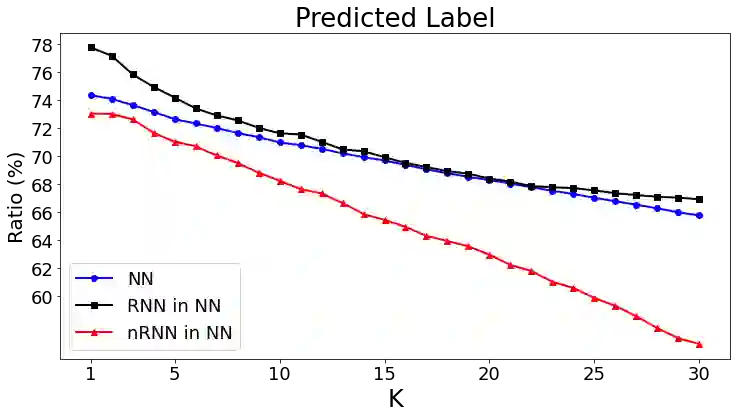

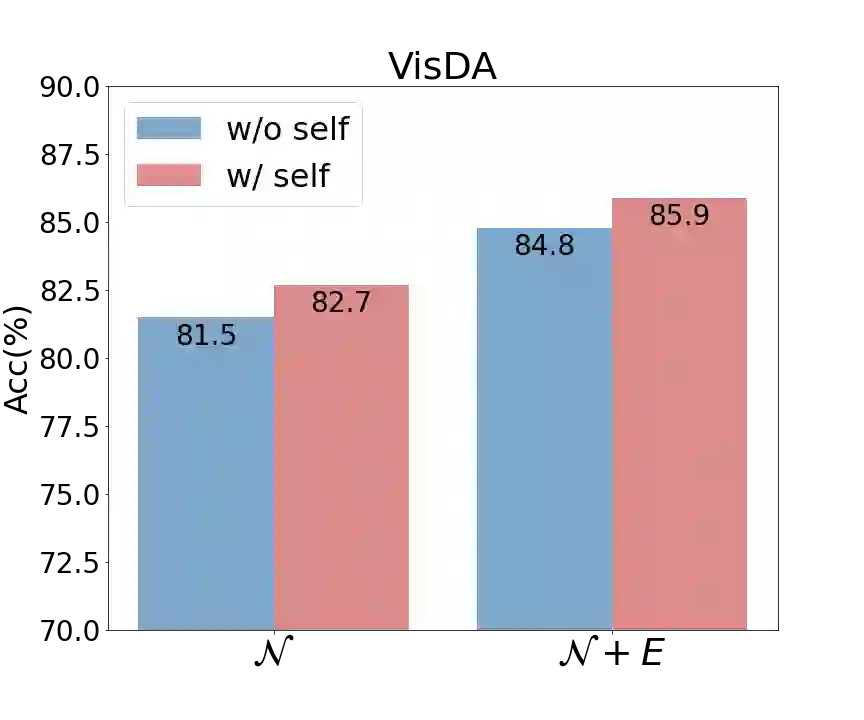

Domain adaptation (DA) aims to alleviate the domain shift between source domain and target domain. Most DA methods require access to the source data, but often that is not possible (e.g. due to data privacy or intellectual property). In this paper, we address the challenging source-free domain adaptation (SFDA) problem, where the source pretrained model is adapted to the target domain in the absence of source data. Our method is based on the observation that target data, which might no longer align with the source domain classifier, still forms clear clusters. We capture this intrinsic structure by defining local affinity of the target data, and encourage label consistency among data with high local affinity. We observe that higher affinity should be assigned to reciprocal neighbors, and propose a self regularization loss to decrease the negative impact of noisy neighbors. Furthermore, to aggregate information with more context, we consider expanded neighborhoods with small affinity values. In the experimental results we verify that the inherent structure of the target features is an important source of information for domain adaptation. We demonstrate that this local structure can be efficiently captured by considering the local neighbors, the reciprocal neighbors, and the expanded neighborhood. Finally, we achieve state-of-the-art performance on several 2D image and 3D point cloud recognition datasets. Code is available in https://github.com/Albert0147/SFDA_neighbors.

翻译:域适应 (DA) 旨在缓解源域和目标域之间的域变化。 大多数 DA 方法要求获取源数据,但往往无法获取源数据(例如由于数据隐私或知识产权)。 在本文中,我们解决了具有挑战性的无源域适应(SFDA)问题,在缺乏源数据的情况下,源预培训模式适应目标域。我们的方法基于以下观察:目标数据可能不再与源域分类器一致,但仍然形成清晰的集群。我们通过界定目标数据的地方亲近性来捕捉这一内在结构,并鼓励与当地高度亲近性的数据之间标签一致。我们观察到,应该将更高的亲近性分配给对等邻居,并提出自我正常化损失,以减少吵闹邻居的消极影响。此外,为了在没有源数据的情况下汇总信息,我们考虑扩大具有较小亲近性值的社区。在实验结果中,我们核实目标特性的固有结构是域适应的重要信息来源。我们证明,通过考虑当地邻居、对等邻居、对等邻居和扩展的邻居的邻域图像可以有效地捕捉到这一本地结构。我们观察到了这种地方结构。 我们观察到了更高的亲近性,提出自我正常化损失,并提出了减少邻居/ dusbbert CD 。 。最后,我们实现了 3- dusaxx 。 。