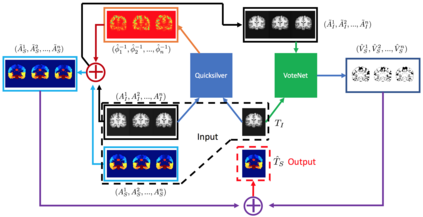

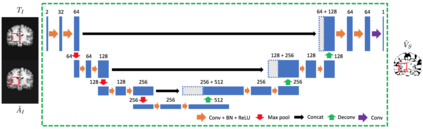

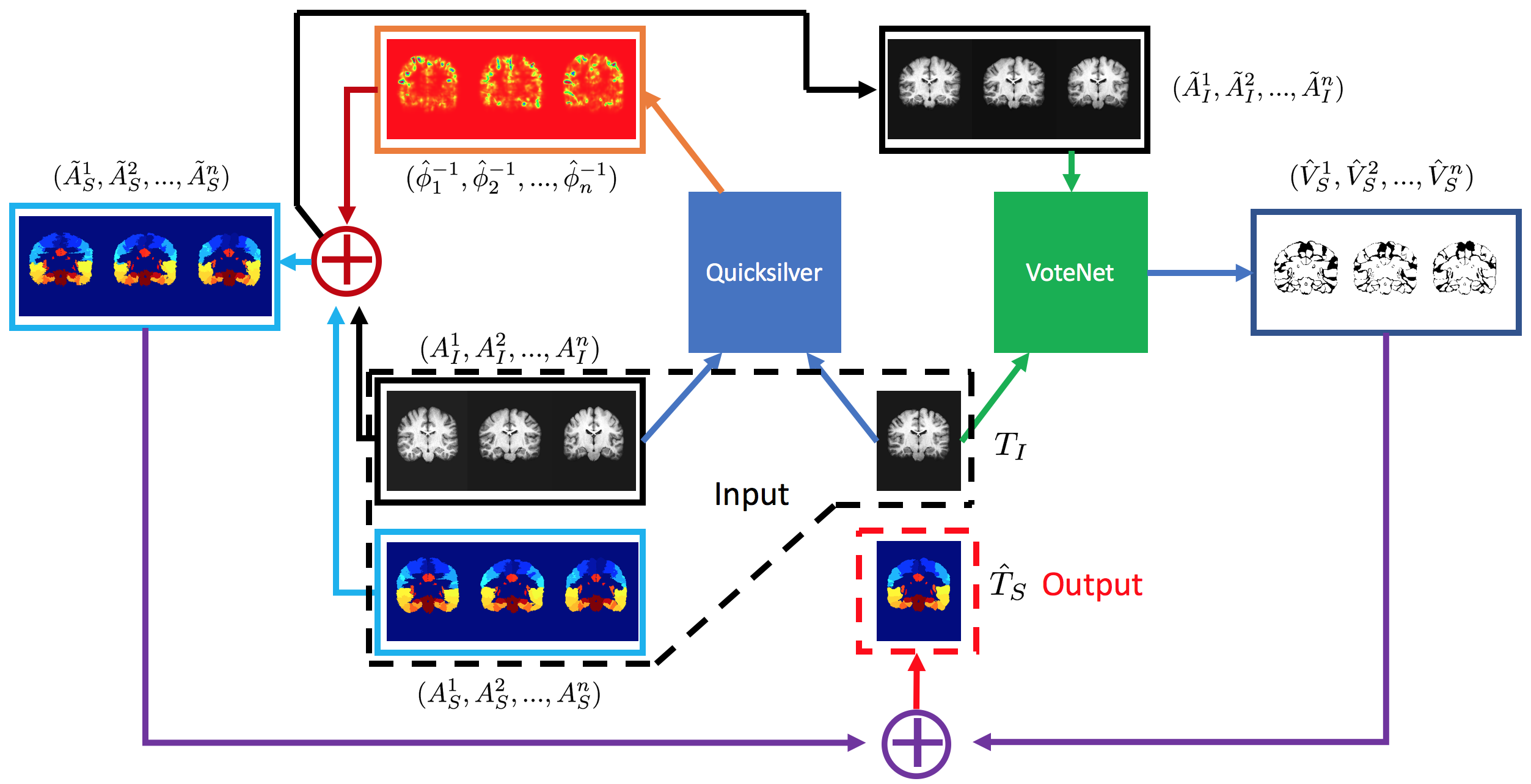

Deep learning (DL) approaches are state-of-the-art for many medical image segmentation tasks. They offer a number of advantages: they can be trained for specific tasks, computations are fast at test time, and segmentation quality is typically high. In contrast, previously popular multi-atlas segmentation (MAS) methods are relatively slow (as they rely on costly registrations) and even though sophisticated label fusion strategies have been proposed, DL approaches generally outperform MAS. In this work, we propose a DL-based label fusion strategy (VoteNet) which locally selects a set of reliable atlases whose labels are then fused via plurality voting. Experiments on 3D brain MRI data show that by selecting a good initial atlas set MAS with VoteNet significantly outperforms a number of other label fusion strategies as well as a direct DL segmentation approach. We also provide an experimental analysis of the upper performance bound achievable by our method. While unlikely achievable in practice, this bound suggests room for further performance improvements. Lastly, to address the runtime disadvantage of standard MAS, all our results make use of a fast DL registration approach.

翻译:深度学习( DL) 方法是许多医学图像分割任务的最新技术。 它们提供了许多优势: 它们可以接受特定任务的培训, 测试时间计算速度很快, 分解质量通常很高 。 相反, 以前流行的多分解( MAS) 方法相对缓慢( 因为他们依赖昂贵的注册), 尽管提出了复杂的标签融合策略, DL 方法一般都优于 MAS 。 在这项工作中, 我们提议了一个基于 DL 的标签融合战略( VoteNet ), 由本地选择一套可靠的地图, 其标签随后通过多元投票融合起来。 对 3D 大脑 MRI 数据的实验表明, 通过选择一个良好的初始地图集, 带 Potote Net 的 MAS, 大大超越了其他标签融合策略以及直接的 DL 分解方法。 我们还对通过我们的方法可以实现的最高性能进行了实验性分析。 虽然在实践上不可能实现, 但这一约束为进一步的绩效改进提供了空间。 最后, 解决标准 MASAS 的运行时的劣势, 我们所有结果都使用了快速 DL 注册方法 。