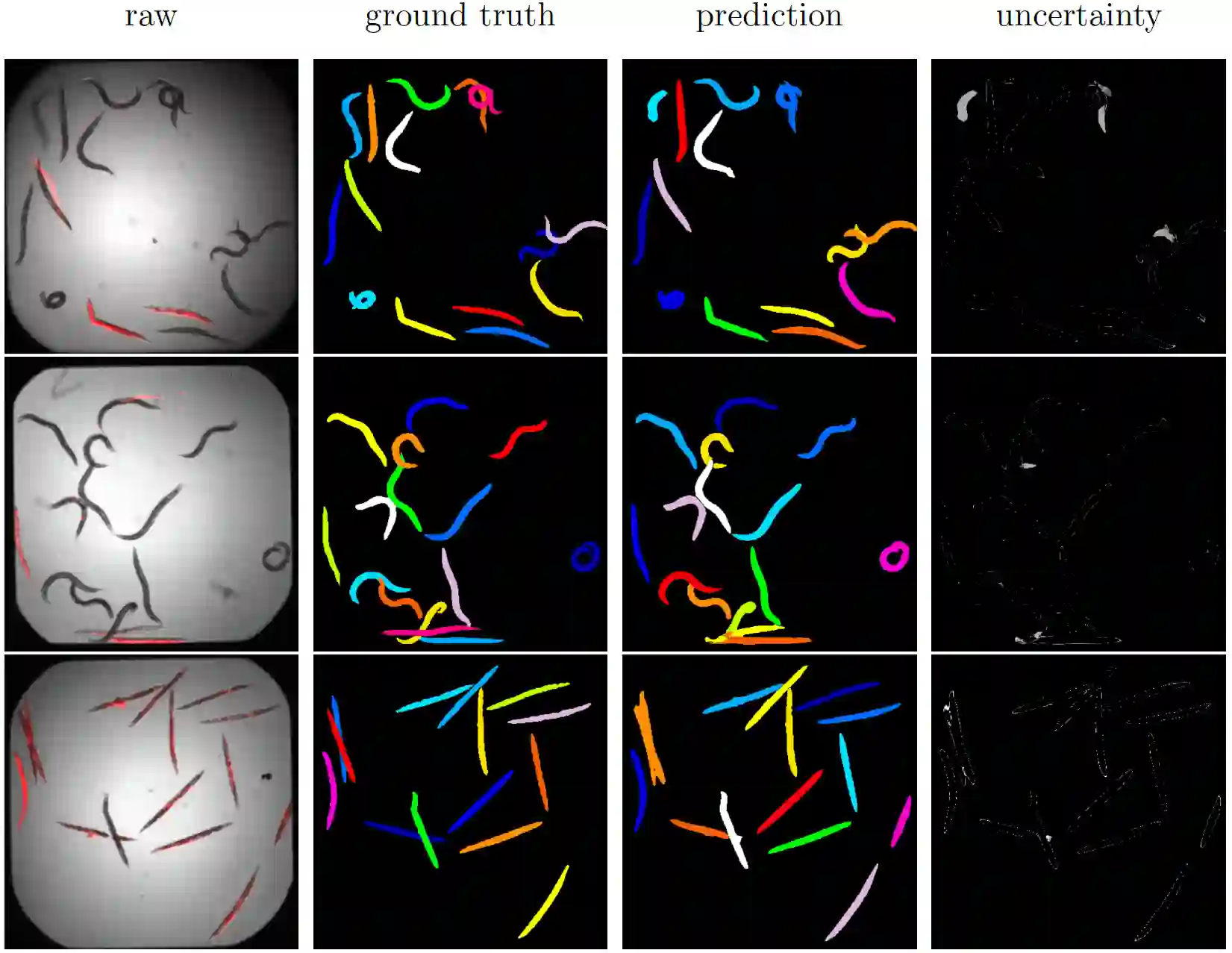

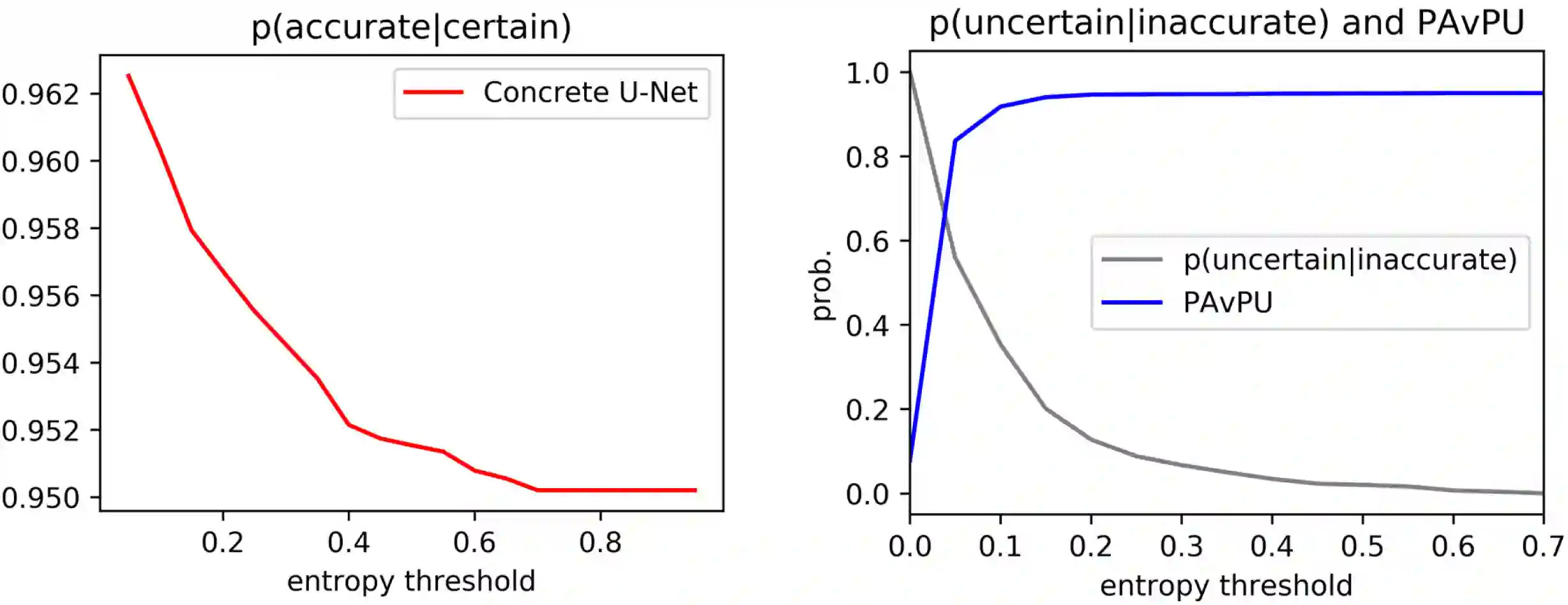

Probabilistic convolutional neural networks, which predict distributions of predictions instead of point estimates, led to recent advances in many areas of computer vision, from image reconstruction to semantic segmentation. Besides state of the art benchmark results, these networks made it possible to quantify local uncertainties in the predictions. These were used in active learning frameworks to target the labeling efforts of specialist annotators or to assess the quality of a prediction in a safety-critical environment. However, for instance segmentation problems these methods are not frequently used so far. We seek to close this gap by proposing a generic method to obtain model-inherent uncertainty estimates within proposal-free instance segmentation models. Furthermore, we analyze the quality of the uncertainty estimates with a metric adapted from semantic segmentation. We evaluate our method on the BBBC010 C.\ elegans dataset, where it yields competitive performance while also predicting uncertainty estimates that carry information about object-level inaccuracies like false splits and false merges. We perform a simulation to show the potential use of such uncertainty estimates in guided proofreading.

翻译:预测预测的分布而不是点估计的概率共振神经网络预测了预测的分布,从而导致计算机视觉的许多领域,从图像重建到语义分割等最近的进展。除了最先进的基准结果外,这些网络还使得有可能量化预测中的当地不确定性。这些网络用于积极的学习框架,针对专家说明员的标签工作,或评估在安全危急环境中预测的质量。但是,例如,到目前为止,这些方法没有经常使用分解问题。我们试图缩小这一差距,方法是提出一种通用方法,在无建议实例分割模型中获得模型性遗传不确定性估计。此外,我们用一种从语义分割中改制的参数分析不确定性估计的质量。我们评估了我们在BBBC010 C.\ elegans数据集上的方法,该数据集具有竞争性性性,同时预测了包含关于目标水平不准确性的信息的不确定性估计,例如假分裂和假合并。我们进行模拟,以显示在有指导校准中可能使用这种不确定性估计。