题目

深度残差强化学习,Deep Residual Reinforcement Learning

关键字

强化学习,残差算法,机器学习

简介

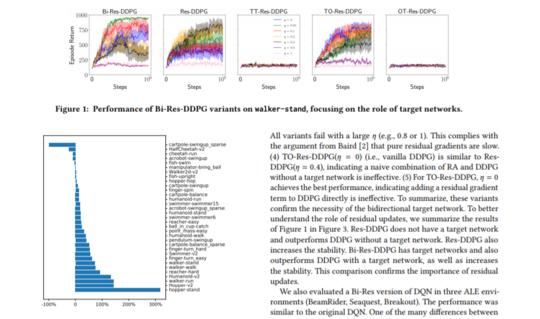

我们在无模型和基于模型的强化学习设置中重新研究残差算法。 我们建议使用双向目标网络技术来稳定残差算法,从而产生DDPG的残差版本,该版本明显优于DeepMind Control Suite基准测试中的原始DDPG。 此外,我们发现残差算法是解决基于模型的规划中分布不匹配问题的有效方法。 与现有的TD(k)方法相比,我们的基于残差的方法对模型的假设更弱,并且性能提升更大。

作者

Shangtong Zhang, Wendelin Boehmer, Shimon Whiteson,来自牛津大学

成为VIP会员查看完整内容

相关内容

强化学习(RL)是机器学习的一个领域,与软件代理应如何在环境中采取行动以最大化累积奖励的概念有关。除了监督学习和非监督学习外,强化学习是三种基本的机器学习范式之一。

强化学习与监督学习的不同之处在于,不需要呈现带标签的输入/输出对,也不需要显式纠正次优动作。相反,重点是在探索(未知领域)和利用(当前知识)之间找到平衡。

该环境通常以马尔可夫决策过程(MDP)的形式陈述,因为针对这种情况的许多强化学习算法都使用动态编程技术。经典动态规划方法和强化学习算法之间的主要区别在于,后者不假设MDP的确切数学模型,并且针对无法采用精确方法的大型MDP。