【泡泡一分钟】分段刚体运动的多帧场景流(3dv-59)

每天一分钟,带你读遍机器人顶级会议文章

标题:Multiframe Scene Flow with Piecewise Rigid Motion

作者:Vladislav Golyanik, Kihwan Kim, Robert Maier, Matthias Nießner, Didier Stricker, and Jan Kautz

来源:3dv 2017 ( International Conference on 3D Vision)

播音员:糯米

编译:陈建华 周平 (83)

欢迎个人转发朋友圈;其他机构或自媒体如需转载,后台留言申请授权

摘要

在本文中,作者引入了一种新的多帧场景流方法,该方法联合优化了RGB-D图像序列的斑块外观与局部刚体运动的一致性。与同类竞争方法相比,作者充分利用了参考帧过分割与鲁棒优化技术两方面的优势。

作者将场景流的恢复公式化成一个全局非线性最小二乘问题,并且通过一种阻尼高斯-牛顿方法进行迭代求解。通过上述方法对基于RGB-D图像序列的场景流估计进行定性分析,其准确性达到了新的高度,并且存在实时运行的可能性。

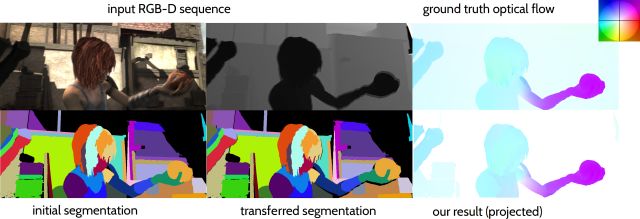

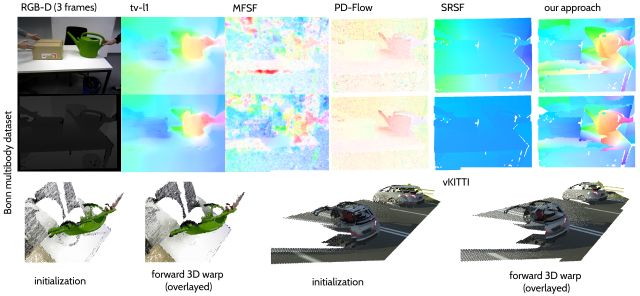

图1 多帧场景流方法的示意图

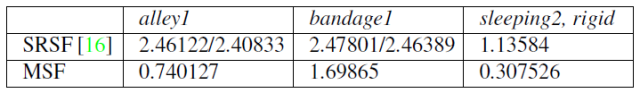

图2 多帧场景流与同类方法的准确性与实时性对比

作者的方法可以处理刚体、分段刚体、铰接和适度的非刚体运动等具有挑战性的场景,并且不依赖于关于运动与变形类型的先验知识。此外,作者通过合成数据集以及真实数据集进行了大量的试验,表明了所提出的方法性能超过了目前的主流方法。

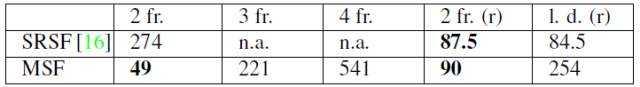

图3 合成数据集仿真测试结果

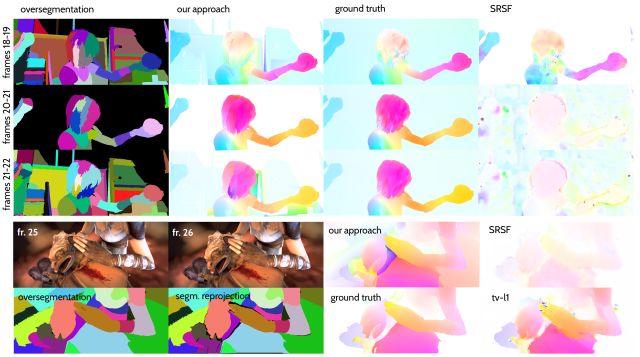

图4 真实数据集仿真测试结果

Abstract

We introduce a novel multiframe scene flow approach that jointly optimizes the consistency of the patch appearances and their local rigid motions from RGB-D image sequences. In contrast to the competing methods, we take advantage of an oversegmentation of the reference frame and robust optimization techniques. We formulate scene flow recovery as a global non-linear least squares problem which is iteratively solved by a damped Gauss-Newton approach. As a result, we obtain a qualitatively new level of accuracy in RGB-D based scene flow estimation which can potentially run in real-time. Our method can handle challenging cases with rigid, piecewise rigid, articulated and moderate non-rigid motion, and does not rely on prior knowledge about the types of motions and deformations. Extensive experiments on synthetic and real data show that our method outperforms state-of-the-art.

如果你对本文感兴趣,想要下载完整文章进行阅读,可以关注【泡泡机器人SLAM】公众号(paopaorobot_slam)。

链接: https://pan.baidu.com/s/1FXZGDNW8A_yBzbvF3587nQ 密码: zre1

泡泡机器人SLAM的原创内容均由泡泡机器人的成员花费大量心血制作而成,希望大家珍惜我们的劳动成果,转载请务必注明出自【泡泡机器人SLAM】微信公众号,否则侵权必究!同时,我们也欢迎各位转载到自己的朋友圈,让更多的人能进入到SLAM这个领域中,让我们共同为推进中国的SLAM事业而努力!

商业合作及转载请联系liufuqiang_robot@hotmail.com