【泡泡图灵智库】实时同步事件立体相机(ECCV)

泡泡图灵智库,带你精读机器人顶级会议文章

标题:Realtime Time Synchronized Event-based Stereo

作者:Alex Zihao Zhu, Yibo Chen, and Kostas Daniilidis

来源:ECCV 2018

编译:李鑫

审核:夏友杰

欢迎个人转发朋友圈;其他机构或自媒体如需转载,后台留言申请授权

摘要

大家好,今天为大家带来的文章是——实时同步事件立体相机,该文章发表于ECCV 2018。

本文提出了一种新的基于事件的立体方法,解决了运动事件相机的运动模糊问题。本文提出的方法使用摄像机的速度和一定范围的视差来同步事件的位置,使得它们就好像是在一个时间点被捕获的。使用了一对新的时间同步事件视差量来表示这些事件,并且展示了在正确视差的情况下为像素移除运动模糊,而在错误视差的情况下进一步模糊像素。然后在这些同步事件视差量上应用了一种新的匹配代价函数,它既奖励了这些视差量之间的相似性,又惩罚了模糊性。最后通过对多车辆立体事件摄像机数据集的评估,表明本文的方法优于更耗资源的基于平滑的事件立体方法。

主要贡献

1、一种利用摄像机速度产生时间同步事件视差量的新方法,在这种方法中,视差正确区域处于聚焦状态,而视差错误区域处于模糊状态。

2、一种新的基于块匹配的代价函数,在事件视差量上,奖励相似的左右区块,同时惩罚模糊的区块。

3、对多车辆立体事件摄像机数据集进行评估,并与其他最先进的方法进行比较,同时还对本文提出的方法的各个组成部分进行评估。

算法流程

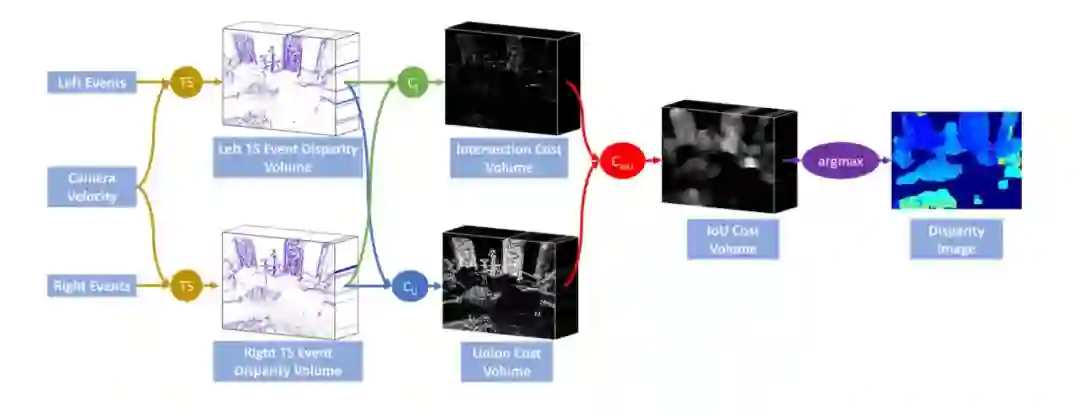

图1 本文方法的概述

1、通过差值实现同步

假设相机速度已知,对于给定的视差d,可以使用运动场方程近似光流。 运动场方程描述了摄像机的线速度(v)和角速度(ω),点(x,y)的深度Z之间的关系,我们在此将其视为视差d和图像中点的运动的函数,我们近似为光流( ẋi,ẏi ):

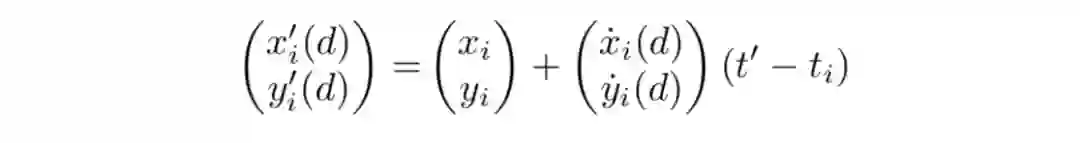

假设每个像素的光流在每个时间窗内是恒定的,那么可以使用线性插值法估计在恒定时间t'产生事件(xi,yi,ti,pi)的点的位置:

2、生成同步时间事件视差量

但是,对于此问题,每个像素的真实深度是未知的。 因此,选择要搜索的视差范围,并对该范围内的每个差异应用来自上一部分的来自左摄像机的事件集。

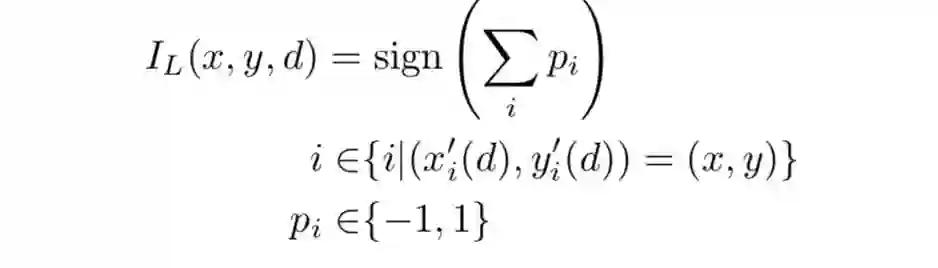

在每个视差水平d,基于时移事件生成图像,其中具有更多正事件的像素被设置为1,更多负事件被设置为-1,没有事件被设置为0。注意,需要将时移事件位置取整到最接近的整数索引到图像中。

3、 匹配代价(matching cost)

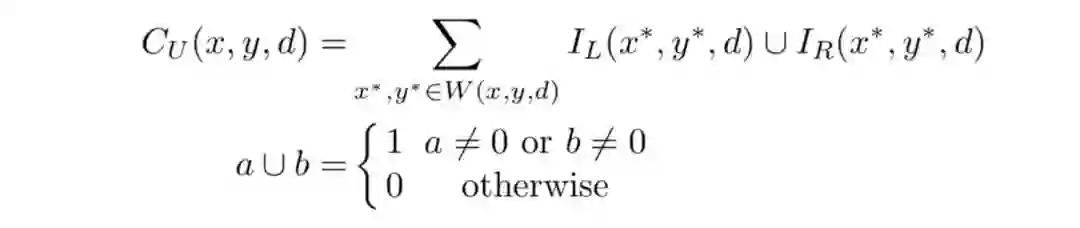

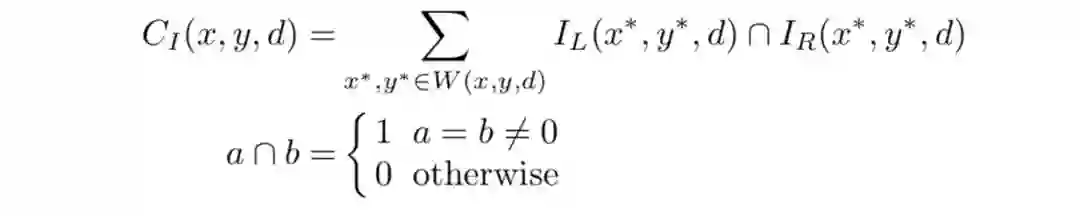

最后,作者应用了一种新颖的滑动窗口匹配代价,同时利用了部分1的去模糊和模糊效果。首先,它惩罚有许多事件的窗口,这将找到由于时间插值引起的模糊而具有不正确视差的区域。 给定在给定视差d处的像素(x,y)周围的局部空间窗口W(x,y,d),使用联合项对其进行编码,定义为:

然后,代价奖励窗口相似。 也就是说,希望两个图像之间的像素具有相同极性的事件。 使用交叉项对此进行编码,定义为:

最终的代价可以被认为是与联合代价上的交集类似:

4、 视差估计

给定代价量,获得每个像素的真实差异估计的最快方法是计算代价量的差异维度上的argmax:

5、 剔除外点

虽然代价函数在实验中相对稳健,但仍然有一些图像区域无法解决正确的差异,需要从最终输出中删除。

主要结果

1、 数据

作者在多车辆立体事件相机(MVSEC)数据集上评估了本文的算法。 MVSEC提供从立体事件摄像机捕获的数据、灰度图像、地面实况深度以及摄像机的位姿。

表1:测试TSES(本文的方法)和CopNet的室内飞行(IF)序列以及消融研究的定量结果。 算法消融的前缀:IoU-联合成本,I-交叉成本,T-时间成本。 后缀代表的是(S)有和(NS)没有时间同步。 速度噪声分别加到线速度和角速度上,作为零均值高斯噪声,方差为每个速度范数的百分比。

2、比较

为了便于比较,作者实现了Piatkowska等人的CopNet方法。并使用他们提供的参数将他们的结果包含在同一数据集中。此外,作者将OpenCV2的块匹配和半全局块匹配方法进行比较,应用于DAVIS相机的灰度帧。值得一提的是,灰度帧不是时间同步的,左右帧之间的时间偏移分别为4ms,14ms和14ms。但是,本文方法仍然能够取得合理的表现。这些比较的定量结果可以在表1中找到。

3、消融研究

除了比较,作者还对算法进行了大量的消融研究,所有结果见表1。

Abstract

In this work, we propose a novel event based stereo method which addresses the problem of motion blur for a moving event camera. Our method uses the velocity of the camera and a range of disparities to synchronize the positions of the events, as if they were captured at a single point in time. We represent these events using a pair of novel time synchronized event disparity volumes, which we show remove motion blur for pixels at the correct disparity in the volume, while further blurring pixels at the wrong disparity. We then apply a novel matching cost over these time synchronized event disparity volumes, which both rewards similarity between the volumes while penalizing blurriness. We show that our method outperforms more expensive, smoothing based event stereo methods, by evaluating on the Multi Vehicle Stereo Event Camera dataset.

如果你对本文感兴趣,想要下载完整文章进行阅读,可以关注【泡泡机器人SLAM】公众号。

点击阅读原文,即可获取本文下载链接。

欢迎来到泡泡论坛,这里有大牛为你解答关于SLAM的任何疑惑。

有想问的问题,或者想刷帖回答问题,泡泡论坛欢迎你!

泡泡网站:www.paopaorobot.org

泡泡论坛:http://paopaorobot.org/bbs/

泡泡机器人SLAM的原创内容均由泡泡机器人的成员花费大量心血制作而成,希望大家珍惜我们的劳动成果,转载请务必注明出自【泡泡机器人SLAM】微信公众号,否则侵权必究!同时,我们也欢迎各位转载到自己的朋友圈,让更多的人能进入到SLAM这个领域中,让我们共同为推进中国的SLAM事业而努力!

商业合作及转载请联系liufuqiang_robot@hotmail.com