从近年顶会论文看领域自适应(Domain Adaptation)最新研究进展

©PaperWeekly 原创 · 作者 | 张一帆

学校 | 中科院自动化所博士生

研究方向 | 计算机视觉

论文标题:

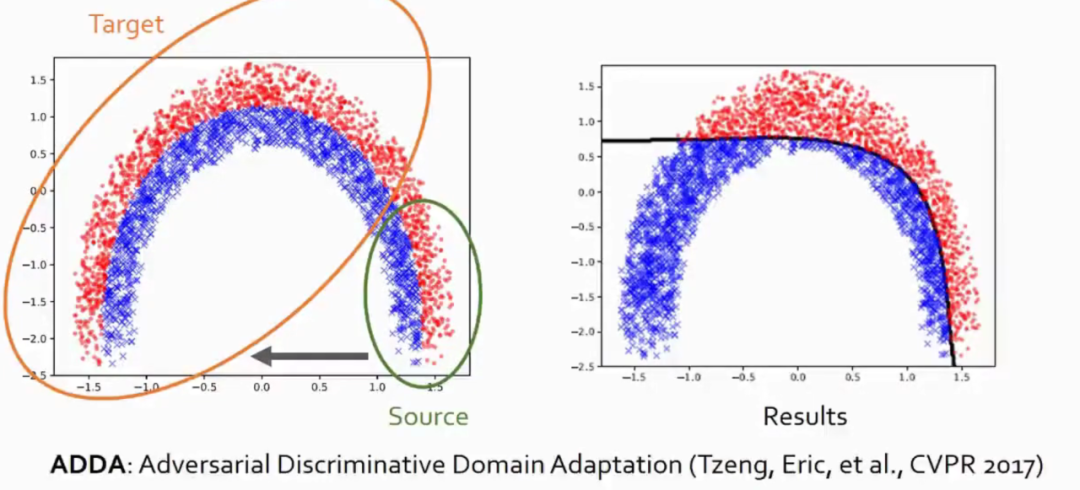

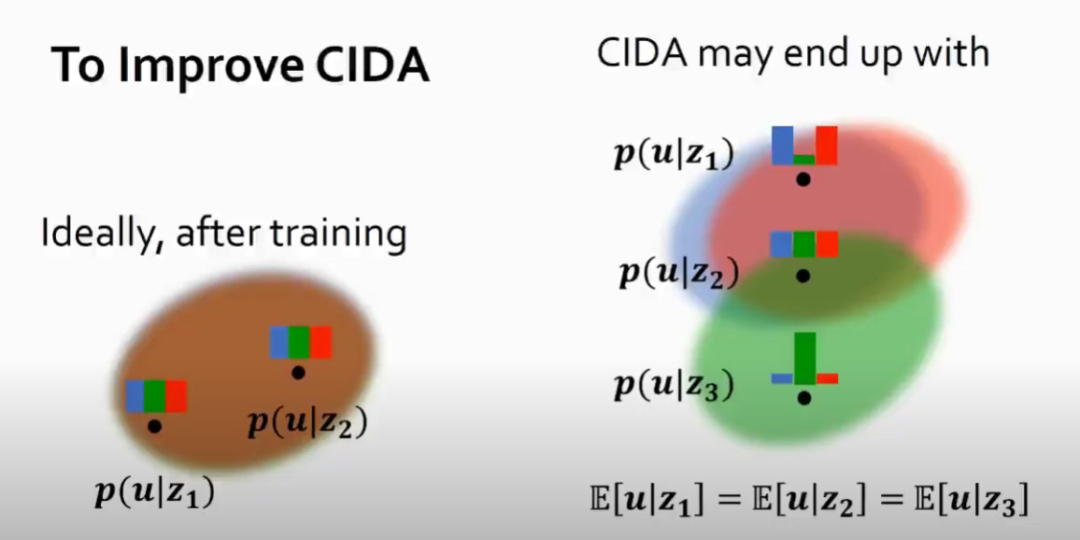

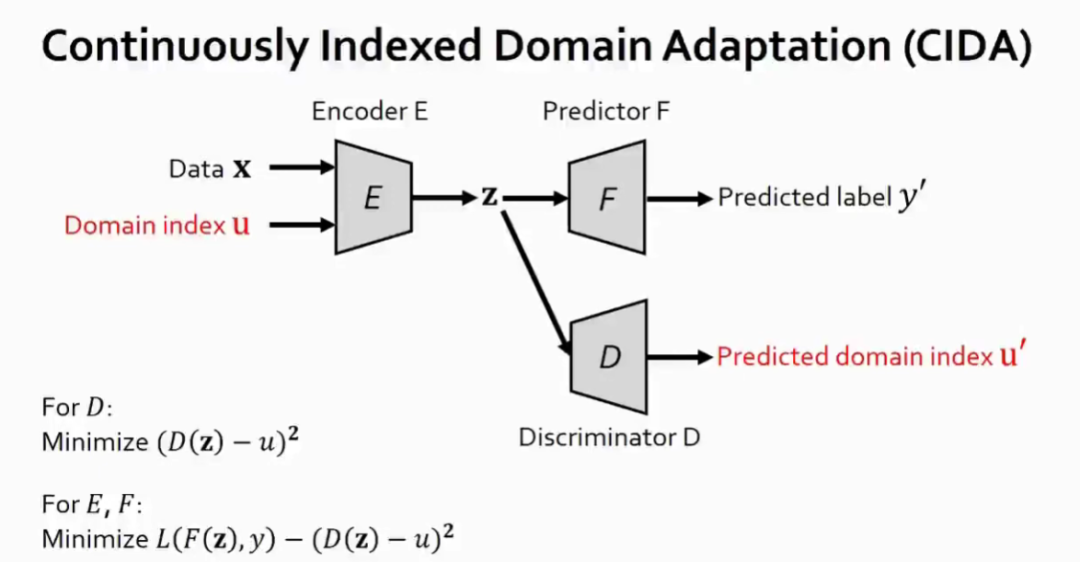

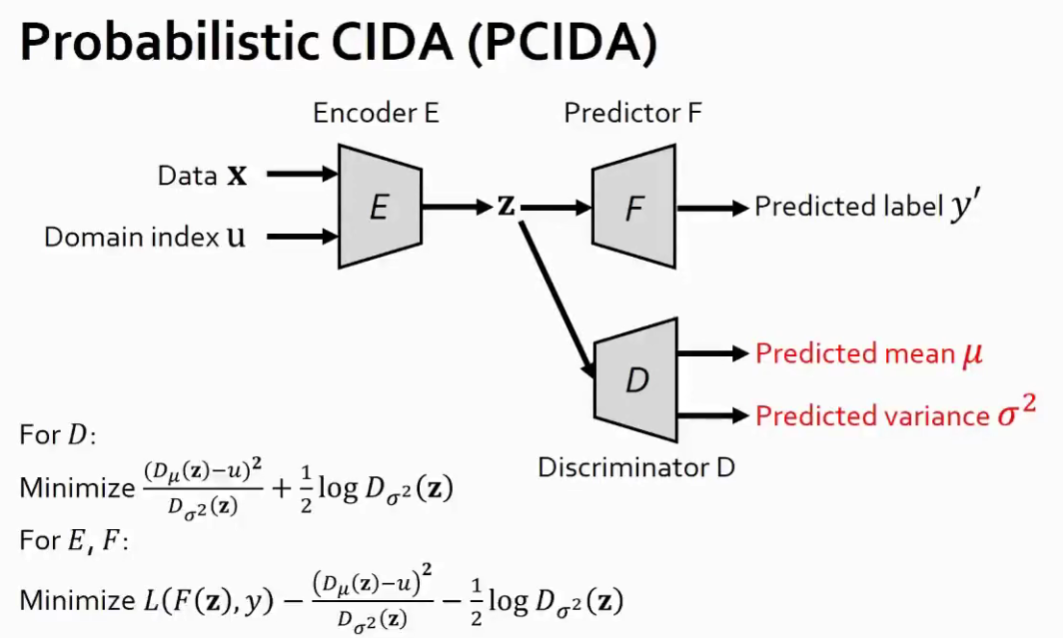

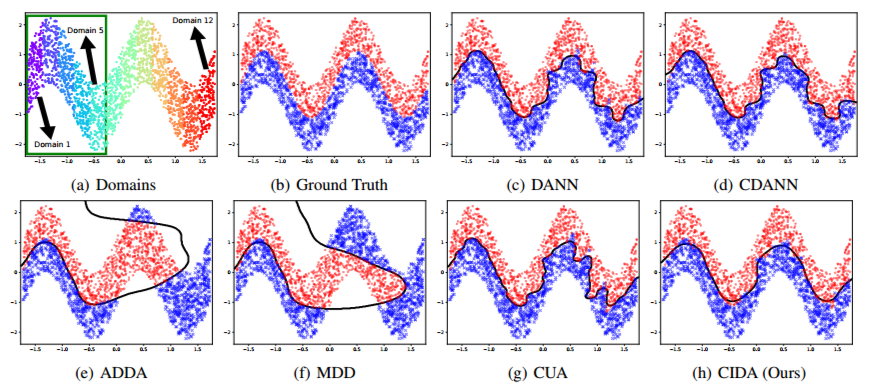

Continuously Indexed Domain Adaptation

ICML 2020 Oral

https://arxiv.org/abs/2007.01807

https://github.com/hehaodele/CIDA

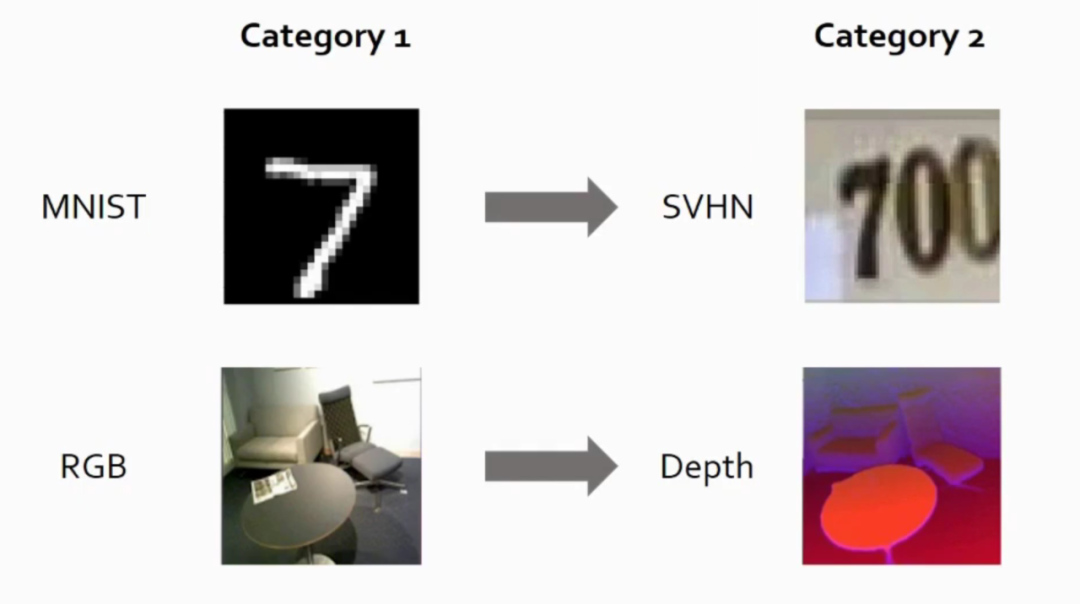

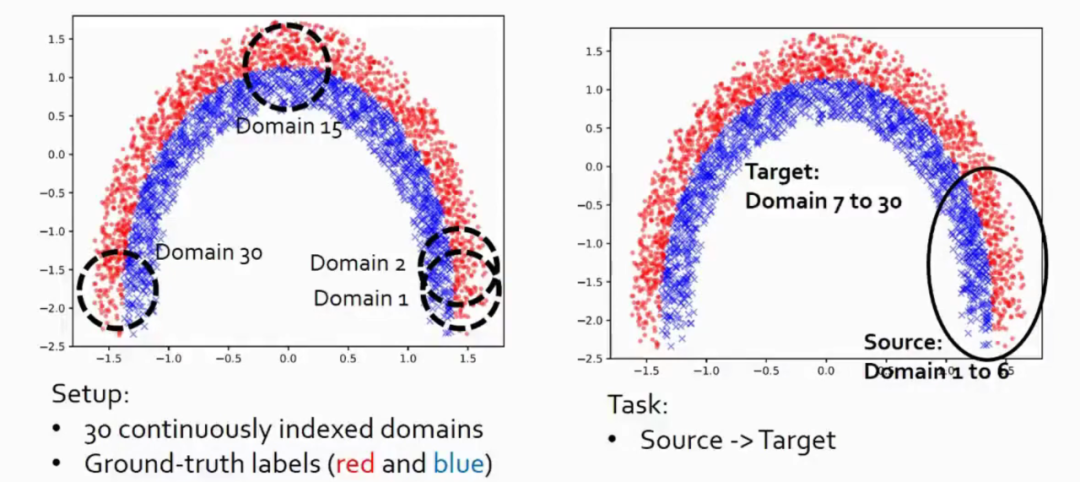

很多实际问题包含了连续变化的 domain,在医药领域,domain 可以是用户的年龄,这是一个连续的值,在自动驾驶领域场景的变化从白天到黑夜,是一个连续的过程。

本文的理论贡献主要有三点:

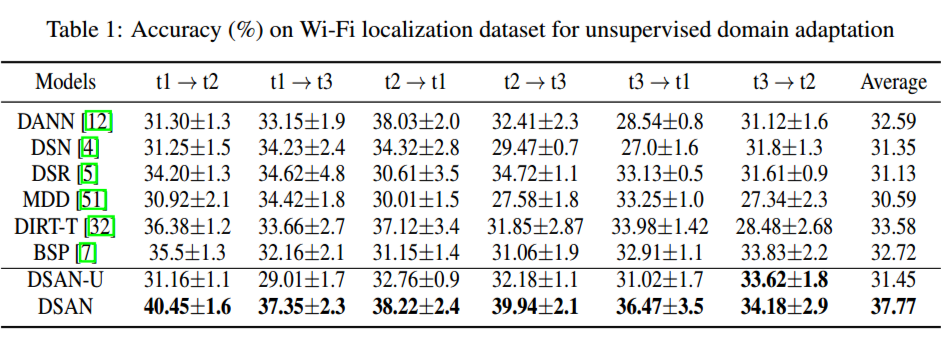

DSAN

论文标题:

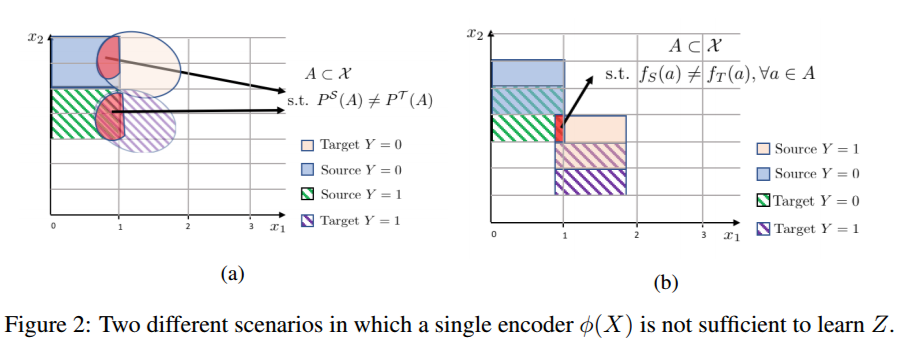

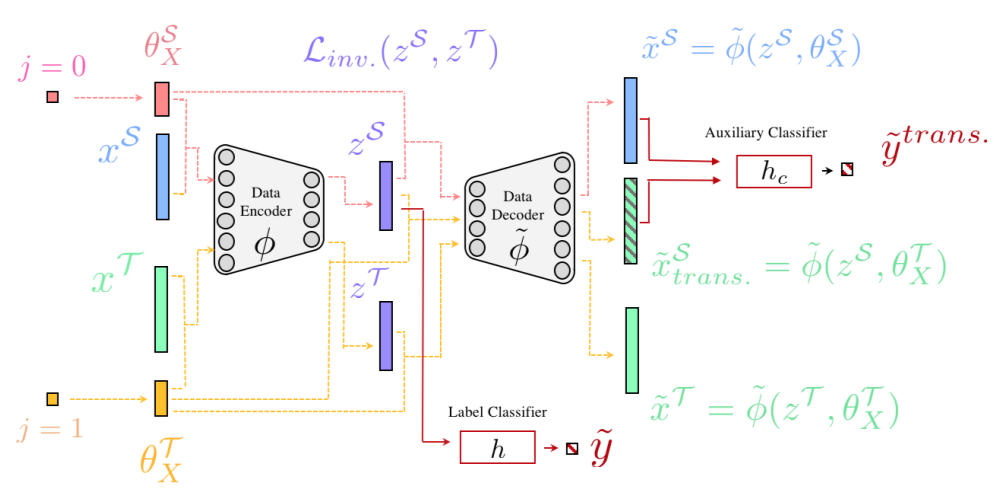

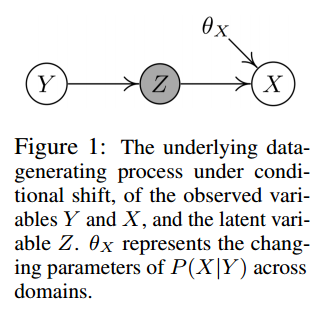

Domain Adaptation with Invariant Representation Learning: What Transformations to Learn?

NeurIPS 2021

https://openreview.net/pdf?id=zdmF437BCB

https://github.com/DMIRLAB-Group/DSAN

本文给出了他们的解决方案,与传统工作的不同点在于:

3. 不同的 domain 对应不同的 encoder。

论文标题:

Gradual Domain Adaptation without Indexed Intermediate Domains

NeurIPS 2021

https://papers.nips.cc/paper/2021/file/45017f6511f91be700fda3d118034994-Paper.pdf

https://github.com/hongyouc/IDOL

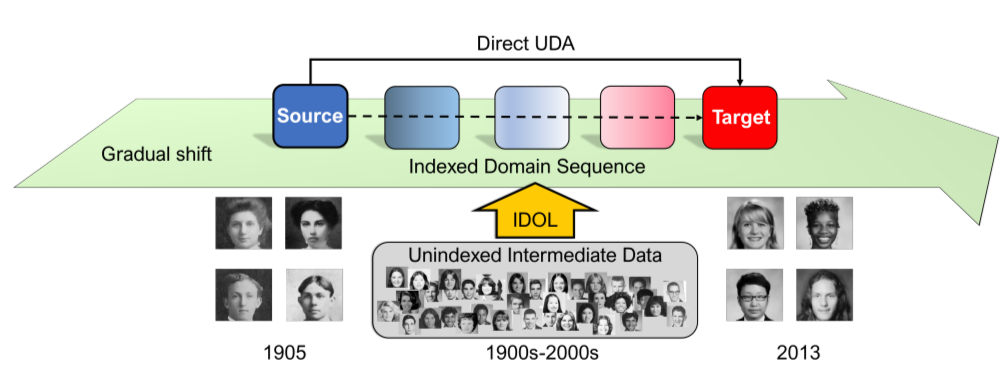

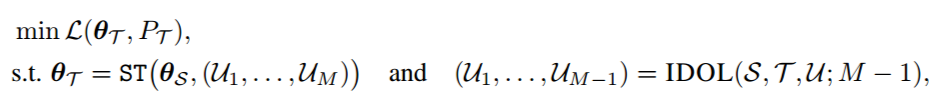

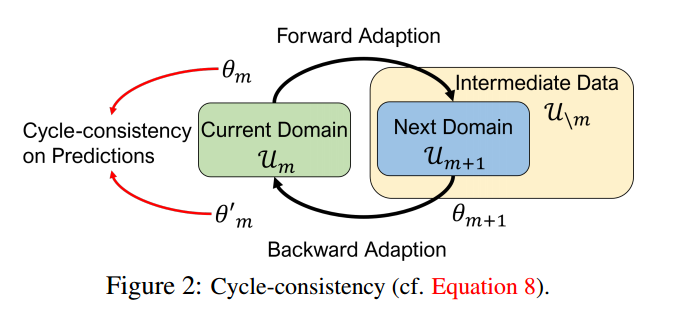

要直接完成这个任务是非常困难的,因为评估预测的多个域标签需要将整个流程跑一遍。因此本文提出了一个渐进式的解决方案:

Implicit Semantic Response Alignment

论文标题:

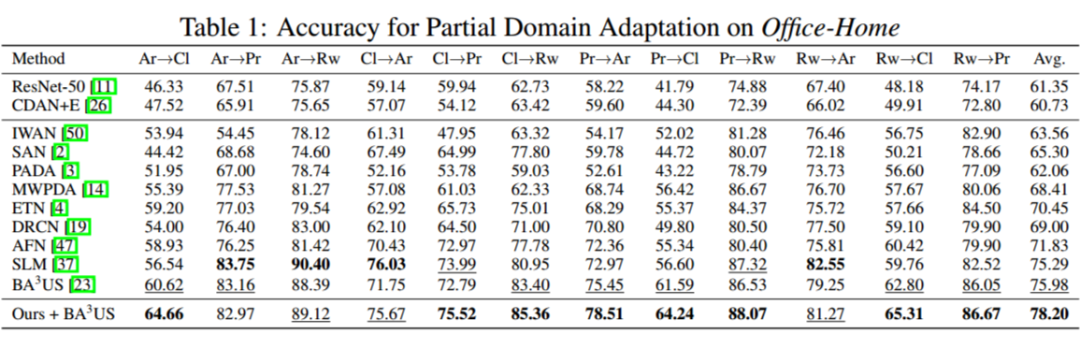

Implicit Semantic Response Alignment for Partial Domain Adaptation

NeurIPS 2021

https://papers.nips.cc/paper/2021/file/731b03008e834f92a03085ef47061c4a-Paper.pdf

https://github.com/implicit-seman-align/implicit-semantic-response-alignment

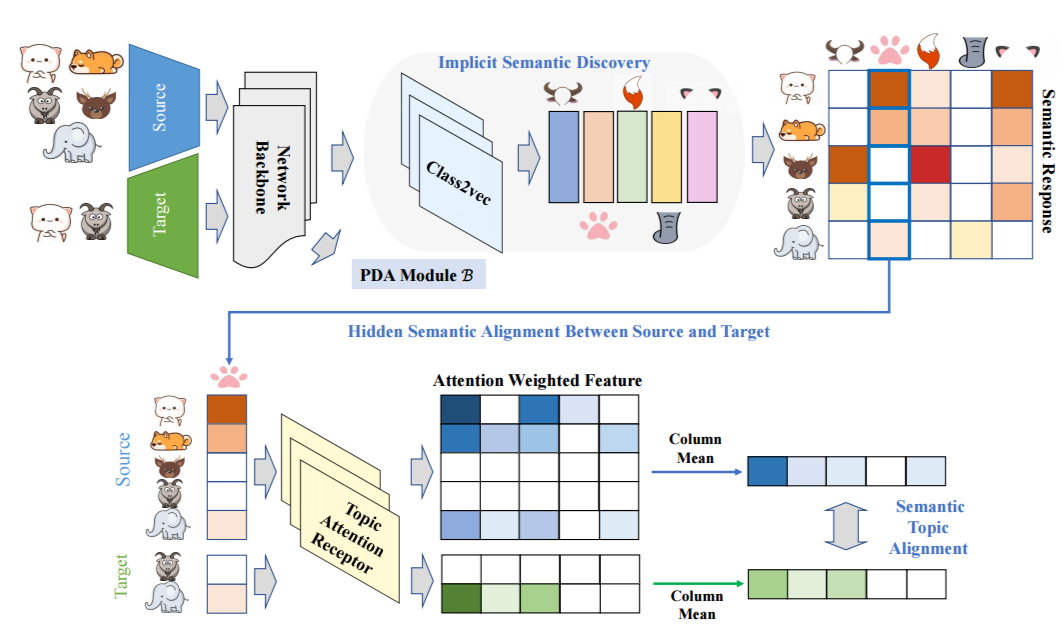

Partial Domain Adaptation(PDA)即目标域的标签是源域标签的一部分,目前的大多数工作旨在对源域进行加权以减小标签的不一致,本文相信来自这些额外类别的样本仍然包含有价值的信息,可以促进 PDA。例如,猫和狗有明显的区分等级的特征;然而,它们也有许多共同的语义信息,包括皮毛、四条腿等等。因此,本文期望通过隐式语义来探讨不同类别之间的关系,并实现语义层次的对齐。

主要分为如下几步:

1. implicit semantic discovery:将图像通过一个 class2vec 模块转化为一系列的语义信息(直观来看就是一组 embedding,每一个 embedding 对应一种语义信息),这里通过一个 auto-encoder 的重构方式来训练 class2vec 模块;

2. Topic attention reception:为了得到我们 backbone 特征和这些语义信息的关系,这里使用一个 attention 模块将计算每个特征对每个语义信息的相应(一个权重),因此我们就可以得到每一个特征对语义信息们的权重向量(mask);

3. Semantic topic alignment:使同一语义对应的 src mask 和 tgt mask 向量尽可能相似,这使我们的模型能够从特定语义上具有相似度的额外类中迁移样本所包含的相关语义信息。

BPDA

收录会议:

论文链接:

代码链接:

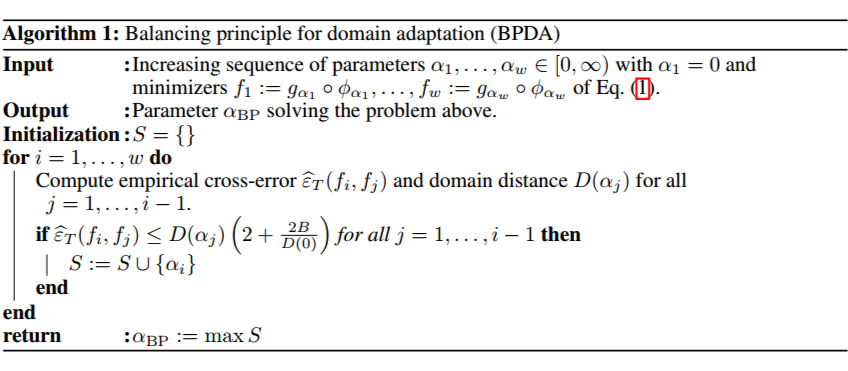

传统 UDA 算法通常由一个分类损失和一个正则化损失组成,但是如何选择二者的 tradeoff parameter 是一个仍未解决的问题,因为我们并没有 tgt domain 的 label,因此无法对每个参数带来的性能进行验证,在实验中现有工作往往将其作为一个超参数。本文从理论出发,找到了一个设置最优 tradeoff parameter 的方法。

特别鸣谢

感谢 TCCI 天桥脑科学研究院对于 PaperWeekly 的支持。TCCI 关注大脑探知、大脑功能和大脑健康。

更多阅读

#投 稿 通 道#

让你的文字被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧