【导读】最近小编推出CVPR2019图卷积网络、CVPR2019生成对抗网络、【可解释性】,CVPR视觉目标跟踪,CVPR视觉问答,医学图像分割,图神经网络的推荐相关论文,反响热烈。最近,Domain Adaptation(域自适应)相关研究非常火热,一部分也是由于GAN、GNN以及其他一些的网络结构的启发,基于Domain Adaptation的工作在今年CVPR 2019上出现了大量的论文。今天小编专门整理最新九篇Domain Adaptation(域自适应)—类别级对抗、域对称网络、可迁移原型网络、可迁移原型网络、通用域自适应等。

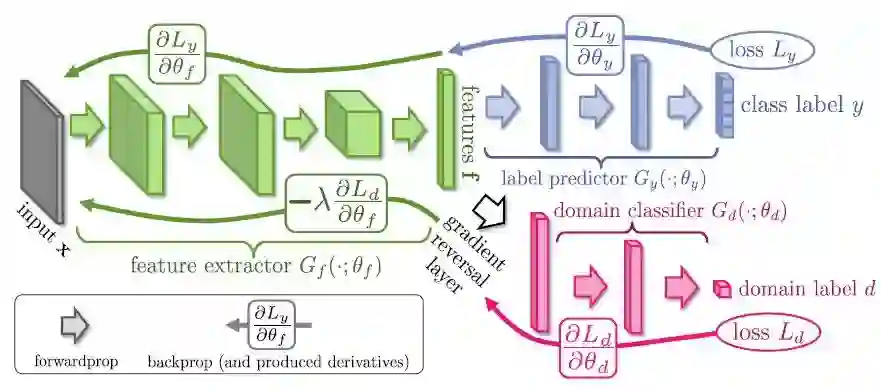

DANN-梯度反转层

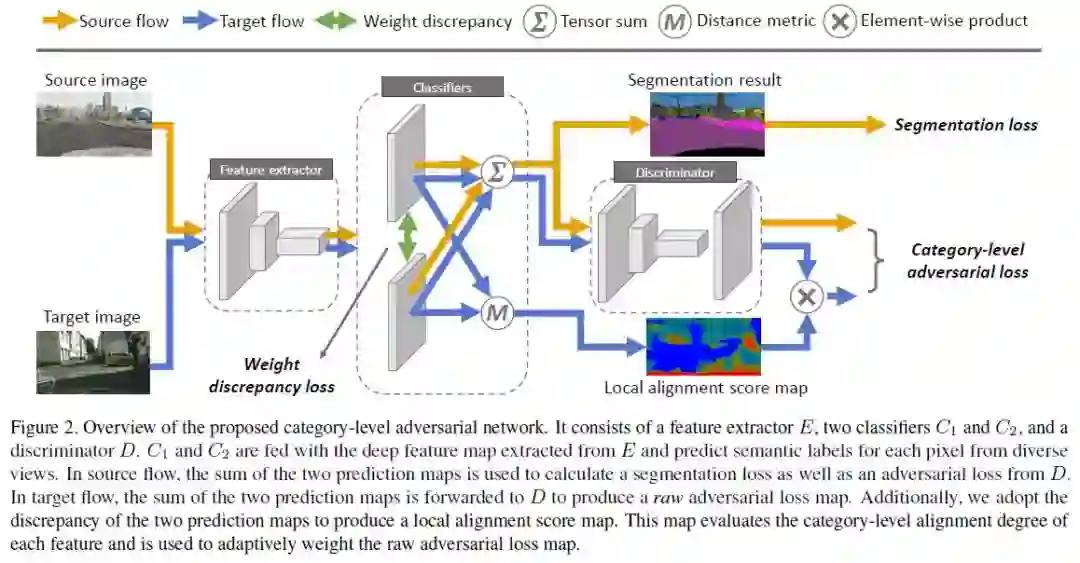

1、Taking A Closer Look at Domain Shift: Category-level Adversaries for Semantics Consistent Domain Adaptation(域迁移: 类别级对抗用于语义一致的域自适应)

CVPR ’19 Oral

作者:Yawei Luo, Liang Zheng, Tao Guan, Junqing Yu, Yi Yang

摘要:我们考虑了语义分割中的无监督域自适应问题。该任务的关键在于减少域迁移,即,强制两个域的数据分布相似。一种流行的策略是通过对抗学习来对齐特征空间的边缘分布。但是,这种全局对齐策略不考虑局部类别的特征分布。全局迁移的一个可能结果是,一些原本在源域和目标域之间很好地对齐的类别可能被错误地映射。为了解决这一问题,本文引入了一种类别级的对抗网络,旨在在全局对齐的趋势下增强局部语义一致性。我们的想法是仔细研究类级别的数据分布,并将每个类与自适应的对抗损失对齐。具体地说,我们减少了类级别对齐特征的对抗性损失的权重,同时增加了对齐较差的特征的对抗性。在这个过程中,我们通过一种联合训练方法来决定一个特征在源域和目标域之间的类别级对齐程度。在两个领域适应任务中,即GTA5 - > Cityscapes和SYNTHIA - > Cityscapes,我们验证所提出的方法在分割准确性方面与现有技术相匹配。

网址:

https://arxiv.org/abs/1809.09478

代码链接:

https://github.com/RoyalVane/CLAN

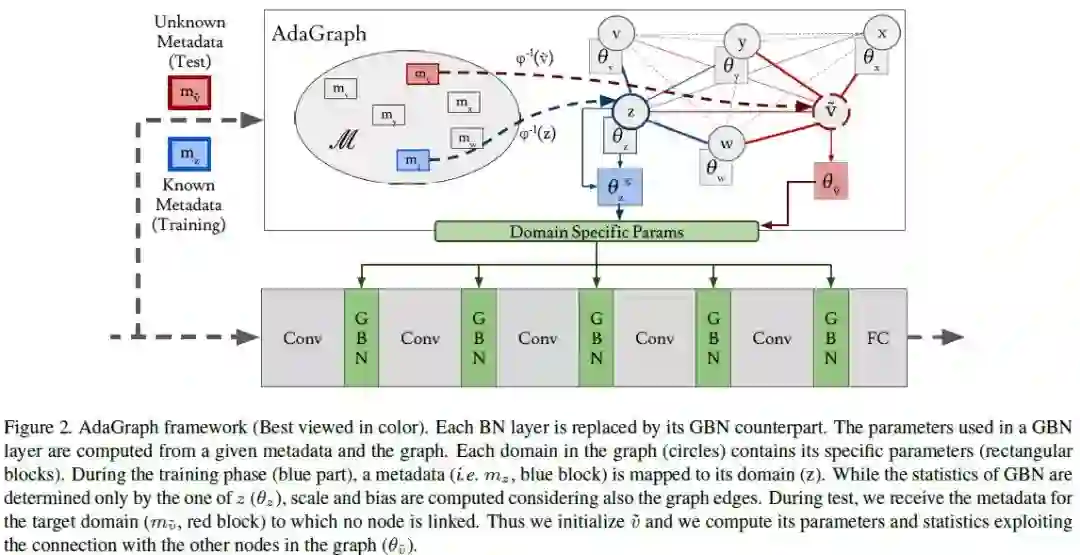

2、AdaGraph: Unifying Predictive and Continuous Domain Adaptation through Graphs(AdaGraph: 通过图形统一预测和连续域自适应)

CVPR ’19 Oral

作者:Massimiliano Mancini, Samuel Rota Bulò, Barbara Caputo, Elisa Riccici

摘要:分类能力是视觉智能的基石,也是人工自主视觉机器的关键功能。 如果没有能够适应和概括跨视域的算法,这个问题将永远无法解决。在域自适应和泛化的背景下,本文重点研究预测域自适应场景,即没有目标数据可用的情况下,系统必须学习从带注释的源图像和来自辅助域的带关联元数据的未标记样本进行泛化。我们的贡献是第一个解决预测域适应的深层架构,能够通过图利用辅助域带来的信息。此外,我们提出了一种简单而有效的策略,允许我们在测试时在连续的域适应场景中利用传入的目标数据。在三个基准数据库上的实验支持验证了我们的方法的价值。

网址:

https://arxiv.org/abs/1903.07062

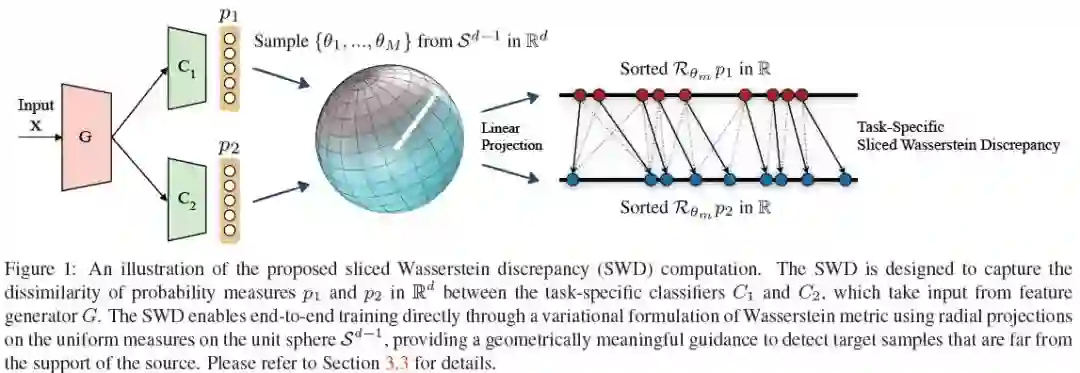

3、Sliced Wasserstein Discrepancy for Unsupervised Domain Adaptation(基于Sliced Wasserstein Discrepancy的无监督域自适应)

CVPR ’19

作者:Chen-Yu Lee, Tanmay Batra, Mohammad Haris Baig, Daniel Ulbricht

摘要:在这项工作中,我们将两个不同的无监督域自适应概念连接起来:利用特定于任务的决策边界和Wasserstein度量在域之间进行特征分布对齐。我们提出的Sliced Wasserstein Discrepancy (SWD)旨在捕捉任务特定分类器输出之间的自然差异概念。它提供了一个几何上有意义的指导来检测远离源支持的目标样本,并以端到端可训练的方式实现有效的分布对齐。在实验中,我们验证了该方法在数字和符号识别、图像分类、语义分割和目标检测等方面的有效性和通用性。

网址:

https://arxiv.org/abs/1903.04064

4、Domain-Symmetric Networks for Adversarial Domain Adaptation(用于对抗域自适应的域对称网络)

CVPR ’19

作者:Yabin Zhang, Hui Tng, Kui Jia, Mingkui Tan

摘要:无监督域自适应是在给定源域上有标记样本训练数据的情况下,学习目标域上未标记样本的分类器模型。最近,通过对深度网络的域对抗训练来学习不变特征,取得了令人瞩目的进展。尽管近年来的研究取得了一定的进展,但域自适应在较细类别水平上实现特征分布的不变性方面仍然存在一定的局限性。为此,本文提出了一种新的域自适应方法——域对称网络(SymNets)。SymNet是基于源域和目标域任务分类器的对称设计,在此基础上,我们还构造了一个额外的分类器,与它们共享其层神经元。为了训练SymNet, 我们提出了一种新颖的对抗学习目标函数,其关键设计是基于一个two-level域混淆方案, 通过推动中间网络特征的学习,类级别的混淆损失在域级别上得到改善。在构造的附加分类器的基础上,实现了域识别和域混淆。由于目标域样本是无标记的,我们还提出了一种跨域训练的方法来帮助学习目标分类器。仔细的消融研究表明我们提出的方法是有效的。特别是,基于常用的基本网络,我们的symnet在三个基准域自适应数据集上实现了最新的技术水平。

网址:

https://arxiv.org/abs/1904.04663

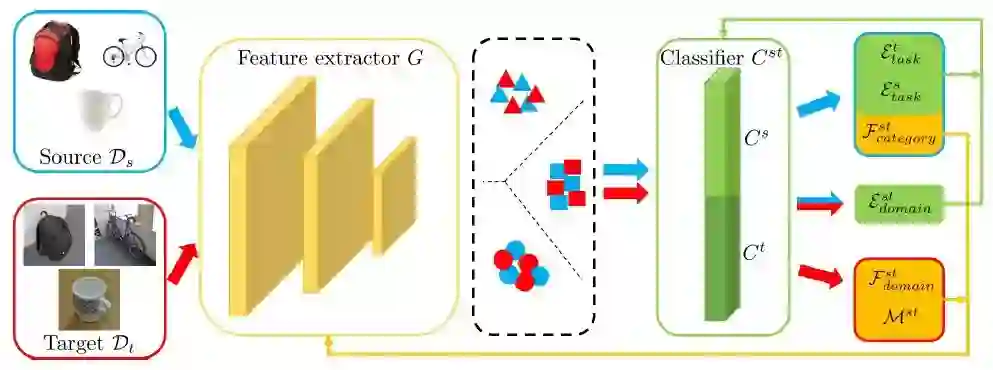

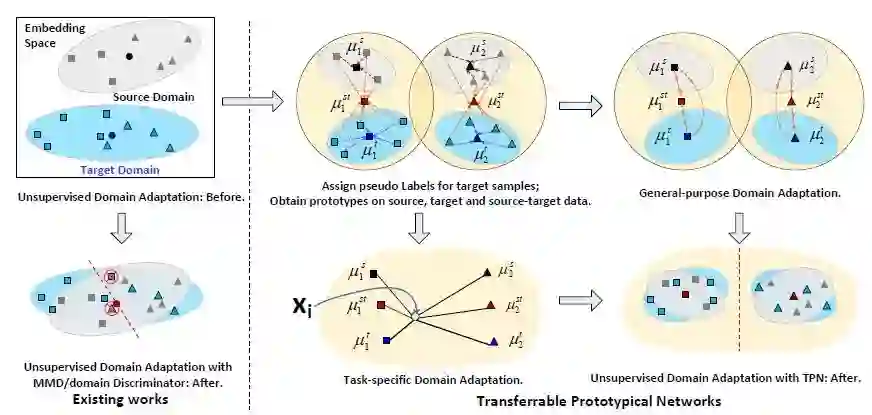

5、Transferrable Prototypical Networks for Unsupervised Domain Adaptation(基于可迁移原型网络的无监督域自适应)

CVPR'19 Oral

作者:Yingwei Pan, Ting Yao, Yehao Li, Yu Wang, Chong-Wah Ngo, Tao Mei

摘要:本文提出了一种通过重构原型网络实现无监督域自适应的新方法,该方法通过学习嵌入空间,通过重构每个类到原型的距离进行分类。具体地说,我们提出了可迁移原型网络(TPN)的自适应算法,使源域和目标域的每个类的原型在嵌入空间上接近,并且原型在源域和目标域数据上分别预测的得分分布是相似的。从技术上讲,TPN最初将每个目标域示例与源域中最近的原型匹配,并为一个示例分配一个“伪”标签。每个类的原型可以分别在纯源域、纯目标域和纯源目标域数据上计算。TPN的优化是通过在三种数据上联合最小化原型之间的距离和由每对原型输出的得分分布的KL -散度来进行端到端训练的。对MNIST、USPS和SVHN数据集之间的迁移进行了广泛的实验,与最先进的方法相比,报告了更好的结果。更值得注意的是,我们在VisDA 2017数据集上获得了80.4%的单模型准确度。

网址:

https://arxiv.org/abs/1904.11227

6、Contrastive Adaptation Network for Unsupervised Domain Adaptation(基于对比自适应网络的无监督域自适应)

CVPR'19

作者:Guoliang Kang, Lu Jiang, Yi Yang, Alexander G Hauptmann

摘要:无监督域自适应(UDA)对目标域数据进行预测,而手工标注只在源域中可用。以往的方法在忽略类信息的情况下,最大限度地减小了域间的差异,从而导致了不一致和泛化性能差。为了解决这一问题,本文提出了一种新的比较自适应网络(CAN)优化度量,它明确地对类内域和类间域的差异进行了建模。我们设计了一种交替的更新策略,以端到端方式训练CAN。在office31和VisDA-2017这两个真实世界基准测试上的实验表明,相对于最先进的方法,该方法可以获得更好的性能,并产生更多的区别性特征。

网址:

https://arxiv.org/abs/1901.00976

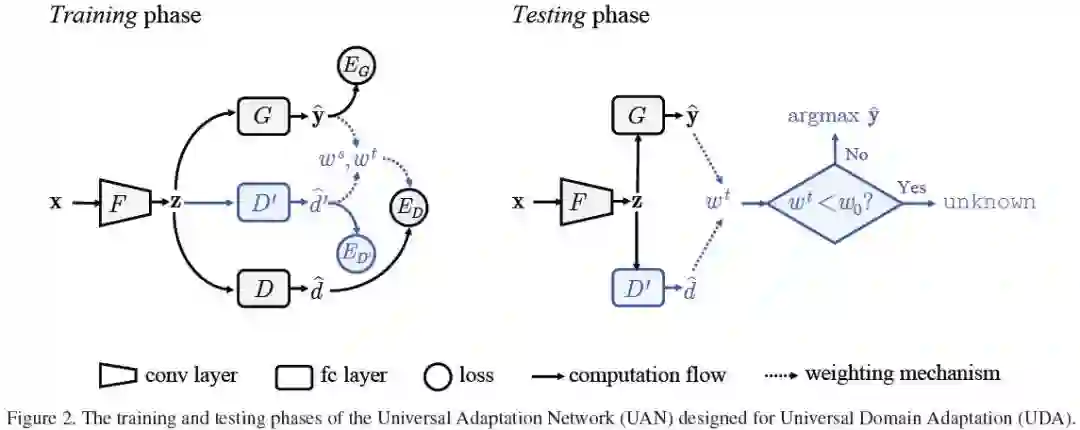

7、Universal Domain Adaptation(通用域自适应)

CVPR ’19

作者:Kaichao You, Mingsheng Long, Zhangjie Cao, Jianmin Wang, and Michael I. Jordan

摘要:域适应的目的是在存在域差距的情况下迁移知识。现有的域自适应方法依赖于对源域和目标域的标签集之间关系的丰富先验知识,这极大地限制了它们在实际中的应用。本文介绍了一种不需要标签集先验知识的通用域自适应算法(UDA)。对于给定的源域标签集和目标域标签集,它们可能分别包含一个公共标签集和一个私有标签集,从而带来额外的类别差异。UDA要求一个模型 (1)正确地分类目标样本,如果它与公共标签集中的标签相关联,或者 (2) 将其标记为“未知”。更重要的是,UDA模型应该能够稳定地应对广泛的共性(通用标签集在整个标签集上的比例),以便它可以处理未知目标域标签集的实际问题。为了解决通用域适应问题,提出了通用域适应网络(UAN)。它量化了发现通用标签集和对每个域私有的标签集的样本级可迁移性,从而促进了自动发现的通用标签集的适应性,并成功地识别了“未知”样本。全面的评价表明,在新颖的UDA设置中,UAN优于现有技术的闭集、部分域和开放域自适应方法。

网址:

https://youkaichao.github.io/files/cvpr2019/1628.pdf

代码链接:

https://github.com/thuml/Universal-Domain-Adaptation

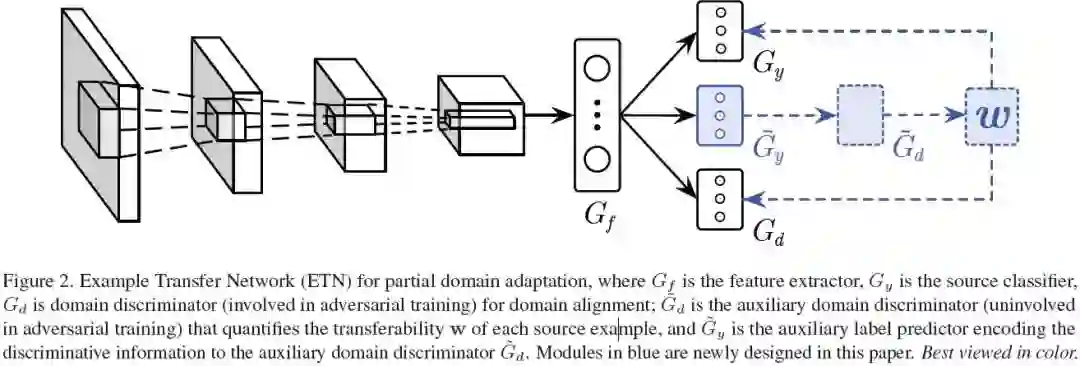

8、Learning to Transfer Examples for Partial Domain Adaptation(基于样例转移网络的部分域自适应)

CVPR ’19

作者:Zhangjie Cao, Kaichao You, Mingsheng Long, Jianmin Wang, Qiang Yang

摘要:域自适应对于在新的未知环境中学习至关重要。通过领域对抗训练,深度网络可以学习可迁移的特征,从而有效地减少用于知识迁移的源域和目标域之间的数据集转移。在大数据时代,大规模标记数据集的可用性引起了人们对局部域适应(PDA)的广泛兴趣,PDA将识别器从标记的大域迁移到未标记的小域。它将标准域适应扩展到目标域标签只是源域标签子集的场景。在目标域标签未知的情况下,PDA的关键挑战是如何在共享类中传递相关的例子来促进正迁移,而忽略特定类中不相关的例子来减少负迁移。在这项工作中,我们提出一个统一的PDA方法—Example Transfer Network (ETN), 共同学习源域和目标域的域不变表示和加权方案, 量化的可迁移源域示例同时控制他们对目标领域中的学习任务的重要性。对几个基准数据集的全面评估表明,我们的方法可以为部分域自适应任务实现最先进的结果。

网址:

https://arxiv.org/abs/1903.12230

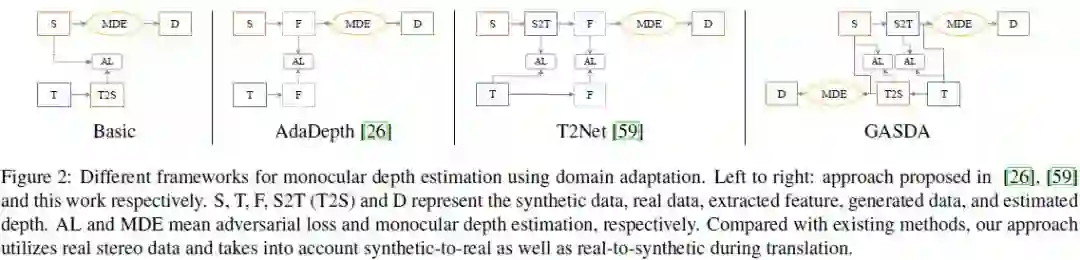

9、Geometry-Aware Symmetric Domain Adaptation for Monocular Depth Estimation(基于几何感知对称域自适应的单眼深度估计)

作者:Shanshan Zhao, Huan Fu, Mingming Gong, Dacheng Tao

摘要:先进的深度网络体系结构使得监督深度估计具有较高的精度。由于groundtruth深度标签难以获取,近年来的方法试图通过非监督线索来学习深度估计网络,这种方法虽然有效,但不如真实标签可靠。解决这一难题的一种新方法是通过域自适应技术从具有groundtruth深度的合成图像中迁移知识。然而,这些方法忽略了目标域内自然图像的特定几何结构(即,真实数据),这对于高性能的深度预测非常重要。在此基础上,我们提出了一种基于几何感知的对称域自适应框架(GASDA),用于研究合成数据和真实数据中的超极几何标记。此外,通过在端到端网络中对称地训练两个图像样式转换器和深度估计器,我们的模型实现了更好的图像样式转换,生成了高质量的深度图。实验结果证明了该方法的有效性,并与现有方法进行了比较。我们的代码在:https://github.com/sshan-zhao/GASDA。

网址:

https://arxiv.org/abs/1904.01870

代码链接:

https://github.com/sshan-zhao/GASDA

下载链接:https://pan.baidu.com/s/1_zUi7BUvfonhLNaw1tsg0g 提取码:crqk