神经进化:一种不一样的深度学习

作者 | Paul Pauls

编译 | 十、年

神经进化

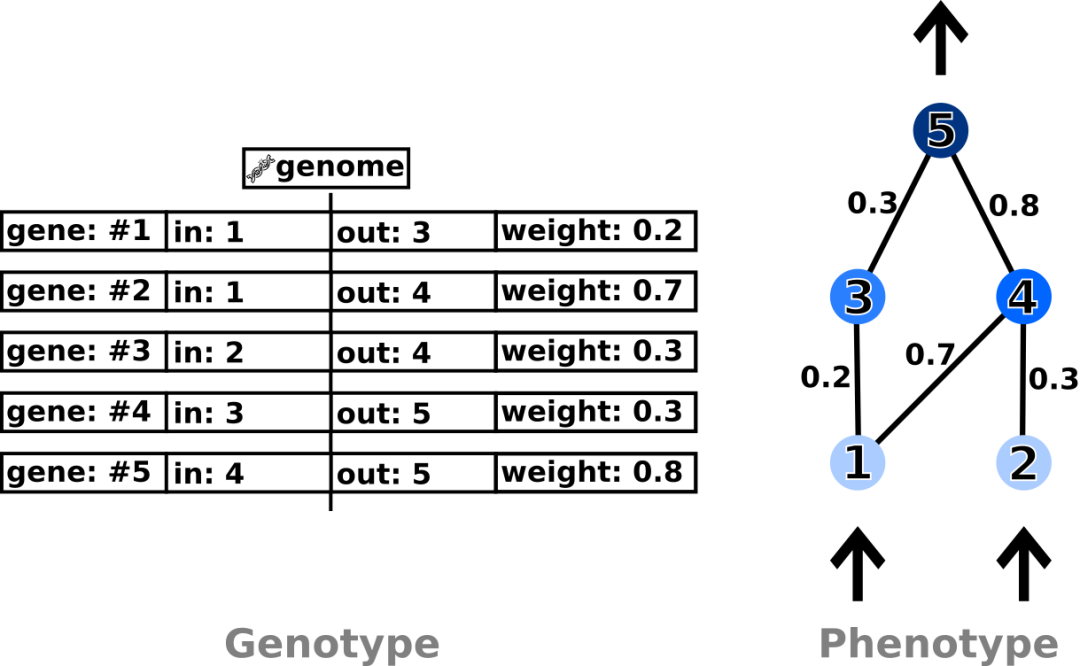

图2:直接遗传编码

图3:间接遗传编码

图3:间接遗传编码

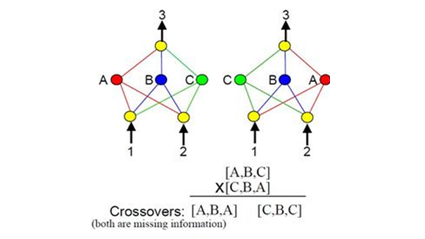

图4:竞合公约问题图解

自然选择与亲本选择

登录查看更多

相关内容

Arxiv

3+阅读 · 2020年3月12日

Arxiv

11+阅读 · 2018年2月16日

Arxiv

4+阅读 · 2017年11月15日