SNN,像你的大脑一样工作

【今日聚焦】

在被人工智能火热席卷的时代里,一种模拟生物神经元机制的神经网络——SNN(Spiking Neural Network)应运而生。本文将从本质概念、工作机制、发展过程、优化方法、未来展望等方面详细介绍SNN,带你一探究竟!

SNN又是个什么NN

在这个人工智能概念被炒的火热的时代里,我们身边充斥着各种NN(Neural Network),从处理图像的CNN(Convolutional Neural Network),到处理序列的RNN(Recurrent Neural Network),再到它们的加强版DNN(Deep Neural Network),以及其他各种变形的NN。所以当你看到SNN的时候,你一定会觉得这个NN跟上面的NN也不会有多大区别,最多也就是其他NN的变形。然而,这种认知是错误的。

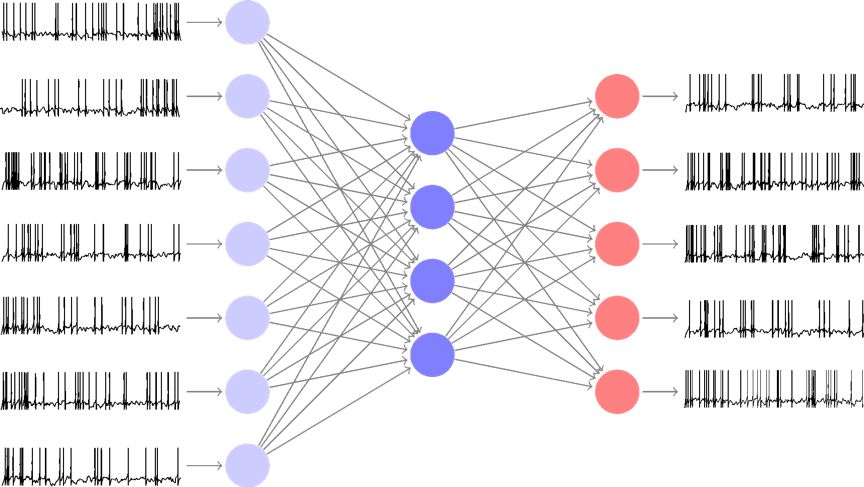

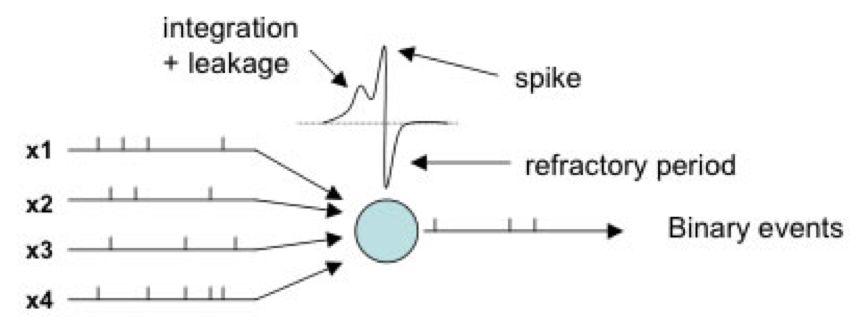

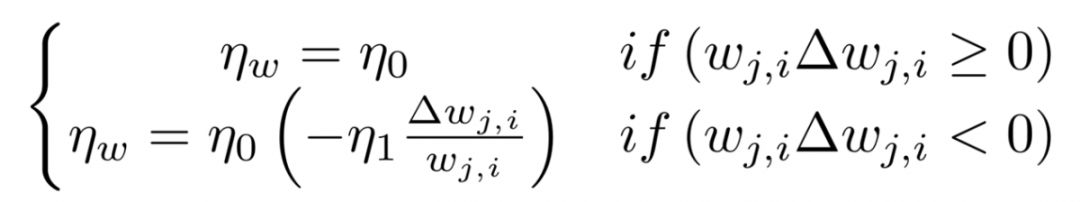

SNN全称是脉冲神经网络(Spiking Neural Network),它与其他的ANN(Artificial Neural Network)有着本质上的不同。SNN神经元间传递的是时域离散的脉冲信号,而其他ANN的神经元间传递的是空域连续的信号。这种不同也是所有其他ANN与生物神经系统之间的本质区别,所以可以把SNN与生物神经系统归为一类,而非ANN中的一员。

图1. 单隐层SNN网络信号及结构

由于现在的ANN多是从多层感知机演化而来的,而感知机虽然借鉴了神经系统的某些特征,但是归根结底还是一个早期电子工程的产物,所以ANN、多层感知机和感知机中传递的信号还都是空域连续的,在某种程度上,我们可以把这些信号看成是生物系统中的放电率信息。相比于这种空域连续信号,时域离散的SNN信号能够更好地描述、模拟生物的神经信息处理过程,从而有机会获得可以用同一网络处理时域和空域信号等目前生物具有而ANN没有的优良特性。

这个问题其实是一个生物学的问题,而这个问题的答案从高中生物教材上也可以窥探一二,这里就从高中生物的知识讲起。

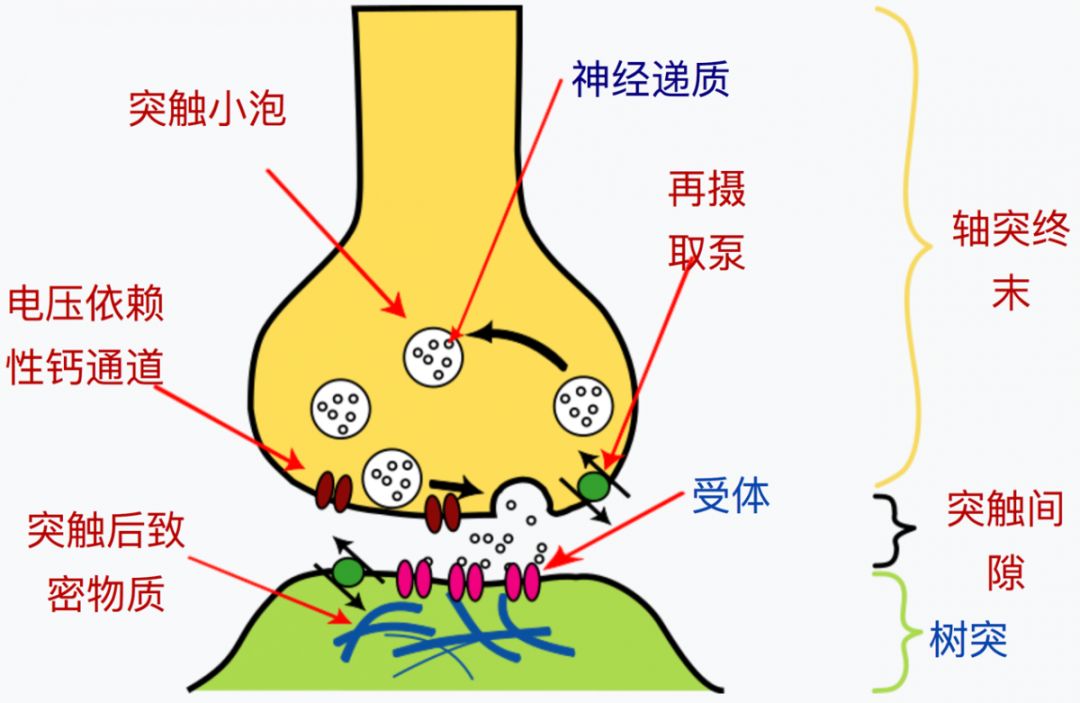

自从卡哈尔在二十世纪初发现了神经元,神经科学家就认为神经元是对输入信号进行了一些简单的操作并将被操作后的信号传递到下一级神经元。而随着进一步的深入研究,发现神经元间传递信息靠的是突触前膜产生的神经递质刺激突触后膜上的受体。而突触后膜在受到足够多的神经递质的刺激后将会产生脉冲信号,传入神经元胞体中进行一些简单的处理,再传到这个神经元的轴突中,刺激突触释放相应的神经递质,从而将处理后的信息传递给再下一级神经元。

图2. 电压依赖性离子通道

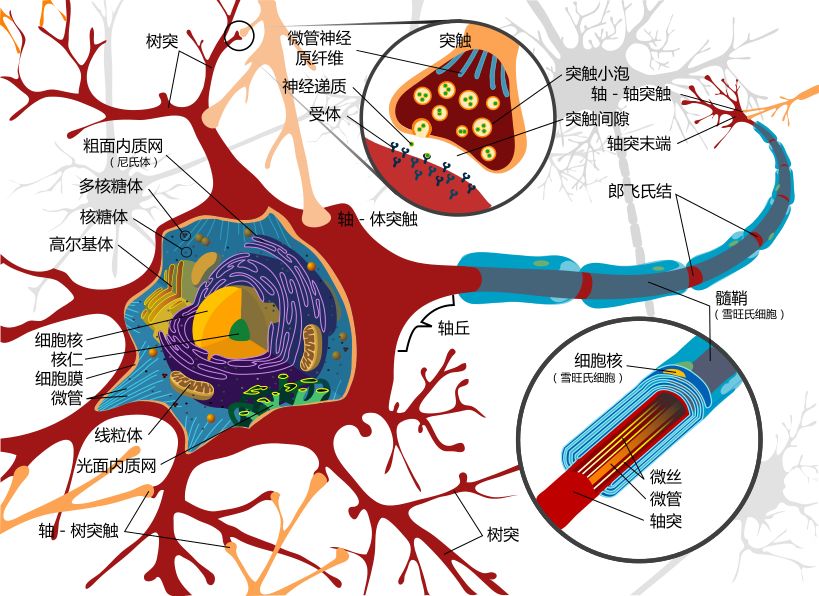

对于神经元内部的认识,是一个对神经元进行建模的过程,我们接着从高中生物讲起。神经元与其他细胞最大的区别就是有很多枝叉,其中最粗最长的那根叫做轴突,其他细而短的叫树突。神经元通过树突来接收其他神经元发出的信号,信号通过神经递质等离子引起的电压变化传导,然后再通过轴突将被胞体处理过的信号传出去。

图3. 神经元细胞结构示意图

虽然现在发现的神经递质有很多种,包括兴奋型的谷氨酸等和抑制型的甘氨酸等,但是我们在这里为了简化只考虑兴奋型。随着越来越多的神经递质与突触后膜上的受体结合,神经元就会越来越兴奋,当它克制不住自己的时候,一个新的神经冲动就产生了,随之而来的就是它的一段落寞。但是神经递质对神经元的刺激效果难以保持很长时间,如果在神经元兴奋上升期暂停了神经递质的刺激,神经元的兴奋程度就会下降。

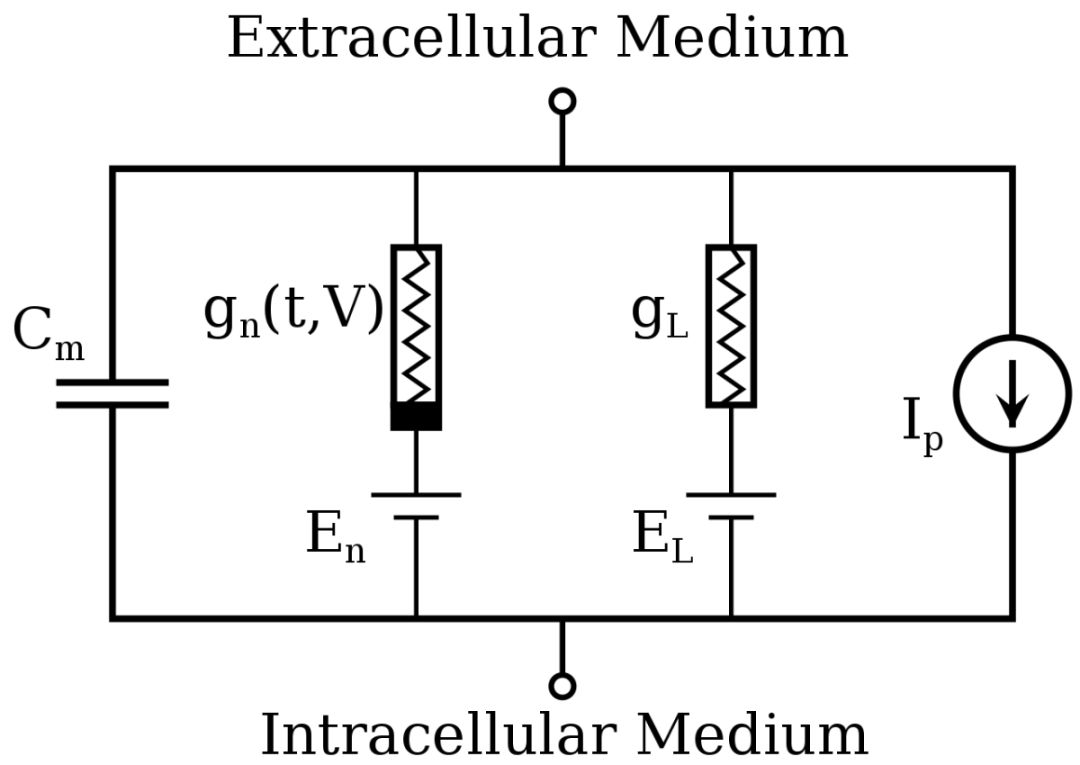

虽然SNN现在被称为第三代神经网络模型,但是它的基本组成部分——脉冲神经元模型,比第一代的感知机出现的都要早。早在1907年,Louis Lapicque就提出了第一个脉冲神经元模型,Integrate-And-Fire(IF)模型。在此之后,Alan Lloyd Hodgkin和Andrew Fielding Huxley通过对于巨大的乌贼突触的研究,提出了基于电导的模型,即Hodgkin-Huxley(H-H)模型。相比于单纯地用电容模拟神经元的IF模型,H-H模型用电容模拟了细胞膜的脂双层结构、用电导模拟了细胞膜上的离子通道、用电压源模拟了细胞内外离子浓度差、用电流源模拟了细胞膜上的离子泵。

这种对于神经元细致的模拟让H-H模型能够很完美地模拟神经元的膜电位变化以及输入输出情况,但是由于H-H模型是一种非线性系统,没有解析解,而且系统复杂难以得出数值解,所以很难自动化学习模型参数,从而不能用于构建机器学习网络。

图4. H-H模型的电路表示

IF模型太简单,不能很好的模拟神经元的功能;而H-H模型又太复杂,没有解析解也无法使用计算机学习得到参数。要既能保证较好的模拟神经元功能,又要够简单可以由计算机学习获得参数,Leaky Integrate and Fire(LIF)模型就应运而生。LIF模型是以IF模型为基础,添加了巨型乌贼神经元实验中发现的泄漏机制。相比于H-H模型,LIF模型将两种离子合并为一种,再用一种简单的数学表示代替电流源的泄漏机制,从而使得生物神经元模型更加接近简单的感知机模型。

图5. LIF模型

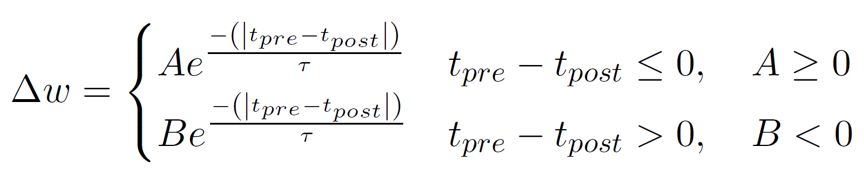

相比于第一代的感知机网络和第二代的BP神经网络,SNN作为一个网络最早出现在1997年。九十年的时间为SNN积累了很多,包括十多种脉冲神经元模型,更重要的是出现了一种有效的SNN的优化方式——STDP(Spike-timing-dependent plasticity)。STDP是通过对神经元之间连接强度的研究发现的一种生物过程,然而这是一种非监督的优化方法,只关注脉冲产生的前后顺序,而没有关注脉冲产生的因果关系。

早在上个世纪50年代,神经科学家就发现了神经元在产生动作电位的同时也会产生反向传播到树突的信号。这个发现激发了后来对第二代BP神经网络的研究。在研究SNN的优化方法时也根据这种生物特征进行了监督式学习方法的研究,但是脉冲信号的不可导的特性导致SNN不能像传统神经网络那样更新权重,所以就要对SNN或优化方法进行改进,从而模拟生物神经元的反向传播监督学习。

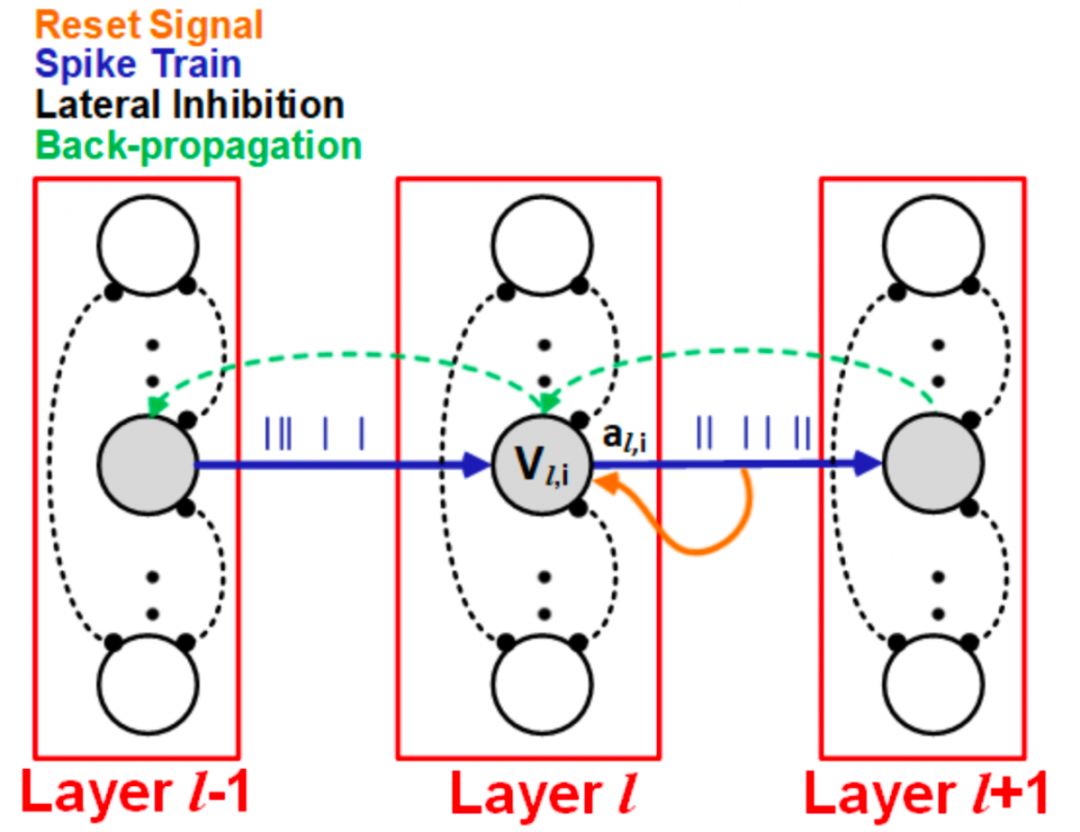

要将监督学习应用到SNN的一个最简单的想法就是改造脉冲神经元,让脉冲神经元的信号可导。回看图5的LIF模型,很容易发现可导的部分就是神经元的膜电位。虽然输入输出信号都是脉冲信号,但是膜电位的变化是连续的。膜电位的变化与输入中脉冲数量和脉冲到达的时间有关,同理也跟输出中脉冲的数量有关,那么使用膜电位的梯度来更新神经元间的连接权重所根据的因素就和STDP方法相同。再加上监督学习关注了神经元之间膜电位变化的因果关系,相比于STDP,这种方法就能更好地、更有针对性地优化SNN。

使用这种方法的优化算法中比较有代表性的就是Jun Haeng Lee等人提出的以膜电位为可导信号的监督式反向传播训练方法。这种方法最大化的保留了两个过程,一个是强化后的膜电位的非线性时序信息积累过程(此处可微分),一个是弱化后的脉冲放电及信号重置过程(此处不可微分),且不仅计算了输入输出的脉冲信号对于神经元膜电位的作用,还关注了生物神经网络中与传统ANN不同的一个特征——侧向抑制作用对于神经元膜电位的影响。

图6. Jun Haeng Lee等人提出的优化方法

Lee的方法虽然模拟了神经元的很多机制,但是却忽视了神经元之间最根本的使用神经递质传播信息的方法。为了真正能够模拟神经元间突触连接的变化,自动化所的曾毅研究员和张铁林助理研究员团队进一步探究了生物神经元间到底是什么影响了突触,同时考虑了兴奋型和抑制型两种神经元,根据实际的生物神经网络的神经元及突触变化提出了七条SNN的训练规则。这七条规则分别是:

(1)获取新的神经元

(2)删除额外神经元

(3)突触形成

(4)突触消失

(5)均匀或Possion背景噪声

(6)三种STDP规则

(7)引入抑制型神经元

在实际使用中,对于现阶段简单的SNN来说七条规则过于复杂,而且从数学模型上来说部分规则存在功能重复性问题,导致最终的训练效果不尽如人意。经过对于模型和训练规则的进一步分析,研究者最终将规则修改为四条,并引入了生物系统中普遍存在的稳态机制。

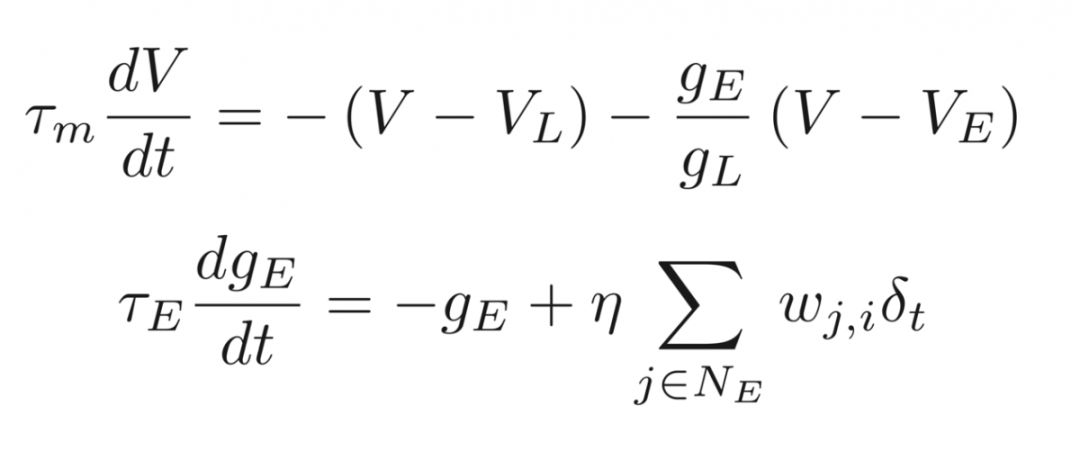

在介绍训练规则之前,要先介绍一下曾毅研究员团队论文中对于LIF模型的认识。在大多数情况下,随着输入脉冲的到来,神经元的膜电位会逐步缓慢增长,只有在长期没有脉冲输入时才会使得膜电位有明显下降。然而在实际使用中发现,如果将输入脉冲直接认为是系统的输入电流,会导致膜电位在没有输入时迅速下降,与实际情况不符。如果将输入脉冲作为兴奋型电导的变化值,膜电位就可以像神经元那样变化。所以这里使用第二种动态方程表示形式,具体表达如下。

这样,随着不同神经元脉冲的到来,兴奋型电导或减或增,神经元的膜电位也就可以平缓地变化。随着接下来前级神经元膜电位的变化和当前神经元脉冲信号的输出,当前神经元的膜电位状态不可避免地会发生变化。为了使系统尽量保持一种稳态,就要让当前的膜电位及时地发生一些变化,从而平衡掉其他部分的影响。这就是第一条训练规则,让膜电位保持稳态。

考虑了膜电位的稳态之后,还要考虑不同的前级神经元对于当前神经元造成的影响,这里主要是兴奋型和抑制型两种,具体的影响方式是根据不同的权重符号产生不同的学习率,例如兴奋型神经元的权重始终要保持为正,抑制型的则正好相反。这个规则看起来限制较为严格,但其实使用权重的变化量与过去权重值的比例关系约束学习率就能做到。

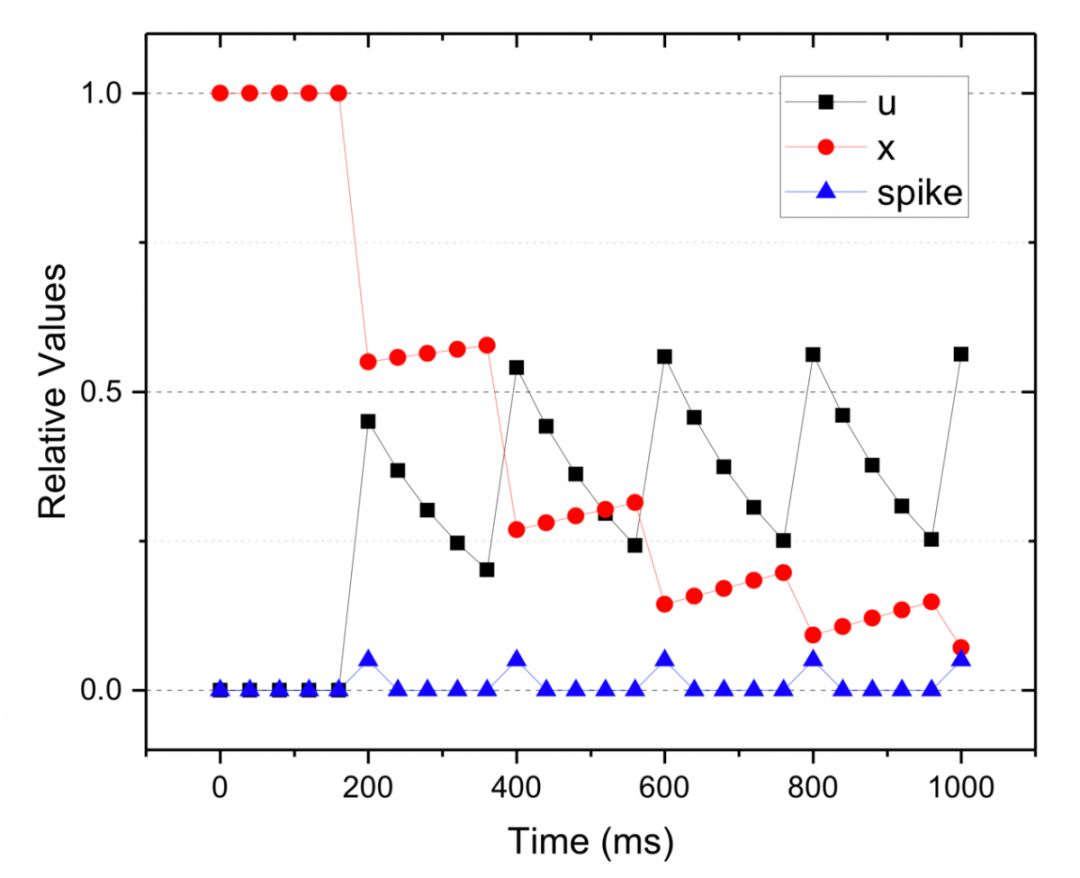

接下来就要用到与神经元间突触变化机制联系最紧密的一条规则——基于稳态的突触短时可塑性(Short-Term Plasticity, STP)。STP主要包括两点,一是突触的短时易化(STF),二是突触的短时抑制(STD)。它们主要来源于神经元中两项重要归一化变量u和x的变化趋势,最终会影响每一次产生的脉冲电流的大小。

图7. STP对于输入脉冲电流大小的影响

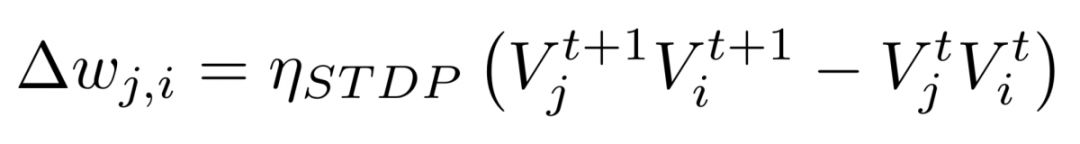

在对最后一层输出脉冲的校准中,监督学习发挥了它强大的纠偏作用。简单来说,当给定网络一种输入之后,在每一个时刻都会有一种期望的输出。而这时对应的神经元的输入如果与期望不符,则要对出现误差的神经元的膜电位进行修正。通过不断的学习,使得输出神经元都尽可能地输出最终期望的结果。

就像生物神经网络中的突触一样,这里的每一次修正都是对膜电位进行的,而随着时间的推移和膜电位变化范式的长期保持,最终将会影响到突触的连接强度,在SNN中就表现为对于神经元间连接权重的影响。在这里,就使用一种类似于STDP的权重更新方式,根据连接的两个神经元前后时刻膜电位变化的关系,确定两者间连接权重的改变。

作为一种模拟生物神经元机制的神经网络,SNN直指人工智能领域的终极目标——像人一样思考!使用脉冲信号的特性让它能处理时域信息,灵活的连接方式让它可以模拟CNN处理空域信息,那么进一步地可以将二者结合起来,让它能够像人一样处理多种混合的任务信息。

现阶段因为SNN还没有一种简单的端到端的训练方法,所以网络结构还比较简单,一般都是窄宽度的三层全连接网络居多,只能处理一些简单的图像信息。但是随着对于SNN优化方式的不断探索,在有了更好的训练方法以后,就可以构建更加复杂的、也更加类似于人类神经网络的结构。很显然,复杂的结构将会给网络带来更加强大的信息处理能力。到那时候,将会有更多的参考人类或者其他动物不同脑区结构设计的SNN出现。

你将可以让以SNN为核心处理机制的机器人像人类服务员一样帮你端茶倒水,让它们帮你像人类的监督员一样监控视频,甚至以后还可能让它们像写作大师一样帮你写作业写论文......

参考文献

[1]Maass W. Networks of spiking neurons: the third generation of neural network models[J]. Neural networks, 1997, 10(9): 1659-1671.

[2] Rosenblatt F. The perceptron: a probabilistic model for information storage and organization in the brain[J]. Psychological review, 1958, 65(6): 386.

[3] Abbott L F. Lapicque’s introduction of the integrate-and-fire model neuron (1907)[J]. Brain research bulletin, 1999, 50(5-6): 303-304.

[4] Hodgkin A L, Huxley A F. A quantitative description of membrane current and its application to conduction and excitation in nerve[J]. The Journal of physiology, 1952, 117(4): 500-544.

[5] Methods in neuronal modeling: from ions to networks[M]. MIT press, 1998.

[6] Markram H, Lübke J, Frotscher M, et al. Regulation of synaptic efficacy by coincidence of postsynaptic APs and EPSPs[J]. Science, 1997, 275(5297): 213-215.

[7] Lee J H, Delbruck T, Pfeiffer M. Training deep spiking neural networks using backpropagation[J]. Frontiers in neuroscience, 2016, 10: 508.

[8] Zhang T, Zeng Y, Zhao D, et al. A Plasticity-Centric Approach to Train the Non-Differential Spiking Neural Networks[C]//AAAI. 2018.

[9] Zhang T, Zeng Y, Zhao D, et al. Brain-inspired Balanced Tuning for Spiking Neural Networks[C]//IJCAI. 2018: 1653-1659.

Story of Convolution Network: 卷积网络层被设计来描述V1区的三个特性,其一是:V1区可以进行空间映射。它具有二维结构来反映视网膜中的图像结构。卷积网络通过用二维映射定义特征的方式来描述该特性。

文章为作者独立观点,不代表自动化所立场。

更多精彩内容,欢迎关注

中科院自动化所官方网站:http://www.ia.ac.cn

欢迎后台留言、推荐您感兴趣的话题、内容或资讯,小编恭候您的意见和建议!如需转载或投稿,请后台私信。

作者:李春放(中国科学院信息工程研究所)

排版:亚岱尔

编辑:鲁宁

中科院自动化研究所

微信:casia1956

欢迎搭乘自动化所AI旗舰号!