人工神经网络真的像神经元一样工作吗?

编者按:Google产品经理Yariv Adan讨论了困惑很多人的问题:人工神经网络和人类大脑中的神经网络到底有多像?

人工神经网络和机器学习已经成为大众媒体的热门主题。智能机器这一想法勾起了很多人的想象,而且人们特别喜欢把它和人类放一起比较。特别是有一个关于人工智能的底层机制的基础问题经常出现——这些人工神经网络的工作方式真的和我们大脑中的神经元相似吗?

Tl;Dr

不。尽管从高层概念上说,ANN(人工神经网络)受到了大脑中的神经元和神经网络的启发,但这些概念的ML实现和大脑的工作方式大有径庭。不仅如此,随着这些年来ML领域的进展,新的复杂想法和技术的提出(RNN、GAN等)——这一联系进一步削弱了。

关键相似点

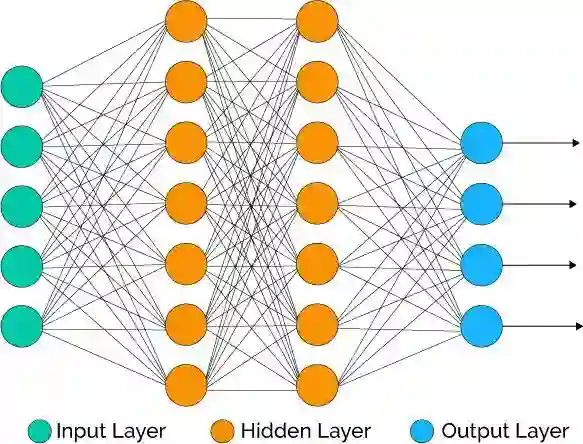

前馈全连接网络的高层架构和一般原则体现了人工神经网络和大脑中的神经网络的相似性。

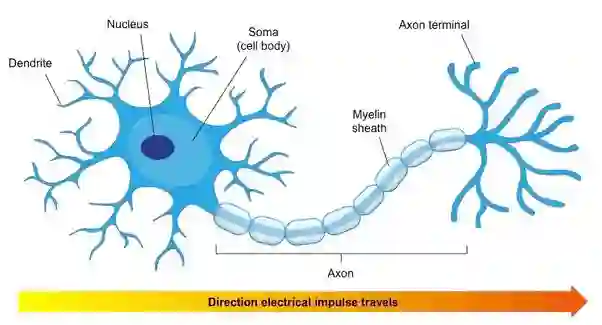

从高层看,大脑的神经元由三部分组成:

树突(输入机制)—— 通过突触接受输入的树状结构。输入可能是来自感觉神经细胞的感觉输入,也可能是来自其他神经细胞的“计算”输入。单个细胞可以有多达10万输入(每个来自不同的细胞)。

胞体(计算机制)—— 细胞体收集所有树突的输入,并基于这些信号决定是否激活输出(脉冲)。这是一个概括性的说法,因为有些计算在传入胞体前就完成了(在树突结构中编码)。

轴突(输出机制)—— 一旦胞体决定是否激活输出信号(也就是激活细胞),轴突负责传输信号,通过末端的树状结构将信号以脉冲连接传递给下一层神经元的树突。

类似地,ANN中也有等价的结构:

输入连接 —— 每个神经元接受一组输入,或者来自输入层(等价于感觉输入),或者来自网络中前一层的神经元。

线性计算和激活函数 —— 这些“累加”输入,接着非线性地决定是否激活神经元。

输出连接 —— 这些传递激活信号至网络中下一层的神经元。

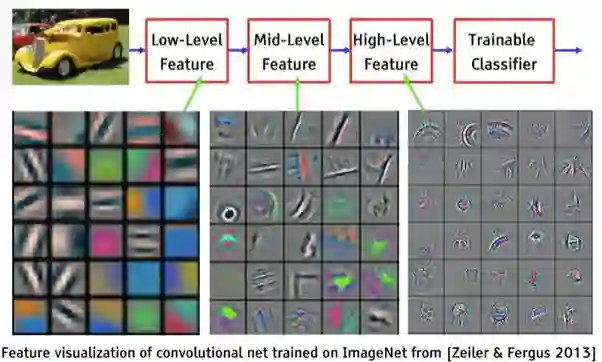

类似地,卷积神经网络借鉴了视觉通路。很酷的一件事情是,CNN原本主要借鉴的是架构(对应特定形状或模式的较小的核/过滤器,每次应用于较小的区域)。然而,多年之后,当ML研究人员开发了新的可视化CNN隐藏层的技术后,人们发现CNN表示图像的方式和视皮层的层次表示十分类似——从表示简单模式的第一层开始,较深的层复合出复杂形状和对象。

可塑性 —— 大脑的独特性质之一,学习和记忆得以成立的关键特性。大脑基于经历创建新的脉冲连接,废弃旧的脉冲连接,加强或削弱现有的连接。可塑性甚至在单个神经元中起作用——影响它的电磁行为,以及对特定输入作出回应触发激活的趋向。

可塑性这一想法是训练ANN的关键原则——基于批次输入迭代修改网络参数(权重)。最近,元学习领域的进展将ANN中可塑性的应用范围从参数拓展到超参数乃至整个模型。

关键区别

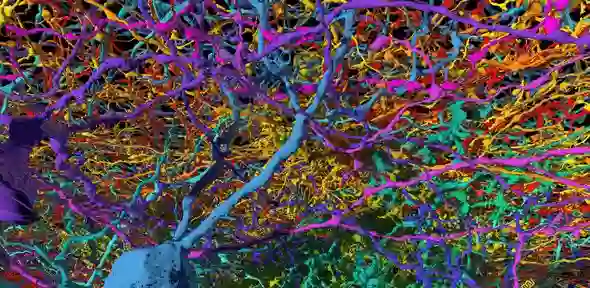

大脑神经元的复杂性和鲁棒性要比人工神经元复杂强大得多。这不仅体现在神经元的数量及每个神经元的树突数量上——比我们现在的ANN高出若干数量级,还体现在单个神经元的内部复杂性上:和人工神经元相比,神经元的化学和电学机制精细得多,也强健得多。例如,神经元不是零电位差的——细胞的不同区域可能具有不同的电位,有不同的电流通过。这让单个神经元可以进行非线性运算,识别随着时间发生的变动(例如,移动的目标),或者将不同的区域并行映射至不同的树突区域——这样整个细胞就可以完成复杂的复合任务。和非常简单的人造神经元相比,这些都是高级很多的结构和能力。

实现 —— 大脑中的神经元是以非常复杂和精细的机制实现的,可以进行非常复杂的非线性计算:

信号在神经元突触间隙中的化学传播,是通过神经递质和感受器完成的,并由各种兴奋和抑制元素放大。

基于复杂的时空电磁波推断逻辑,兴奋/抑制性突触后电位构建了动作电位。

离子通道和微电位差控制脉冲的触发,细胞体中的脉冲将沿着轴突传播。

大量我们尚未理解的机制……

和这些相比,ANN中使用的参数、权重、线性函数、激活函数十分简单粗暴。

在此之上,大脑中的神经元的整体架构要比大多数ANN复杂得多,特别是和常见的前馈网络相比(前馈网络的每一层只和前一层、后一层连接)。不过,即使是和多层RNN或者残差网络相比,大脑中的神经元网络也是不可思议地复杂,在许多方向上有着数万跨“层”、跨区域的树突。

另一方面,大脑不太可能使用反向传播这样的方法——基于误差函数的偏导数上的链式法则。

能源消耗 —— 大脑是一个极端高效的计算机,差不多十瓦左右,约为单个CPU能耗的三分之一。

GAN、RL、RNN等新进展 —— 在ML的理论和应用上,都不断涌现新的想法和创新。这些都不再基于大脑的工作机制。它们也许受到了大脑的启发,或者人类行为的启发,但在许多方面,现在的ML方面的研究和工作过着属于自己的生活——迎接自身的挑战,追寻自身的机遇。

大脑是持续的灵感来源

尽管有上面列出的这些不同,ML研究仍然不断将大脑列为灵感来源,因为大脑比我们现有的计算设备要强健和高效太多。认识人工神经网络和大脑的差距,以及关于大脑机制的研究,激发了一些最激动人心也最具挑战性的ML近期研究。例如:

能效 —— 如前所述,大脑的神经元和连接数量比我们创建的任何ANN都要大上若干数量级,但它消耗的能量却要少若干数量级。这是一个很活跃的研究领域,包括基于DNA和其他分子的生物网络,以及试图模仿神经元和突触的神经形态(neuromorphic)电子开关。

从很小的训练样本集学习 —— 最有可能是通过一些内置的模型,这些模型对物理法则、心理学、因果关系和其他决定地球上的决策和行动的规则有一些“直觉上的”理解。和现有的通用白板神经网络相比,这些加速了学习,并能指导预测/行动。

释放无监督学习和强化学习的威力 —— 无监督学习和强化学习是AI的“暗能量”。物理上,暗能量占据了我们的宇宙的大部分,而我们对其知之甚少。与此类似,很明显我们的大脑主要通过无监督学习和强化学习的方式进行学习。而当前的大部分ML应用使用监督学习。解开这一谜题是构建能像人类一样学习的机器的关键。

新的方法和架构。例如,嗅觉背后的神经系统,可以为新的ML方法提供灵感,处理现有方法无法很好应对的一些问题。

最后,这当然不可能是一个全面的答案,明显还有很多我没提到的相似性和区别。例如,来自多伦多的Blake Richards做了一个很棒的简短演讲:https://youtu.be/vGFq6vQ_gR4 从一个新颖独特的角度陈述了大脑和深度学习在原则上的相似性。事实上,这一问题是我们的时代最激动人心、最复杂、进展最快的两个研究领域的交汇之处,所以你可以期望在未来我们会了解更多。

原文地址:https://medium.com/swlh/do-neural-networks-really-work-like-neurons-667859dbfb4f