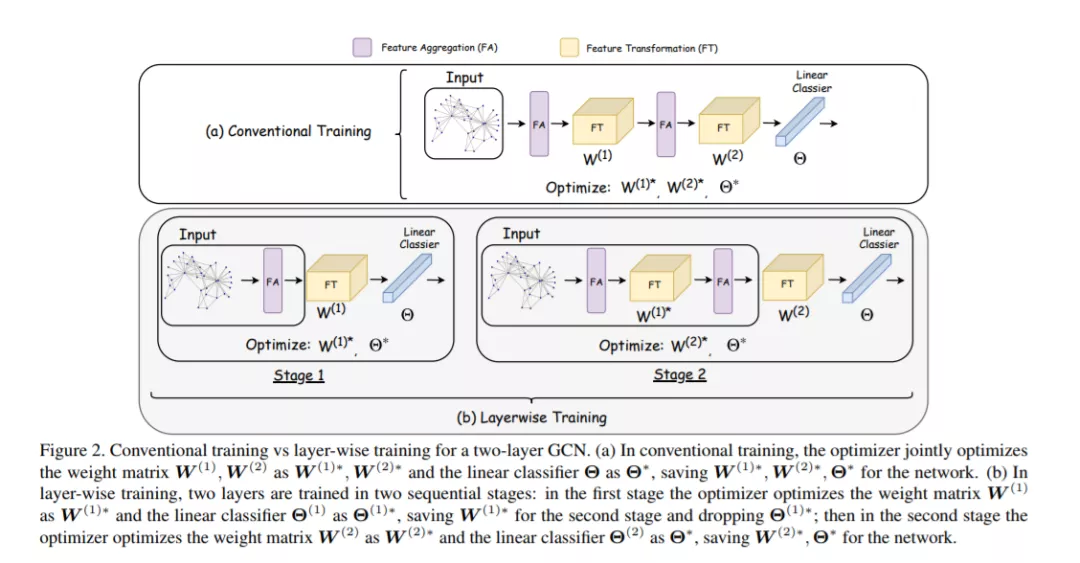

图卷积网络(GCN)在许多应用中越来越受欢迎,但在大型图数据集上的训练仍然是出了名的困难。它们需要从它们的邻居递归地计算节点表示。当前的GCN训练算法要么计算成本高,随层数呈指数增长,要么加载整个图和节点嵌入时占用大量内存。提出了一种高效的GCN (L-GCN)分层训练框架,将训练过程中的特征集合和特征转换分离出来,大大降低了训练的时间复杂度和记忆复杂度。我们在图同构框架下对L-GCN进行了理论分析,结果表明,在较温和的条件下,L-GCN与代价较高的传统训练算法具有同样强大的GCNs性能。我们进一步提出了L^2-GCN,它为每一层学习一个控制器,可以自动调整L-GCN中每一层的训练时间。实验表明,L-GCN至少比目前的水平快一个数量级,内存使用的一致性不依赖于数据集的大小,同时保持了可比较的预测性能。通过学习控制器,L^2-GCN可以进一步减少一半的训练时间。我们的代码在这个https URL中可用。

成为VIP会员查看完整内容

相关内容

Arxiv

9+阅读 · 2019年5月27日

Arxiv

7+阅读 · 2018年11月4日