【泡泡一分钟】CalibNet:使用3D空间变换网络进行几何监督的外部校准

每天一分钟,带你读遍机器人顶级会议文章

来源:2018 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS)

作者:Ganesh Iyer, R. Karnik Ram, J. Krishna Murthy, and K. Madhava Krishna

编译:章绩伟

审核:陈世浪,颜青松

欢迎个人转发朋友圈;其他机构或自媒体如需转载,后台留言申请授权。

摘要

3D激光雷达和2D相机越来越多地在传感器装置并行使用来完成感知任务。然而,在用这些传感器进行数据采集之前需要精确校准它们的外部参数(和内部参数),原因是传感器的性能对这些校准参数非常敏感。绝大多数现有的校准技术需要大量的数据和/或校准目标以及人力,严重影响它们在大规模生产系统中的适用性。因此,本文采用CalibNet(一种几何监督的深度网络)解决了这个问题,CalibNet能够实时自动估算3D激光雷达和2D摄像机之间的6自由度刚体转换。CalibNet减少了对校准目标的需求,从而大大节省了校准工作量。在训练期间,网络仅将激光雷达点云,相应的单目图像和摄像机校准矩阵K作为输入。在训练时,我们不进行直接监督(例如我们不直接回归校准参数)。相反,我们训练网络预测校准参数,从而最大化输入图像和点云的几何和光度一致性。CalibNet能够迭代地解决基础几何问题,并准确地预测外部校准参数,以进行各种误校准,而无需重新训练或域适应。工程代码发布在:https://epiception.github.io/CalibNet

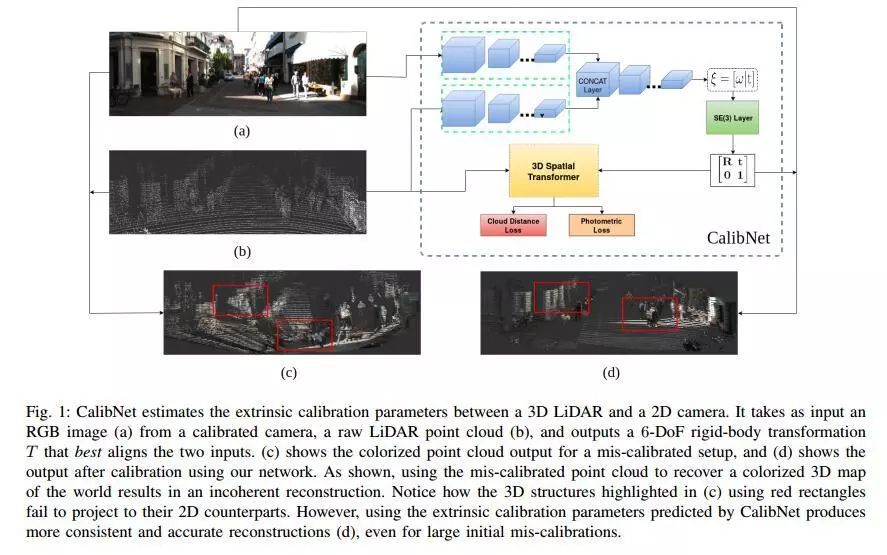

图1 CalibNet估计3D LiDAR和2D相机之间的外部校准参数。它将来自校准相机的RGB图像(a),原始LiDAR点云(b)作为输入,并输出最佳对齐两个输入的6-DoF刚体变换T. (c)显示错误校准设置的彩色点云输出,(d)显示使用我们的网络校准后的输出。如图所示,使用误校准的点云来恢复世界的彩色3D地图导致不连贯的重建。注意(c)中使用红色矩形突出显示的3D结构如何无法投影到其2D对应物。然而,使用CalibNet预测的外部校准参数可以产生更一致和准确的重建(d),即使对于大的初始误校准也是如此。

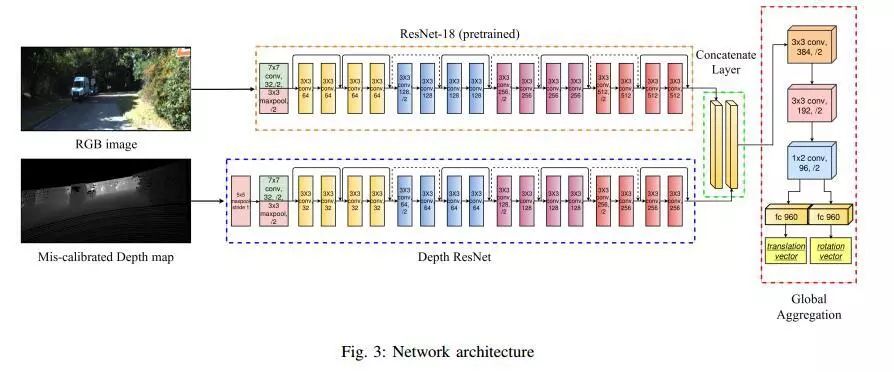

图3 网络结构

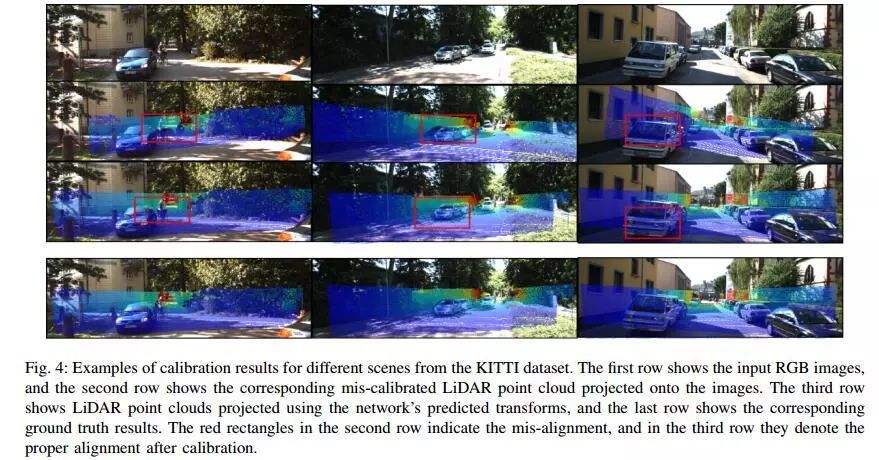

图4 来自KITTI数据集的不同场景的校准结果示例。第一行显示输入的RGB图像,第二行显示投影到图像上的相应的错误校准的LiDAR点云。第三行显示使用网络预测变换投影的LiDAR点云,最后一行显示相应的地面实况结果。第二行中的红色矩形表示未对齐,而在第三行中,它们表示校准后的正确对齐。

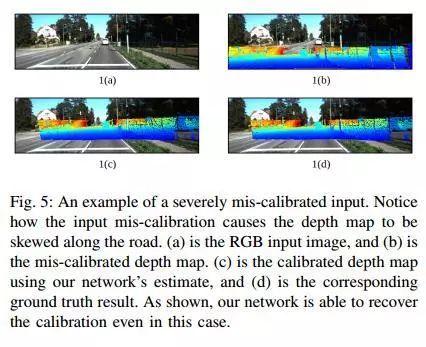

图5 严重误校准输入的示例。注意输入误校准是如何导致深度图沿着道路倾斜的。(a)是RGB输入图像,(b)是误校准的深度图。(c)是使用我们网络估计的校准深度图,(d)是相应的地面实况结果。如图所示,即使在这种情况下,我们的网络也能够恢复校准。

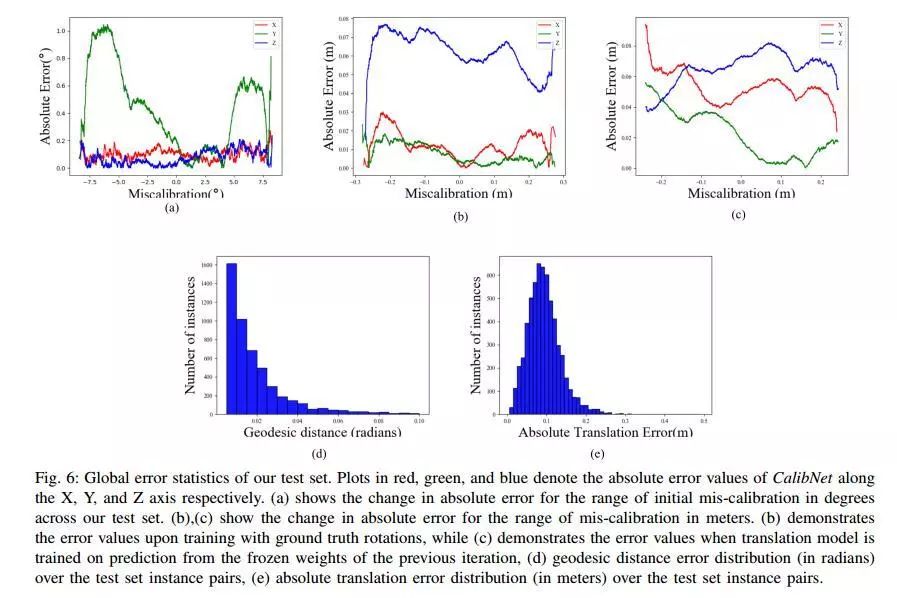

图6 我们的测试集的全局错误统计信息。红色,绿色和蓝色的图分别表示CalibNet沿X,Y和Z轴的绝对误差值。(a)显示了我们测试装置中以度为单位的初始误校准范围的绝对误差变化。(b),(c)显示以米为单位的误校准范围的绝对误差变化。(b)演示了地面实况旋转训练时的误差值,而(c)显示了从前一次迭代的冻结权重预测平移模型时的误差值,(d)测地距离误差分布(弧度) 测试集实例对,(e)测试集实例对上的绝对转换错误分布(以米为单位)。

Abstract

3D LiDARs and 2D cameras are increasingly being used alongside each other in sensor rigs for perception tasks. Before these sensors can be used to gather meaningful data, however, their extrinsics (and intrinsics) need to be accurately calibrated, as the performance of the sensor rig is extremely sensitive to these calibration parameters. A vast majority of existing calibration techniques require significant amounts of data and/or calibration targets and human effort, severely impacting their applicability in large-scale production systems. We address this gap with CalibNet: a geometrically supervised deep network capable of automatically estimating the 6-DoF rigid body transformation between a 3D LiDAR and a 2D camera in real-time. CalibNet alleviates the need for calibration targets, thereby resulting in significant savings in calibration efforts. During training, the network only takes as input a LiDAR point cloud, the corresponding monocular image, and the camera calibration matrix K. At train time, we do not impose direct supervision (i.e., we do not directly regress to the calibration parameters, for example). Instead, we train the network to predict calibration parameters that maximize the geometric and photometric consistency of the input images and point clouds. CalibNet learns to iteratively solve the underlying geometric problem and accurately predicts extrinsic calibration parameters for a wide range of mis-calibrations, without requiring retraining or domain adaptation. The project page is hosted at https://epiception.github.io/CalibNet

如果你对本文感兴趣,想要下载完整文章进行阅读,可以关注【泡泡机器人SLAM】公众号(paopaorobot_slam)。

欢迎来到泡泡论坛,这里有大牛为你解答关于SLAM的任何疑惑。

有想问的问题,或者想刷帖回答问题,泡泡论坛欢迎你!

泡泡网站:www.paopaorobot.org

泡泡论坛:http://paopaorobot.org/bbs/

泡泡机器人SLAM的原创内容均由泡泡机器人的成员花费大量心血制作而成,希望大家珍惜我们的劳动成果,转载请务必注明出自【泡泡机器人SLAM】微信公众号,否则侵权必究!同时,我们也欢迎各位转载到自己的朋友圈,让更多的人能进入到SLAM这个领域中,让我们共同为推进中国的SLAM事业而努力!

商业合作及转载请联系liufuqiang_robot@hotmail.com