数据挖掘领域的国际会议WSDM将于2020年2月3日-2月7日在美国休斯敦召开,WSDM 2020全称为第13届国际互联网搜索与数据挖掘会议(The 13th International Conference on Web Search and Data Mining, WSDM 2020)。WSDM是CCF推荐的B类国际学术会议,由SIGIR、SIGKDD、SIGMOD和SIGWEB四个专委会协调筹办,在互联网搜索、数据挖掘领域享有较高学术声誉。这次会议共收到来自615篇长文投稿,仅有91篇长文被录用,录用率约15%。

为此小编特意整理了近期五篇图神经网络(GNN)相关的接收论文,让大家先睹为快。

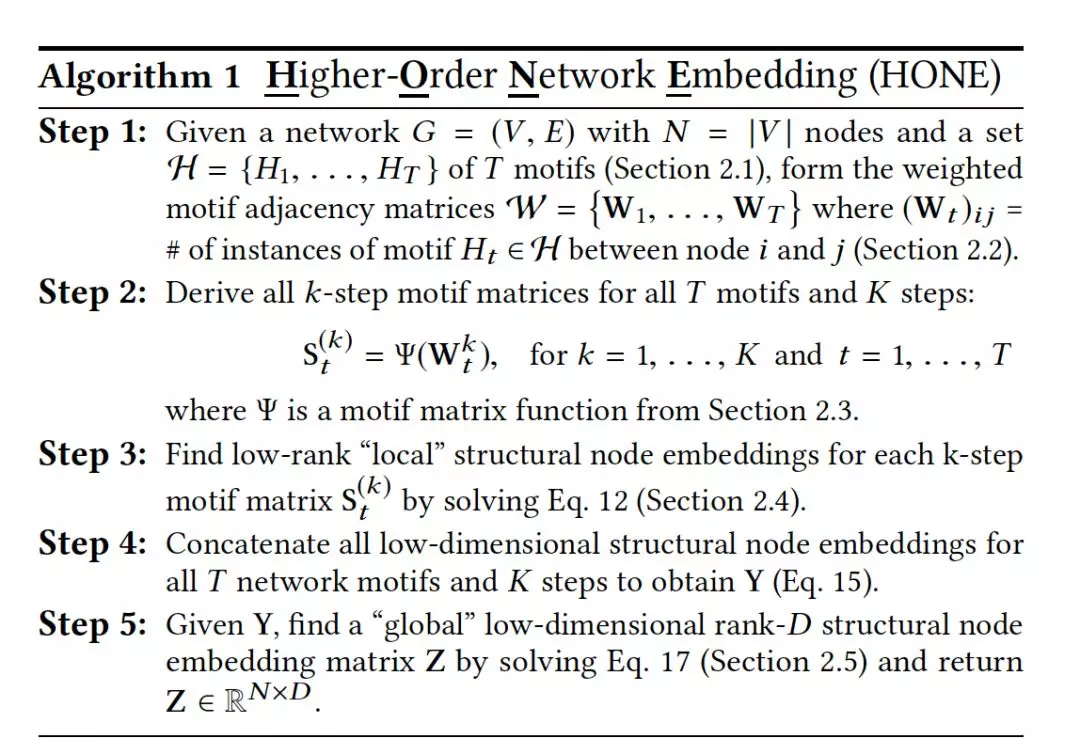

1. A Structural Graph Representation Learning Framework

作者:Ryan A. Rossi, Nesreen K. Ahmed, Eunyee Koh, Sungchul Kim, Anup Rao and Yasin Abbasi-Yadkori;

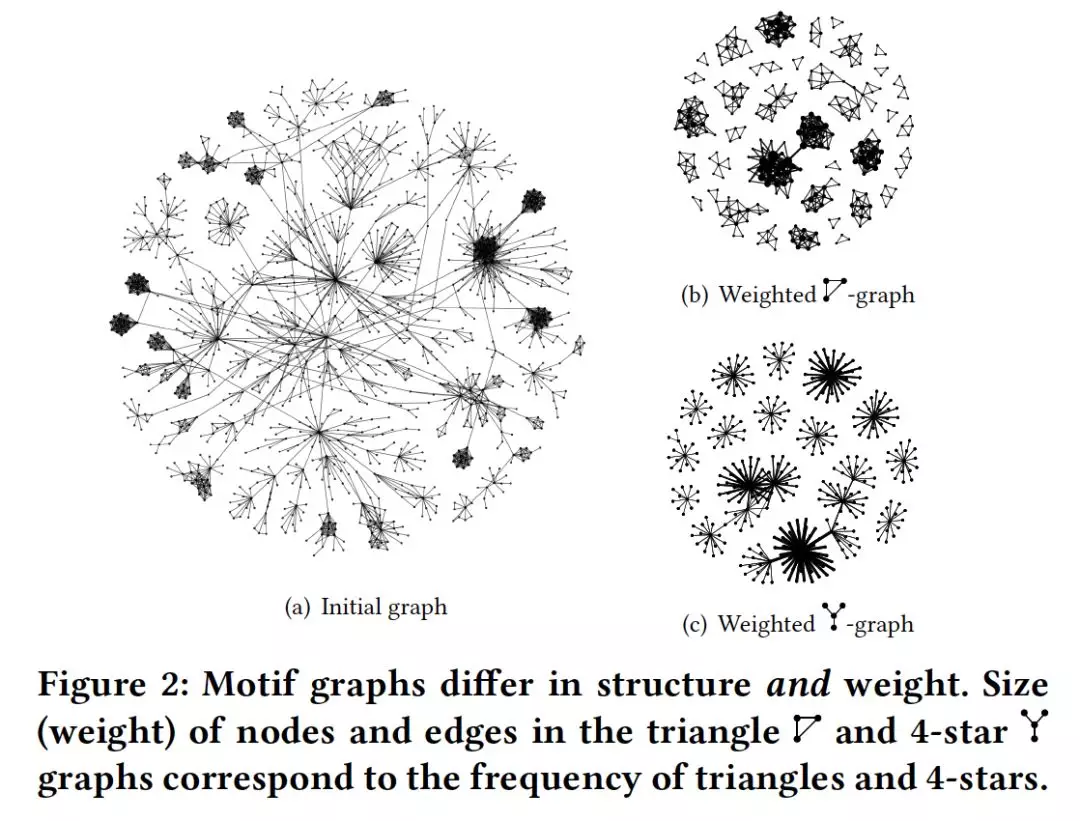

摘要:许多基于图的机器学习任务的成功在很大程度上取决于从图数据中学习到的适当表示。大多数工作都集中在于学习保留邻近性的节点嵌入,而不是保留节点之间结构相似性的基于结构的嵌入。这些方法无法捕获对基于结构的应用程序(如web日志中的visitor stitching)至关重要的高阶结构依赖和连接模式。在这项工作中,我们阐述了高阶网络表示学习,并提出了一个称为HONE的通用框架,用于通过节点邻域中的子图模式(network motifs, graphlet orbits/positions)从网络中学习这种结构性节点嵌入。HONE引入了一种通用的diffusion机制和一种节省空间的方法,该方法避免了使用k-step线性算子来显式构造k-step motif-based矩阵。此外,HONE被证明是快速和有效的,最坏情况下的时间复杂度几乎是线性的。实验结果表明,该算法能有效地处理大量的网络日志数据,包括链接预测和visitor stitching。

网址: http://ryanrossi.com/pubs/WSDM20-structural-node-embedding-framework.pdf

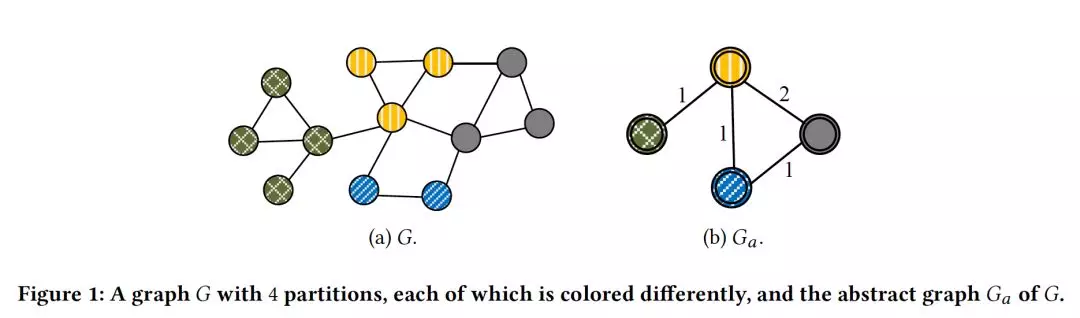

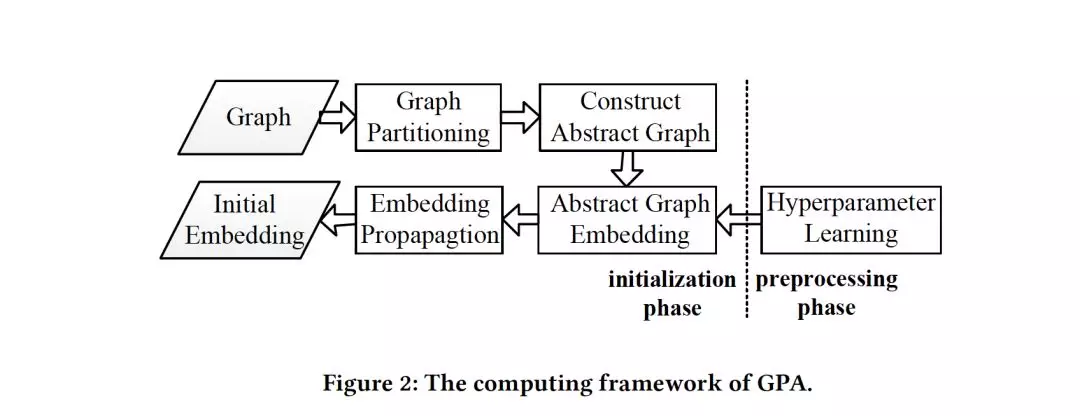

2. Initialization for Network Embedding: A Graph Partition Approach

作者:Wenqing Lin, Feng He, Faqiang Zhang, Xu Cheng and Hongyun Cai;

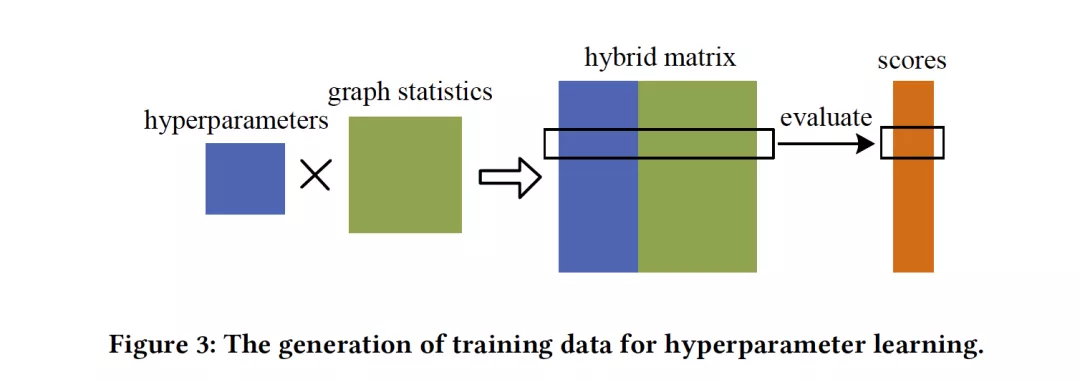

摘要:网络嵌入已经在文献中得到了深入的研究,并广泛用于各种应用中,如链接预测和节点分类。尽管先前的工作集中在新算法的设计上或针对各种问题设置进行了量身定制,但常常忽略了学习过程中对初始化策略的讨论。在这项工作中,我们解决了这个重要的网络嵌入初始化问题,它可以显著地提高算法的有效性和效率。具体来说,我们首先利用graph partition技术将图划分为几个不相交的子集,然后基于这些partition构造一个abstract graph。我们通过计算abstract graph上的网络嵌入,得到图中每个节点的嵌入初始化,abstract graph上的网络嵌入比输入图小得多,然后将嵌入传播到输入图的节点中。通过对各种数据集的大量实验,我们证明了我们的初始化技术显著提高了最先进算法在链接预测和节点分类方面的性能,分别提高了7.76%和8.74%。此外,我们证明了初始化技术至少减少了20%的运行时间。

网址:https://arxiv.org/abs/1908.10697

3. Dynamic graph representation learning via self-attention networks

作者:Aravind Sankar, Yanhong Wu, Liang Gou, Wei Zhang and Hao Yang;

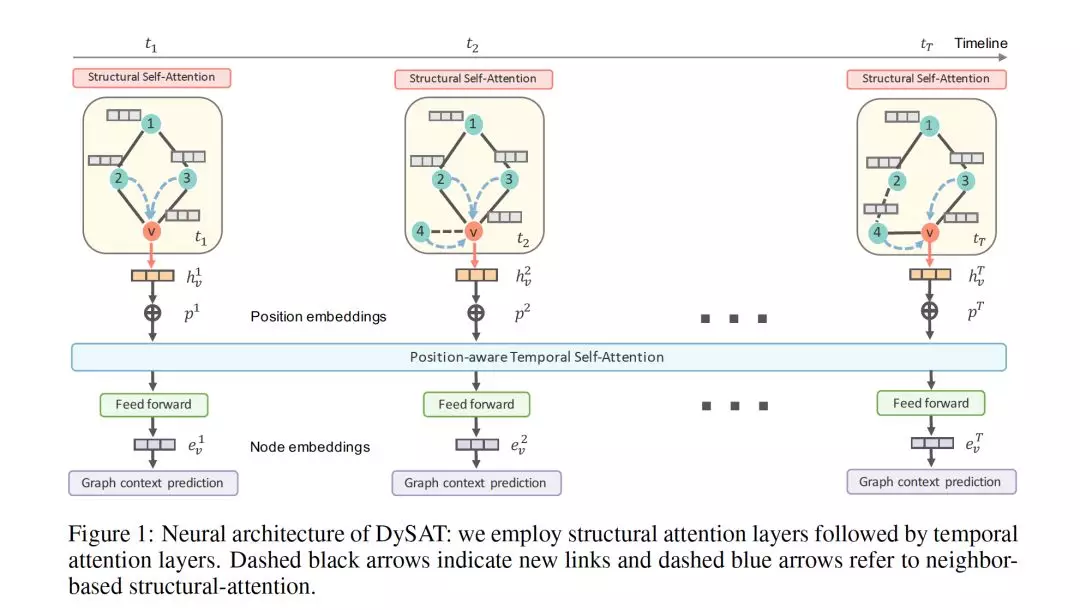

摘要:学习图中节点的潜在表示是一项重要且普遍存在的任务,在链接预测、节点分类和图可视化等领域有着广泛的应用。以往的图表示学习方法主要集中在静态图上,而现实世界中的很多图都是动态的、随时间变化的。在这篇论文中,我们提出了Dynamic Self-Attention Network (DySAT),这是一种新型的神经架构,它操作在动态图上,并学习节点表示,以捕捉结构特性和时间演化模式。具体来说,DySAT通过在两个维度(结构邻域和时间动态)上联合使用self-attention层来计算节点表示。我们对两类图进行了链接预测实验:通信网络和二分评级网络。我们的实验结果表明,DySAT在几种不同的最先进的图嵌入baseline上有显著的性能提升。

网址:https://arxiv.org/abs/1812.09430

https://www.zhuanzhi.ai/paper/55d2d91d5aca95983842deb7c7138252

4. Relation Learning on Social Networks with Multi-Modal Graph Edge Variational Autoencoders

作者:Carl Yang, Jieyu Zhang, Haonan Wang, Sha Li, Myungwan Kim, Ma Walker, Yiou Xiao and Jiawei Han;

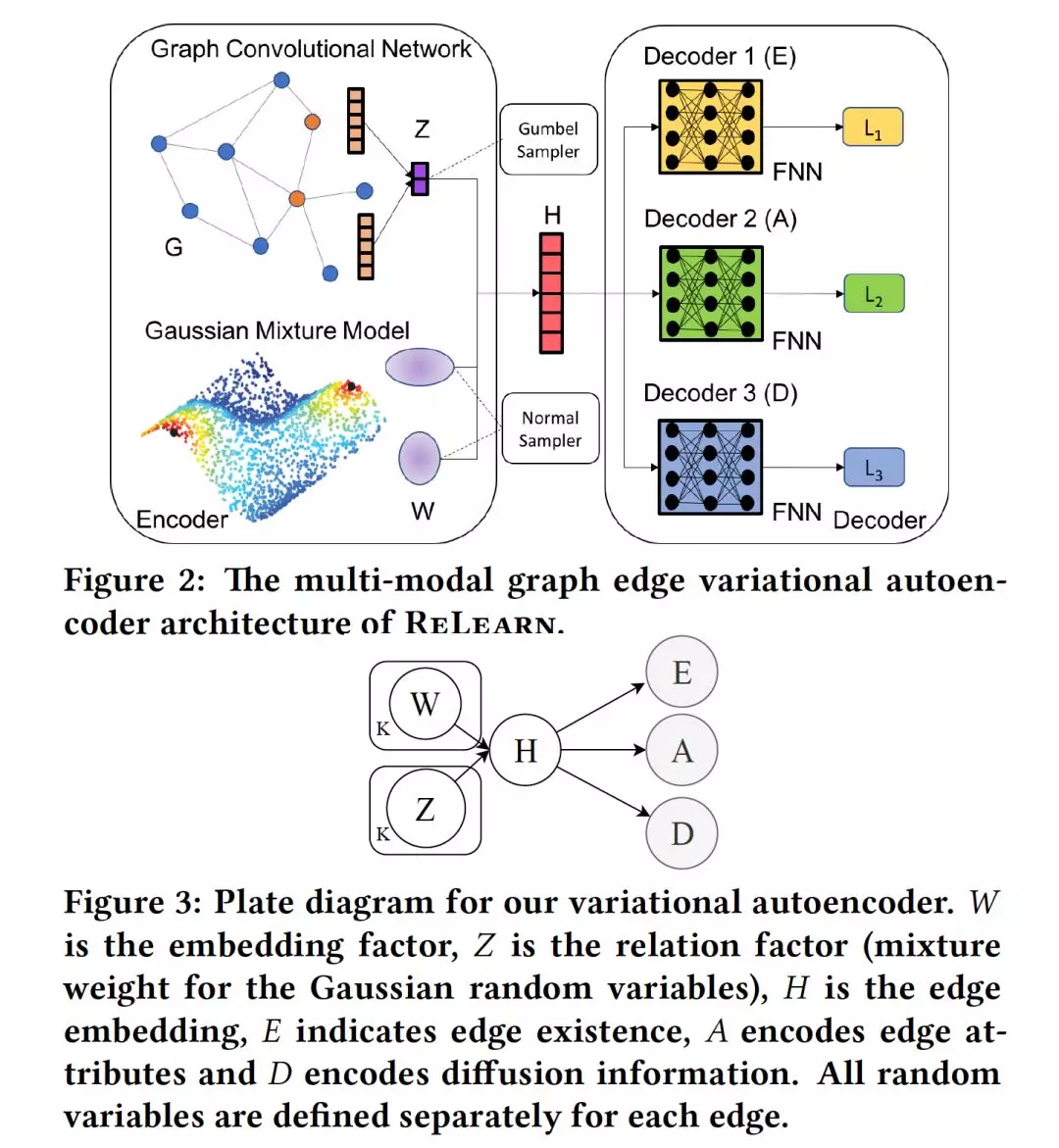

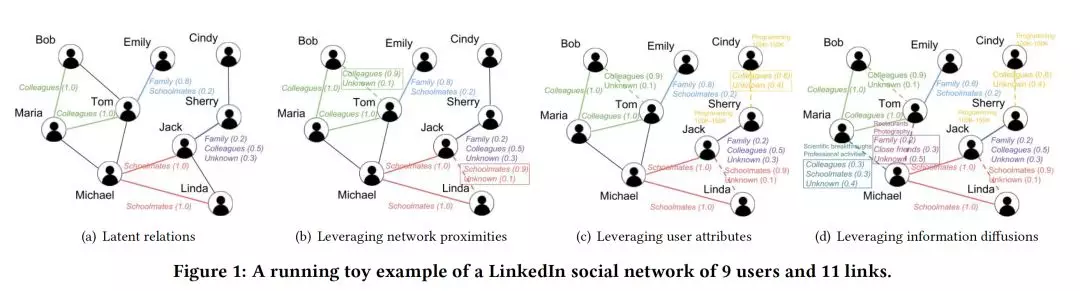

摘要:尽管节点语义已在社交网络中得到了广泛的探索,但对边缘语义即社会关系的研究很少受到关注。理想的边缘语义不仅应该显示两个用户是连接的,而且还应该说明他么为什么彼此认识以及共享什么。然而,由于嘈杂的多模态信号和有限的用户生成的ground-truth标签,社交网络中的关系往往很难分析。

在这项工作中,我们的目标是开发一个统一的且有原则的框架,通过在有噪声和不完整数据存在的情况下整合多模态信号,将用户关系描述为社交网络中的边缘语义。我们的框架对于半监督或无监督的情况也是灵活的。具体地说,我们假定每个用户链接下的多个关系的潜在分布,并使用多模态图边缘变分自动编码器来学习它们。我们用一个图卷积网络对网络数据进行编码,用多个重构网络对任意信号进行解码。在两个公开的DBLP author network和两个internal LinkedIn member network上的大量实验和案例研究证明了我们提出的模型的优越性和有效性。

网址:https://arxiv.org/abs/1911.05465

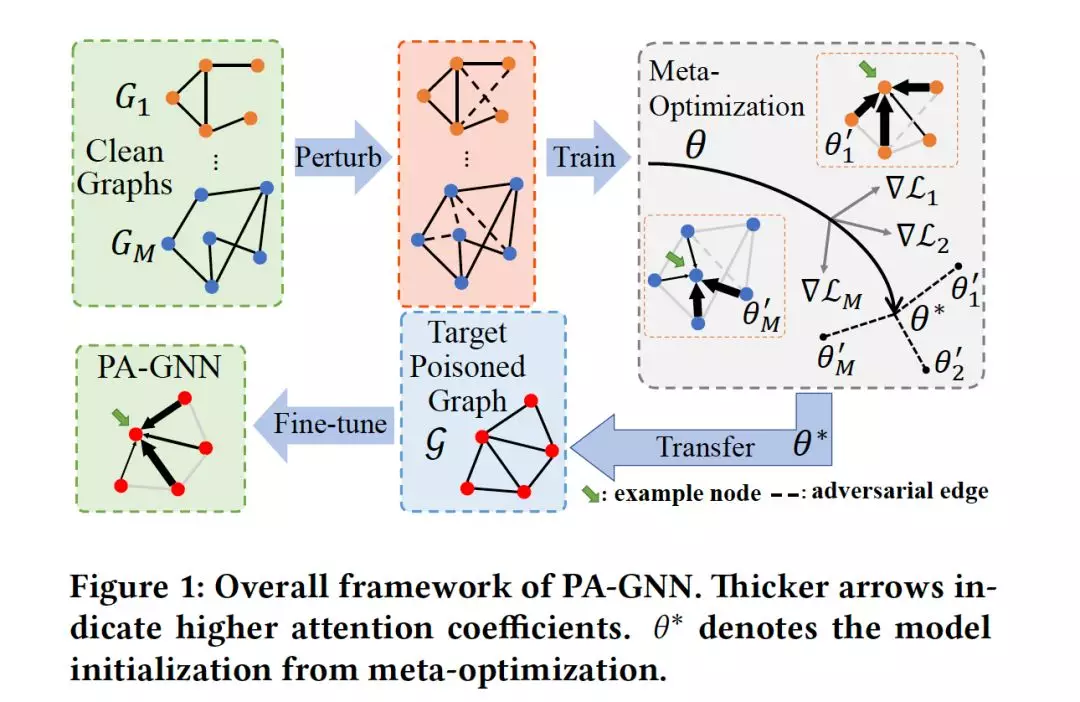

5. Robust Graph Neural Network Against Poisoning Attacks via Transfer Learning

作者:Xianfeng Tang, Yandong Li, Yiwei Sun, Huaxiu Yao, Prasenjit Mitra and Suhang Wang;

摘要:图神经网络(GNNs)有着广泛的应用。然而,他们在对抗攻击的鲁棒性方面是不行的。先前的研究表明,对图拓扑或节点特征使用不明显的修改会大大降低GNN的性能。设计强大的图神经网络以防止poisoning attack是一项非常具有挑战性的工作。现有工作的目标是仅使用poisoned图来减少adversarial edge的负面影响,这是次优的,因为它们无法区分adversarial edge和normal edge。另一方面,来自与目标poisoned图类似领域的clean图在现实世界中通常是可用的。通过扰动这些clean图,我们创建了监督知识来训练检测adversarial edge的能力,从而提高了GNN的鲁棒性。然而,现有的工作忽略了这种clean图的潜力。为此,我们研究了一个新的问题,通过研究clean图来提高GNNs对poisoning attack的鲁棒性。具体而言,我们提出了PA-GNN,它基于一种惩罚性聚合机制,通过分配较低的注意力系数来直接限制adversarial edge的负面影响。为了优化一个poisoned图的PA-GNN,我们设计了一种meta-optimization算法,训练PA-GNN使用clean图和其adversarial图惩罚扰动,并将这种能力迁移到poisoned图上,以提高PA-GNN的鲁棒性。在四个真实数据集上的实验结果证明了PA-GNN对图数据poisoning attack的鲁棒性。

网址: https://arxiv.org/abs/1908.07558

论文链接:https://pan.baidu.com/s/1DbS8KgreKx1AtUsZV2OgQw 提取码:uzby