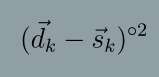

Graph representation learning for hypergraphs can be used to extract patterns among higher-order interactions that are critically important in many real world problems. Current approaches designed for hypergraphs, however, are unable to handle different types of hypergraphs and are typically not generic for various learning tasks. Indeed, models that can predict variable-sized heterogeneous hyperedges have not been available. Here we develop a new self-attention based graph neural network called Hyper-SAGNN applicable to homogeneous and heterogeneous hypergraphs with variable hyperedge sizes. We perform extensive evaluations on multiple datasets, including four benchmark network datasets and two single-cell Hi-C datasets in genomics. We demonstrate that Hyper-SAGNN significantly outperforms the state-of-the-art methods on traditional tasks while also achieving great performance on a new task called outsider identification. Hyper-SAGNN will be useful for graph representation learning to uncover complex higher-order interactions in different applications.

翻译:用于高测图的图形代表学习可以用来提取在很多现实世界问题中至关重要的更高层次互动模式。 但是,目前为高测图设计的方法无法处理不同类型的高测图,通常不是用于各种学习任务的通用方法。 事实上,没有能够预测不同大小的多元高端模型。 在这里,我们开发了一个新的基于自我注意的图形神经网络,称为超超超SAGNN, 适用于具有不同高端尺寸的同质和异质高超光谱。 我们对多个数据集进行了广泛的评估, 包括四个基准网络数据集和两个基因组的单细胞高超C数据集。 我们证明超SAGNN明显地超越了传统任务上的最新方法,同时在一项称为外部识别的新任务上取得巨大成绩。 超SAGNN将有益于图形演示学习, 以发现不同应用程序中复杂的更高层次互动。