【导读】作为世界数据挖掘领域的最高级别的学术会议,ACM SIGKDD(国际数据挖掘与知识发现大会,简称 KDD)每年都会吸引全球领域众多专业人士参与。今年的 KDD大会计划将于 2020 年 8 月 23 日 ~27 日在美国美国加利福尼亚州圣地亚哥举行。上周,KDD 2020官方发布接收论文,共有1279篇论文提交到Research Track,共216篇被接收,接收率16.8%。近期KDD官网公布了接受论文列表,为此,上个月专知小编为大家整理了图神经网络相关的论文,这期小编继续为大家奉上KDD 2020必读的五篇图神经网络(GNN)相关论文-Part 2——多层次GCN、无监督预训练GCN、图Hash、GCN主题模型、采样

KDD 2020 Accepted Paper: https://www.kdd.org/kdd2020/accepted-papers

KDD2020GNN_Part1、CVPR2020SGNN、CVPR2020GNN_Part2、CVPR2020GNN_Part1、WWW2020GNN_Part1、AAAI2020GNN、ACMMM2019GNN、CIKM2019GNN、ICLR2020GNN、EMNLP2019GNN、ICCV2019GNN_Part2、ICCV2019GNN_Part1、NIPS2019GNN、IJCAI2019GNN_Part1、IJCAI2019GNN_Part2、KDD2019GNN、

1. Multi-level Graph Convolutional Networks for Cross-platform Anchor Link Prediction

作者:Hongxu Chen, Hongzhi Yin, Xiangguo Sun, Tong Chen, Bogdan Gabrys, Katarzyna Musial

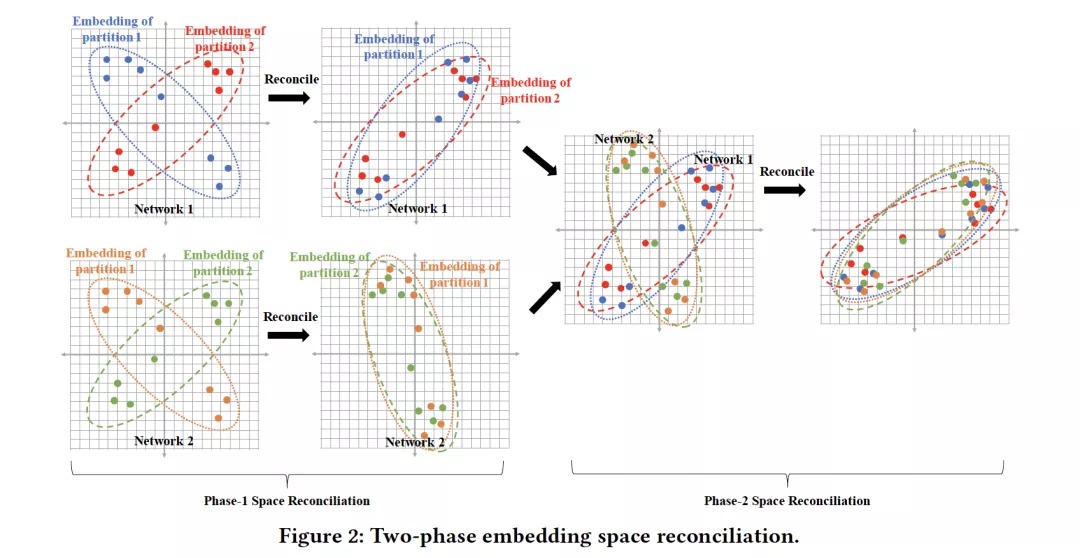

摘要:跨平台的账号匹配在社交网络分析中发挥着重要作用,并且有利于广泛的应用。然而,现有的方法要么严重依赖于高质量的用户生成内容(包括用户兴趣模型),要么只关注网络拓扑结构,存在数据不足的问题,这使得研究这个方向变得很困难。为了解决这一问题,我们提出了一种新的框架,该框架统一考虑了局部网络结构和超图结构上的多级图卷积。该方法克服了现有工作中数据不足的问题,并且不一定依赖于用户的人口统计信息。此外,为了使所提出的方法能够处理大规模社交网络,我们提出了一种两阶段的空间协调机制,在基于网络分区的并行训练和跨不同社交网络的帐户匹配中对齐嵌入空间。我们在两个大规模的真实社交网络上进行了广泛的实验。实验结果表明,该方法的性能比现有的模型有较大幅度的提高。

网址:

https://arxiv.org/abs/2006.01963

2. GCC: Graph Contrastive Coding for Graph Neural Network Pre-Training

作者:Jiezhong Qiu, Qibin Chen, Yuxiao Dong, Jing Zhang, Hongxia Yang, Ming Ding, Kuansan Wang, Jie Tang

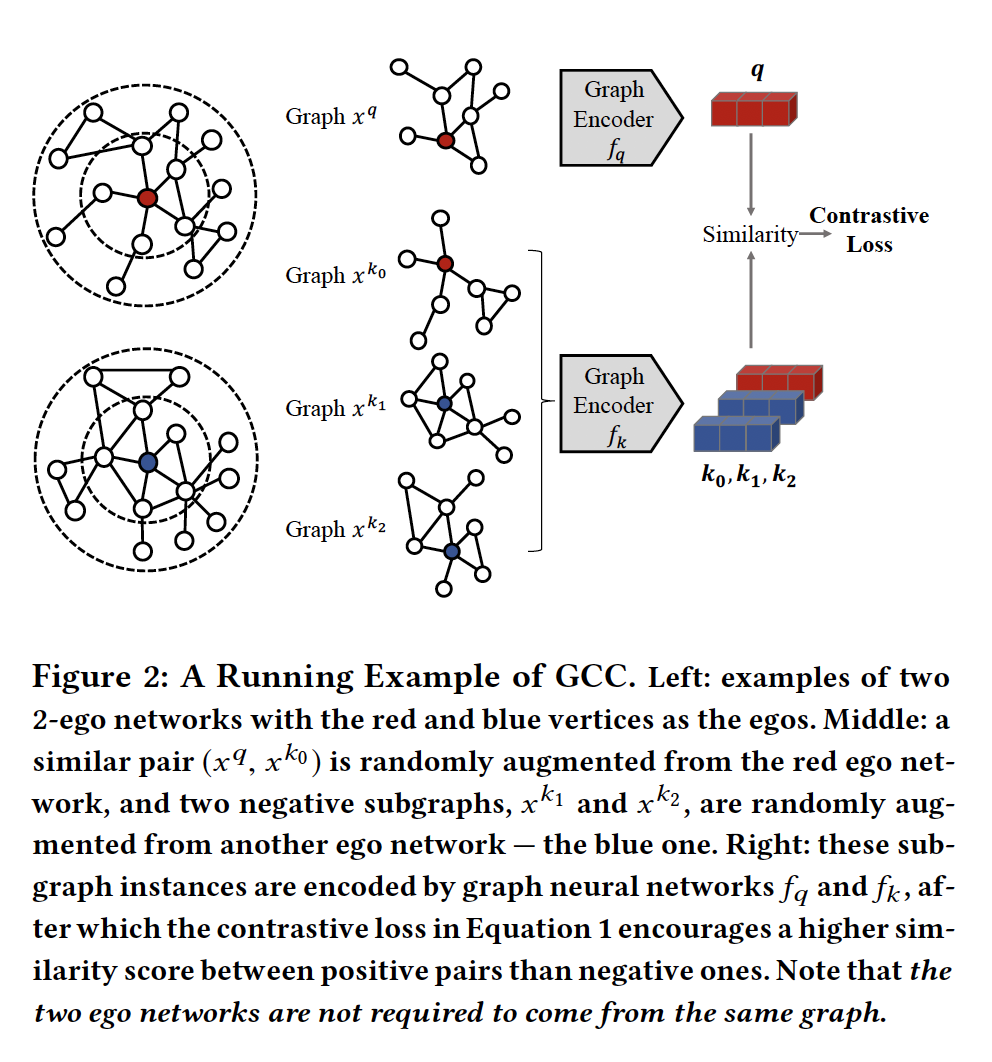

摘要:图表示学习已经成为解决现实问题的一种强有力的技术。包括节点分类、相似性搜索、图分类和链接预测在内的各种下游图学习任务都受益于它的最新发展。然而,关于图表示学习的现有技术集中于领域特定的问题,并为每个图训练专用模型,这通常不可转移到领域之外的数据。受自然语言处理和计算机视觉在预训练方面的最新进展的启发,我们设计了图对比编码(Graph Contrastive Coding,GCC)一个无监督的图表示学习框架来捕捉跨多个网络的通用网络拓扑属性。我们将GCC的预训练任务设计为网络内部和网络之间的子图级别的实例判断,并利用对比学习来增强模型学习内在的和可迁移的结构表征能力。我们在三个图学习任务和十个图数据集上进行了广泛的实验。结果表明,GCC在一组不同的数据集上进行预训练,可以获得与从头开始的特定任务训练的方法相媲美或更好的性能。这表明,预训练和微调范式对图表示学习具有巨大的潜力。

网址:

https://arxiv.org/abs/2006.09963

代码链接:

3. GHashing: Semantic Graph Hashing for Approximate Similarity Search in Graph Databases

作者:Zongyue Qin, Yunsheng Bai, Yizhou Sun

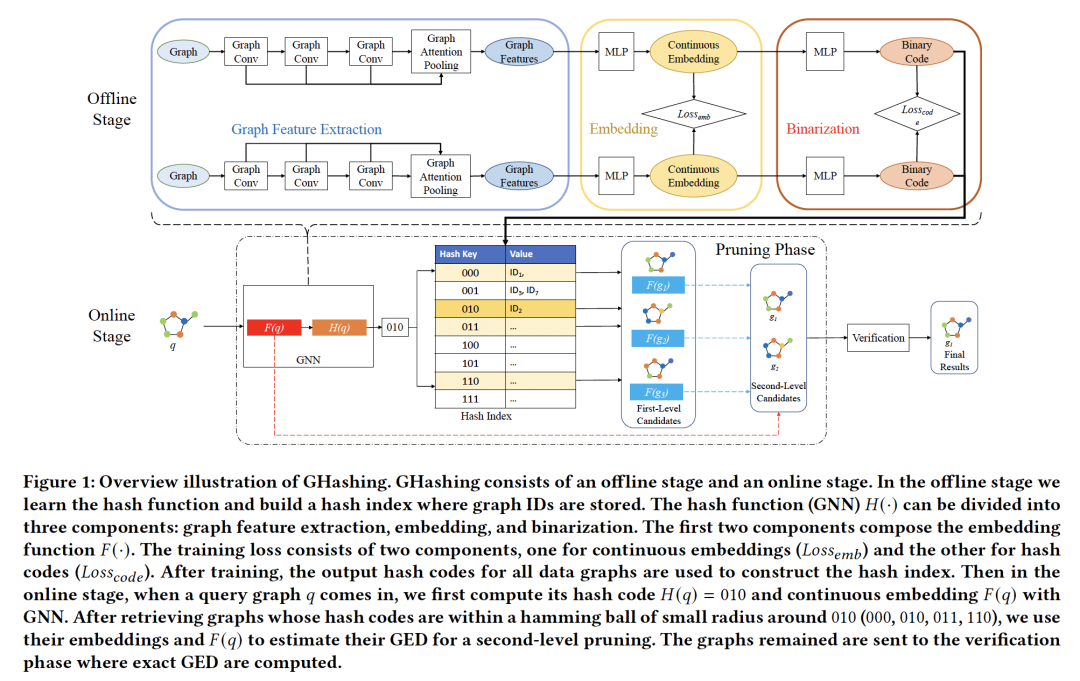

摘要:图相似搜索的目的是根据给定的邻近度,即图编辑距离(GED),在图形数据库中找到与查询最相似的图。这是一个被广泛研究但仍具有挑战性的问题。大多数研究都是基于剪枝验证框架,该框架首先对非看好的图进行剪枝,然后在较小的候选集上进行验证。现有的方法能够管理具有数千或数万个图的数据库,但由于其精确的剪枝策略,无法扩展到更大的数据库。受到最近基于深度学习的语义哈希(semantic hashing)在图像和文档检索中的成功应用的启发,我们提出了一种新的基于图神经网络(GNN)的语义哈希,即GHash,用于近似剪枝。我们首先用真实的GED结果训练GNN,以便它学习生成嵌入和哈希码,以保持图之间的GED。然后建立哈希索引以实现恒定时间内的图查找。在回答一个查询时,我们使用哈希码和连续嵌入作为两级剪枝来检索最有希望的候选对象,并将这些候选对象发送到精确的求解器进行最终验证。由于我们的图哈希技术利用了近似剪枝策略,与现有方法相比,我们的方法在保持高召回率的同时,实现了显著更快的查询时间。实验表明,该方法的平均速度是目前唯一适用于百万级数据库的基线算法的20倍,这表明GHash算法成功地为解决大规模图形数据库的图搜索问题提供了新的方向。

网址:

http://web.cs.ucla.edu/~yzsun/papers/2020_KDD_GHashing.pdf

4. Graph Structural-topic Neural Network

作者:Qingqing Long, Yilun Jin, Guojie Song, Yi Li, Wei Lin

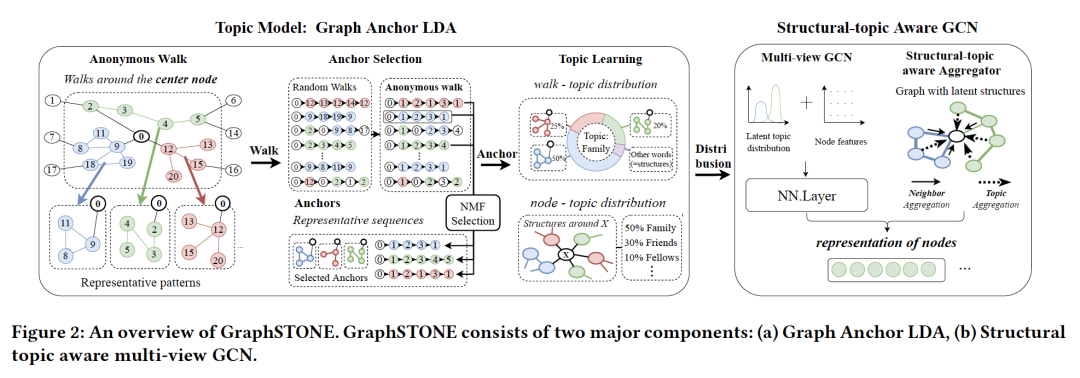

摘要:图卷积网络(GCNS)通过有效地收集节点的局部特征,取得了巨大的成功。然而,GCNS通常更多地关注节点特征,而较少关注邻域内的图结构,特别是高阶结构模式。然而,这种局部结构模式被显示为许多领域中的节点属性。此外,由于网络很复杂,每个节点的邻域由各种节点和结构模式的混合组成,不只是单个模式,所有这些模式上的分布都很重要。相应地,在本文中,我们提出了图结构主题神经网络,简称GraphSTONE,这是一种利用图的主题模型的GCN模型,使得结构主题广泛地从概率的角度捕捉指示性的图结构,而不仅仅是几个结构。具体地说,我们使用 anonymous walks和Graph Anchor LDA(一种LDA的变体,首先选择重要的结构模式)在图上建立主题模型,以降低复杂性并高效地生成结构主题。此外,我们设计了多视图GCNS来统一节点特征和结构主题特征,并利用结构主题来指导聚合。我们通过定量和定性实验对我们的模型进行了评估,我们的模型表现出良好的性能、高效率和清晰的可解释性。

网址:

https://arxiv.org/abs/2006.14278

代码链接:

https://github.com/YimiAChack/GraphSTONE/

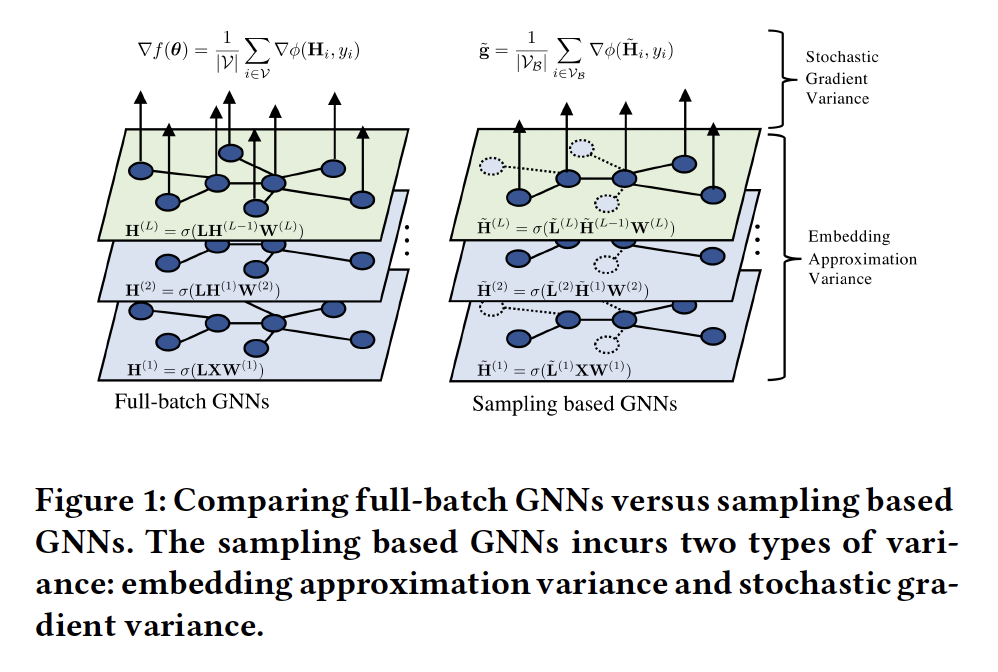

5. Minimal Variance Sampling with Provable Guarantees for Fast Training of Graph Neural Networks

作者:Weilin Cong, Rana Forsati, Mahmut Kandemir, Mehrdad Mahdavi

摘要:抽样方法(如节点抽样、分层抽样或子图抽样)已成为加速大规模图神经网络(GNNs)训练不可缺少的策略。然而,现有的抽样方法大多基于图的结构信息,忽略了最优化的动态性,导致随机梯度估计的方差较大。高方差问题在非常大的图中可能非常明显,它会导致收敛速度慢和泛化能力差。本文从理论上分析了抽样方法的方差,指出由于经验风险的复合结构,任何抽样方法的方差都可以分解为前向阶段的嵌入近似方差和后向阶段的随机梯度方差,这两种方差都必须减小,才能获得较快的收敛速度。我们提出了一种解耦的方差减小策略,利用(近似)梯度信息自适应地对方差最小的节点进行采样,并显式地减小了嵌入近似引入的方差。理论和实验表明,与现有方法相比,该方法即使在小批量情况下也具有更快的收敛速度和更好的泛化能力。

网址: