【导读】作为世界数据挖掘领域的最高级别的学术会议,ACM SIGKDD(国际数据挖掘与知识发现大会,简称 KDD)每年都会吸引全球领域众多专业人士参与。今年的 KDD大会计划将于 2020 年 8 月 23 日 ~27 日在美国美国加利福尼亚州圣地亚哥举行。上周,KDD 2020官方发布接收论文,共有1279篇论文提交到Research Track,共216篇被接收,接收率16.8%。近期一些Paper放出来了,为此,专知小编提前为大家整理了五篇KDD 2020 图神经网络(GNN)相关论文,供大家参考。——图结构学习、多元时间序列预测、负采样、多任务多视角图表示学习、多兴趣推荐

CVPR2020SGNN、CVPR2020GNN_Part2、CVPR2020GNN_Part1、WWW2020GNN_Part1、AAAI2020GNN、ACMMM2019GNN、CIKM2019GNN、ICLR2020GNN、EMNLP2019GNN、ICCV2019GNN_Part2、ICCV2019GNN_Part1、NIPS2019GNN、IJCAI2019GNN_Part1、IJCAI2019GNN_Part2、KDD2019GNN、ACL2019GNN、CVPR2019GNN、

1. Graph Structure Learning for Robust Graph Neural Networks

作者:Wei Jin, Yao Ma, Xiaorui Liu, Xianfeng Tang, Suhang Wang, Jiliang Tang

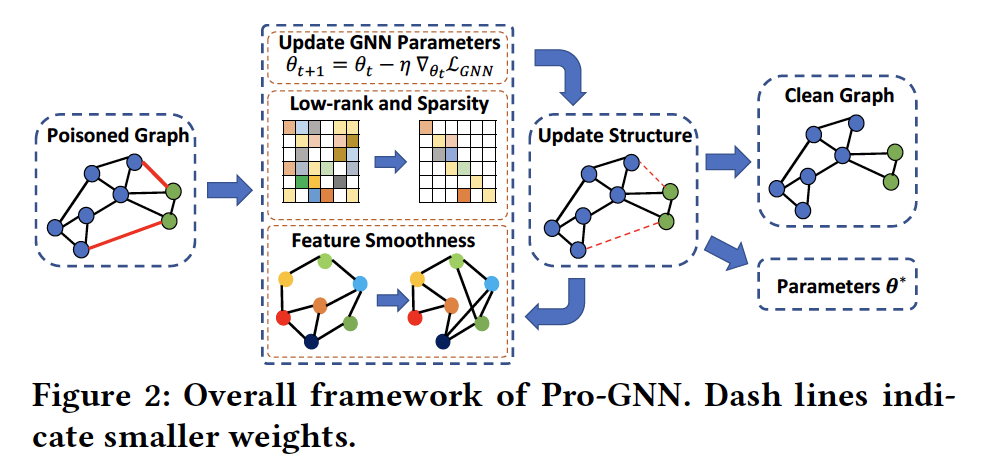

摘要:图神经网络(GNNs)是图表示学习的有力工具。但是,最近的研究表明,GNN容易受到精心设计的扰动(称为对抗攻击)的攻击。对抗性攻击很容易欺骗GNN来预测下游任务。对于对抗攻击的脆弱性使人们越来越关注在安全关键型应用中应用GNN。因此,开发稳健的算法来防御对抗攻击具有重要意义。防御对抗攻击的一个自然想法是清理受干扰的图。很明显,真实世界的图共享一些内在属性。例如,许多现实世界的图都是低秩和稀疏的,两个相邻节点的特征往往是相似的。事实上,我们发现对抗攻击很可能会违背这些图的性质。因此,在本文中,我们利用这些特性来防御针对图的对抗攻击。特别是,我们提出了一个通用框架Pro-GNN,该框架可以从受这些特性指导的扰动图中联合学习结构图和鲁棒图神经网络模型。在真实图上的大量实验表明,即使在图受到严重干扰的情况下,我们所提出的框架也比现有的防御方法获得了显著更好的性能。我们将Pro-GNN的实现发布到我们的DeepRobust存储库,以进行对抗性攻击和防御。

网址: https://arxiv.org/pdf/2005.10203.pdf

代码链接: https://github.com/ChandlerBang/Pro-GNN

2. Connecting the Dots: Multivariate Time Series Forecasting with Graph Neural Networks

作者:Zonghan Wu, Shirui Pan, Guodong Long, Jing Jiang, Xiaojun Chang, Chengqi Zhang

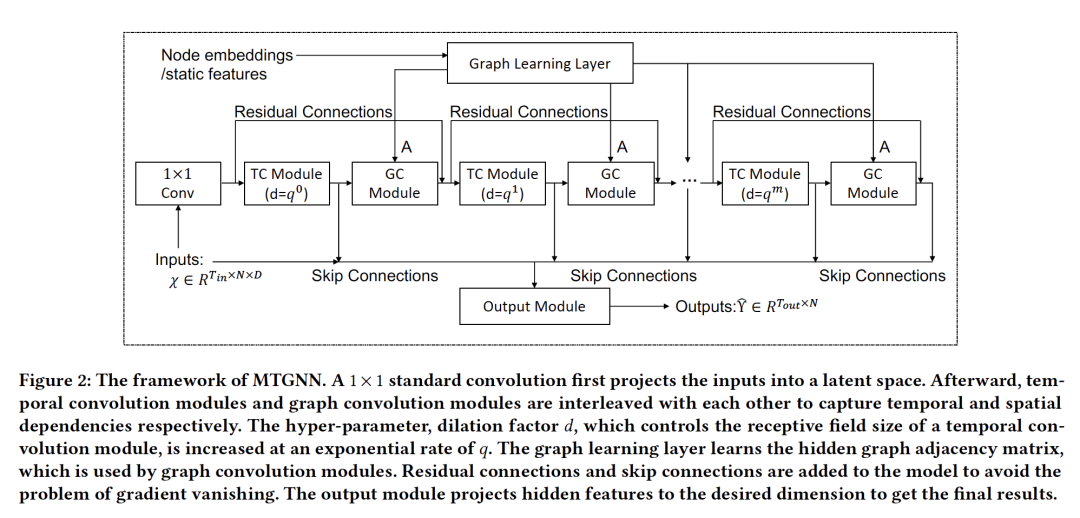

摘要:多变量时间序列的建模长期以来一直吸引着来自经济、金融和交通等不同领域的研究人员的关注。多变量时间序列预测背后的一个基本假设是其变量之间相互依赖,但现有方法未能充分利用变量对之间的潜在空间相关性。同时,近些年来,图神经网络(GNNs)在处理关系依赖方面表现出了很高的能力。GNN需要定义良好的图结构来进行信息传播,这意味着它们不能直接应用于事先不知道依赖关系的多变量时间序列。本文提出了一种专门针对多变量时间序列数据设计的通用图神经网络框架。该方法通过图学习模块自动提取变量间的单向关系,可以方便地集成变量属性等外部知识。在此基础上,提出了一种新的max-hop传播层和一个dilated inception层来捕捉时间序列中的时间和空间依赖关系。图学习、图卷积和时间卷积模块在端到端框架中联合学习。实验结果表明,我们提出的模型在4个基准数据集中的3个数据上优于最新的基线方法,并且在提供额外结构信息的两个交通数据集上,与其他方法具有同等的性能。

网址: https://shiruipan.github.io/publication/kdd-2020-wu/kdd-2020-wu.pdf

3. Understanding Negative Sampling in Graph Representation Learning

作者:Zhen Yang, Ming Ding, Chang Zhou, Hongxia Yang, Jingren Zhou, Jie Tang

摘要:在最近的几年中,对图表示学习进行了广泛的研究。尽管它有可能为各种网络生成连续的嵌入,但是在大型节点集中得到有效高质量的表示仍然具有挑战性。采样是实现该性能目标的关键点。现有技术通常侧重于正向节点对的采样,而对负向采样的策略探索不够。为了弥补这一差距,我们从目标和风险两个角度系统地分析了负采样的作用,从理论上论证了负采样在确定优化目标和结果方差方面与正采样同等重要。据我们所知,我们是第一个推导该理论并量化负采样分布应与其正采样分布成正相关但亚线性相关的方法。在该理论的指导下,我们提出了MCNS,用自对比度近似法近似正分布,并通过Metropolis-Hastings加速负采样。我们在5个数据集上评估了我们的方法,这些数据集涵盖了19个实验设置,涵盖了广泛的下游图学习任务,包括链接预测,节点分类和个性化推荐。这些相对全面的实验结果证明了其稳健性和优越性。

网址: https://arxiv.org/pdf/2005.09863.pdf

4. M2GRL: A Multi-task Multi-view Graph Representation Learning Framework for Web-scale Recommender Systems

作者:Menghan Wang, Yujie Lin, Guli Lin, Keping Yang, Xiao-ming Wu

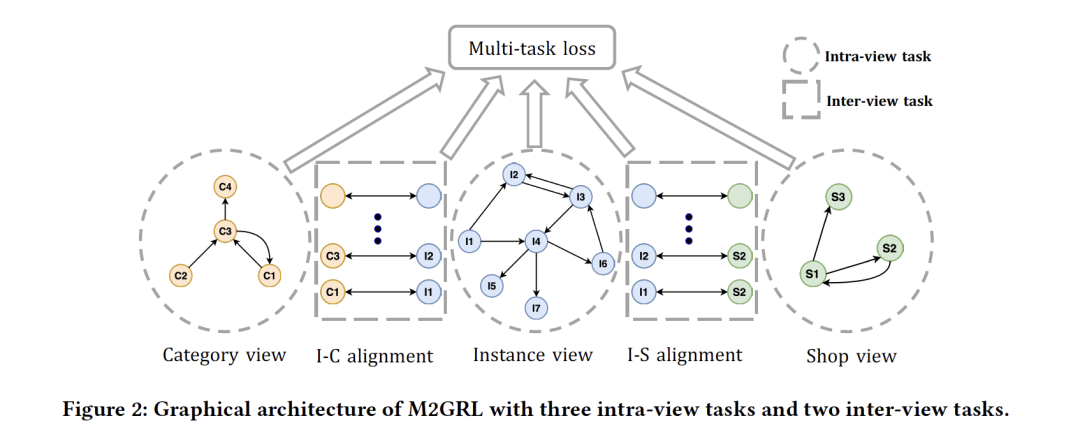

摘要:将图表示学习与多视图数据(边信息)相结合进行推荐是工业上的一种趋势。现有的大多数方法可以归类为多视图表示融合,它们首先构建一个图,然后将多视图数据集成到图中每个节点的单个紧凑表示中。这些方法在工程和算法方面都引起了人们的关注:1)多视图数据在工业中是丰富而且有用的,并且可能超过单个矢量的容量;2)由于多视图数据往往来自不同的分布,可能会引入归纳偏置(inductive bias)。在本文中,我们使用一种多视图表示对齐方法来解决这个问题。特别地,我们提出了一个多任务多视角图表示学习框架(M2GRL)来学习web级推荐系统中的多视角图节点表示。M2GRL为每个单视图数据构造一个图,从多个图中学习多个单独的表示,并执行对齐以建立模型的交叉视图关系。M2GRL选择了一种多任务学习范式来联合学习视图内表示和交叉视图关系。此外,M2GRL在训练过程中利用同方差不确定性自适应地调整任务的损失权重。我们在淘宝部署了M2GRL,并对570亿个实例进行了训练。根据离线指标和在线A/B测试,M2GRL的性能明显优于其他最先进的算法。对淘宝多样性推荐的进一步研究表明,利用M2GRL产生的多种表征是有效的,对于不同侧重点的各种工业推荐任务来说,M2GRL是一个很有前途的方向。

网址:

https://arxiv.org/pdf/2005.10110.pdf

5. Controllable Multi-Interest Framework for Recommendation

作者:Yukuo Cen, Jianwei Zhang, Xu Zou, Chang Zhou, Hongxia Yang, Jie Tang

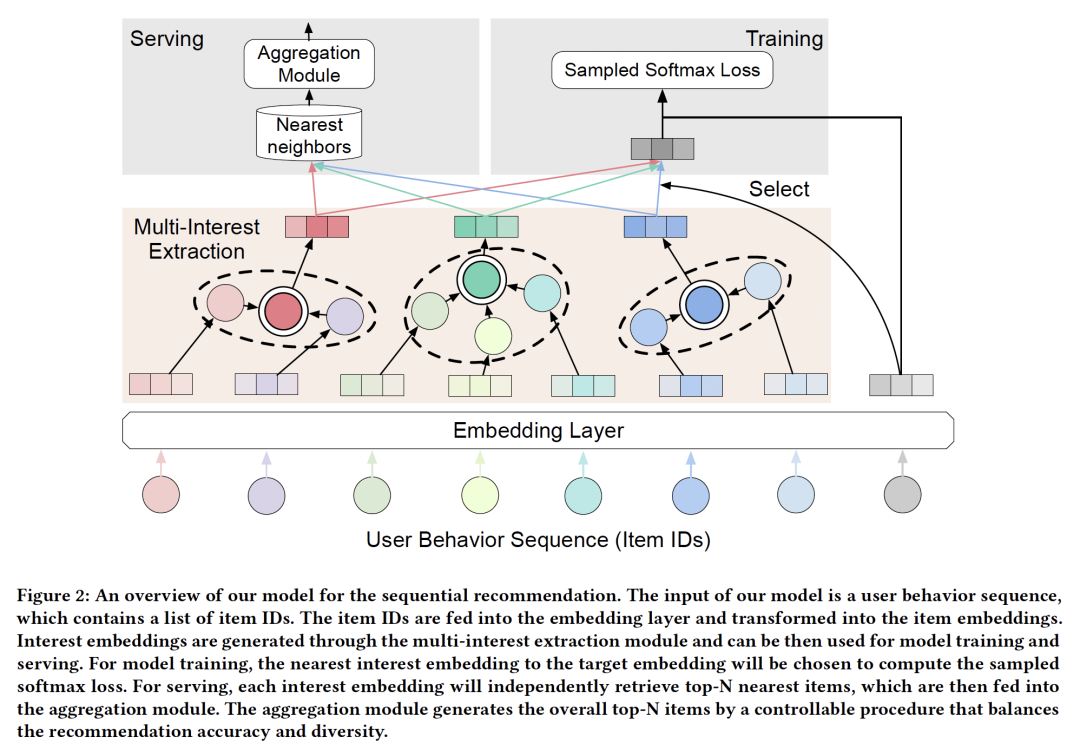

摘要:近年来,由于深度学习的快速发展,神经网络在电子商务推荐系统中得到了广泛的应用。我们将推荐系统形式化为一个序列推荐问题,目的是预测可能与用户交互的下一个项目。最近的研究通常从用户的行为序列中给出一个整体的嵌入。然而,统一的用户嵌入不能反映用户在一段时间内的多个兴趣。本文提出了一种新颖的可控多兴趣序列推荐框架,称为ComiRec。我们的多兴趣模块从用户行为序列中捕获多个兴趣,可用于从大规模项目集中检索候选项目。然后将这些项目送入聚合模块以获得总体推荐。聚合模块利用一个可控因素来平衡推荐的准确性和多样性。我们在两个真实的数据集Amazon和Taobao进行序列推荐实验。实验结果表明,我们的框架相对于最新模型取得了重大改进。我们的框架也已成功部署在离线阿里巴巴分布式云平台上。